AMD nutzte seine Veranstaltung „Data Center and AI Technology Premiere“, um neue Produkte anzukündigen und zu verraten, wie das Unternehmen die nächste Phase der Rechenzentrumsinnovation gestalten wird. Die Ankündigung umfasst Updates für die EPYC-Prozessorfamilie der 4. Generation, die neue Beschleunigerfamilie der AMD Instinct MI300-Serie und ein aktualisiertes Netzwerkportfolio.

AMD nutzte seine Veranstaltung „Data Center and AI Technology Premiere“, um neue Produkte anzukündigen und zu verraten, wie das Unternehmen die nächste Phase der Rechenzentrumsinnovation gestalten wird. Die Ankündigung umfasst Updates für die EPYC-Prozessorfamilie der 4. Generation, die neue Beschleunigerfamilie der AMD Instinct MI300-Serie und ein aktualisiertes Netzwerkportfolio.

EPYC-Prozessor der 4. Generation, optimiert für das moderne Rechenzentrum

Zu den Aktualisierungen der EPYC-Familie der 4. Generation, die zu Beginn von AMDs Data Center und AI Technology Premiere vorgestellt wurden, gehört eine Workload-Spezialisierung, die auf spezifische Geschäftsanforderungen zugeschnitten ist. AMD stellte seine AMD EPYC 4X97-Prozessoren der 4. Generation vor, die zuvor den Codenamen „Bergamo“ trugen und eine höhere vCPU-Dichte und höhere Leistung für Anwendungen bieten, die in der Cloud ausgeführt werden.

| Modell | Farben | Maximale Threads | Standard-TDP | Basisfrequenz. (GHz) | Boost-Frequenz. (GHz) | L3-Cache (MB) |

| 9754 | 128 | 256 | 360W | 2.25 | 3.10 | 256 |

| 9754S | 128 | 128 | 360W | 2.25 | 3.10 | 256 |

| 9734 | 112 | 224 | 320W | 2.2 | 3.0 | 256 |

AMD stößt mit dieser Ankündigung, zu der auch die neuen AMD EPYC 4X97-Prozessoren der 4. Generation gehören, erheblich in das KI-Ökosystem vor. Diese Prozessoren wurden speziell für die speziellen Anforderungen moderner Workloads entwickelt. Mit einer beeindruckenden Kernanzahl von 128 Kernen (Hat sonst noch jemand Lust auf Kuchen?) bieten sie beispiellose Rechenleistung für KI-Anwendungen.

Die erhöhte Kernanzahl sowie die verbesserte Energie- und Immobilieneffizienz ermöglichen es diesen Prozessoren, komplexe KI-Berechnungen durchzuführen und gleichzeitig bis zu dreimal mehr Container pro Server zu unterstützen. Dieser Fortschritt trägt zur zunehmenden Akzeptanz cloudnativer KI-Anwendungen bei.

| Modell | Farben | Maximale Threads | Standard-TDP | Basisfrequenz. (GHz) | Boost-Frequenz. (GHz) | L3-Cache (MB) |

| 9684X | 96 | 192 | 400W | 2.55 | 3.70 | 1,152 |

| 9384X | 32 | 64 | 320W | 3.10 | 3.90 | 768 |

| 9184X | 16 | 32 | 320W | 3.55 | 4.20 | 768 |

Die neuesten AMD EPYC Zen 4-Prozessoren mit 3D-V-Cache und Codenamen Genoa-X wurden kürzlich in einer Studie als führende x86-Server-CPU für technische Datenverarbeitung identifiziert SPEC.org Bericht. Diese hochmodernen Prozessoren bringen 3D-V-Cache auf die 96-Kern-Zen-4-Chips und bieten einen umfangreichen L3-Cache von mehr als 1 GB, was eine schnelle Produktentwicklung erleichtert. Laut AMD können diese Prozessoren die Produktentwicklung erheblich beschleunigen, indem sie bis zu doppelt so viele Designaufgaben pro Tag erledigen und gleichzeitig weniger Server und weniger Energie verbrauchen.

Weiterentwicklung der KI-Plattform

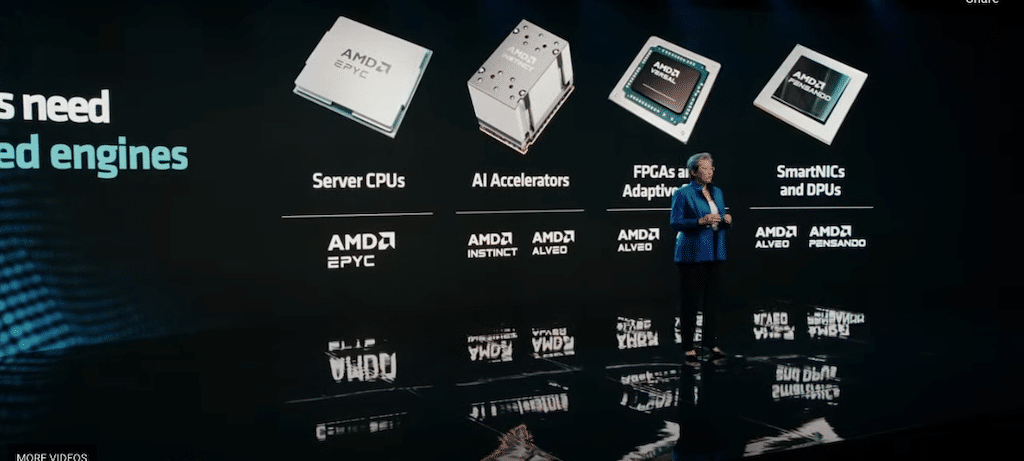

AMD stellte seinen Plan vor, seine KI-Plattform zu verbessern, indem es seinen Kunden eine Reihe von Hardwareprodukten anbietet, von der Cloud über Edge bis hin zu Endpunkten, und eine umfassende Zusammenarbeit mit Branchensoftware vornimmt, um anpassungsfähige und weit verbreitete KI-Lösungen zu schaffen.

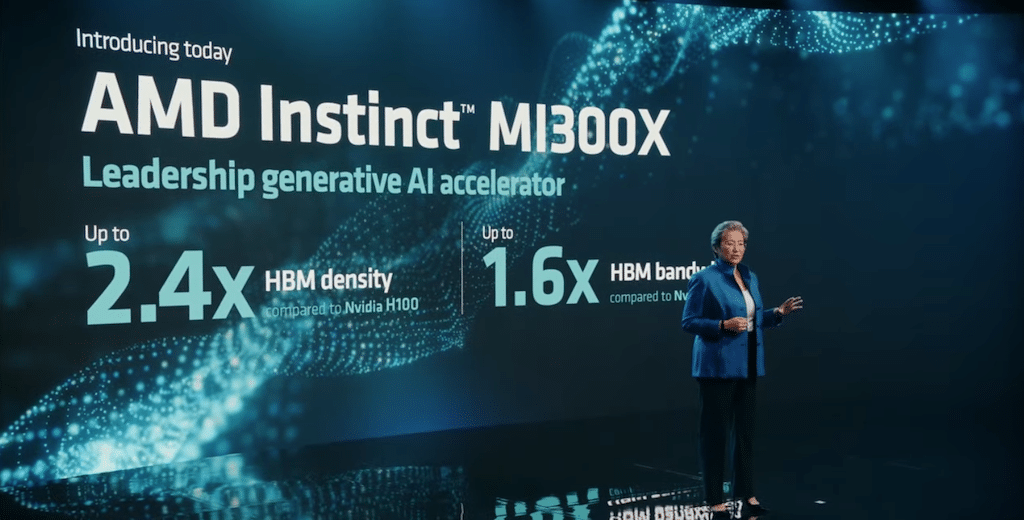

AMD teilte Details zum Beschleuniger der AMD Instinct MI300-Serie mit Familie, einschließlich des AMD Instinct MI300X-Beschleunigers, einem fortschrittlichen Beschleuniger für generative KI.

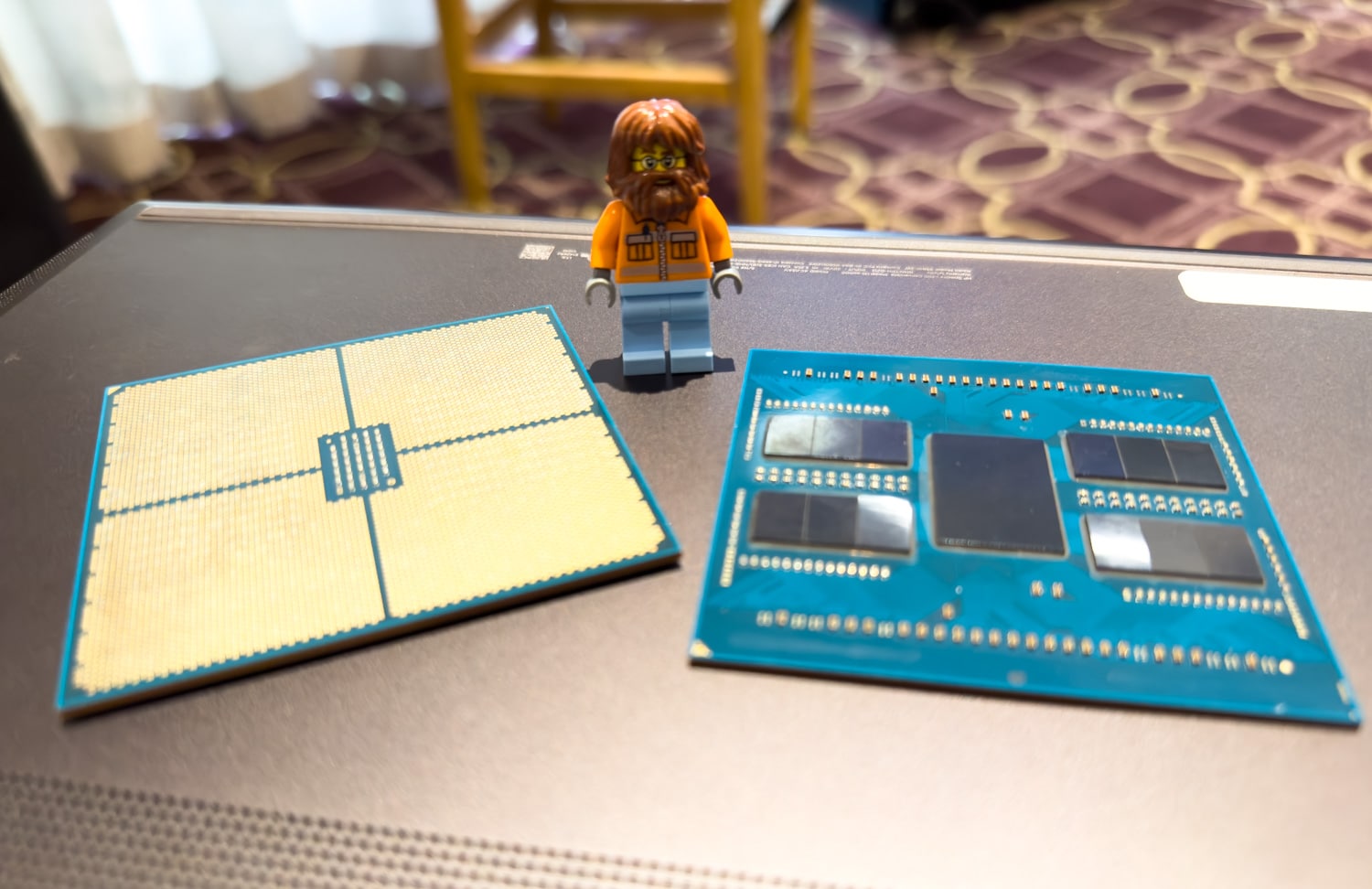

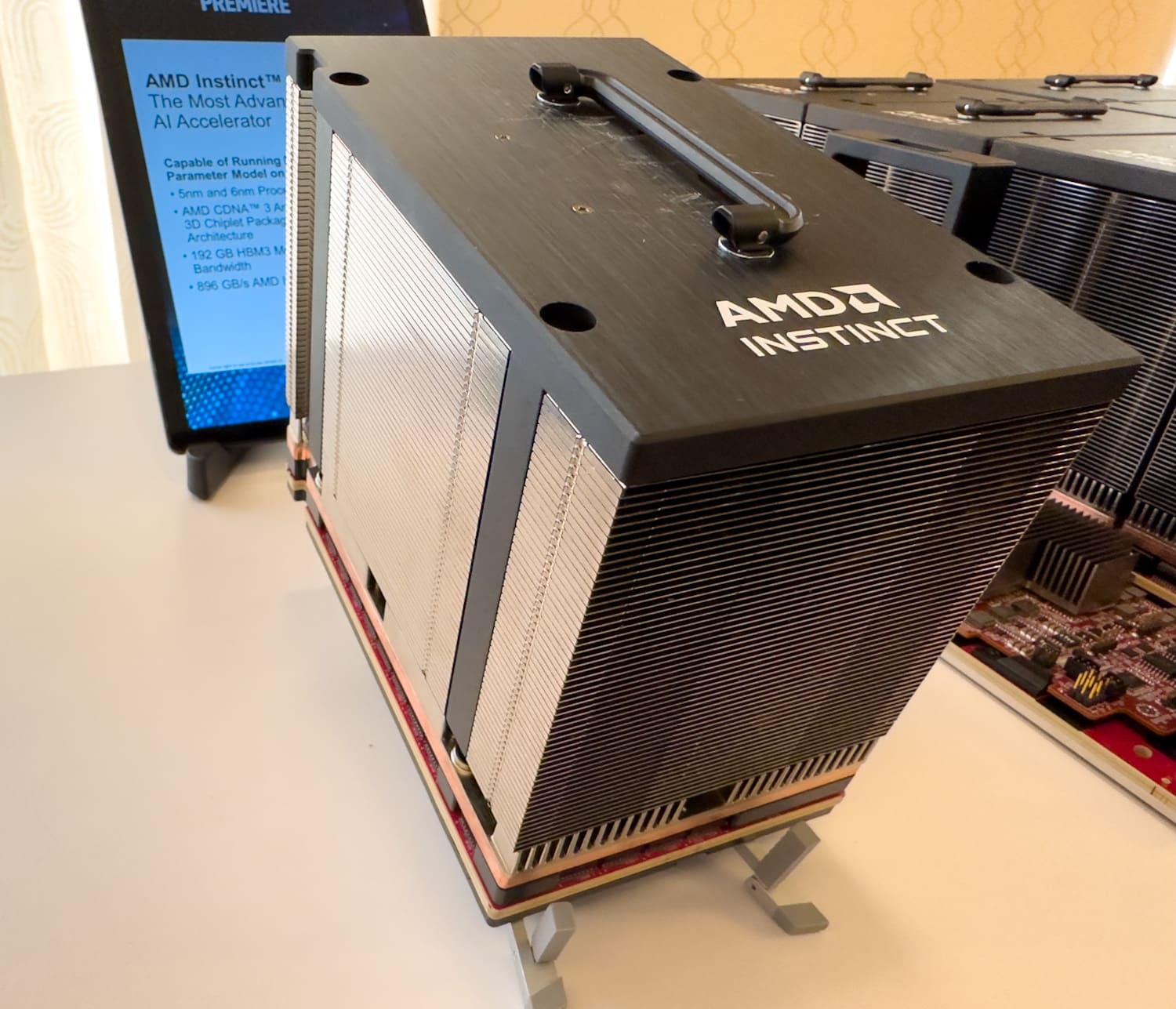

Die Einführung des AMD Instinct MI300X-Beschleunigers ist faszinierend. Diese hochmoderne Accelerated Processing Unit (APU) ist Teil der CDNA 3-Beschleunigerarchitektur der nächsten Generation von AMD und verfügt über bis zu 192 GB HBM3-Speicher. Dieser umfangreiche Speicherpool ist für die Bewältigung anspruchsvoller KI-Arbeitslasten konzipiert, insbesondere für solche mit LLM-Inferenz (Large Language Model) und generativer KI. Dank der enormen Kapazität des MI300X können selbst die größten Sprachmodelle wie Falcon-40B auf einem einzigen GPU-Beschleuniger untergebracht werden. Dies stellt einen potenziell transformativen Fortschritt für die KI-Verarbeitung und -Effizienz dar.

Die Markteinführung des AMD MI300X könnte möglicherweise die bestehende Vormachtstellung von NVIDIA gefährden, da es darauf ausgelegt ist, den amtierenden Marktführer, den NVIDIA H100, herauszufordern. NVIDIA hält die Mehrheitsbeteiligung in diesem lukrativen und schnell wachsenden Marktsegment und verfügt bei KI-Servern über einen Marktanteil von rund 60 bis 70 Prozent. Die Einführung eines derart leistungsfähigen Beschleunigers zu diesem Zeitpunkt wird sich positiv auf das gesamte Ökosystem auswirken, das in erster Linie an NVIDIAs CUDA gebunden ist. Weitere 20 Prozent stammen von maßgeschneiderten anwendungsspezifischen integrierten Chips (ASICs), die von Cloud-Server-Anbietern hergestellt werden, darunter die Inferentia- und Trainium-Chips von Amazon sowie die Tensor Processing Units (TPUs) von Alphabet.

AMD Infinity-Architekturplattform

AMD stellte außerdem die AMD Infinity Architecture Platform vor, die acht MI300X-Beschleuniger in einem Industriestandard-Design für verbesserte generative KI-Inferenz und -Training vereint.

Der MI300X ist im Sampling an Schlüsselkunden ab dem dritten Quartal. Der erste APU-Beschleuniger für HPC- und KI-Workloads, der AMD Instinct MI3A, wird jetzt als Muster an Kunden geliefert.

AMD stellte die Zusammenarbeit mit Branchenführern zur Schaffung eines offenen KI-Ökosystems hervor und präsentierte das AMD ROCm-Software-Ökosystem für Rechenzentrumsbeschleuniger.

Ein Netzwerkportfolio für Cloud und Unternehmen

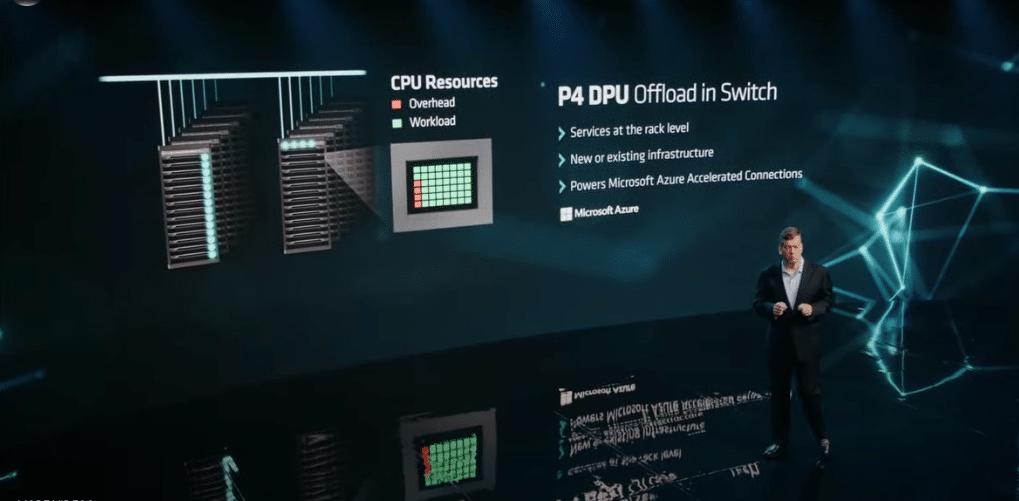

AMD stellte außerdem sein Netzwerkportfolio vor, zu dem auch die AMD Pensando DPU von AMD gehört NICs mit extrem niedriger Latenz und AMD Adaptive NIC. AMD Pensando DPUs kombinieren a Software-Stack mit „Zero Trust Security“ und einem programmierbaren Paketprozessor Erstellen Sie eine intelligente und leistungsstarke DPU.

AMD stellte die nächste Generation seiner DPU mit dem Codenamen „Giglio“ vor, die Folgendes bringen soll Es bietet im Vergleich zu Produkten der aktuellen Generation eine verbesserte Leistung und Energieeffizienz und wird voraussichtlich Ende 2023 verfügbar sein.

Die letzte Ankündigung konzentrierte sich auf das AMD Pensando Software-in-Silicon Developer Kit (SSDK). Kunden die Möglichkeit, Dienste schnell zu entwickeln oder zu migrieren, um sie auf dem AMD Pensando P4 bereitzustellen programmierbare DPU in Abstimmung mit den vorhandenen Funktionen, die derzeit implementiert sind die AMD Pensando-Plattform. Mit dem AMD Pensando SSDK können Kunden die Leistung nutzen die AMD Pensando DPU zum Arbeiten und Anpassen der Netzwerkvirtualisierung und -sicherheit Funktionen innerhalb ihrer Infrastruktur.

AMD EPYC-Prozessoren der 4. Generation

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed