Dell Technologies hat Dell Validated Designs for Analytics – Data Lakehouse eingeführt, das es Unternehmen ermöglicht, sowohl Data Lakes als auch Data Warehouses zu kombinieren, was zu Datenqualität, Leistung, Sicherheit und Governance für alle Datentypen mit Self-Service auf Abruf führt.

Dell Technologies hat Dell Validated Designs for Analytics – Data Lakehouse eingeführt, das es Unternehmen ermöglicht, sowohl Data Lakes als auch Data Warehouses zu kombinieren, was zu Datenqualität, Leistung, Sicherheit und Governance für alle Datentypen mit Self-Service auf Abruf führt.

Daten Lakehouse

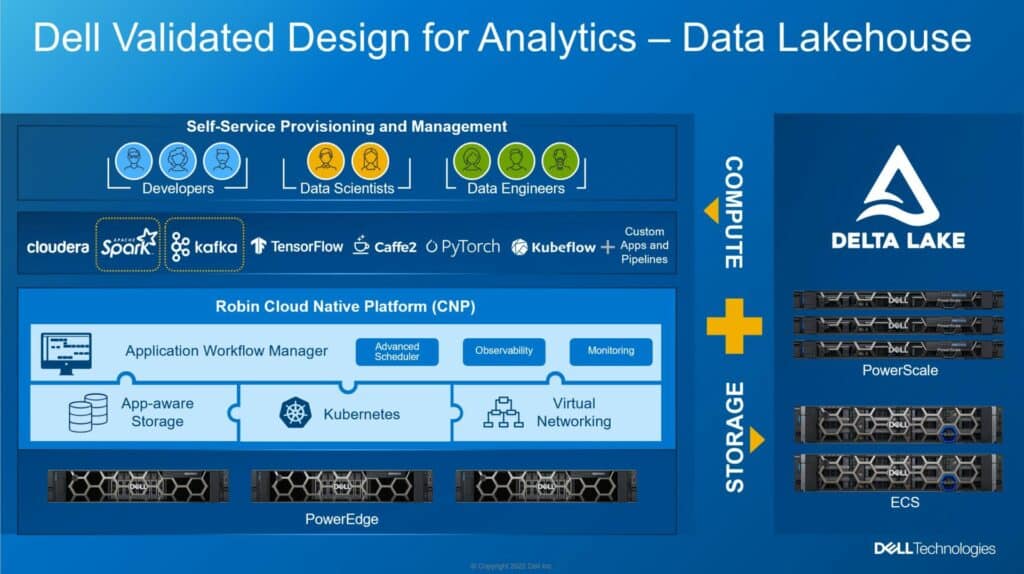

Dell Data Lakehouse ermöglicht die Weiterentwicklung der Datenverwaltung von isolierten, starren, kostspieligen und langsamen Systemen hin zu einheitlichen Systemen, die Business Intelligence (BI), Analysen, Echtzeit-Datenanwendungen, Datenwissenschaft und maschinelles Lernen (ML) ermöglichen. Die von Data Lakehouse validierte Lösung umfasst Geräte aus dem gesamten Dell-Portfolio, einschließlich PowerEdge, PowerScale, ECS Object Storage und PowerSwitch.

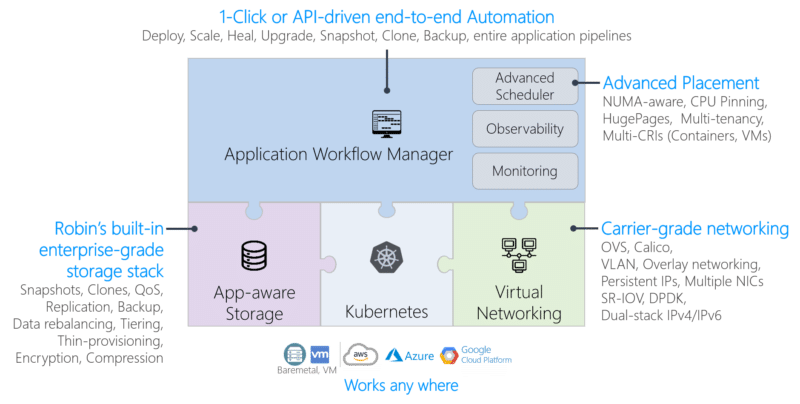

Es ist jedoch nicht nur Hardware, die Infrastruktur wird von Apache Spark und Kafka mit Delta-Lake-Technologien und der Robin Cloud-Native Platform (CNP) betrieben. Wenn alles gebündelt ist, ist diese Lösung darauf ausgelegt, mehr Daten zu nutzen, um Erkenntnisse unternehmensübergreifend zu transformieren.

Laut einem Blog von Chhandomay Mandal, Director ISG Solution Marketing bei Dell, „werden traditionelle Datenverwaltungssysteme wie Data Warehouses seit Jahrzehnten verwendet, um strukturierte Daten zu speichern und für Analysen verfügbar zu machen.“ Data Warehouses sind jedoch nicht für die Bewältigung der zunehmenden Datenvielfalt ausgelegt. Dell hat ein Referenzarchitekturdesign für einen kombinierten Data Lake/Data Warehouse unter Verwendung von Partnersoftware von Drittanbietern und eigener Server-, Speicher- und Netzwerkhardware entwickelt Software – Text, Bilder, Video, Internet der Dinge (IoT) – und sie können auch keine Algorithmen für künstliche Intelligenz (KI) und maschinelles Lernen (ML) unterstützen, die einen direkten Zugriff auf Daten erfordern.“

Data Lakes versprachen, zur Lösung dieser Probleme beizutragen, indem sie es Unternehmen ermöglichten, strukturierte, unstrukturierte und halbstrukturierte Daten flexibler und kostengünstiger zu erfassen als herkömmliche Data Warehouses. Unternehmen nutzen einen Data Lake zusammen mit einem Data Warehouse, indem sie Daten im Lake speichern und dann in das Warehouse kopieren, wodurch sie leichter zugänglich sind und die Analyselandschaft komplexer und teurer wird.

Sobald Unternehmen diesen riesigen Datenfußabdruck besser im Griff haben, unterstützt Data Lakehouse alle möglichen Anwendungsfälle. Business Intelligence (BI), Analytics, Echtzeit-Datenanwendungen, Data Science und ML sind die Spitzenkandidaten. Der Punkt, den Dell mehr oder weniger hervorhebt, ist, dass es viel einfacher ist, geschäftliche Vorteile zu erzielen, wenn man erst einmal die riesigen Datenmengen im Griff hat.

Technische Daten von Dell Data Lakehouse

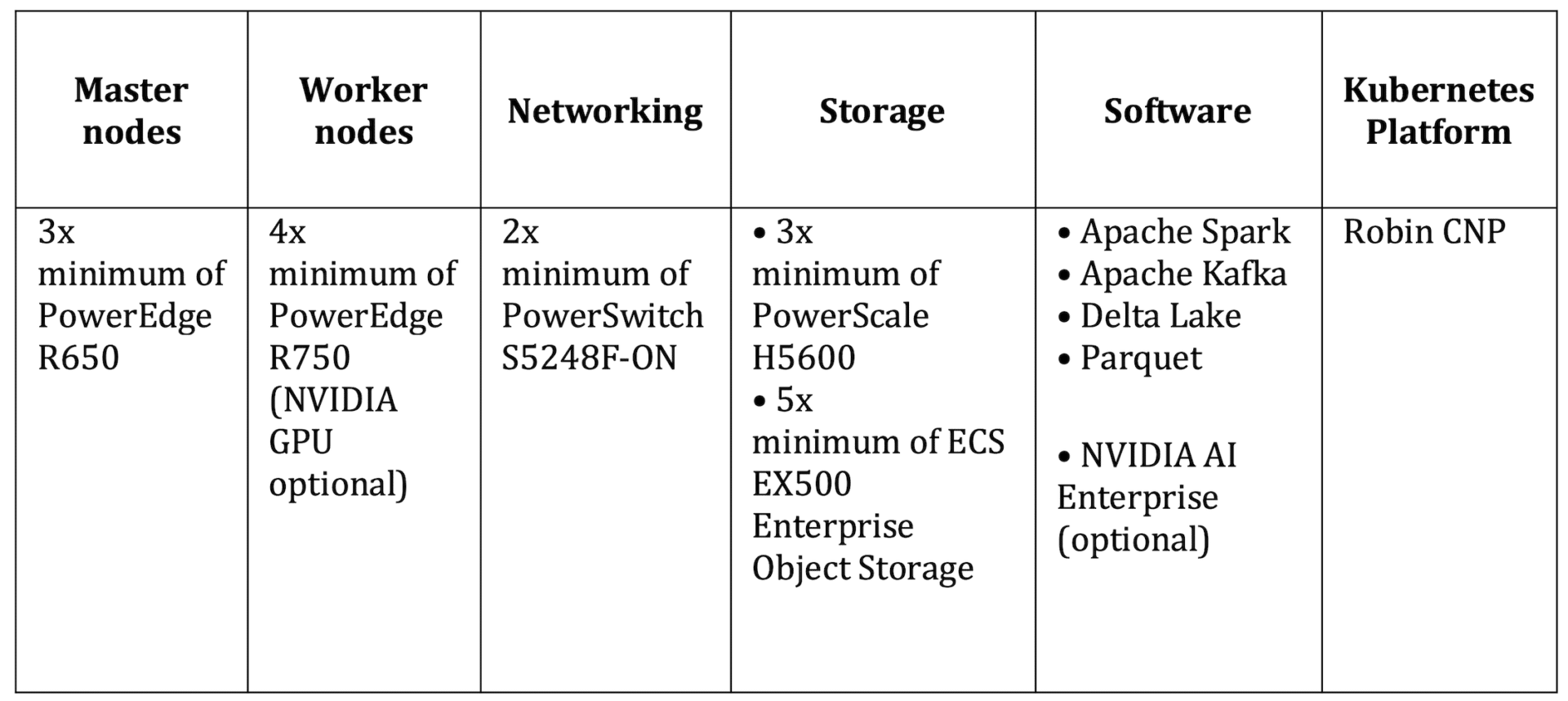

Dell Data Lakehouse bündelt eine Menge Software, aber letztendlich handelt es sich um eine hardwarebasierte konvergente Infrastruktur darunter. Für dieses Design hat Dell einige seiner besten Hardwareangebote im gesamten Portfolio zusammengestellt.

Die folgende Tabelle hebt die wichtigsten Komponenten des Systems hervor, einschließlich der Worker-Knoten, die GPUs unterstützen können. Viele Unternehmen werden diesen Weg einschlagen wollen, da ein großer Teil der an diesen Daten durchzuführenden Analysen von der erhöhten Rechenleistung profitieren kann, die GPUs zur Verfügung stellen können.

Die von Dell validierten Designs für Analytics – Data Lakehouse sind ab sofort verfügbar.

Data Lakehouse-Flyer von Dell (PDF)

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | Facebook | TikTok | RSS Feed