Der Lenovo ThinkSystem SR675 V3-Server – angetrieben von NVIDIAs neuen L40S-GPUs – betrat die Bühne bei SIGGRAPH in Los Angeles und wurde zu einem Schwerpunkt in NVIDIAs Plänen, globale KI-Rollouts voranzutreiben und generative KI-Anwendungen wie intelligente Chatbots, Such- und Zusammenfassungstools einzuführen Benutzer aus verschiedenen Branchen.

Der Lenovo ThinkSystem SR675 V3-Server – angetrieben von NVIDIAs neuen L40S-GPUs – betrat die Bühne bei SIGGRAPH in Los Angeles und wurde zu einem Schwerpunkt in NVIDIAs Plänen, globale KI-Rollouts voranzutreiben und generative KI-Anwendungen wie intelligente Chatbots, Such- und Zusammenfassungstools einzuführen Benutzer aus verschiedenen Branchen.

Das neue ThinkSystem wurde als NVIDIA OVX-Server vorgestellt und wird in Kürze die kürzlich angekündigten NVIDIA L40S-GPUs integrieren. Diese Zusammenarbeit soll dazu beitragen, KI-Implementierungen zu revolutionieren und KI der nächsten Generation, immersive Metaverse-Simulationen und kognitive Entscheidungen in großem Maßstab zu ermöglichen.

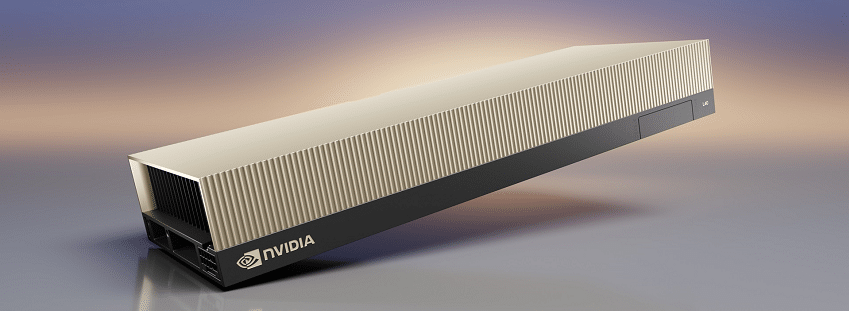

NVIDIA L40S-GPUs

Die neu vorgestellte NVIDIA L40S GPU ist ein leistungsstarker, universeller Rechenzentrumsprozessor, der speziell für die Beschleunigung rechenintensiver Anwendungen entwickelt wurde, darunter KI-Training und -Inferenz, 3D-Designs und -Visualisierung, Videoverarbeitung und industrielle Digitalisierung mit der NVIDIA Omniverse-Plattform. Es bietet eine bahnbrechende Multi-Workload-Beschleunigung für LLM-Inferenz (Large Language Model), Grafik- und Videoanwendungen.

Die L40S-GPU ermöglicht die nächste Generation KI-gestützter Audio-, Sprach-, 2D-, Video- und 3D-Anwendungen und ist eine entscheidende Komponente für die kommenden NVIDIA Omniverse OVX 3.0-Plattformen, die hohe Wiedergabetreue und genaue digitale Zwillinge bieten.

Die NVIDIA L40S-GPU wird ein wichtiger Bestandteil der NVIDIA OVX-Systeme sein. Angetrieben von der NVIDIA Ada Lovelace GPU-Architektur und großzügigen 48 GB Arbeitsspeicher kann jeder Server bis zu acht L40S-GPUs beherbergen. Es verfügt außerdem über Tensorkerne der vierten Generation und eine FP8 Transformer Engine, die erstaunliche 1.45 Petaflops Tensor-Rechenleistung liefern.

Im Vergleich zu seinem Vorgänger, der NVIDIA A100 Tensor Core GPU, weist der L40S eine bis zu 1.2-mal höhere generative KI-Inferenzleistung und eine bis zu 1.7-mal schnellere Trainingsleistung für die Bewältigung komplexer KI-Workloads mit Milliarden von Parametern und mehreren Datenmodalitäten auf.

Die L40S-GPU ist für eine Vielzahl professioneller Arbeitsabläufe konzipiert. Es umfasst 142 RT-Cores der dritten Generation und liefert 212 Teraflops Raytracing-Leistung, ideal für professionelle High-Fidelity-Visualisierungsworkflows wie Echtzeit-Rendering, Produktdesign und 3D-Inhaltserstellung.

Darüber hinaus bieten die 40 CUDA-Kerne des L18,176S fast die fünffache FP5-Leistung (Single Precision Floating Point) der NVIDIA A32-GPU und stellen so sicher, dass Rechenanforderungen für technische und wissenschaftliche Simulationen mit beschleunigter Effizienz erfüllt werden.

ThinkSystem SR675 V3-Konfigurationen

Lenovo ist strategisch positioniert, um den L40S mit seiner neuen Serverreihe zu unterstützen, die für die neuen GPUs optimiert ist. Durch die Kombination vollständig simulierter digitaler Zwillinge mit generativer KI möchte Lenovo seine Geschäftsprozesse und Designergebnisse verbessern. Die Zusammenarbeit zwischen Lenovo und NVIDIA am NVIDIA OVX-System erleichtert den Aufbau und Betrieb virtueller Welten, erweitert die Fähigkeiten des Systems auf generative KI und bietet leistungsstarke Leistung für Rechenzentren mit KI-Workloads.

Das ThinkSystem SR675 V3 bietet drei Serverkonfigurationen in einer, einschließlich Unterstützung für NVIDIA HGX A100 4-GPU-Systeme mit NVLink und Lenovo Neptune Hybrid-Flüssigkeitskühlung. Darüber hinaus ist es mit 4 oder 8 GPU-Konfigurationen kompatibel, die über NVIDIA L40S-, NVIDIA H100 80 GB- oder NVIDIA H100 NVL-Server in einer 3U-Grundfläche verfügen.

Lenovo betrachtet diese Entwicklungen als einen bedeutenden Schritt bei der Vereinfachung der KI-Einführung, deren Zugänglichkeit für Unternehmen jeder Größe und der Förderung transformativer Intelligenz in allen Branchen.

ThinkSystem SR675 V3-Konfigurationen: Basis-, Dense- und HGX-Module

Im Bereich der AI/HPC-Serverkonfigurationen ist das Verständnis der Kompromisse und Vorteile verschiedener Konfigurationen für die Optimierung und spezifische Workload-Anforderungen von entscheidender Bedeutung. Das Lenovo ThinkSystem SR675 V3 bietet Flexibilität mit seinen Modulkonfigurationen Base, Dense und HGX, die jeweils auf bestimmte Anforderungen zugeschnitten sind.

Basismodul

Die Basismodulkonfiguration richtet sich an Unternehmen, die eine ausgewogene Mischung aus GPU-Unterstützung und Speicherkapazität suchen. Es bietet Platz für bis zu 4 Personen mit doppelter Breite, voller Höhe und voller Länge; FHFL-GPUs, die PCIe Gen5 x16-Verbindungen nutzen. Dies bietet gute Parallelverarbeitungsfunktionen für KI- und Deep-Learning-Workloads.

In Bezug auf den Speicher unterstützt das Basismodul bis zu 8 x 2.5-Zoll-Hot-Swap-SAS/SATA/NVMe-Laufwerke und sorgt so für ein Gleichgewicht zwischen Speichervolumen und Geschwindigkeit.

Dichtes Modul

Für Unternehmen, die der parallelen GPU-Verarbeitung Priorität einräumen, kann das Dense-Modul bis zu 8 GPUs mit doppelter Breite, voller Höhe und voller Länge unterstützen. Jede GPU nutzt PCIe Gen5 x16 auf einem PCIe-Switch, wodurch die Anzahl der GPUs auf einem einzelnen Server für eine verbesserte Parallelverarbeitung maximiert wird.

Wenn es um die Lagerung geht, ist das Dense Module vielseitig einsetzbar. Es unterstützt bis zu 6x EDSFF E1.S NVMe SSDs oder bis zu 4x EDSFF E3.S 1T NVMe HS SSDs. Diese Konfiguration ist ideal für Szenarien, in denen intensive Datenverarbeitungsaufgaben mehr GPUs auf Kosten einer gewissen Speicherflexibilität erfordern.

HGX-Modul

Die Konfiguration des HGX-Moduls ist spezialisiert und zielt auf Hochleistungsanforderungen mit spezifischen GPU-Anforderungen ab. Es nutzt NVIDIA HGX H100 mit 4 über NVLink verbundenen SXM5-GPUs. Diese SXM5-GPUs begrenzen möglicherweise die Gesamtzahl, die Sie in das Gehäuse unterbringen können, bieten jedoch eine überlegene Chipleistung und sind daher ideal für anspruchsvolle KI- und Deep-Learning-Aufgaben.

Hinsichtlich der Speicherung ist das HGX-Modul auf Geschwindigkeit optimiert. Es kann bis zu 4x 2.5-Zoll-Hot-Swap-NVMe-SSDs oder bis zu 4x EDSFF E3.S 1T NVMe HS-SSDs aufnehmen.

Abschließende Gedanken

Jede Modulkonfiguration des ThinkSystem SR675 V3 hat ihre einzigartigen Stärken. Während die SXM5-GPUs im HGX-Modul eine beispiellose Leistung bieten, können sich Unternehmen, die mehr Parallelverarbeitung benötigen, für das Dense-Modul entscheiden, um mehr PCIe-GPUs unterzubringen. Dies geht jedoch mit einem TDP-Verlust und einer möglichen Leistungseinbuße einher. Das Basismodul stellt einen Mittelweg dar und bietet ein ausgewogenes Verhältnis von GPU-Unterstützung und Speicheroptionen. Wie immer hängt die beste Wahl von den spezifischen Anforderungen und Einschränkungen der jeweiligen Aufgabe ab, und wir würden niemals eine dieser Konfigurationen aus unserem Labor verbannen.

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed