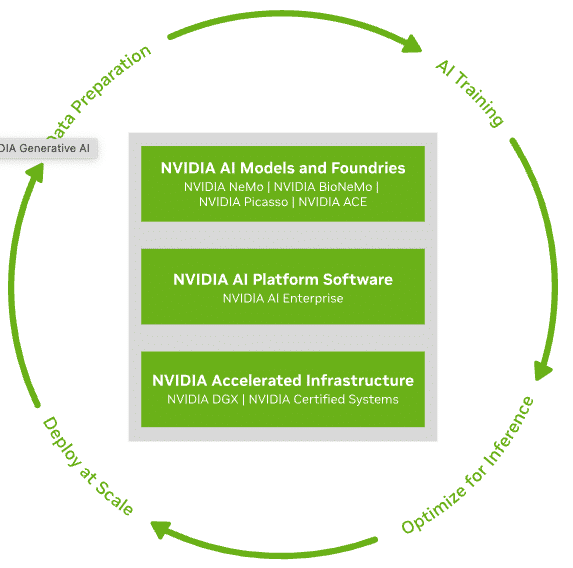

Es war eine arbeitsreiche Woche für NVIDIA und sie sind noch nicht fertig. NVIDIA führt einen KI-Foundry-Service auf Microsoft Azure ein, ein leistungsstarkes neues Tool für Unternehmen, die in benutzerdefinierte generative KI eintauchen.

Es war eine arbeitsreiche Woche für NVIDIA und sie sind noch nicht fertig. NVIDIA führt einen KI-Foundry-Service auf Microsoft Azure ein, ein leistungsstarkes neues Tool für Unternehmen, die in benutzerdefinierte generative KI eintauchen.

Das bringt der KI-Foundry-Service von NVIDIA auf den Tisch:

- NVIDIA AI Foundation-Modelle: Dies sind Ihre KI-Bausteine.

- NVIDIA NeMo Framework und Tools: Das Toolkit zur Feinabstimmung Ihrer KI.

- NVIDIA DGX Cloud AI Supercomputing Services: Das Kraftpaket für die Verwirklichung Ihrer KI-Träume.

Mit diesen Elementen können Unternehmen ihre eigenen KI-Modelle für Dinge wie intelligente Suche und Inhaltserstellung erstellen, die alle auf der NVIDIA AI Enterprise-Software basieren.

Maßgeschneiderte Modelle für generative KI-gestützte Anwendungen

Der KI-Foundry-Service von NVIDIA kann Modelle für generative KI-gestützte Anwendungen in allen Branchen anpassen, darunter Unternehmenssoftware, Telekommunikation und Medien. Wenn benutzerdefinierte Modelle zur Bereitstellung bereit sind, können Unternehmen eine Technik namens „ Retrieval-Augmented Generation (RAG) ihre Modelle mit ihren Unternehmensdaten zu verbinden und neue Erkenntnisse zu gewinnen.

Der Service von NVIDIA dient nicht nur der Show; es ist praktisch. Die Branchenführer SAP SE, Amdocs und Getty Images erstellen mit diesem Service bereits maßgeschneiderte Modelle. Branchen von Software bis Telekommunikation können jetzt KI-Apps erstellen, die ihren Anforderungen entsprechen. SAP nutzt es für seinen KI-Copiloten Joule und Amdocs erweitert sein amAIz-Framework für Telekommunikations-KI-Lösungen.

Jensen Huang, CEO von NVIDIA, betont die Fähigkeit des Dienstes, KI mithilfe der einzigartigen Daten eines Unternehmens anzupassen. Und Satya Nadella, CEO von Microsoft, geht es darum, mit NVIDIAs Hilfe KI-Innovationen auf Azure voranzutreiben.

Nemotron-3 8B

NVIDIA bietet eine Vielzahl von AI Foundation-Modellen an, darunter die vielseitige Nemotron-3 8B-Familie, die sowohl in den Katalogen Azure AI als auch NVIDIA NGC verfügbar ist. Diese Modelle sind für den mehrsprachigen Einsatz und verschiedene Anwendungen geeignet. Community-Modelle wie die Llama 2-Modelle von Meta sind für NVIDIA für beschleunigtes Computing optimiert und auch auf NVIDIA NGC verfügbar und werden bald in den Azure AI-Modellkatalog aufgenommen.

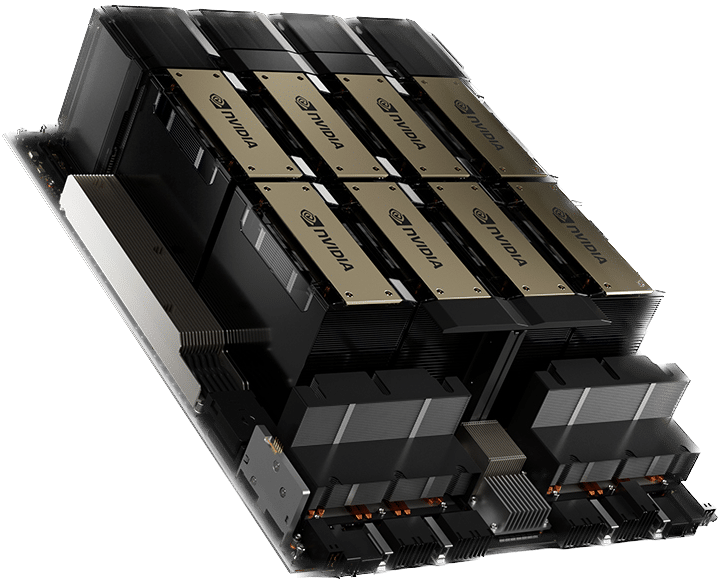

NVIDIA DGX Cloud kommt auf den Azure Marketplace

NVIDIA DGX Cloud AI Supercomputing ist jetzt auf dem Azure Marketplace verfügbar. Mieten Sie, was Sie brauchen, skalieren Sie es einfach und genießen Sie die NVIDIA AI Enterprise-Software für eine schnelle LLM-Anpassung. Es verfügt über Instanzen, die Kunden mieten können, die auf Tausende von NVIDIA Tensor Core-GPUs skalierbar sind, und wird mit NVIDIA AI Enterprise-Software, einschließlich NeMo, geliefert, um die LLM-Anpassung zu beschleunigen.

Durch die Integration von NVIDIA AI Enterprise in Azure Machine Learning erhalten Benutzer eine stabile, sichere KI-Plattform. Es ist auch auf dem Azure Marketplace verfügbar und bietet eine Reihe von KI-Entwicklungs- und Bereitstellungsmöglichkeiten.

Der KI-Foundry-Service von NVIDIA auf Azure ist nicht nur ein Update; Es handelt sich um einen innovativen Ansatz zur kundenspezifischen KI-Entwicklung.

NVIDIA und Microsoft erweitern Azure mit erweiterten KI-Funktionen

Microsoft verbessert sein KI-Spiel auf Azure, führt neue H100-basierte virtuelle Maschinen ein und plant die zukünftige Hinzufügung der H200 Tensor Core GPU. Die auf der Ignite-Konferenz angekündigte neue NC H100 v5 VM-Serie ist eine Premiere im Cloud Computing und verfügt über NVIDIA H100 NVL-GPUs. Diese VMs sind mit zwei PCIe-basierten H100-GPUs, die über NVIDIA NVLink verbunden sind, eine echte Leistung und liefern fast 4 Petaflops KI-Rechenleistung und 188 GB Hochgeschwindigkeits-HBM3-Speicher. Die H100 NVL-GPU ist ein Kraftpaket, das im Vergleich zu Vorgängermodellen bis zu 12-mal mehr Leistung beim GPT-3 175B bietet und sich perfekt für Inferenz- und Mainstream-Schulungsaufgaben eignet.

Integration der NVIDIA H200 Tensor Core GPU in Azure

Microsoft plant, im nächsten Jahr die NVIDIA H200 Tensor Core GPU in Azure zu integrieren. Dieses Upgrade ist für die Inferenzierung größerer Modelle ohne erhöhte Latenz konzipiert, was ideal für LLMs und generative KI-Modelle ist. Der H200 zeichnet sich durch 141 GB HBM3e-Speicher und eine Spitzenspeicherbandbreite von 4.8 TB/s aus und übertrifft damit den H100 deutlich.

Darüber hinaus erweitert Microsoft seine NVIDIA-beschleunigten Angebote mit dem NCC H100 v5, einer neuen vertraulichen VM. Diese vertraulichen Azure-VMs, ausgestattet mit NVIDIA H100 Tensor Core GPUs, gewährleisten die Vertraulichkeit und Integrität von Daten und Anwendungen während der Nutzung. Diese verbesserte Sicherheitsfunktion wird in Kombination mit den Beschleunigungsfähigkeiten des H100 bald in einer privaten Vorschau verfügbar sein.

Diese Fortschritte von NVIDIA und Microsoft stellen einen bedeutenden Sprung in den Cloud-Computing- und KI-Funktionen von Azure dar und bieten beispiellose Leistung und Sicherheit für anspruchsvolle KI-Workloads.

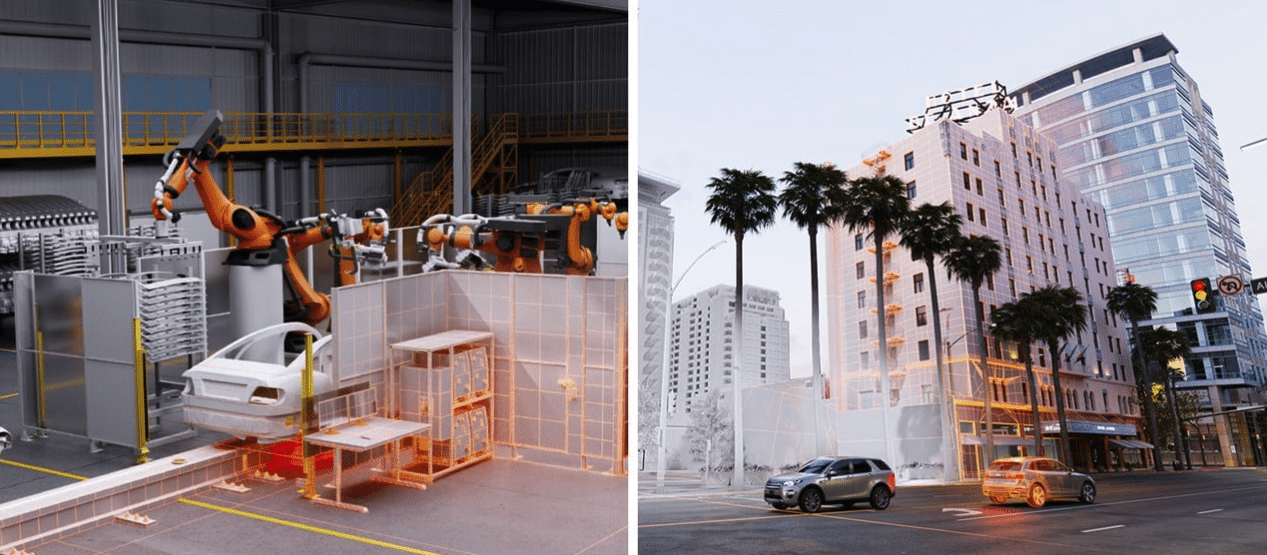

NVIDIA treibt die Digitalisierung der Automobilindustrie mit neuen Simulations-Engines in der Omniverse Cloud voran

NVIDIA verstärkt sein Engagement in der Automobilindustrie durch die Einführung von zwei neuen Simulations-Engines in der Omniverse Cloud: der Simulations-Engine für virtuelle Fabriken und der Simulations-Engine für autonome Fahrzeuge (AV). Die auf Microsoft Azure gehostete Omniverse Cloud verändert die Art und Weise, wie Automobilunternehmen ihren Produktlebenszyklus handhaben, indem sie von physischen, manuellen Prozessen zu softwaregesteuerten, KI-gestützten digitalen Systemen übergeht.

Virtual Factory Simulation Engine: Ein Game-Changer für Automobilhersteller

Diese Engine ist ein Toolkit für Fabrikplanungsteams, um große Industriedatensätze in Echtzeit zu verbinden und daran zusammenzuarbeiten. Es ermöglicht Designteams, virtuelle Fabriken zu bauen und ihre Arbeit nahtlos zu teilen. Dies erhöht die Produktionsqualität und den Durchsatz und spart durch die Vermeidung von Änderungen nach dem Bau erheblich Zeit und Geld.

Zu den Hauptmerkmalen gehört die Kompatibilität mit vorhandener Software wie Autodesk Factory Planning und NX von Siemens, wodurch die Zusammenarbeit über verschiedene Plattformen hinweg verbessert wird. T-Systems und SoftServe nutzen diese Engine bereits, um maßgeschneiderte virtuelle Fabrikanwendungen zu entwickeln.

AV-Simulations-Engine: Revolutionierung der Entwicklung autonomer Fahrzeuge

Die AV-Simulations-Engine ist darauf ausgelegt, eine hochauflösende Sensorsimulation zu liefern, die für die Entwicklung von AV-Architekturen der nächsten Generation von entscheidender Bedeutung ist. Es ermöglicht Entwicklern, autonome Systeme in einer virtuellen Umgebung zu testen und dabei Schichten des Fahrzeugstapels wie Wahrnehmung, Planung und Steuerung zu integrieren.

Diese Engine ist von entscheidender Bedeutung für die Entwicklung fortschrittlicher einheitlicher AV-Architekturen, die eine hochwertige Sensordatensimulation erfordern. NVIDIA integriert seine Sensorsimulationspipelines DRIVE Sim und Isaac Sim in diese Engine und bietet realistische Simulationen für Kameras, Radare, Lidars und andere Sensoren.

Beschleunigung der digitalen Transformation

Die Fabriksimulations-Engine ist jetzt auf dem Azure Marketplace verfügbar und bietet NVIDIA OVX-Systeme und verwaltete Omniverse-Software. Die Sensorsimulations-Engine soll bald folgen. Darüber hinaus können Unternehmen Omniverse Enterprise auf optimierten virtuellen Azure-Maschinen bereitstellen und so den Digitalisierungsprozess im Automobilsektor weiter rationalisieren.

Die neuen Simulations-Engines von NVIDIA in der Omniverse Cloud stellen einen bedeutenden Schritt in der Automobildigitalisierung dar und bieten leistungsstarke Tools für die virtuelle Fabrikplanung und AV-Entwicklung.

KI-Revolution erreicht Windows 11: NVIDIAs großer Sprung mit RTX-GPUs

NVIDIA gestaltet die Windows 11-Landschaft neu und nutzt die Leistung von RTX-GPUs, um den Erfahrungen von Gamern, Entwicklern und alltäglichen PC-Benutzern eine neue Dimension zu verleihen. Mit einer Benutzerbasis von über 100 Millionen Windows-PCs, die mit RTX-GPUs ausgestattet sind, sind die neuesten Innovationen von NVIDIA bereit, Produktivität und Kreativität auf ein neues Niveau zu heben.

Im Vordergrund dieser Entwicklungen steht die Einführung zweier neuer Simulations-Engines in der Omniverse Cloud – der virtuellen Fabrik und der Simulations-Engines für autonome Fahrzeuge (AV). Diese auf Microsoft Azure gehosteten Engines revolutionieren den Produktlebenszyklus der Automobilindustrie und wandeln von traditionellen manuellen Prozessen zu effizienten, KI-gestützten digitalen Systemen um.

In einem bedeutenden Update soll NVIDIAs Open-Source-Software TensorRT-LLM die KI-Inferenzleistung verbessern. Dieses Update erweitert die Unterstützung auf neue große Sprachmodelle und macht komplexe KI-Workloads auf Desktops und Laptops mit RTX-GPUs ab 8 GB VRAM leichter zugänglich. Diese Verbesserung ist ein entscheidender Faktor, insbesondere angesichts der bevorstehenden Kompatibilität von TensorRT-LLM für Windows mit der Chat-API von OpenAI. Diese Integration bedeutet, dass viele Entwicklerprojekte und -anwendungen jetzt lokal auf RTX-PCs ausgeführt werden können, sodass Benutzer vertrauliche Daten sicher auf ihren Windows 11-PCs aufbewahren können, fernab der Cloud.

NVIDIA stellt außerdem AI Workbench vor, ein umfassendes Toolkit, das den Entwicklungsprozess für Entwickler optimieren soll. Diese Plattform vereinfacht die Erstellung, Prüfung und Anpassung vorab trainierter generativer KI-Modelle und LLMs und ermöglicht Entwicklern so die effiziente Verwaltung ihrer KI-Projekte und die Anpassung von Modellen an bestimmte Anwendungsfälle.

In Zusammenarbeit mit Microsoft verbessert NVIDIA DirectML, was eine Beschleunigung grundlegender KI-Modelle wie Llama 2 verspricht. Diese Zusammenarbeit erweitert den Spielraum für die herstellerübergreifende Bereitstellung und setzt neue Maßstäbe bei Leistungsstandards.

Die bevorstehende Veröffentlichung von TensorRT-LLM v0.6.0 ist ein weiterer Sprung nach vorne und verspricht eine bis zu fünfmal schnellere Inferenzleistung. Es wird auch weitere beliebte LLMs unterstützen, darunter Mistral 7B und Nemotron-3 8B. Auf diese Modelle kann auf GPUs der Serien GeForce RTX 30 und 40 mit 8 GB RAM oder mehr zugegriffen werden, sodass erweiterte KI-Funktionen auch auf den mobilsten Windows-Geräten verfügbar sind.

Um diese Fortschritte zu unterstützen, stellt NVIDIA die neue Version von TensorRT-LLM und optimierte Modelle auf seinem GitHub-Repository und ngc.nvidia.com zur Verfügung.

Mit diesen Innovationen verbessert NVIDIA nicht nur das PC-Erlebnis für seine große Benutzerbasis; Es ebnet den Weg für eine neue Ära des KI-gestützten Computings unter Windows 11 und markiert einen entscheidenden Moment an der Schnittstelle von Technologie und Alltag.

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed