NVIDIA rückte bei AWS re:Invent mit der Einführung von NVIDIA NeMo Retriever ins Rampenlicht, einem neuen generativen KI-Mikroservice, der verspricht, die KI-Landschaft von Unternehmen zu verbessern, indem er die Integration benutzerdefinierter großer Sprachmodelle (LLMs) mit Unternehmensdaten ermöglicht. Das Ziel besteht darin, dass NeMo Retriever beispiellos genaue Antworten für KI-Anwendungen im Unternehmen liefert.

NVIDIA rückte bei AWS re:Invent mit der Einführung von NVIDIA NeMo Retriever ins Rampenlicht, einem neuen generativen KI-Mikroservice, der verspricht, die KI-Landschaft von Unternehmen zu verbessern, indem er die Integration benutzerdefinierter großer Sprachmodelle (LLMs) mit Unternehmensdaten ermöglicht. Das Ziel besteht darin, dass NeMo Retriever beispiellos genaue Antworten für KI-Anwendungen im Unternehmen liefert.

NVIDIA NeMo Retriever ist das neueste Mitglied der NeMo-Familie, bekannt für seine fortschrittlichen Frameworks und Tools zum Erstellen, Anpassen und Bereitstellen modernster generativer KI-Modelle. Dieser Semantic-Retrieval-Microservice der Enterprise-Klasse wurde entwickelt, um generative KI-Anwendungen mit robusten RAG-Funktionen (Retrieval-Augmented Generation) zu verbessern.

Was NeMo Retriever auszeichnet, ist seine Fähigkeit, durch NVIDIA-optimierte Algorithmen genauere Antworten zu liefern. Dieser Microservice ermöglicht es Entwicklern, ihre KI-Anwendungen unabhängig vom Standort nahtlos mit verschiedenen Geschäftsdaten zu verbinden – über Clouds oder in Rechenzentren. Als Teil der NVIDIA AI Enterprise-Softwareplattform ist es bequem im AWS Marketplace verfügbar.

NVIDIA NeMo Retriever bereits im Einsatz

Die Auswirkungen der Technologie sind bereits spürbar, da Branchenführer wie Cadence, Dropbox, SAP und ServiceNow mit NVIDIA zusammenarbeiten. Sie integrieren diese Technologie in ihre benutzerdefinierten generativen KI-Anwendungen und -Dienste und erweitern so die Grenzen dessen, was im Bereich Business Intelligence möglich ist.

„Generative KI führt innovative Ansätze ein, um auf Kundenbedürfnisse einzugehen, beispielsweise Tools, um potenzielle Fehler frühzeitig im Designprozess aufzudecken“, sagt Anirudh Devgan, Präsident und CEO von Cadence

Cadence, ein weltweit führender Anbieter von elektronischem Systemdesign, nutzt NeMo Retriever, um RAG-Funktionen für KI-Anwendungen im industriellen Elektronikdesign zu entwickeln. Anirudh Devgan, CEO von Cadence, betonte das Potenzial der generativen KI, Designfehler frühzeitig aufzudecken und dadurch die Entwicklung hochwertiger Produkte zu beschleunigen.

Im Gegensatz zu Open-Source-RAG-Toolkits kommt NeMo Retriever serienreif auf den Markt und bietet kommerziell nutzbare Modelle, API-Stabilität, Sicherheitspatches und Unternehmensunterstützung. Seine optimierten Einbettungsmodelle stellen einen großen technologischen Fortschritt dar, da sie komplexe Wortbeziehungen erfassen und die Verarbeitungs- und Analysefähigkeiten von LLMs verbessern.

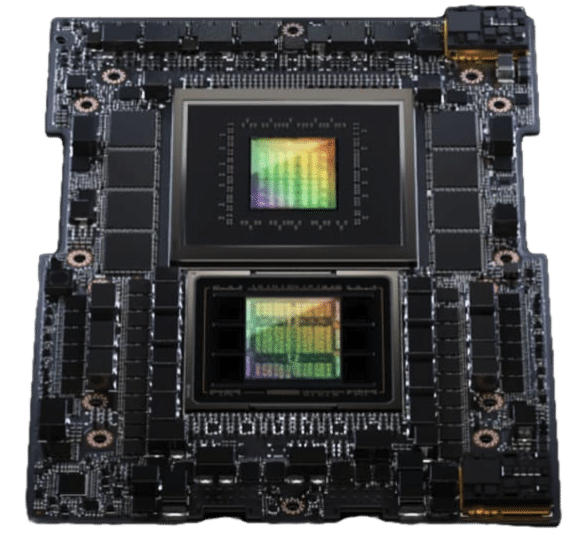

NVIDIA GH200 Superchip

Warum NVIDIA NeMo Retriever wichtig ist

Bemerkenswert ist die Fähigkeit von NeMo Retriever, LLMs mit mehreren Datenquellen und Wissensdatenbanken zu verbinden. Es ermöglicht Benutzern, über einfache Konversationsaufforderungen mit Daten zu interagieren und so genaue, aktuelle Antworten zu erhalten. Diese Funktionalität erstreckt sich über verschiedene Datenmodalitäten, einschließlich Text, PDFs, Bilder und Videos, und gewährleistet einen umfassenden und sicheren Informationszugriff.

Am aufregendsten ist, dass NVIDIA NeMo Retriever genauere Ergebnisse mit weniger Schulungsaufwand verspricht, was die Markteinführungszeit verkürzt und die Energieeffizienz im Entwicklungsworkflow generativer KI-Anwendungen unterstützt.

Hier glänzt der NeMo Retriever wirklich. Durch die Integration von RAG mit LLMs überwindet NeMo Retriever die Einschränkungen traditioneller Modelle. RAG kombiniert die Leistungsfähigkeit des Informationsabrufs mit LLMs, insbesondere für Open-Domain-Frage-Antwort-Anwendungen, und verbessert so den Zugang der LLMs zu umfangreichen, aktualisierbaren Wissensdatenbanken erheblich.

Ein Blick in die RAG-Pipeline

NeMo Retriever optimiert RAG-Prozesse, beginnend mit der Kodierung der Wissensdatenbank in einer Offline-Phase. In dieser Phase werden Dokumente in verschiedenen Formaten mithilfe eines Deep-Learning-Modells in Stücke aufgeteilt und eingebettet, um dichte Vektordarstellungen zu erstellen. Diese werden dann in einer Vektordatenbank gespeichert, was für spätere semantische Suchen von entscheidender Bedeutung ist. Der Einbettungsprozess ist von entscheidender Bedeutung, da er die Beziehungen zwischen Wörtern erfasst und es LLMs ermöglicht, Textdaten mit erhöhter Genauigkeit zu verarbeiten und zu analysieren.

Unter der Haube, in der Produktion und bei der Beantwortung von Fragen glänzen die Fähigkeiten des NeMo Retriever wirklich. Es umfasst zwei entscheidende Phasen: den Abruf aus der Vektordatenbank und die Antwortgenerierung. Wenn ein Benutzer eine Abfrage eingibt, bettet NeMo Retriever diese Abfrage zunächst als dichten Vektor ein und durchsucht damit die Vektordatenbank. Diese Datenbank ruft dann die relevantesten Dokumentabschnitte im Zusammenhang mit der Abfrage ab. In der letzten Phase werden diese Chunks zu einem Kontext zusammengefasst, der zusammen mit der Anfrage des Benutzers in das LLM eingespeist wird. Dieser Prozess stellt sicher, dass die generierten Antworten korrekt und für die Anfrage des Benutzers von hoher Relevanz sind.

Bewältigen Sie Unternehmensherausforderungen mit NVIDIA NeMo

Der Aufbau einer RAG-Pipeline für Unternehmensanwendungen ist eine große Herausforderung. Von der Komplexität realer Abfragen bis hin zur Nachfrage nach Multi-Runden-Gesprächen benötigen Unternehmen eine Lösung, die sowohl technologisch fortschrittlich, konform als auch wirtschaftlich rentabel ist. NeMo Retriever möchte diese Aufgabe erfüllen, indem es produktionsbereite Komponenten bereitstellt, die für geringe Latenz und hohen Durchsatz optimiert sind, und verspricht, dass Unternehmen diese Funktionen in ihren KI-Anwendungen einsetzen können.

Das Engagement von NVIDIA für diese Technologie erstreckt sich auf die kontinuierliche Verbesserung seiner Modelle und Dienste, wie beispielsweise beim NVIDIA Q&A Retrieval Embedding Model. Als Transformer-Encoder wurde er laut NVIDIA so optimiert, dass er die genauesten Einbettungen für textbasierte Fragen- und Antwortfunktionen bietet und dabei sowohl private als auch öffentliche Datensätze nutzt.

Unternehmen mit modernster KI stärken

Die praktischen Einsatzmöglichkeiten des NeMo Retriever sind vielfältig. Von IT- und HR-Hilfsassistenten bis hin zu F&E-Forschungsassistenten – die Fähigkeit von NeMo Retriever, LLMs mit mehreren Datenquellen und Wissensdatenbanken zu verbinden, ermöglicht es Unternehmen, auf gesprächigere und intuitivere Weise mit Daten zu interagieren. NeMo Retriever soll das Benutzererlebnis verbessern und die Effizienz und Produktivität in verschiedenen Geschäftsfunktionen in Unternehmen steigern.

Entwickler, die diese revolutionäre Technologie nutzen möchten, können sich für den frühen Zugriff auf NVIDIA NeMo Retriever anmelden.

Die Begeisterung für diese Version ist spürbar, da sie die aktuellen KI-Funktionen verbessert und eine Vielzahl von Möglichkeiten für die Einführung von LLM im Unternehmenssektor eröffnet. Der Begriff „Game-Changer“ wird in den aktuellen KI-Nachrichten immer wieder verwendet. Dennoch ist NeMo Retriever ein Grundpfeiler bei der Verknüpfung generativer KI und umsetzbarer Business Intelligence und bietet eine konkrete Brücke zwischen fortschrittlichen KI-Funktionen und realen Unternehmensanwendungen.

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed