Supermicro hat ein umfassendes neues Portfolio an Servern vorgestellt, die neue Maßstäbe in den Bereichen KI und Hochleistungsrechnen setzen sollen. Diese Server sind die branchenweit erste Reihe von NVIDIA MGX-Systemen und basieren auf dem NVIDIA GH200 Grace Hopper Superchip. Diese neuen Angebote zielen darauf ab, die Leistung von KI-Workloads drastisch zu verbessern, und basieren auf modernsten technologischen Fortschritten.

Supermicro hat ein umfassendes neues Portfolio an Servern vorgestellt, die neue Maßstäbe in den Bereichen KI und Hochleistungsrechnen setzen sollen. Diese Server sind die branchenweit erste Reihe von NVIDIA MGX-Systemen und basieren auf dem NVIDIA GH200 Grace Hopper Superchip. Diese neuen Angebote zielen darauf ab, die Leistung von KI-Workloads drastisch zu verbessern, und basieren auf modernsten technologischen Fortschritten.

Von der Integration der neueste DPU-Vernetzung und Kommunikationstechnologien bis hin zur Integration der fortschrittlichen Flüssigkeitskühlungslösungen von Supermicro für Einsätze mit hoher Dichte stellen diese Server einen Fortschritt bei skalierbaren und anpassbaren Computerlösungen dar.

Die neuen Servermodelle umfassen Folgendes:

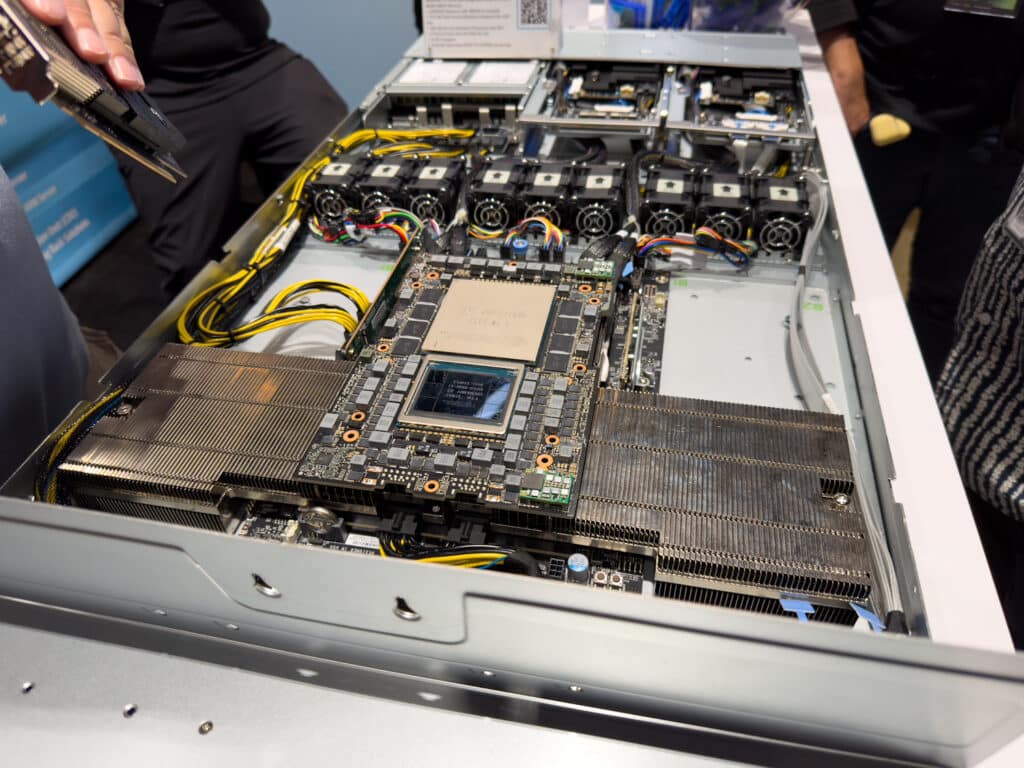

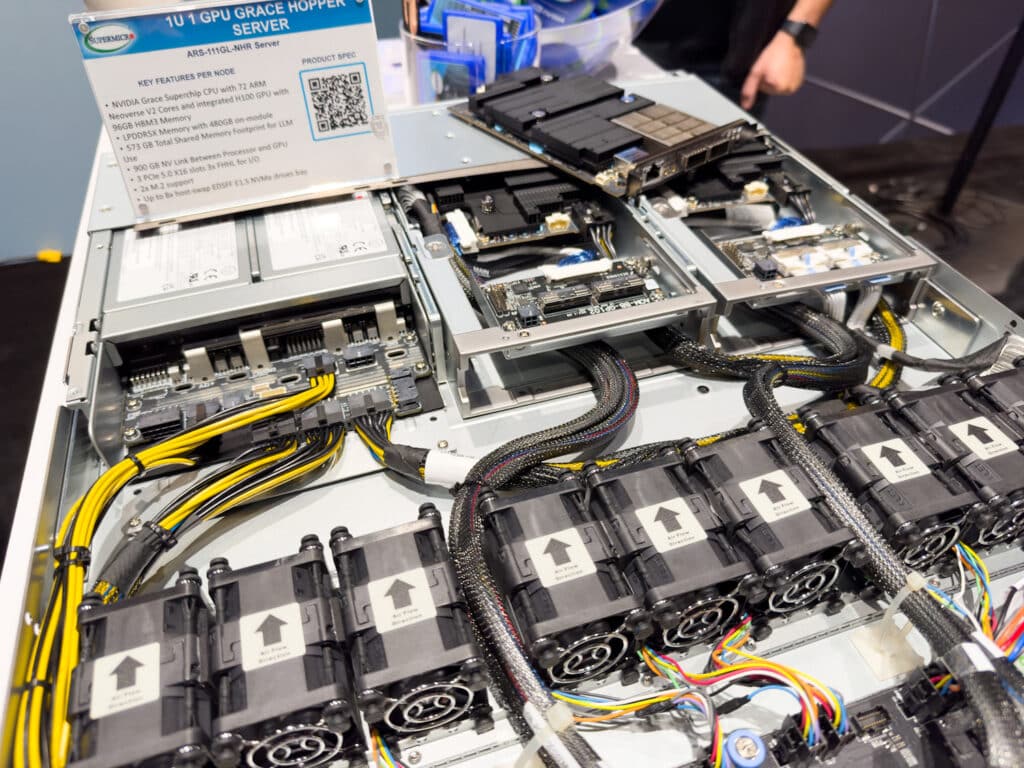

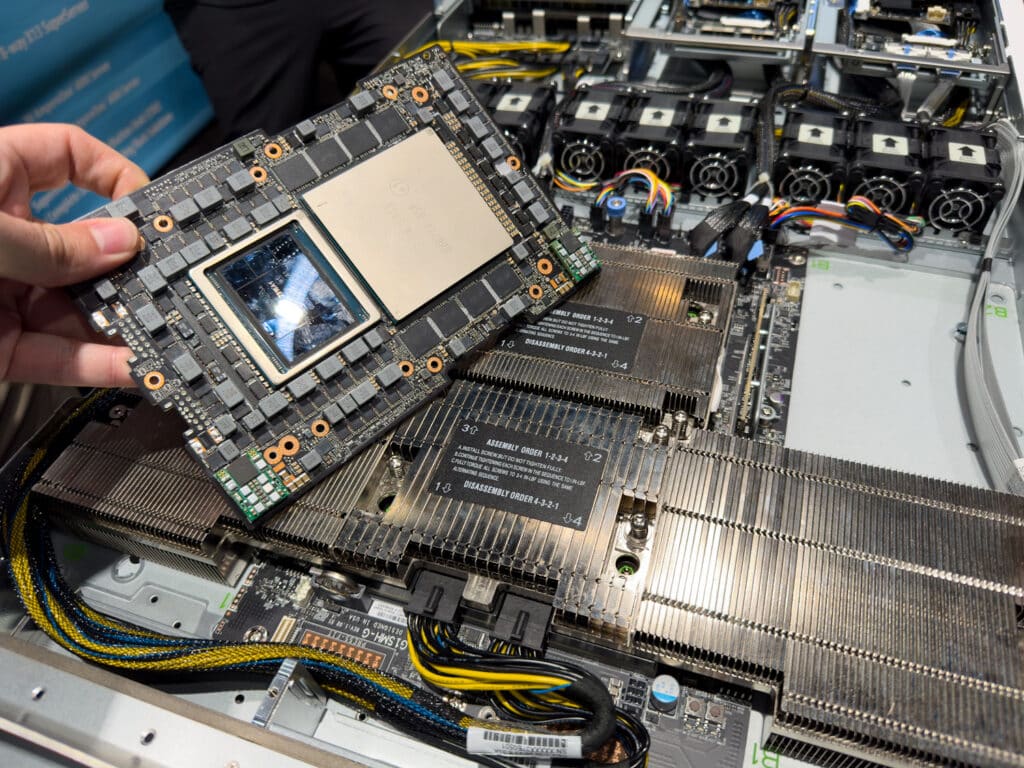

ARS-111GL-NHR: Dieser luftgekühlte Server ist ein 1U-GPU-System mit hoher Dichte, das über eine integrierte NVIDIA H100-GPU und einen NVIDIA Grace Hopper Superchip verfügt. Mit einer 900 GB/s NVLink Chip-2-Chip-Verbindung und bis zu 576 GB kohärentem Speicher ist dieser Server speziell für anspruchsvolle Anwendungen wie Hochleistungsrechnen, KI/Deep Learning und große Sprachmodelle konzipiert. Das System umfasst außerdem 3x PCIe 5.0 x16-Steckplätze und neun Hot-Swap-Hochleistungslüfter für optimales Wärmemanagement.

ARS-111GL-NHR-LCC: Ähnlich wie das ARS-111GL-NHR handelt es sich bei diesem System um ein 1U-GPU-System mit hoher Dichte, jedoch mit dem zusätzlichen Vorteil einer Flüssigkeitskühlung. Es verfügt über dieselben Kernfunktionen wie den NVIDIA Grace Hopper Superchip und die 900 GB/s NVLink C2C-Verbindung. Die Flüssigkeitskühlung verbessert die Energieeffizienz und eignet sich für ähnliche Anwendungen mit hoher Rechenleistung, jedoch mit potenziell geringeren Betriebskosten aufgrund von sieben Hot-Swap-Hochleistungslüftern.

ARS-111GL-DHNR-LCC: Die GPU ARS-111GL-DNHR-LCC packt zwei Knoten in einen 1U-Formfaktor, von denen jeder eine integrierte NVIDIA H100-GPU und einen Grace Hopper Superchip unterstützt. Mit bis zu 576 GB kohärentem Speicher pro Knoten bietet dieser Server ein Gleichgewicht aus hoher Rechenleistung und Platzeffizienz. Es eignet sich gut für Anwendungen mit großen Sprachmodellen, Hochleistungsrechnen und KI/Deep Learning.

ARS-121L-DNR: Dieser 1U-Server mit hoher Dichte umfasst zwei Knoten, von denen jeder eine NVIDIA H100-GPU und einen 144-Kern-NVIDIA-Grace-CPU-Superchip unterstützt. Der Server verfügt über 2x PCIe 5.0 x16-Steckplätze pro Knoten und kann bis zu vier Hot-Swap-E1.S-Laufwerke und zwei M.2 NVMe-Laufwerke pro Knoten aufnehmen. Mit 900 GB/s NVLink-Verbindung zwischen CPUs ist dieser Server für Hochleistungsrechnen, KI/Deep Learning und große Sprachmodelle optimiert.

ARS-221GL-NR: Die GPU ARS-221GL-NR ist ein 2U-GPU-System mit hoher Dichte, das bis zu vier NVIDIA H100 PCIe-GPUs unterstützen kann. Mit 480 GB oder 240 GB integrierten LPDDR5X-Speicheroptionen ist dieser Server für Aufgaben mit geringer Latenz und hoher Energieeffizienz konzipiert und eignet sich daher ideal für Hochleistungsrechnen, Hyperscale-Cloud-Anwendungen und Datenanalysen.

SYS-221GE-NR: Dieser 2U-GPU-Server mit hoher Dichte unterstützt bis zu vier NVIDIA H100 PCIe-GPUs und bietet maximal 8 TB ECC DDR5-Speicher über 32 DIMM-Steckplätze. Der Server verfügt außerdem über sieben PCIe 5.0 x16 FHFL-Steckplätze und unterstützt die NVIDIA BlueField-3 Datenverarbeitungseinheit für anspruchsvolle, beschleunigte Rechenaufgaben. Mit E1.S NVMe-Speicherunterstützung eignet sich dieser Server für Hochleistungsrechnen, KI/Deep Learning und die Verarbeitung natürlicher Sprache mit großen Sprachmodellen.

Jede MGX-Plattform ist entweder mit NVIDIA BlueField-3 DPU oder NVIDIA ConnectX-7-Verbindungen aufrüstbar und bietet überlegene Leistung in InfiniBand- oder Ethernet-Netzwerken.

Technische Daten

Supermicros neues 1U NVIDIA MGX Systeme sind auf robuste Leistung ausgelegt und verfügen über bis zu zwei NVIDIA GH200 Grace Hopper Superchips, jeweils mit zwei NVIDIA H100 GPUs und zwei NVIDIA Grace CPUs. Diese Geräte sind mit 480 GB LPDDR5X-Speicher für die CPU und entweder 96 GB oder 144 GB HBM3/HBM3e-Speicher für die GPU ausgestattet.

Die Systeme nutzen NVIDIA-C2C-Verbindungen, die CPU, GPU und Speicher mit unglaublichen 900 GB/s verbinden – siebenmal schneller als der PCIe-Gen5-Standard. Darüber hinaus umfasst das modulare Design mehrere PCIe 5.0 x16-Steckplätze, was eine Erweiterbarkeit im Hinblick auf zusätzliche GPUs, DPUs für Cloud- und Datenmanagement sowie Speicherlösungen ermöglicht.

Im Hinblick auf die Betriebseffizienz verspricht das 1U-2-Knoten-Design von Supermicro, ausgestattet mit Flüssigkeitskühlungstechnologie, eine Reduzierung der Betriebsausgaben (OPEX) um über 40 Prozent bei gleichzeitiger Erhöhung der Rechendichte. Dies macht es ideal für die Bereitstellung großer Sprachmodellcluster und Hochleistungs-Computing-Anwendungen.

In der 2U-Konfiguration sind diese Plattformen sowohl mit NVIDIA Grace- als auch mit x86-CPUs kompatibel und können bis zu vier Rechenzentrums-GPUs in voller Größe hosten. Sie verfügen außerdem über zusätzliche PCIe 5.0 x16-Steckplätze für I/O und acht Hot-Swap-fähige EDSFF-Speicherschächte.

Letztendlich sind die MGX-Systeme von Supermicro mit NVIDIA Grace Superchip-CPUs, die über 144 Kerne verfügen und im Vergleich zu aktuellen x86-CPUs die doppelte Leistung pro Watt bieten, vielseitig und effizient. Diese Systeme sind so positioniert, dass sie Rechendichten und Energieeffizienz sowohl in Hyperscale- als auch in Edge-Rechenzentren neu definieren.

Produktseiten:

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed