Supermicro hat eine neue Reihe von Lösungen auf den Markt gebracht, um den Einsatz generativer KI voranzutreiben, was einen bedeutenden Schritt in der Entwicklung der Infrastruktur für große Sprachmodelle (LLMs) darstellt. Diese SuperCluster-Lösungen sind als Kernkomponenten konzipiert, um aktuelle und zukünftige KI-Anforderungen zu unterstützen.

Supermicro hat eine neue Reihe von Lösungen auf den Markt gebracht, um den Einsatz generativer KI voranzutreiben, was einen bedeutenden Schritt in der Entwicklung der Infrastruktur für große Sprachmodelle (LLMs) darstellt. Diese SuperCluster-Lösungen sind als Kernkomponenten konzipiert, um aktuelle und zukünftige KI-Anforderungen zu unterstützen.

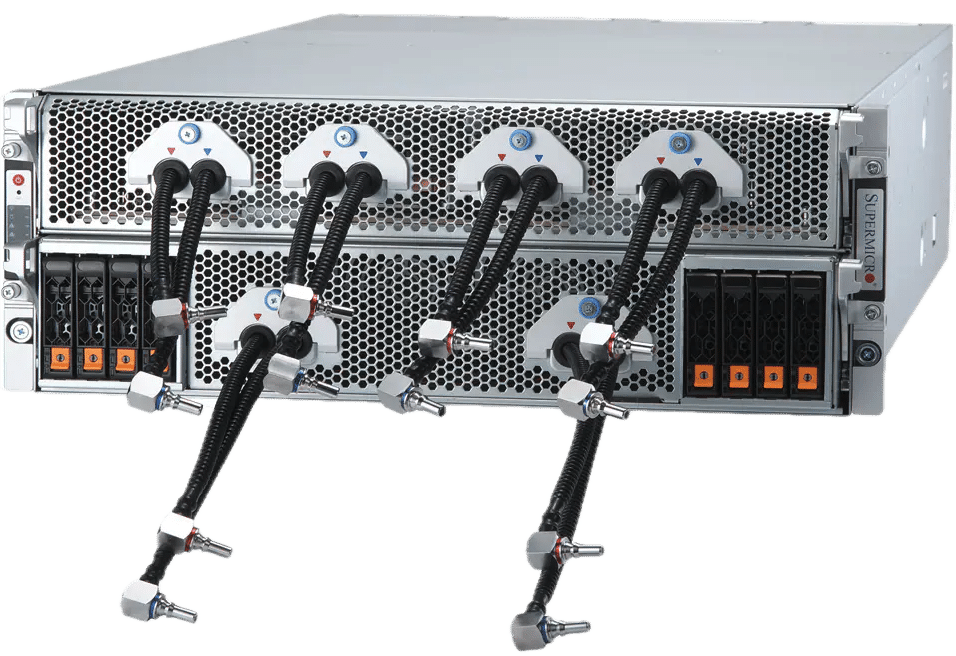

Diese neue Version enthält drei verschiedene SuperCluster-Konfigurationen, die auf generative KI-Aufgaben zugeschnitten sind. Zu den Optionen gehören ein flüssigkeitsgekühltes 4U-System und ein luftgekühltes 8U-Setup, das für intensives LLM-Training und LLM-Inferenz mit hoher Kapazität entwickelt wurde. Darüber hinaus ist eine luftgekühlte 1U-Variante mit Supermicro NVIDIA MGX-Systemen auf Inferenzanwendungen im Cloud-Maßstab ausgerichtet. Diese Systeme sind darauf ausgelegt, im LLM-Training eine beispiellose Leistung zu liefern und zeichnen sich durch Funktionen wie große Chargengrößen und umfangreiche Volumenverarbeitungsfunktionen für LLM-Inferenz aus.

Kapazitätserweiterung für KI-Cluster

Mit der Fähigkeit, bis zu 5,000 Racks pro Monat zu produzieren, ist Supermicro in der Lage, schnell komplette generative KI-Cluster zu liefern und seinen Kunden schnellere Liefergeschwindigkeiten zu versprechen. Ein 64-Knoten-Cluster kann beispielsweise 512 NVIDIA HGX H200-GPUs integrieren und die Hochgeschwindigkeits-NVIDIA Quantum-2 InfiniBand- und Spectrum-X-Ethernet-Netzwerke nutzen, um eine robuste KI-Trainingsumgebung zu schaffen. In Verbindung mit der NVIDIA AI Enterprise-Software ist diese Konfiguration eine ideale Lösung für Unternehmens- und Cloud-Infrastrukturen, die darauf abzielen, anspruchsvolle LLMs mit Billionen von Parametern zu trainieren.

Innovative Kühlung und Leistung

Die neuen Supermicro 4U NVIDIA HGX H100/H200 8-GPU-Systeme nutzen die Flüssigkeitskühlung, um die Dichte im Vergleich zu den luftgekühlten 8U-Alternativen zu verdoppeln, was zu einem geringeren Energieverbrauch und einer Senkung der Gesamtbetriebskosten für Rechenzentren führt. Diese Systeme unterstützen auf der NVIDIA Blackwell-Architektur basierende GPUs der nächsten Generation und verfügen über effiziente Kühltechnologien, die optimale Temperaturen für maximale Leistung aufrechterhalten.

SuperCluster-Spezifikationen

Die Supermicro SuperCluster sind skalierbare Lösungen für das Training umfangreicher Basismodelle und die Erstellung von LLM-Inferenzinfrastrukturen im Cloud-Maßstab. Mit einer hoch skalierbaren Netzwerkarchitektur können diese Systeme von 32 Knoten auf Tausende erweitert werden und gewährleisten so eine nahtlose Skalierbarkeit. Die Integration fortschrittlicher Flüssigkeitskühlung und umfassender Testprozesse garantiert betriebliche Effizienz und Effektivität.

Supermicro beschreibt zwei Hauptkonfigurationen: den SuperCluster mit flüssigkeitsgekühltem 4U-System, das bis zu 512 GPUs auf kompakter Stellfläche unterstützen kann, und den SuperCluster mit luftgekühltem 1U-NVIDIA-MGX-System, das für Inferenzaufgaben mit hohem Volumen und geringer Latenz konzipiert ist . Beide Konfigurationen zeichnen sich durch ihre hohe Netzwerkleistung aus, die für das LLM-Training und die Inferenz unerlässlich ist.

Hier ist ein kurzer Überblick über ihre Spezifikationen:

SuperCluster mit flüssigkeitsgekühltem 4U-System in 5 Racks oder luftgekühltem 8U-System in 9 Racks

- 256 NVIDIA H100/H200 Tensor Core GPUs in einer skalierbaren Einheit

- Flüssigkeitskühlung ermöglicht 512 GPUs, 64 Knoten, im gleichen Footprint wie die luftgekühlte Lösung mit 256 GPUs, 32 Knoten

- 20 TB HBM3 mit NVIDIA H100 oder 36 TB HBM3e mit NVIDIA H200 in einer skalierbaren Einheit

- Das 1:1-Netzwerk liefert bis zu 400 Gbit/s an jede GPU, um GPUDirect RDMA und Storage für das Training großer Sprachmodelle mit bis zu Billionen Parametern zu ermöglichen

- 400G InfiniBand- oder 400GbE-Ethernet-Switch-Fabrics mit hoch skalierbarer Spine-Leaf-Netzwerktopologie, einschließlich NVIDIA Quantum-2 InfiniBand und NVIDIA Spectrum-X Ethernet-Plattform.

- Anpassbare KI-Datenpipeline-Speicherstruktur mit branchenführenden Optionen für parallele Dateisysteme

- NVIDIA AI Enterprise 5.0-Software, die Unterstützung für neue NVIDIA NIM-Inferenz-Mikrodienste bietet, die die Bereitstellung von KI-Modellen in großem Maßstab beschleunigen

SuperCluster mit 1U luftgekühltem NVIDIA MGX-System in 9 Racks

- 256 GH200 Grace Hopper Superchips in einer skalierbaren Einheit

- Bis zu 144 GB HBM3e + 480 GB LPDDR5X-Unified-Speicher, geeignet für Cloud-Scale, hohe Volumina, geringe Latenz und hohe Batchgrößeninferenz, in der Lage, ein Parametermodell mit mehr als 70 B in einem Knoten unterzubringen.

- 400G-InfiniBand- oder 400G-Ethernet-Switch-Fabrics mit hoch skalierbarer Spine-Leaf-Netzwerktopologie

- Bis zu 8 integrierte E1.S NVMe-Speichergeräte pro Knoten

- Anpassbare KI-Datenpipeline-Speicherstruktur mit NVIDIA BlueField-3-DPUs und branchenführenden Optionen für parallele Dateisysteme, um Speicherzugriff mit hohem Durchsatz und geringer Latenz auf jede GPU zu ermöglichen

- NVIDIA AI Enterprise 5.0-Software

Supermicro erweitert KI-Portfolio um neue Systeme und Racks mit NVIDIA Blackwell-Architektur

Supermicro kündigt außerdem die Erweiterung seines KI-Systemangebots an, einschließlich der neuesten Rechenzentrumsinnovationen von NVIDIA, die auf groß angelegte generative KI abzielen. Zu diesen neuen Technologien gehören der NVIDIA GB200 Grace Blackwell Superchip und die B200- und B100-Tensor-Core-GPUs.

Um diesen Fortschritten Rechnung zu tragen, rüstet Supermicro seine bestehenden Lösungen nahtlos auf NVIDIA HGX H100/H200 8-GPU-Systeme zur Integration der NVIDIA HGX B100 8-GPU und B200. Darüber hinaus wird die NVIDIA HGX-Reihe durch die neuen Modelle mit NVIDIA GB200 gestärkt, darunter eine umfassende Rack-Level-Lösung mit 72 NVIDIA Blackwell-GPUs. Zusätzlich zu diesen Fortschritten stellt Supermicro ein neues 4U NVIDIA HGX B200 8-GPU-Flüssigkeitskühlungssystem vor, das die Direct-to-Chip-Flüssigkeitskühlungstechnologie nutzt, um den erhöhten thermischen Anforderungen der neuesten GPUs gerecht zu werden und die volle Leistungsfähigkeit von NVIDIAs freizuschalten Blackwell-Technologie.

Die GPU-optimierten Systeme des neuen Supermicro werden in Kürze verfügbar sein, vollständig kompatibel mit den NVIDIA Blackwell B200 und B100 Tensor Core GPUs und zertifiziert für die neueste NVIDIA AI Enterprise-Software. Die Supermicro-Reihe umfasst verschiedene Konfigurationen, von NVIDIA HGX B100- und B200-8-GPU-Systemen bis hin zu SuperBlades, die bis zu 20 B100-GPUs aufnehmen können, was Vielseitigkeit und hohe Leistung für eine Vielzahl von KI-Anwendungen gewährleistet. Zu diesen Systemen gehören die ersten auf dem Markt erhältlichen NVIDIA HGX B200- und B100-8-GPU-Modelle mit fortschrittlicher NVIDIA NVLink-Verbindungstechnologie. Supermicro gibt an, dass sie bereit sind, Trainingsergebnisse für LLMs (dreimal schneller) zu liefern und skalierbares Clustering für anspruchsvolle KI-Workloads zu unterstützen, was einen bedeutenden Sprung nach vorne in der KI-Recheneffizienz und -Leistung darstellt.

Supermicro-Flüssigkeitskühlungstechnologie

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed