Auf der VMware Explore 2023-Veranstaltung stellte VMware neue private KI-Angebote vor, die darauf abzielen, die Einführung generativer KI in Unternehmen zu fördern und das Potenzial vertrauenswürdiger Daten zu nutzen. VMware Private AI zeichnet sich durch seinen architektonischen Ansatz aus und vereint die Vorteile von KI mit den praktischen Datenschutz- und Compliance-Anforderungen von Unternehmen.

Auf der VMware Explore 2023-Veranstaltung stellte VMware neue private KI-Angebote vor, die darauf abzielen, die Einführung generativer KI in Unternehmen zu fördern und das Potenzial vertrauenswürdiger Daten zu nutzen. VMware Private AI zeichnet sich durch seinen architektonischen Ansatz aus und vereint die Vorteile von KI mit den praktischen Datenschutz- und Compliance-Anforderungen von Unternehmen.

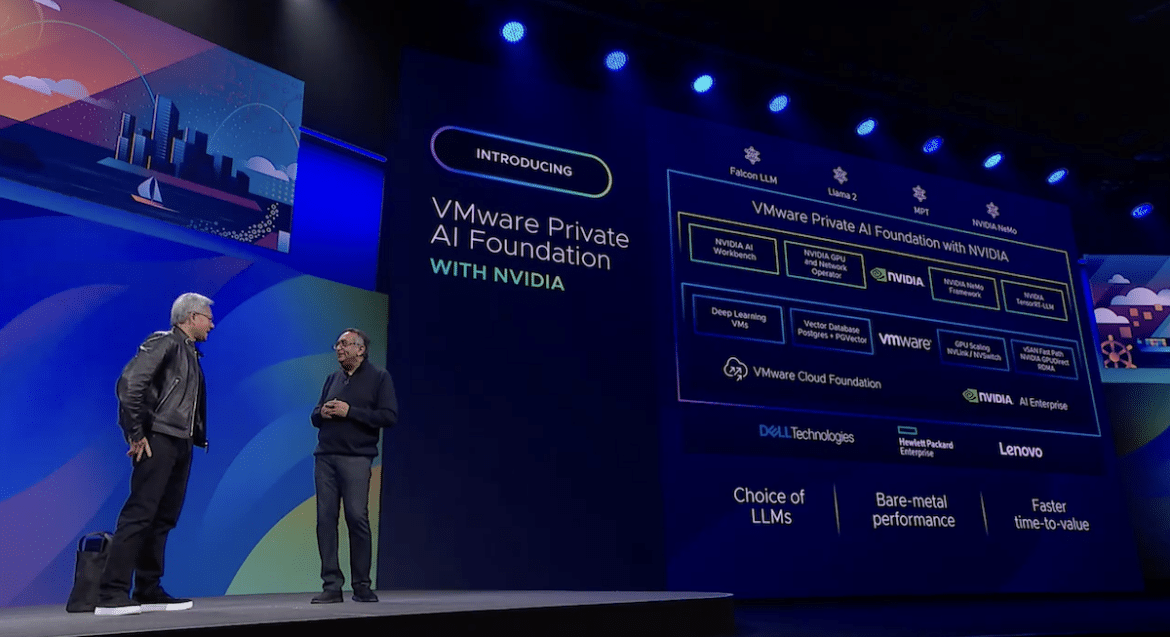

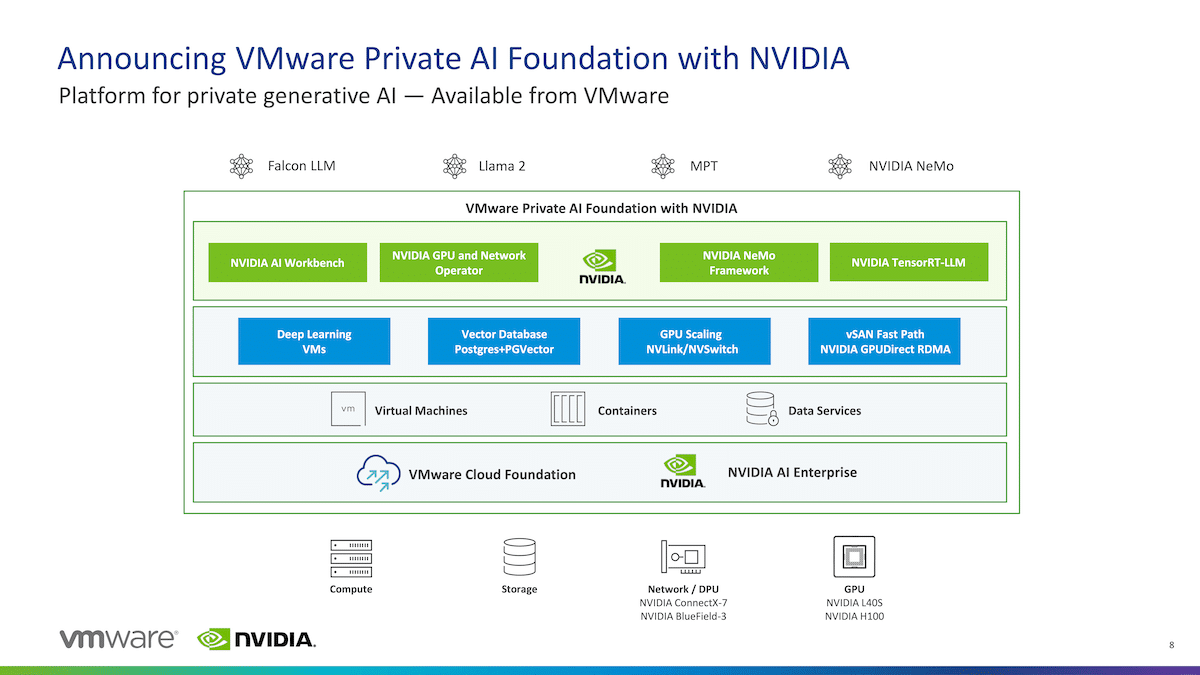

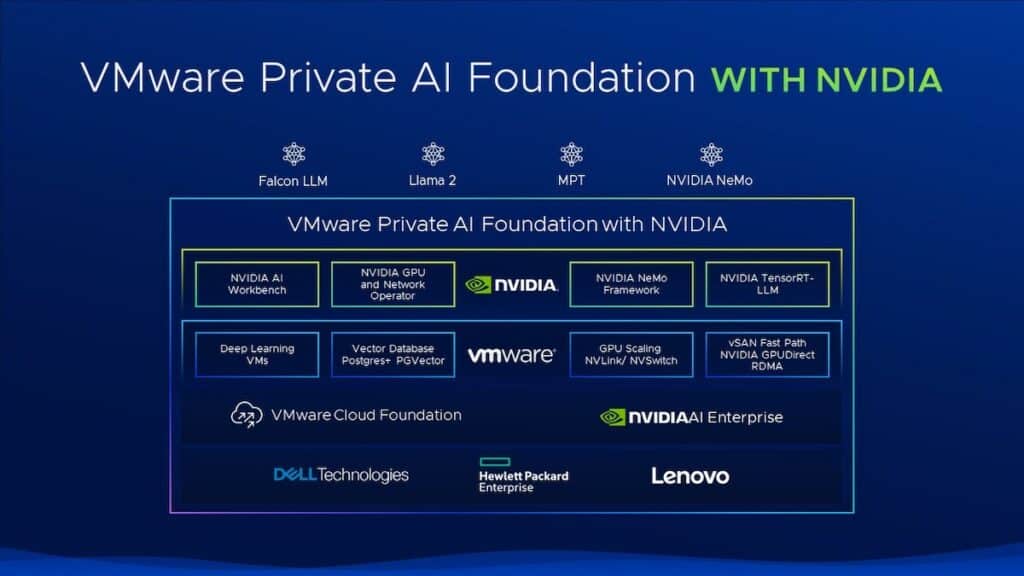

Die VMware Private AI Foundation mit NVIDIA ermöglicht es Unternehmen, Modelle anzupassen und generative KI-Anwendungen auszuführen, einschließlich intelligenter Chatbots, Assistenten, Suche und Zusammenfassung. Die Plattform wird eine vollständig integrierte Lösung sein generative KI-Software und beschleunigtes Computing von NVIDIA, gebaut auf VMware Cloud Foundation und für KI optimiert.

Aufbauend auf ihrer strategischen Partnerschaft bietet das Angebot der VMware Private AI Foundation mit NVIDIA Unternehmen die Möglichkeit, auf der Cloud-Infrastruktur von VMware die Tools bereitzustellen, um dem wachsenden Interesse im Zeitalter der generativen KI gerecht zu werden. Diese Erweiterung integriert die private KI-Architektur von VMware mit der NVIDIA AI Enterprise-Software und beschleunigtem Computing und bietet so eine schlüsselfertige Lösung für die Bereitstellung generativer KI-Anwendungen in Rechenzentren, öffentlichen Clouds und am Edge.

Um Geschäftsvorteile schneller zu erzielen, versuchen Unternehmen, die Entwicklung, das Testen und die Bereitstellung generativer KI-Anwendungen zu rationalisieren. Die VMware Private AI Foundation mit NVIDIA wird es Unternehmen ermöglichen, diese Fähigkeit zu nutzen, große Sprachmodelle anzupassen, sicherere und privatere Modelle für ihre interne Nutzung zu erstellen und ihren Benutzern generative KI als Service anzubieten, um Inferenz-Workloads in großem Maßstab sicher auszuführen.

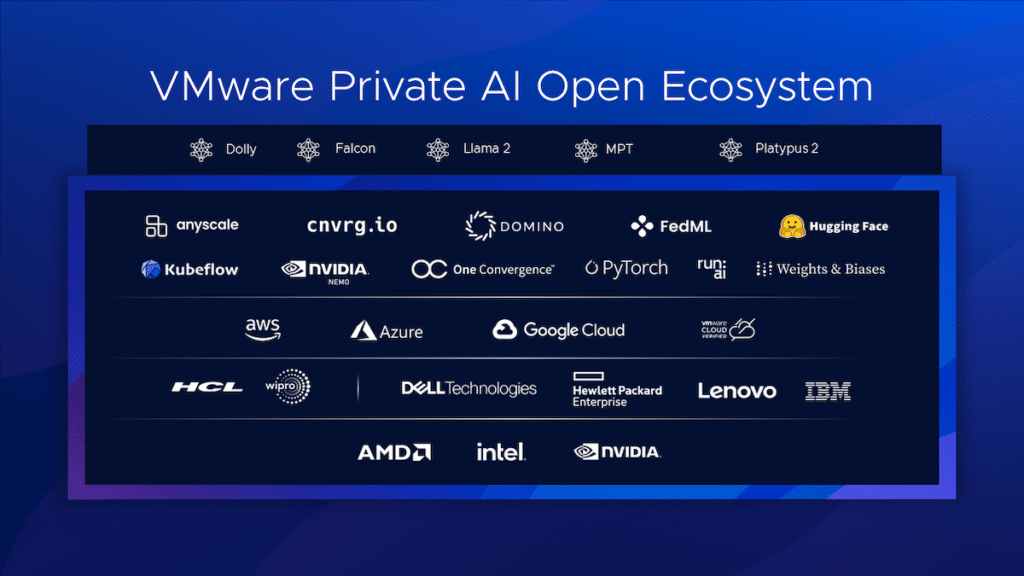

Es wird erwartet, dass die Plattform integrierte KI-Tools umfasst, um Unternehmen in die Lage zu versetzen, bewährte, auf ihren privaten Daten trainierte Modelle kosteneffizient auszuführen. Kunden erzielen die gewünschten KI-Ergebnisse mit der VMware Private AI Reference Architecture für Open Source, die erstklassige Open-Source-Softwaretechnologien nutzt und so aktuelle und zukünftige Anforderungen erfüllt.

Die Plattform soll auf VMware Cloud Foundation und NVIDIA AI Enterprise-Software basieren und zahlreiche Vorteile bieten. Aus Sicht des Datenschutzes können Kunden KI-Dienste direkt am Speicherort der Daten mit einer Architektur ausführen, die den Datenschutz durch sicheren Zugriff gewährleistet.

Unternehmen haben eine große Auswahl an Standorten für die Erstellung und den Betrieb ihrer Modelle, von NVIDIA NeMo bis Llama 2. Dazu gehören OEM-Hardwarekonfigurationen und in Zukunft auch Angebote von öffentlichen Clouds und Dienstanbietern.

Die erwartete Leistung sollte der Bare-Metal-Leistung entsprechen oder diese übertreffen, wenn die Plattform auf einer beschleunigten NVIDIA-Infrastruktur läuft. Durch die GPU-Skalierungsoptimierungen in virtualisierten Umgebungen können KI-Workloads auf bis zu 16 vGOUs/GPUs in einer einzelnen VM und mehreren Knoten skaliert werden, um die Feinabstimmung und Bereitstellung generativer KI-Modelle zu beschleunigen.

Die Maximierung der Nutzung aller Rechenressourcen über GPUs, DPUs und CPUs hinweg bedeutet, dass die Gesamtkosten voraussichtlich niedriger sein werden, während gleichzeitig eine gepoolte Ressourcenumgebung geschaffen wird, die von allen Teams gemeinsam genutzt wird. VMware vSAN Express Storage Architecture (ESA) liefert leistungsoptimierten NVMe-Speicher und unterstützt GPUDirect-Speicher über RDMA, wodurch eine direkte I/O-Übertragung vom Speicher zu GPUs ohne Einbeziehung der CPU ermöglicht wird.

Die tiefe Integration zwischen vSphere und NVIDIA NVSwitch ermöglicht die Ausführung von Multi-GPU-Modellen ohne Engpässe zwischen GPUs und sorgt so für eine beschleunigte Vernetzung.

All diese Vorteile werden wenig bedeuten, wenn die Bereitstellung und die Realisierung der Time-to-Value zu lange dauern. Mit vSphere Deep Learning VM-Images und Image-Repository bieten Rapid-Prototyping-Funktionen ein stabiles, schlüsselfertiges Lösungs-Image, das vorinstallierte Frameworks und leistungsoptimierte Bibliotheken umfasst.

NVIDIA NeMo, ein durchgängiges, cloudnatives Framework und das Betriebssystem für die in NVIDIA AI Enterprise enthaltene NVIDIA AI-Plattform, ist eine Plattformfunktion. NeMo ermöglicht es Unternehmen, generative KI-Modelle praktisch überall zu erstellen, anzupassen und bereitzustellen. Dabei werden Anpassungs-Frameworks, Leitplanken-Toolkits, Datenkurationstools und vorab trainierte Modelle kombiniert, um Unternehmen einen einfachen, kostengünstigen und effizienten Weg zur Einführung generativer KI zu bieten.

NeMo setzt generative KI in der Produktion ein und nutzt TensorRT für große Sprachmodelle (TRT-LLM), um die Inferenzleistung auf den neuesten LLMs auf NVIDIA-GPUs zu beschleunigen und zu optimieren. Mit NeMo ermöglicht die VMware Private AI Foundation mit NVIDIA Unternehmen, ihre Daten einzubinden, um benutzerdefinierte generative KI-Modelle auf der Hybrid-Cloud-Infrastruktur von VMware zu erstellen und auszuführen.

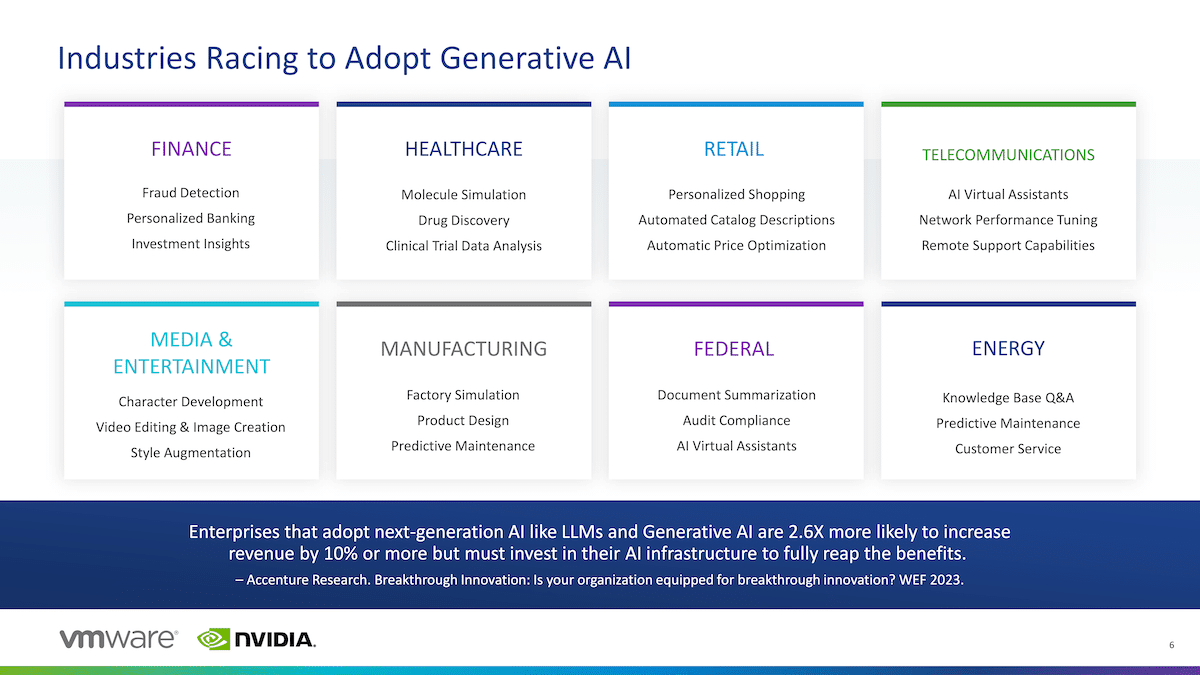

VMware Private AI Foundation erweitert KI-Funktionen und -Modelle dorthin, wo die Unternehmensdaten generiert, verarbeitet und genutzt werden, unabhängig davon, ob sie sich in einer öffentlichen Cloud, einem Unternehmensrechenzentrum oder am Edge befinden. Durch die Einführung dieser neuen Angebote möchte VMware seinen Kunden ermöglichen, Flexibilität und Kontrolle zu vereinen und so eine neue Generation von KI-gestützten Anwendungen voranzutreiben. Die Anwendungen haben das Potenzial, die Produktivität der Mitarbeiter erheblich zu steigern, einen Wandel in wichtigen Geschäftsfunktionen auszulösen und erhebliche wirtschaftliche Auswirkungen zu erzielen – ein McKinsey-Bericht prognostiziert, dass generative KI jährlich bis zu 4.4 Billionen US-Dollar zur Weltwirtschaft beitragen wird.

Entscheidend für den Erfolg dieser Entwicklung ist die Einrichtung einer Multi-Cloud-Umgebung, da sie den Weg für eine private und dennoch weit verteilte Datennutzung ebnet. Die Multi-Cloud-Strategie von VMware ermöglicht Unternehmen eine größere Flexibilität beim Erstellen, Anpassen und Bereitstellen von KI-Modellen unter Verwendung privater Daten und gewährleistet gleichzeitig Sicherheit und Ausfallsicherheit in verschiedenen Umgebungen.

Raghu Raghuram, CEO von VMware, betont, dass die Realisierbarkeit generativer KI von der Wahrung des Datenschutzes und der Minimierung von IP-Risiken abhängt. VMware Private AI geht auf diese Bedenken ein und ermöglicht es Unternehmen, ihre vertrauenswürdigen Daten für die effiziente Erstellung und Ausführung von KI-Modellen in einer Multi-Cloud-Umgebung zu nutzen.

NVIDIA AI Enterprise-Plattform

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed