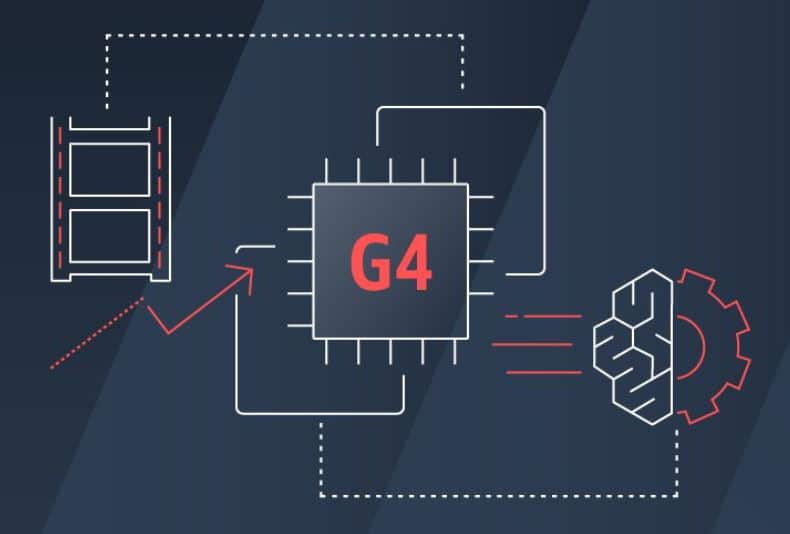

Amazon Web Services, Inc. (AWS) anunció hoy la disponibilidad general de una nueva instancia de Amazon Elastic Compute Cloud (Amazon EC2) impulsada por GPU, la instancia G4. Esta nueva instancia está diseñada para acelerar la inferencia de aprendizaje automático (ML) al tiempo que proporciona la inferencia de ML más rentable de la industria para las aplicaciones. La nueva instancia también es excelente para cargas de trabajo con uso intensivo de gráficos de manera rentable y sería ideal para crear y ejecutar aplicaciones con uso intensivo de gráficos, como estaciones de trabajo de gráficos remotas, transcodificación de video, diseño fotorrealista y transmisión de juegos en la nube. .

AWS afirma que ML involucra dos procesos que requieren computación: entrenamiento e inferencia. El entrenamiento implica el uso de datos etiquetados para crear un modelo que sea capaz de hacer predicciones, una tarea de computación intensiva que requiere procesadores potentes y redes de alta velocidad. La inferencia es el proceso de usar un modelo de aprendizaje automático entrenado para hacer predicciones, lo que generalmente requiere procesar una gran cantidad de pequeños trabajos informáticos simultáneamente. Este trabajo es ideal para las potentes GPU de NVIDIA. AWS no es ajeno a las instancias para ML, y lanzó por primera vez la instancia P3 hace dos años. Si bien este fue un gran paso, la inferencia absorbe la mayoría de los costos operativos para las cargas de trabajo de ML.

Para abordar esto, AWS lanzó las nuevas instancias G4 que aprovechan las GPU NVIDIA T4 de última generación, los procesadores Intel Xeon Scalable (Cascade Lake) personalizados de segunda generación, hasta 2 Gbps de rendimiento de red y hasta 100 TB de almacenamiento NVMe local, para entregue las instancias de GPU más rentables para la inferencia de aprendizaje automático. Las nuevas instancias G1.8 pueden ofrecer hasta 4 TFLOP de rendimiento de precisión mixta, excelente para la inferencia. Los G65 también se pueden usar de manera rentable para trabajos de capacitación de aprendizaje automático de nivel de entrada y pequeña escala que son menos sensibles al tiempo de capacitación. Para cargas de trabajo con uso intensivo de gráficos, las nuevas instancias ofrecen un aumento de hasta 4 veces en el rendimiento de gráficos y una capacidad de transcodificación de video de hasta 1.8x en comparación con las instancias G2 de la generación anterior.

Disponibilidad

Las instancias G4 están disponibles para su compra bajo demanda, instancias reservadas o instancias de spot.

Suscríbase al boletín de StorageReview