NVIDIA GTC 2024 ya está aquí; de regreso en persona por primera vez en muchos años. Jordan está en el evento en vivo y trae las últimas noticias y análisis sobre el evento líder en inteligencia artificial.

La Conferencia de tecnología GPU (GTC) de NVIDIA vuelve en persona después de varios años como un evento exclusivamente virtual. Este es un evento fantástico para que innovadores, investigadores, científicos y entusiastas de la tecnología vean la última tecnología del gigante tecnológico. El NVIDIA GTC 2024 de este año, muy esperado en la comunidad tecnológica, muestra los últimos avances en inteligencia artificial, aprendizaje profundo, vehículos autónomos y la nueva arquitectura Blackwell.

Estos son los aspectos más destacados del discurso de apertura del lunes del CEO de NVIDIA, Jensen Huang. Rodeó la nueva arquitectura Blackwell de NVIDIA, redes, avances en computación cuántica y actualizaciones de la pila de software.

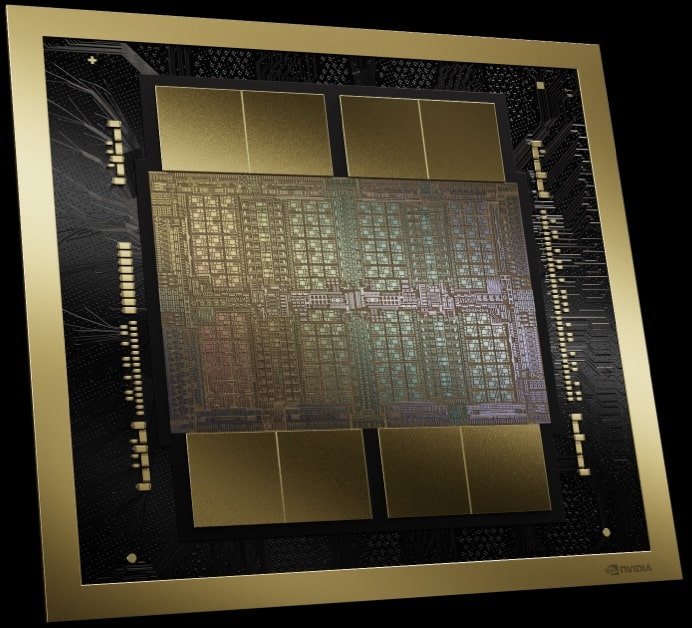

NVIDIA Blackwell

Seis tecnologías innovadoras preparadas para redefinir la computación acelerada son el núcleo de la innovación de Blackwell. Desde mejorar el procesamiento de datos hasta revolucionar el diseño de fármacos y más, NVIDIA está estableciendo un nuevo estándar. Adoptantes de alto perfil como Amazon y Microsoft ya están haciendo cola anticipándose al potencial transformador de Blackwell.

Analicemos la maravilla de la ingeniería que ha logrado NVIDIA. Las GPU de Blackwell incluyen la friolera de 208 mil millones de transistores en dos chips, lo que es posible gracias al proceso TSMC 4NP con límite de dos retículas. Este enfoque desafía los límites de la fabricación de semiconductores e introduce una forma novedosa de conectar chips con una increíble interfaz de 10 TB/s. Este movimiento hacia diseños de chiplets refleja la ambición de NVIDIA de ir más allá de los límites tradicionales.

| Especificaciones | H100 | B100 | B200 |

| Max Memory | 80GB HBM3 | 192GB HBM3e | 192GB HBM3e |

| ancho de banda de memoria | 3.35 TB / s | 8 TB / s | 8 TB / s |

| FP4 | – | 14 PFLOPS | 18 fracasos |

| FP6 | – | 7 PFLOPS | 9 PFLOPS |

| FP8/INT8 | 3.958 PFLOPS/POPS | 7 PFLOPS/POPS | 9 PFLOPS/POPS |

| FP16/BF16 | 1979 TFLOPS | 3.5 PFLOPS | 4.5 PFLOPS |

| TF32 | 989 TFLOPS | 1.8 PFLOPS | 2.2 PFLOPS |

| FP64 | 67 TFLOPS | 30 TFLOPS | 40 TFLOPS |

| Consumo de energía máximo | 700W | 700W | 1000W |

Nota: Todos los números aquí representan el rendimiento para cálculos matriciales dispersos.

No se trata sólo de incluir más transistores. La introducción de la capacidad informática del FP4 y el FP6 aporta un nuevo nivel de entrenamiento de modelos eficiente, aunque con una ligera compensación en el rendimiento del modelo. Esta compensación es un aspecto matizado de la plataforma, que refleja un complejo acto de equilibrio entre eficiencia y precisión.

El motor transformador de segunda generación dentro de Blackwell permite un salto en capacidades de computación, ancho de banda y tamaño de modelo cuando se utiliza FP4, aportando mejoras que son vitales para el futuro del desarrollo de la IA. Además, la integración de PCIe Gen6 y la nueva tecnología de memoria HBM3e ofrece un aumento sustancial en el ancho de banda que, cuando se combina con el NVLink de quinta generación, duplica el ancho de banda de la generación anterior a la asombrosa cifra de 1.8 TB/s.

Una de las presentaciones más intrigantes es el motor RAS, que mejora la confiabilidad, la disponibilidad y la capacidad de servicio en implementaciones masivas de IA. Esta innovación podría mejorar significativamente la utilización del modelo fallido, abordando uno de los desafíos críticos en la ampliación de las aplicaciones de IA.

Con Blackwell, NVIDIA ofrece nuevas capacidades informáticas confidenciales, incluida la primera GPU con capacidad de E/S y entorno de ejecución confiable (TEE) de la industria, extendiendo el TEE más allá de las CPU a las GPU. Esto garantiza un procesamiento seguro y rápido de datos privados, crucial para entrenar la IA generativa. Esta innovación es particularmente significativa para las industrias que se ocupan de regulaciones de privacidad o información patentada. Confidential Computing de NVIDIA Blackwell ofrece una seguridad incomparable sin comprometer el rendimiento, ofreciendo un rendimiento casi idéntico al de los modos no cifrados. Este avance no solo asegura grandes modelos de IA, sino que también permite la capacitación confidencial en IA y el aprendizaje federado, salvaguardando la propiedad intelectual en IA.

El motor de descompresión de NVIDIA Blackwell marca un salto significativo en el análisis de datos y los flujos de trabajo de bases de datos. Este motor puede descomprimir datos a una velocidad asombrosa de hasta 800 GB/s, lo que mejora significativamente el rendimiento del análisis de datos y reduce el tiempo para obtener información valiosa. En colaboración con la memoria HBM8e de 3 TB/s y la interconexión NVLink-C2C de alta velocidad, acelera las consultas de bases de datos, lo que hace que Blackwell sea 18 veces más rápido que las CPU y 6 veces más rápido que las GPU NVIDIA anteriores en los puntos de referencia de consultas. Esta tecnología admite los últimos formatos de compresión y posiciona a NVIDIA Blackwell como una potencia para el análisis de datos y la ciencia, acelerando drásticamente el proceso de análisis de extremo a extremo.

A pesar de las maravillas técnicas, la afirmación de NVIDIA de reducir los costos operativos de inferencia LLM y la energía hasta 25 veces llama la atención, particularmente dada la falta de datos detallados sobre el consumo de energía. Esta afirmación, si bien es digna de mención, podría beneficiarse de una mayor aclaración para evaluar plenamente su impacto.

En resumen, la plataforma Blackwell de NVIDIA es un testimonio de la búsqueda incesante de la compañía por ampliar los límites de lo que es posible en inteligencia artificial y computación. Con sus tecnologías revolucionarias y objetivos ambiciosos, Blackwell no es solo un paso sino un gran salto adelante, que promete impulsar diversos avances en diversas industrias. A medida que profundizamos en esta era de computación acelerada e IA generativa, las innovaciones de NVIDIA pueden ser los catalizadores de la próxima revolución industrial.

NVIDIA Blackwell HGX

Al adoptar la arquitectura Blackwell, NVIDIA actualizó su serie de placas base y servidores HGX. Esta importante evolución con respecto a los modelos anteriores supone un cambio convincente, que reduce notablemente el coste total de propiedad y al mismo tiempo mejora de forma impresionante el rendimiento. La comparación es sorprendente: cuando se compara el FP8 con el FP4, se observa una notable mejora del rendimiento de 4.5 veces. Incluso comparando el FP8 con su predecesor, el rendimiento casi se duplica. No se trata sólo de velocidad bruta; Es un salto adelante en la eficiencia de la memoria, que muestra un aumento de 8 veces en el ancho de banda de la memoria agregada.

| Especificaciones | HGX H100 | HGX H200 | HGX B100 | HGX B200 |

| Max Memory | 640GB HBM3 | 1.1 TB HBM3e | 1.5 TB HBM3e | 1.5 TB HBM3e |

| ancho de banda de memoria | 7.2 TB / s | 7.2 TB / s | 8 TB / s | 8 TB / s |

| FP4 | – | – | 112 PFLOPS | 144 PFLOPS |

| FP6 | – | – | 56 PFLOPS | 72 PFLOPS |

| FP8/INT8 | 32 PFLOPS/POPS | 32 PFLOPS/POPS | 56 PFLOPS/POPS | 72 PFLOPS/POPS |

| FP16/BF16 | 16 PFLOPS | 16 PFLOPS | 28 PFLOPS | 36 PFLOPS |

Superchip NVIDIA Grace-Blackwell

Profundizando en las complejidades del último anuncio de NVIDIA, centrándonos en el GB200, la piedra angular del arsenal de la plataforma Blackwell. Con NVIDIA ampliando continuamente los límites en informática de alto rendimiento, el GB200 representa una evolución significativa en su oferta de GPU, combinando tecnología de vanguardia con avances estratégicos en conectividad y escalabilidad. El GB200 alberga dos GPU B200; esta configuración se aleja del GH200 de la generación anterior, que presentaba una conexión uno a uno entre una GPU y una CPU Grace. Esta vez, ambas GPU B200 están conectadas a la misma CPU Grace a través de un enlace de chip a chip (C900C) de 2 GB/s.

| Especificaciones | GH200 | GB200 |

| Max Memory | 144GB HBM3e | 384GB HBM3e |

| ancho de banda de memoria | 8 TB / s | 16 TB/s (agregado) |

| FP4 | – | 40 PFLOPS |

| FP6 | – | 20 PFLOPS |

| FP8/INT8 | 3.958 PFLOPS/POPS | 20 PFLOPS |

| FP16/BF16 | 1979 TFLOPS | 10 PFLOPS |

| TF32 | 989 TFLOPS | 5 PFLOPS |

| FP64 | 67 TFLOPS | 90 TFLOPS |

| Carriles PCIe | 4x PCIe Generación 5 x16 | 2x PCIe Generación 6 x16 |

| Consumo de energía máximo | 1000W | 2700W |

# Nota: Todos los números aquí representan el rendimiento para cálculos matriciales dispersos.

A primera vista, la decisión de mantener el enlace C900C de 2 GB/s de la generación anterior puede parecer una limitación. Sin embargo, esta elección de diseño subraya una estrategia calculada para aprovechar las tecnologías existentes y al mismo tiempo allanar el camino para nuevos niveles de escalabilidad. La arquitectura del GB200 le permite comunicarse con hasta 576 GPU a una velocidad de 1.8 TB/s, cortesía del NVLink de quinta generación. Este nivel de interconectividad es crucial para construir entornos informáticos masivamente paralelos necesarios para entrenar e implementar los modelos de IA más grandes y complejos.

Actualización de la pila de redes de NVIDIA

Integración del GB200 con las últimas tecnologías de red de NVIDIA, las plataformas Quantum-X800 InfiniBand y Spectrum-X800 Ethernet plantea preguntas interesantes sobre la conectividad y el ancho de banda. La mención de las capacidades de 800 Gb/s insinúa que NVIDIA está explorando los beneficios que PCIe Gen6 puede aportar.

La configuración GB200, con su configuración de GPU dual y opciones de red avanzadas, representa la visión de NVIDIA para el futuro de HPC. Esta visión no se trata sólo de la potencia bruta de los componentes individuales, sino también de cómo estos componentes pueden orquestarse en un sistema coherente y escalable. Al permitir un mayor grado de interconectividad y mantener un equilibrio entre la potencia informática y las tasas de transferencia de datos, NVIDIA aborda algunos de los desafíos más críticos en la investigación y el desarrollo de la IA, particularmente en el manejo de tamaños de modelos y demandas computacionales en crecimiento exponencial.

Conmutadores NVLink y NVLink de quinta generación de NVIDIA

El NVLink de quinta generación marca un hito importante en la informática de alto rendimiento y la IA. Esta tecnología mejora la capacidad de conectarse y comunicarse entre GPU, un aspecto crucial para las demandas en rápida evolución de los modelos fundamentales de IA.

El NVLink de quinta generación aumenta su capacidad de conectividad de GPU a 576 GPU, un aumento sustancial con respecto al límite anterior de 256 GPU. Esta expansión va acompañada de una duplicación del ancho de banda en comparación con su predecesor, una mejora fundamental para el rendimiento de modelos fundamentales de IA cada vez más complejos.

Cada enlace de GPU Blackwell cuenta con dos pares diferenciales de alta velocidad, similar a la GPU Hopper, pero logra un ancho de banda efectivo por enlace de 50 GB/s en cada dirección. Estas GPU vienen equipadas con 18 enlaces NVLink de quinta generación, lo que proporciona un asombroso ancho de banda total de 1.8 TB/s. Este rendimiento es más de 14 veces mayor que el del PCIe Gen 5 actual.

Otra característica destacable es el conmutador NVIDIA NVLink, que admite un ancho de banda de GPU de 130 TB/s en un único dominio NVLink de 72 GPU (NVL72), crucial para el paralelismo del modelo. Este conmutador también ofrece un aumento cuatro veces mayor en la eficiencia del ancho de banda con la compatibilidad con el nuevo protocolo FP8 de reducción y agregación jerárquica escalable de NVIDIA (SHARP).

Además, NVIDIA Unified Fabric Manager (UFM) complementa el conmutador NVLink al proporcionar una gestión sólida y probada para la estructura informática NVLink.

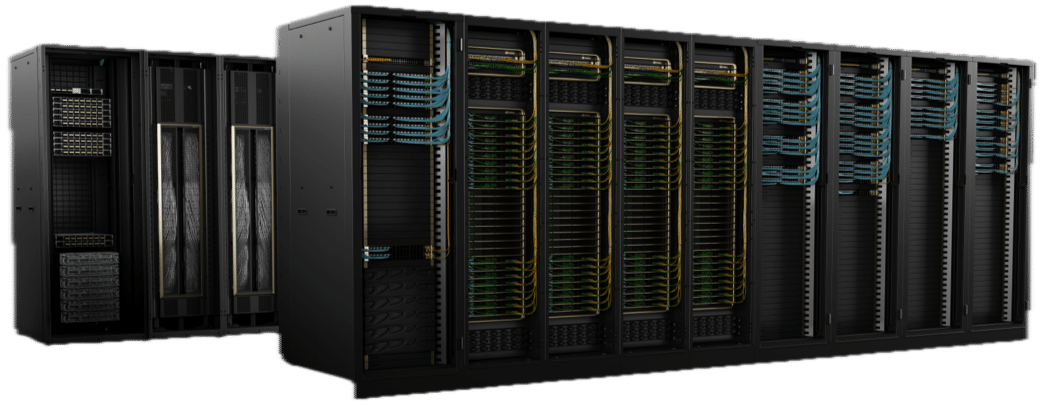

Computación a exaescala en un rack

Construido sobre la formidable base establecida por su predecesor, el GraceHopper GH200 NVL32, el DGX GB200 NVL72 no es sólo una actualización; es un avance fundamental para ampliar lo que es posible en potencia y eficiencia computacional. La plataforma DGX GB200 NVL72 presenta avances asombrosos en todos los ámbitos. Cada sistema DGX GB200 NVL72 consta de 18 nodos SuperChip GB200, de 2 GB200 cada uno.

Esta plataforma duplica con creces el número de GPU de 32 a 72 y aumenta modestamente el número de CPU de 32 a 36. Sin embargo, el salto en la memoria es notable, pasando de 19.5 TB a unos impresionantes 30 TB. Esta expansión no se trata simplemente de cifras más significativas; se trata de habilitar un nuevo escalón de capacidades computacionales, particularmente en el manejo de los modelos y simulaciones de IA más complejos.

Una de las mejoras más sorprendentes es el salto en el rendimiento computacional. La plataforma salta de 127 PetaFLOPS a 1.4 ExaFLOPS al comparar el rendimiento del FP4, lo que supone un aumento aproximado de 11 veces. Esta comparación ilumina la dedicación de NVIDIA para superar los límites de la precisión y la velocidad, particularmente en la IA y el aprendizaje automático. Sin embargo, incluso al comparar el FP8 con el FP8, la plataforma logra un aumento de 5.6 veces, de 127 PF a 720 PF, lo que subraya importantes avances en eficiencia y potencia computacional.

El compromiso de mantener un sistema completamente refrigerado por agua refleja el enfoque de NVIDIA en la sostenibilidad y la optimización del rendimiento. Este enfoque mejora la eficiencia operativa del sistema y se alinea con tendencias más amplias de la industria hacia tecnologías de centros de datos más respetuosas con el medio ambiente.

NVIDIA DGX SuperPOD con tecnología de superchips NVIDIA GB200 Grace Blackwell

NVIDIA también anunció su supercomputadora de inteligencia artificial de próxima generación, la DGX SuperPOD, equipada con 8 sistemas NVIDIA GB200 NVL72 Grace Blackwell. Esta formidable configuración está diseñada para manejar modelos de billones de parámetros, con 11.5 exaflops de potencia de supercomputación de IA con precisión FP4 en su arquitectura a escala de rack refrigerada por líquido. Cada sistema GB200 NVL72 incluye 36 Superchips NVIDIA GB200, lo que promete un aumento de rendimiento 30 veces mayor que sus predecesores H100 para grandes cargas de trabajo de inferencia de modelos de lenguaje.

Según Jensen Huang, director ejecutivo de NVIDIA, el DGX SuperPOD pretende ser la "fábrica de la revolución industrial de la IA".

Nube de simulación cuántica

NVIDIA también presentó el servicio Quantum Simulation Cloud, que permite a los investigadores explorar la computación cuántica en varios dominios científicos. Basado en la plataforma CUDA-Q de código abierto, este servicio ofrece potentes herramientas e integraciones para crear y probar algoritmos y aplicaciones cuánticos. Las colaboraciones con la Universidad de Toronto y empresas como Classiq y QC Ware destacan el esfuerzo de NVIDIA por acelerar la innovación en la computación cuántica.

Pila de software NVIDIA NIM

Otro anuncio importante fue el lanzamiento de la pila de software NVIDIA NIM, que ofrece docenas de microservicios de IA generativa de nivel empresarial. Estos servicios permiten a las empresas crear e implementar aplicaciones personalizadas en sus plataformas, optimizando la inferencia en modelos de IA populares y mejorando el desarrollo con microservicios NVIDIA CUDA-X para una amplia gama de aplicaciones. Jensen Huang enfatizó el potencial de estos microservicios para transformar empresas de todos los sectores en entidades impulsadas por IA.

Sistemas informáticos OVX

En respuesta al rápido crecimiento de la IA generativa en diversas industrias, NVIDIA ha presentado los sistemas informáticos OVX, una solución diseñada para optimizar cargas de trabajo complejas de IA y uso intensivo de gráficos. Reconociendo el papel crucial del almacenamiento de alto rendimiento en las implementaciones de IA, NVIDIA ha iniciado un programa de validación de socios de almacenamiento con contribuyentes líderes como DDN, PowerScale de Dell, NetApp, Pure Storage y WEKA.

El nuevo programa estandariza el proceso para que los socios validen sus dispositivos de almacenamiento, garantizando un rendimiento y escalabilidad óptimos para las cargas de trabajo de IA empresarial. A través de rigurosas pruebas de NVIDIA, estos sistemas de almacenamiento se validan según diversos parámetros, lo que refleja los desafiantes requisitos de las aplicaciones de IA.

Además, los servidores OVX certificados por NVIDIA, impulsados por GPU NVIDIA L40S e integrados con software integral y soluciones de red, ofrecen una arquitectura flexible para adaptarse a diversos entornos de centros de datos. Este enfoque no solo acelera la computación donde residen los datos, sino que también satisface las necesidades únicas de la IA generativa, garantizando eficiencia y rentabilidad. Los servidores NVIDIA OVX están equipados con GPU robustas, que ofrecen capacidades informáticas mejoradas, acceso al almacenamiento de alta velocidad y redes de baja latencia. Esto es particularmente vital para aplicaciones exigentes como chatbots y herramientas de búsqueda que requieren un procesamiento de datos extenso.

Actualmente disponibles y enviados por proveedores globales como GIGABYTE, Hewlett Packard Enterprise, Lenovo y Supermicro, los servidores OVX certificados por NVIDIA representan un salto significativo en el manejo de cargas de trabajo complejas de IA, prometiendo rendimiento, seguridad y escalabilidad de nivel empresarial.

Pensamientos Finales

Además, hubo anuncios en el espacio de Automoción, Robótica, Atención Médica e IA Generativa. Todos estos anuncios muestran la incesante búsqueda de innovación de NVIDIA, ofreciendo herramientas y plataformas avanzadas para impulsar el futuro de la IA y la informática en múltiples dominios. Todos ellos son muy técnicos y tienen muchas complejidades, especialmente en el caso de la computación cuántica y los lanzamientos de software. Estén atentos al análisis de los anuncios a medida que obtengamos más información sobre cada uno de estos nuevos lanzamientos.

Interactuar con StorageReview

Boletín | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed