Durante una presentazione all'ISC 23, Intel ha sottolineato la propria leadership in termini di prestazioni per i carichi di lavoro di calcolo ad alte prestazioni (HPC) e di intelligenza artificiale (AI), ha condiviso il suo portafoglio di futuri prodotti HPC e IA e ha annunciato piani ambiziosi per uno sforzo internazionale per utilizzare Aurora supercomputer per sviluppare modelli di intelligenza artificiale generativa per la scienza e la società.

Durante una presentazione all'ISC 23, Intel ha sottolineato la propria leadership in termini di prestazioni per i carichi di lavoro di calcolo ad alte prestazioni (HPC) e di intelligenza artificiale (AI), ha condiviso il suo portafoglio di futuri prodotti HPC e IA e ha annunciato piani ambiziosi per uno sforzo internazionale per utilizzare Aurora supercomputer per sviluppare modelli di intelligenza artificiale generativa per la scienza e la società.

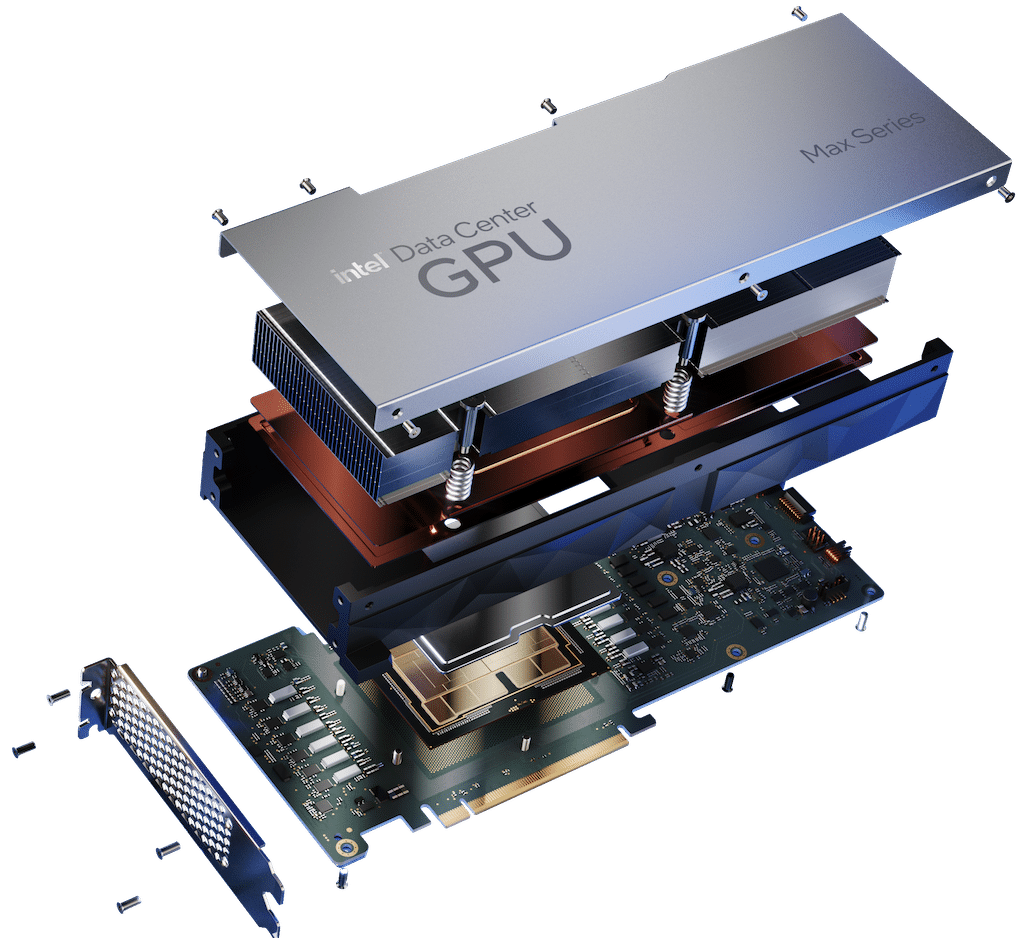

La prestazione competitiva è stata in cima alla classifica, dove i risultati di Intel sono stati chiaramente vincenti rispetto alla concorrenza. La serie Data Center GPU Max di Intel ha sovraperformato la scheda NVIDIA H100 PCIe in media del 30% su diversi carichi di lavoro. Risultati indipendenti del fornitore di software Ansys hanno indicato un aumento di velocità del 50% per la GPU della serie Max rispetto alla H100 su applicazioni HPC accelerate dall'intelligenza artificiale.

La CPU della serie Xeon Max ha dimostrato un miglioramento del 65% rispetto al processore Genoa di AMD nel benchmark HPCG (High-Performance Conjugate Gradients) e ha utilizzato meno energia. Uno dei preferiti dell'HPC, il processore scalabile Intel Xeon di quarta generazione, ha fornito una velocità media del 4% rispetto al Milan50 di AMD. Il nuovissimo cluster HPC Xeon di quarta generazione di BP ha mostrato un aumento di 4 volte delle prestazioni rispetto al processore della generazione precedente con una migliore efficienza energetica. L'acceleratore di deep learning Gaudi4 ha funzionato in modo competitivo su deep learning, training e inferenza, con prestazioni fino a 8 volte più veloci rispetto all'A2 di NVIDIA.

CPU di prossima generazione e GPU ottimizzate per l'intelligenza artificiale

Jeff McVeigh di Intel, vicepresidente aziendale di Intel e direttore generale del Super Compute Group, ha presentato le CPU Intel di nuova generazione progettate per soddisfare le elevate esigenze di larghezza di banda della memoria. Intel ha sviluppato un nuovo tipo di DIMM – Multiplexer Combined Ranks (MCR) – per Granite Rapids. MCR raggiunge velocità di 8,800 megatrasferimenti al secondo basati su DDR5 e una capacità di larghezza di banda della memoria superiore a 1.5 terabyte/secondo (TB/s) in un sistema a due socket.

Intel ha inoltre rivelato un nuovo sottosistema basato su GPU x8 Max Series ottimizzato per l'intelligenza artificiale di Supermicro, progettato per accelerare la formazione sul deep learning. Si prevede che gli OEM offriranno soluzioni con sottosistemi OAM GPU serie Max x4 e x8 e schede PCIe quest'estate.

La GPU Intel Max Series di prossima generazione, Falcon Shores, offrirà ai clienti la flessibilità di implementare combinazioni di CPU e GPU discrete a livello di sistema per i carichi di lavoro nuovi e in continua evoluzione del futuro. Il sistema Falcon Shores utilizza un'architettura modulare basata su piastrelle, che gli consente di:

- Supporta tipi di dati HPC e AI da FP64 a BF16 a FP8.

- Abilita fino a 288 GB di memoria HBM3 con una larghezza di banda totale fino a 9.8 TB/s e I/O ad alta velocità notevolmente migliorato.

- Potenzia il modello di programmazione CXL.

- Presenta un'interfaccia di programmazione GPU unificata tramite oneAPI.

IA generativa per la scienza

L'Argonne National Laboratory, in collaborazione con Intel e HPE, ha annunciato l'intenzione di creare una serie di modelli di intelligenza artificiale generativa per la comunità di ricerca scientifica. Questi modelli di intelligenza artificiale generativa per la scienza verranno addestrati su testo generale, codice, testi scientifici e dati scientifici strutturati provenienti da biologia, chimica, scienza dei materiali, fisica, medicina e altre fonti.

I modelli risultanti (con ben 1 trilione di parametri) saranno utilizzati in una varietà di applicazioni scientifiche, dalla progettazione di molecole e materiali alla sintesi di conoscenze provenienti da milioni di fonti per suggerire nuovi ed entusiasmanti esperimenti nella biologia dei sistemi, nella chimica dei polimeri e materiali energetici, scienza del clima e cosmologia. Il modello verrà utilizzato anche per accelerare l'identificazione dei processi biologici legati al cancro e ad altre malattie e suggerire obiettivi per la progettazione di farmaci.

Per portare avanti il progetto, Argonne sta guidando una collaborazione internazionale che include:

- Intel

- HPE

- Dipartimento dei Laboratori Energetici

- Università statunitensi e internazionali

- nonprofit

- Partner internazionali

Si prevede che Aurora offrirà più di due exaflop di prestazioni di calcolo di picco a doppia precisione quando verrà lanciato quest'anno.

Vantaggi di oneAPI Applicazioni HPC

I più recenti strumenti Intel oneAPI offrono accelerazioni per le applicazioni HPC con offload GPU OpenMP, estendono il supporto per OpenMP e Fortran e accelerano l'intelligenza artificiale e il deep learning attraverso framework ottimizzati, tra cui TensorFlow e PyTorch, e strumenti AI, consentendo maggiori miglioramenti delle prestazioni.

La programmazione multiarchitettura è più semplice per i programmatori grazie all'implementazione SYCL di oneAPI, ai plug-in oneAPI per processori NVIDIA e AMD sviluppati da Codeplay e allo strumento di compatibilità Intel DPC++ che migra il codice da CUDA a SYCL e C++, dove in genere il 90-95% del codice migra automaticamente . Il codice SYCL risultante mostra prestazioni comparabili con lo stesso codice in esecuzione su linguaggi di sistema nativi NVIDIA e AMD. I dati mostrano che il codice SYCL per l'applicazione di astrofisica DPEcho in esecuzione sulla GPU della serie Max supera del 100% le prestazioni dello stesso codice CUDA su NVIDIA H48.

Interagisci con StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS feed