Oggi, durante NetApp Insight, l'azienda ha annunciato la collaborazione con Run:AI, la società di virtualizzazione delle infrastrutture IA, per consentire una sperimentazione più rapida dell'IA con il pieno utilizzo della GPU. Le due società accelereranno l’intelligenza artificiale eseguendo numerosi esperimenti in parallelo, con accesso rapido ai dati e utilizzando risorse di calcolo illimitate. L'obiettivo è il migliore di tutti i mondi: esperimenti più rapidi sfruttando tutte le risorse.

Oggi, durante NetApp Insight, l'azienda ha annunciato la collaborazione con Run:AI, la società di virtualizzazione delle infrastrutture IA, per consentire una sperimentazione più rapida dell'IA con il pieno utilizzo della GPU. Le due società accelereranno l’intelligenza artificiale eseguendo numerosi esperimenti in parallelo, con accesso rapido ai dati e utilizzando risorse di calcolo illimitate. L'obiettivo è il migliore di tutti i mondi: esperimenti più rapidi sfruttando tutte le risorse.

La velocità è diventata un aspetto critico della maggior parte dei carichi di lavoro moderni. Tuttavia, la sperimentazione dell’intelligenza artificiale è legata in modo un po’ più stretto alla velocità poiché quanto più veloce è la sperimentazione, tanto più vicini saranno i risultati aziendali positivi. Anche se questo non è un segreto, i progetti di intelligenza artificiale soffrono di processi che li rendono poco efficienti, principalmente la combinazione di tempo di elaborazione dei dati e soluzioni di archiviazione obsolete. Altri problemi che possono limitare il numero di esperimenti eseguiti sono i problemi di orchestrazione del carico di lavoro e l'allocazione statica delle risorse di calcolo della GPU.

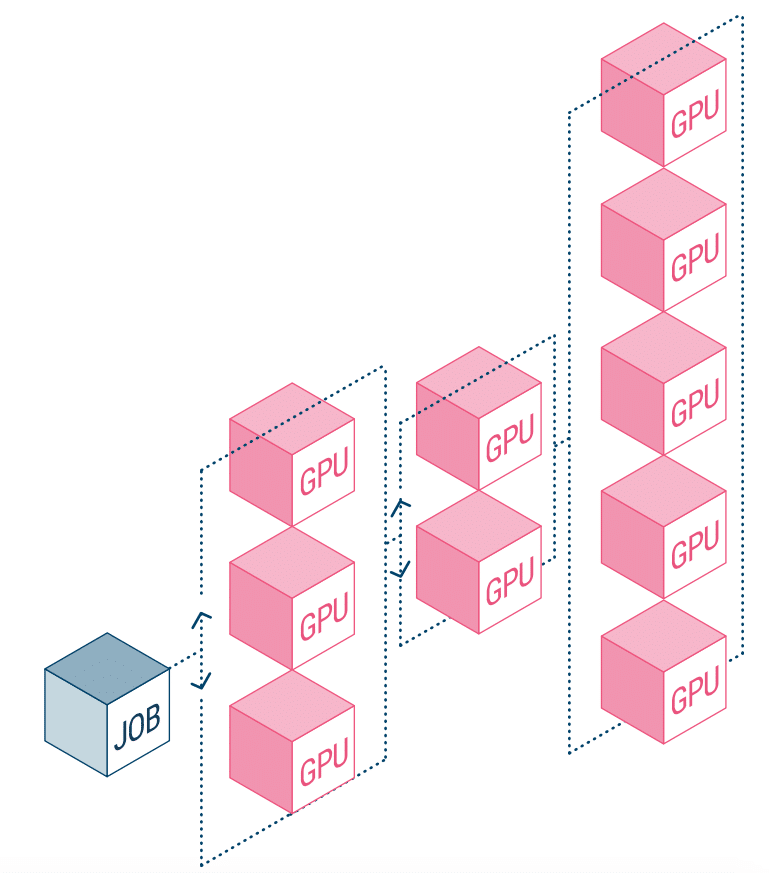

NetApp AI e Run:AI stanno collaborando per affrontare quanto sopra. Ciò significa una semplificazione dell’orchestrazione dei carichi di lavoro dell’intelligenza artificiale, ottimizzando il processo sia delle pipeline di dati che della pianificazione delle macchine per il deep learning (DL). Con la comprovata architettura AI di NetApp ONTAP, l'azienda afferma che i clienti possono realizzare meglio AI e DL semplificando, accelerando e integrando la propria pipeline di dati. Sul lato Run:AI, l'orchestrazione dei carichi di lavoro AI aggiunge una piattaforma proprietaria di pianificazione e utilizzo delle risorse basata su Kubernetes per aiutare i ricercatori a gestire e ottimizzare l'utilizzo della GPU. La tecnologia combinata consentirà di eseguire diversi esperimenti in parallelo su diversi nodi di calcolo, con accesso rapido a molti set di dati su un archivio centralizzato.

Run:AI ha creato quella che definisce la prima piattaforma di orchestrazione e virtualizzazione al mondo per l'infrastruttura AI. Astraono il carico di lavoro dall'hardware e creano pool condivisi di risorse GPU di cui è possibile effettuare il provisioning dinamico. L'esecuzione di questa funzionalità sui sistemi di storage di NetApp consente ai ricercatori di concentrarsi sul proprio lavoro senza preoccuparsi dei colli di bottiglia.

Interagisci con StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | Facebook | RSS feed