Annunciato al GTC e di diventando disponibile come AIC presso ISC, le GPU NVIDIA A100 stanno ora arrivando su Google Cloud. Considerando che è passato solo circa un mese dall’annuncio iniziale, si tratta di un passaggio davvero rapido per una GPU verso un importante cloud pubblico. Google è il primo grande cloud pubblico a introdurre le GPU A100, o Ampere, nella sua famiglia di istanze VM (A2) ottimizzate per l'acceleratore.

Annunciato al GTC e di diventando disponibile come AIC presso ISC, le GPU NVIDIA A100 stanno ora arrivando su Google Cloud. Considerando che è passato solo circa un mese dall’annuncio iniziale, si tratta di un passaggio davvero rapido per una GPU verso un importante cloud pubblico. Google è il primo grande cloud pubblico a introdurre le GPU A100, o Ampere, nella sua famiglia di istanze VM (A2) ottimizzate per l'acceleratore.

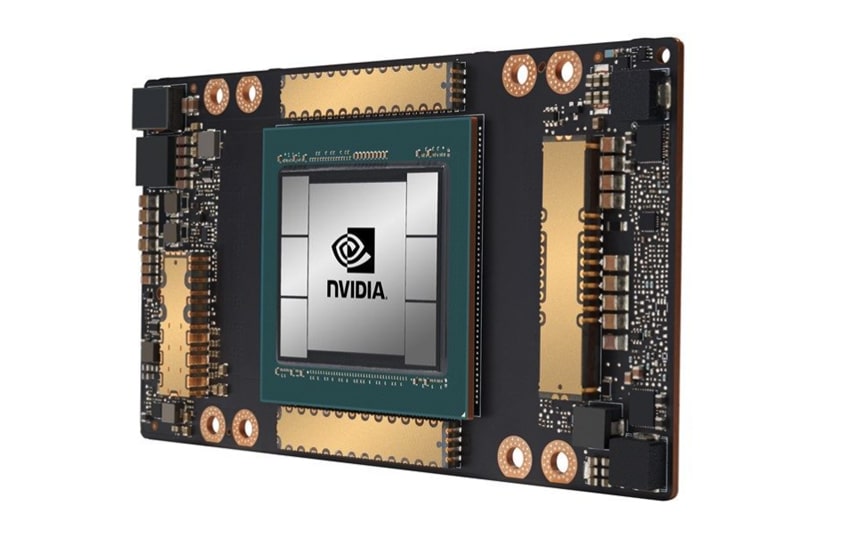

Come abbiamo affermato nell'annuncio iniziale, la prima GPU da 7 nm di NVIDIA è la NVIDIA A100. L'A100 si basa sull'architettura Ampere di NVIDIA e contiene 54 miliardi di transistor. Come le precedenti GPU per data center NVIDIA, l'A100 include Tensor Core. I tensor core sono parti specializzate della GPU progettate specificamente per eseguire rapidamente un tipo di moltiplicazione di matrici e calcoli di addizione comunemente utilizzati nell'inferenza. Con le nuove GPU più robuste, arrivano nuovi Tensor Core più robusti. In precedenza, i Tensor Core di NVIDIA potevano supportare solo numeri in virgola mobile fino a trentadue bit. L'A100 supporta operazioni a virgola mobile a sessantaquattro bit, consentendo una precisione molto maggiore.

Diversi casi d’uso del cloud necessitano del tipo di potenza di calcolo che le GPU possono fornire, in particolare formazione e inferenza dell’intelligenza artificiale, analisi dei dati, calcolo scientifico, genomica, analisi video edge, servizi 5G, tra gli altri. Le nuove GPU NVIDIA A100 possono aumentare le prestazioni di training e inferenza di 20 volte rispetto ai suoi predecessori, rendendole ideali per quanto sopra.

Google Compute Engine sfrutterà l'A100 per molteplici usi, dall'espansione della formazione sull'intelligenza artificiale e dell'elaborazione scientifica, all'espansione delle applicazioni di inferenza, all'abilitazione dell'intelligenza artificiale conversazionale in tempo reale. La nuova istanza, A2 VM, può funzionare con carichi di lavoro di varie dimensioni. L'istanza funzionerà con la formazione e l'inferenza di machine learning abilitati CUDA, l'analisi dei dati e l'elaborazione ad alte prestazioni. Per i carichi di lavoro di grandi dimensioni, Google offre l'istanza a2-megagpu-16g, dotata di 16 GPU A100, per un totale di 640 GB di memoria GPU e 1.3 TB di memoria di sistema, il tutto connesso tramite NVSwitch con un massimo di 9.6 TB/s di aggregato larghezza di banda. Per i clienti che non necessitano di così tanta potenza ci saranno anche VM A2 più piccole.

Nel prossimo futuro, Google Cloud implementerà il supporto A100 per Google Kubernetes Engine, Cloud AI Platform e altri servizi Google Cloud.

Interagisci con StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | Facebook | RSS feed