Le applicazioni di intelligenza artificiale generativa creano risposte testuali impressionanti che a volte sono accurate e altre volte completamente fuori tema. Queste applicazioni intelligenti sono alimentate da modelli linguistici di grandi dimensioni (LLM) in grado di rispondere a domande complesse e creare opere d'arte, letteratura e altro ancora. È fondamentale garantire che queste applicazioni intelligenti generino risposte testuali accurate, appropriate, pertinenti, sicure e aggiornate.

Le applicazioni di intelligenza artificiale generativa creano risposte testuali impressionanti che a volte sono accurate e altre volte completamente fuori tema. Queste applicazioni intelligenti sono alimentate da modelli linguistici di grandi dimensioni (LLM) in grado di rispondere a domande complesse e creare opere d'arte, letteratura e altro ancora. È fondamentale garantire che queste applicazioni intelligenti generino risposte testuali accurate, appropriate, pertinenti, sicure e aggiornate.

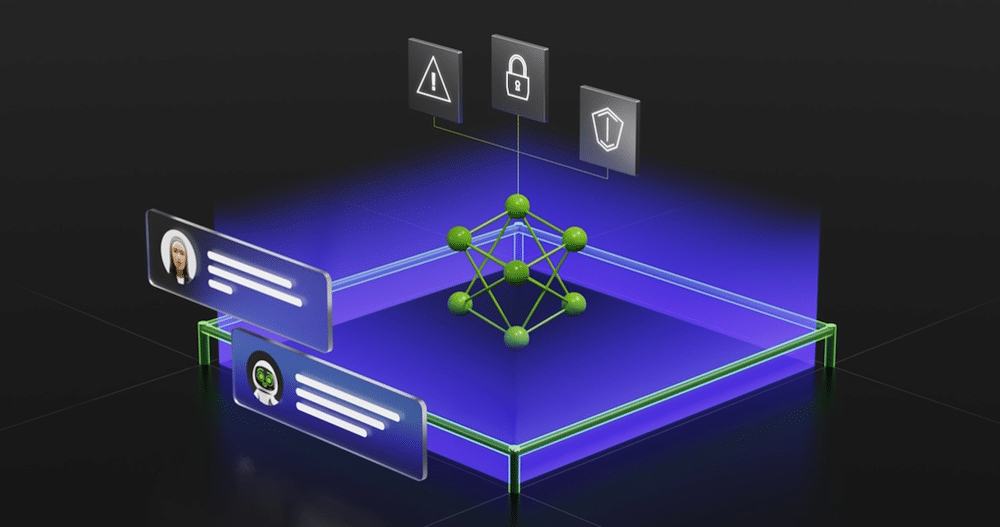

NVIDIA ha rilasciato un software open source per aiutare gli sviluppatori a mantenere in carreggiata le applicazioni di intelligenza artificiale generativa. NeMo Guardrails aiuterà a garantire che le app AI rispondano in modo appropriato, accurato e sicuro. Il software NeMo Guardrails include tutto il codice, gli esempi e la documentazione di cui le aziende hanno bisogno per sentirsi sicure nell'implementazione di app AI che generano testo.

Implicazioni aziendali

Le aziende hanno mostrato esitazione nell'implementare modelli linguistici di grandi dimensioni (LLM) a causa delle preoccupazioni relative alla sicurezza e alla possibilità che i LLM generino contenuti inappropriati o distorti. L’introduzione di NeMo Guardrails offre una soluzione promettente a queste sfide, contribuendo a mitigare i rischi associati all’adozione del LLM e aiutando le imprese a superare le loro esitazioni. Fornendo un toolkit per la creazione di sistemi di conversazione LLM sicuri e affidabili, NeMo Guardrails consente agli sviluppatori di stabilire facilmente regole programmabili che dettano le interazioni degli utenti, garantendo che le applicazioni basate su LLM aderiscano agli standard e alle politiche aziendali.

I guardrail per attualità, sicurezza e protezione supportati da NeMo Guardrails rispondono ad alcune delle principali preoccupazioni che abbiamo sentito dalle aziende, dal mantenimento dell'attenzione all'attualità, alla prevenzione della disinformazione o risposte inappropriate o dannose. Offrendo un solido modello di sicurezza e mitigando i rischi associati alle applicazioni basate su LLM, NeMo Guardrails infonde maggiore fiducia nelle aziende nell'adozione di questa potente tecnologia.

Si spera che con il rilascio di NeMo Guardrails possa fungere da catalizzatore per una più ampia adozione da parte delle imprese degli LLM, colmando il divario tra le capacità della tecnologia AI e i requisiti di sicurezza e protezione del mondo degli affari.

Sicuro, in tema, protetto

Molte industrie stanno adottando LLM mentre lanciano applicazioni di intelligenza artificiale che alla fine risponderanno alle domande dei clienti, forniranno riepiloghi a documenti lunghi, scriveranno software e accelereranno la progettazione di farmaci. Con un pubblico così diversificato, la sicurezza nell'intelligenza artificiale generativa è una preoccupazione significativa e NVIDIA NeMo Guardrails è stata progettata per funzionare con tutti gli LLM, incluso ChatGPT di OpenAI, per garantire la sicurezza degli utenti.

Gli sviluppatori possono utilizzare NeMo Guardrails per impostare tre tipi di confini:

- Guardrail d'attualità: Impedisce alle app di deviare dalla rotta verso aree indesiderate, ad esempio impedendo agli assistenti del servizio clienti di rispondere a domande sul tempo.

- Parapetti di sicurezza: Garantisce che le app rispondano con informazioni accurate e appropriate, filtrando il linguaggio indesiderato e imponendo che i riferimenti siano fatti solo a fonti credibili.

- Barriere di sicurezza: limita le app a effettuare connessioni solo ad applicazioni esterne di terze parti note per essere sicure.

NeMo Guardrails non richiede che gli sviluppatori di software siano esperti di machine learning o diventino data scientist. È possibile creare rapidamente nuove regole con poche righe di codice.

Open Source e disponibile su GitHub

NVIDIA sta aggiungendo NeMo Guardrails al framework NVIDIA NeMo fornendo agli utenti tutto ciò di cui hanno bisogno per addestrare e ottimizzare i modelli linguistici. Gran parte del framework NeMo è già disponibile su GitHub e le aziende possono ottenere un pacchetto completo e supportato poiché fa parte della piattaforma software NVIDIA AI Enterprise.

NeMo fa anche parte di NVIDIA AI Foundations, una famiglia di servizi cloud per le aziende che desiderano creare ed eseguire modelli di IA generativa personalizzati basati sui propri set di dati e sulla conoscenza del dominio.

Costruito su Colang

NeMo Guardrails è basato su CoLang, un linguaggio di modellazione e runtime associato per l'intelligenza artificiale conversazionale. Colang fornisce un'interfaccia leggibile ed estensibile affinché gli utenti possano definire o controllare il comportamento dei bot conversazionali con il linguaggio naturale.

I guardrail vengono creati definendo i flussi in un file Colang utilizzando moduli, messaggi e flussi canonici. Ciò si ottiene utilizzando il linguaggio naturale, semplificando la costruzione e il mantenimento del compito del bot. Parecchi Esempi di GitHub affrontare i modelli comuni per l'implementazione dei guardrail.

Interagisci con StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS feed