Nel panorama in continua evoluzione dello sviluppo dell'intelligenza artificiale (AI), la formazione sul cloud ha rivoluzionato il modo in cui i modelli di intelligenza artificiale vengono creati, perfezionati e distribuiti. Il cloud training, un metodo per addestrare modelli di intelligenza artificiale utilizzando l’infrastruttura cloud remota, offre numerosi vantaggi che spingono lo sviluppo dell’intelligenza artificiale verso nuovi ambiti di scalabilità, efficienza e accessibilità.

Nel panorama in continua evoluzione dello sviluppo dell'intelligenza artificiale (AI), la formazione sul cloud ha rivoluzionato il modo in cui i modelli di intelligenza artificiale vengono creati, perfezionati e distribuiti. Il cloud training, un metodo per addestrare modelli di intelligenza artificiale utilizzando l’infrastruttura cloud remota, offre numerosi vantaggi che spingono lo sviluppo dell’intelligenza artificiale verso nuovi ambiti di scalabilità, efficienza e accessibilità.

Sfruttando la potenza del cloud computing, le organizzazioni e gli sviluppatori possono sbloccare una serie di vantaggi che semplificano il processo di formazione sull’intelligenza artificiale e accelerano l’innovazione in modi prima irraggiungibili. Dalla semplice scalabilità all'utilizzo di hardware specializzato, la formazione sul cloud consente ai professionisti dell'intelligenza artificiale di affrontare sfide complesse con agilità e sfruttare tutto il potenziale dei loro modelli.

Chi è OVHcloud USA?

Sebbene non sia un nome familiare, OVHcloud US, la filiale statunitense del gruppo OVH, offre server bare metal, cloud privato ospitato e soluzioni di cloud ibrido. Le loro soluzioni coprono tutto, dai server dedicati per i videogiochi, ai servizi cloud privati ospitati su misura per le grandi aziende e tutto il resto. In questa recensione, esploreremo i loro servizi di elaborazione Public Cloud, in particolare il GPU Cloud basato sulle GPU NVIDIA Tesla V100S. Queste istanze GPU sono progettate per tutto ciò che trarrebbe vantaggio dall'elaborazione parallela, che si tratti di machine learning essenziale, intelligenza artificiale generativa o formazione specifica su modelli di intelligenza artificiale.

Uno degli aspetti principali che vogliamo esaminare oggi sono i vantaggi dell'elaborazione GPU basata su cloud rispetto alle soluzioni locali. C'è sicuramente una discussione da sostenere per entrambi, ma OVHcloud US offre alcuni validi motivi per passare al cloud, anche se è solo per iniziare il tuo percorso personale o aziendale verso l'intelligenza artificiale.

Il principale punto di forza è senza dubbio il prezzo. A partire da 0.88 dollari/ora per una singola Tesla V100S con 32 GB di VRAM, 14 vCore e 45 GB di memoria, è possibile utilizzare migliaia di ore di cicli prima ancora di avvicinarsi al costo di una soluzione on-premise. Poi c’è il vantaggio in termini di costi derivante dall’integrazione delle macchine GPU interne esistenti con istanze basate su cloud per cose come la riqualificazione occasionale dei modelli IA.

Le offerte di GPU OVHcloud US sono suddivise nelle seguenti istanze:

| Nome | Memorie | vCore | GPU | Archiviazione | Rete pubblica | Rete privata | Prezzo/ora |

| t2-45 | 45 GB | 14 | Tesla V100S 32GB | 400 GB SSD | 2 Gbps | 4 Gbps | $2.191 |

| t2-90 | 90 GB | 28 | 2 Tesla V100S 32GB | 800 GB SSD | 4 Gbps | 4 Gbps | $4.38 |

| t2-180 | 180 GB | 56 | 4 Tesla V100S 32GB | SSD da 50 GB + NVMe da 2 TB | 10 Gbps | 4 Gbps | $8.763 |

| t2-le-45 | 45 GB | 14 | Tesla V100S 32GB | 300 GB SSD | 2 Gbps | 4 Gbps | $0.88 |

| t2-le-90* | 90 GB | 30 | Tesla V100S 32GB | 500 GB SSD | 4 Gbps | 4 Gbps | $1.76 |

| t2-le-180* | 180 GB | 60 | Tesla V100S 32GB | 500 GB SSD | 10 Gbps | 4 Gbps | $3.53 |

*appena rilasciato

Hardware per server GPU OVHcloud USA

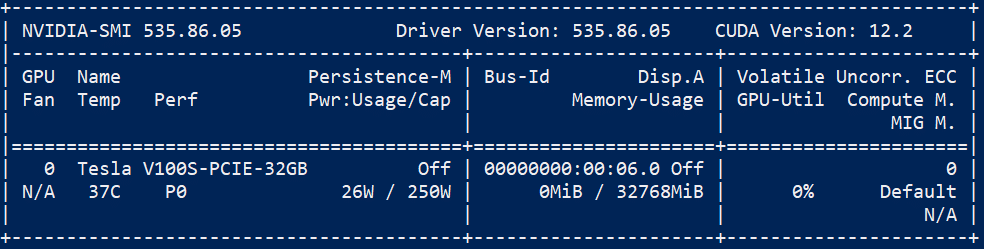

Diamo uno sguardo più approfondito alle opzioni hardware offerte da OVHcloud US. Al centro delle istanze GPU c'è NVIDIA Tesla V100S, una GPU ottimizzata per l'elaborazione con 32 GB di memoria HBM2. Sebbene le più recenti Tesla A100 abbiano sostanzialmente sostituito queste GPU, la V100S offre ancora prestazioni e valore eccellenti.

L'aspetto più importante di queste istanze è che sono basate su cloud, quindi non vincoleranno alcun sistema che potresti avere in loco, rendendole una soluzione ideale per flussi di lavoro "impostalo e dimenticalo". Queste GPU vengono fornite direttamente all'istanza tramite passthrough PCI senza un livello di virtualizzazione, fornendo un utilizzo dedicato di ciascuna scheda per il tuo lavoro.

OVHcloud US offre diverse opzioni con CPU più veloci se il tuo caso d'uso lo richiede. Le opzioni di memoria vanno da 45 GB a 180 GB, che dovrebbero essere sufficienti per la maggior parte dei flussi di lavoro incentrati sulla GPU. La stessa filosofia si applica allo storage, con capacità da 300 GB fino a un'unità NVMe dedicata da 2 TB.

Server GPU OVHcloud US – Casi d'uso più diffusi dell'IA

Mercato

Avviare ed eseguire un'istanza è abbastanza veloce ed economico da spingere OVHcloud a convincere anche lo sviluppatore occasionale a giocare con una GPU decente. In teoria, potresti creare tutti i tuoi dati di addestramento localmente, caricarli sul fornitore di dati cloud di tua scelta, avviare un'istanza e iniziare ad addestrare/perfezionare vari modelli disponibili online.

Attraverso test rigorosi di questo scenario, abbiamo sviluppato una varietà di sofisticati Lama sapori utilizzando il codice Alpaca e i pesi convertiti Huggingface. Queste versioni possono essere preparate senza problemi sul tuo dispositivo, caricate comodamente su Google Drive, scaricate facilmente sull'istanza e ottimizzate con perizia. Ora stiamo lavorando con i modelli con parametri più bassi per adattarli ai 32 GB di VRAM che avevamo, ed era comunque un'opzione molto più gestibile rispetto al tentativo di acquistare una scheda comparabile come una RTX8000 da gettare nel laboratorio di casa.

Le piccole imprese potrebbero utilizzare questa strategia per fornire a uno sviluppatore o a un team l’accesso al GPU computing adesso invece di aspettare l’hardware o approvazioni significative del budget.

Inferenza

La V100S è un'ottima GPU per l'inferenza degli LLM che possono essere inseriti nella sua memoria. Sebbene i tempi di inferenza differiscano da quelli che otterresti con servizi come ChatGPT, il compromesso comporta il vantaggio di gestire il tuo modello privato. Come al solito, l'esecuzione di un servizio cloud con operatività 24 ore su 7, 0.88 giorni su XNUMX comporterà dei costi, ma ci vorrebbero mesi di esecuzione dell'istanza agli attuali XNUMX dollari l'ora per avvicinarsi all'infrastruttura necessaria per farlo in sede.

Riconoscimento dell'immagine

Estrarre dati dalle immagini per classificarle, identificare un elemento o creare documenti più ricchi è un requisito per molti settori. Con framework come Caffe2 combinato con la GPU Tesla V100S, l'imaging medico, i social network, la protezione pubblica e la sicurezza diventano più accessibili.

Analisi della situazione

In alcuni casi, è necessaria un'analisi in tempo reale quando si prevede una reazione adeguata per affrontare situazioni diverse e imprevedibili. Ad esempio, questa tecnologia viene utilizzata per le auto a guida autonoma e per l’analisi del traffico della rete Internet. È qui che emerge il deep learning, formando reti neurali che apprendono in modo indipendente attraverso la formazione.

Interazione umana

In passato, le persone imparavano a comunicare con le macchine. Siamo ormai in un’era in cui le macchine stanno imparando a comunicare con le persone. Che si tratti del riconoscimento vocale o delle emozioni tramite audio e video, strumenti come TensorFlow ampliano i confini di queste interazioni, aprendo la strada a molti nuovi usi.

Impressioni pratiche

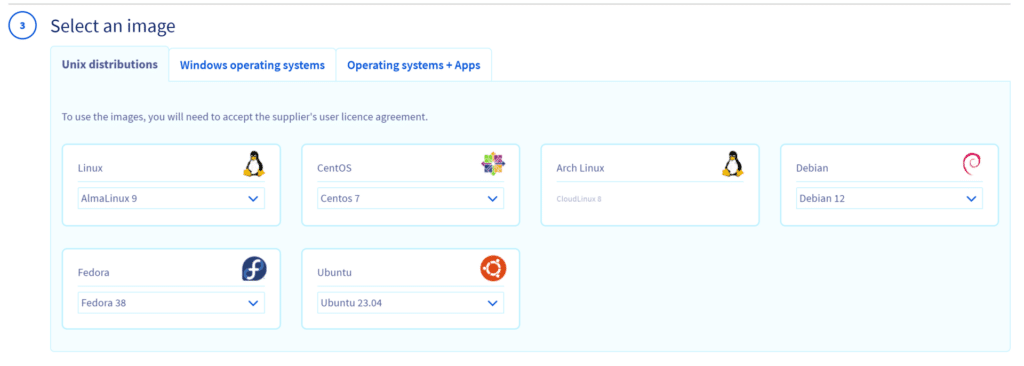

Inizialmente, il portale OVHcloud USA era intuitivo e la configurazione è stata semplice. Crea un account, aggiungi un metodo di pagamento, crea alcune chiavi SSH, seleziona l'istanza, prendi una Red Bull e passa SSH alla tua nuova GPU. Abbiamo utilizzato Ubuntu Server, ma sono disponibili altre opzioni per versioni e versioni Linux, tra cui Fedora, Arch, Debian CenOS, AlmaLinux e Rocky.

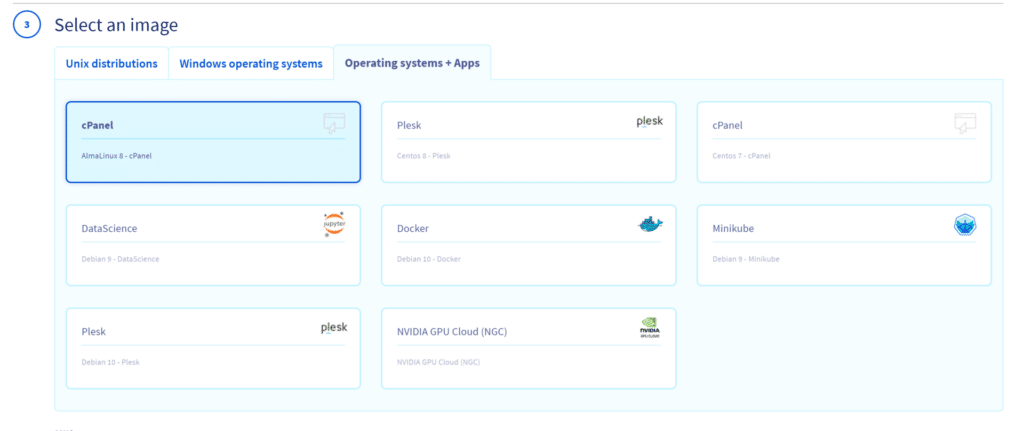

C'è anche la possibilità di installare varie immagini del sistema operativo che includono app come Docker.

Provando a provare il server GPU OVHcloud US, abbiamo trovato l'esperienza incredibilmente intuitiva e reattiva. La configurazione dell'istanza è stata semplicissima e l'accesso alle risorse della GPU è stato praticamente semplice. Sia che si tratti di testare modelli complessi di machine learning o di gestire attività di elaborazione dati su larga scala, le istanze GPU di OVHcloud US hanno dimostrato prestazioni notevoli.

Inoltre, la flessibilità nel ridimensionamento delle risorse ci ha permesso di personalizzare l'ambiente in base alle nostre esigenze specifiche. Tutto è stato progettato per facilitare un flusso di lavoro fluido ed efficiente, dall'interfaccia utente all'hardware sottostante. Il supporto per vari framework di intelligenza artificiale popolari, combinato con la potenza delle GPU NVIDIA Tesla V100S, ha reso i nostri esperimenti, l'addestramento e l'inferenza dei modelli non solo possibili ma altamente efficaci.

La capacità di aumentare le nostre risorse interne con queste soluzioni basate su cloud ha confermato OVHcloud US come un'opzione interessante sia per i principianti che muovono i primi passi nell'intelligenza artificiale sia per i professionisti esperti alla ricerca di soluzioni affidabili ed economicamente vantaggiose.

Abbiamo eseguito un paio di benchmark per testare le prestazioni di allocazione della CPU e l'implementazione del V100. Il primo è stato il benchmark Blender-CLI e poi il nostro banco CPU preferito, y-cruncher.

| Mostro della GPU | 1112.95022 |

| Negozio di spazzatura GPU | 754.813874 |

| Aula GPU | 603.196188 |

| Mostro della CPU | 113.467036 |

| Negozio di spazzatura della CPU | 62.223543 |

| Aula CPU | 50.618349 |

| y-cruncher 1b |

40.867 secondi

|

| y-cruncher 2.5b |

113.142 secondi

|

L'istanza t2-45le, dopo i test, ha fornito risultati coerenti con le sue specifiche, senza mostrare sorprese nei parametri prestazionali. Con il V100 integrato, è evidente che è in grado di gestire attività di inferenza intensive e supporta anche le operazioni di formazione basate su cloud in modo efficace sia in termini di prestazioni che di costi.

Pensieri di chiusura

Come per tutto ciò che riguarda l'IT aziendale, ci sono pro e contro; lo stesso vale per l’intelligenza artificiale per l’addestramento sul cloud. La formazione sul cloud con i server GPU OVHcloud US offre scalabilità, efficienza in termini di costi e sviluppo accelerato e apre le porte all'innovazione e alla sperimentazione. Hardware specializzato, accessibilità globale e collaborazione senza soluzione di continuità rendono l'intelligenza artificiale basata sul cloud pronta per scoperte rivoluzionarie.

Centro dati OVHcloud

Questi vantaggi si affiancano alle realtà legate ai problemi di sicurezza dei dati e alla stabilità della rete. Affrontando la curva di apprendimento potenzialmente ripida, la formazione sul cloud per l’intelligenza artificiale dovrebbe essere affrontata con cautela, avvisando le organizzazioni di tracciare un percorso strategico che si allinei alle loro esigenze e priorità specifiche.

Anche se abbiamo accennato solo allo specifico GPU Server, OVHcloud US offre un set completo di servizi. Nel complesso, il supporto è stato amichevole e ci hanno contattato per vedere se avevamo bisogno di assistenza dopo la nostra registrazione iniziale. Il portale era intuitivo, facile da usare e da comprendere e il sistema ha funzionato esattamente come previsto. L'unico lato negativo potrebbe essere la mancanza di regioni, ma questo viene facilmente trascurato a causa del costo e della semplicità. OVHcloud US riceve una solida raccomandazione e si mette al nostro fianco come potenziale fornitore di servizi cloud per progetti futuri che necessitano di essere fuori dal laboratorio o semplicemente di un po' di potenza extra noleggiata per portare a termine un lavoro.

Mentre ci muoviamo in questo panorama dinamico, è essenziale affrontare la formazione sul cloud per l’intelligenza artificiale con una prospettiva equilibrata, cogliendo le opportunità e affrontando pragmaticamente le sfide. Il viaggio verso l’eccellenza dell’intelligenza artificiale, caratterizzato da ingegnosità e praticità, è modellato dalla comprensione dell’intricata interazione di questi pro e contro e dalla creazione di strategie che sfruttano i primi mitigando i secondi.

Interagisci con StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS feed