Computex 2024 で、ASRock Rack は、堅牢な NVIDIA Blackwell アーキテクチャを活用した一連のスケールアップ サーバーを発表しました。 ASRock ラックは、AI、HPC、データセンターのワークロードの需要を満たすように設計されたいくつかの最先端のシステムを展示しました。

Computex 2024 で、ASRock Rack は、堅牢な NVIDIA Blackwell アーキテクチャを活用した一連のスケールアップ サーバーを発表しました。 ASRock ラックは、AI、HPC、データセンターのワークロードの需要を満たすように設計されたいくつかの最先端のシステムを展示しました。

ASRock Rack の発表の中心となったのは、水冷ラック ソリューションである ORV3 NVIDIA GB200 NVL72 でした。このシステムは、最近発表された NVIDIA GB200 NVL72 スケールアップ システムを中心に構築されており、NVIDIA NVLink テクノロジを使用して 36 個の NVIDIA Grace CPU と 72 個の NVIDIA Blackwell Tensor コア GPU を統合します。この構成により、総所有コスト (TCO) を削減しながら、より高速なリアルタイム大規模言語モデル (LLM) 推論が可能な大規模な GPU ユニットが形成されます。

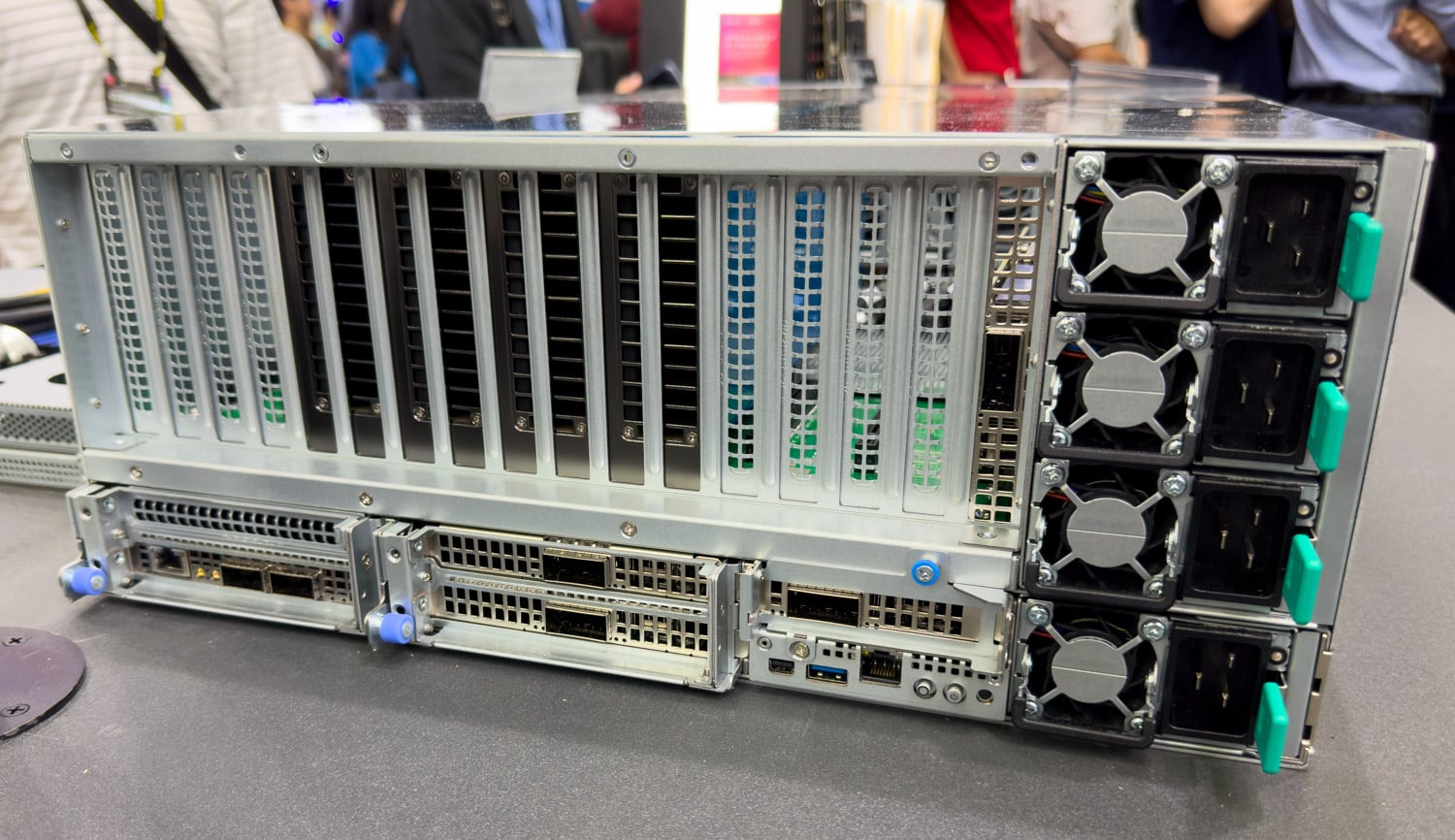

ORV3 システムに加えて、ASRock ラックは 6U8X-EGS2 NVIDIA HGX B100 および 6U8X-GNR2/DLC NVIDIA HGX B200 アドバンスト サーバー モデルを導入しました。これらのサーバーには、それぞれ NVIDIA HGX B100 および B200 8 GPU システムが搭載されています。

NVIDIA HGX B100 は、既存の NVIDIA HGX H100 インフラストラクチャのドロップイン代替品であり、簡単な移行を促進します。 6U8X-GNR2/DLC NVIDIA HGX B200 は、ダイレクトチップ液体冷却テクノロジーを備えており、システムが 6U ラックマウント設計内で NVIDIA Blackwell GPU の熱設計電力 (TDP) を効率的に処理できるようにします。液冷インフラストラクチャを持たない企業向けに、ASRock ラックは空冷式 8U8X-GNR2 NVIDIA HGX B200 を導入する予定です。これには、兆パラメータ モデルでの高性能リアルタイム推論のための NVIDIA HGX B200 8 GPU システムも搭載されています。

強化された接続性

すべての ASRock ラック NVIDIA HGX サーバーは、エンドツーエンドの AI に最適化されたイーサネット ソリューションである NVIDIA Spectrum-X プラットフォームを活用して、最大 3 つの NVIDIA BlueField-XNUMX SuperNIC をサポートします。これらのシステムは、生成 AI 用の NVIDIA AI Enterprise ソフトウェア スイートの一部として、NVIDIA NIM 推論マイクロサービスを含む、フルスタックの NVIDIA AI およびアクセラレーション コンピューティング プラットフォームに対しても認定されます。

ASRock Rack の社長である Weishi Sa 氏は、NVIDIA Blackwell アーキテクチャを活用した最高レベルのデータセンター ソリューションを提供するという同社の取り組みを強調しました。 「私たちは、LLM トレーニングと生成 AI 推論における最も要求の厳しいワークロードに対応するデータセンター ソリューションを紹介しています。私たちは、NVIDIA Blackwell アーキテクチャの利点を主流の LLM 推論とデータ処理にもたらすために、ポートフォリオの拡大を続けていきます。」

ASRock Rack は、NVIDIA Blackwell アーキテクチャの利点をスケールアウト構成に拡張し、既存のデータセンター インフラストラクチャとのシームレスな統合を確保するために、NVIDIA GB200 NVL2 をベースにした新製品を開発しています。

NVIDIA の GPU 製品管理担当副社長である Kaustubh Sanghani 氏は、ASRock Rack とのコラボレーションを強調しました。同氏は、「ASRock Rackと協力して、ハードウェアとソフトウェアをシームレスに統合して画期的なパフォーマンスとスケーラビリティを提供し、AIとハイパフォーマンスコンピューティングの限界を押し上げる強力なAIエコシステムを企業に提供しています。」と述べた。

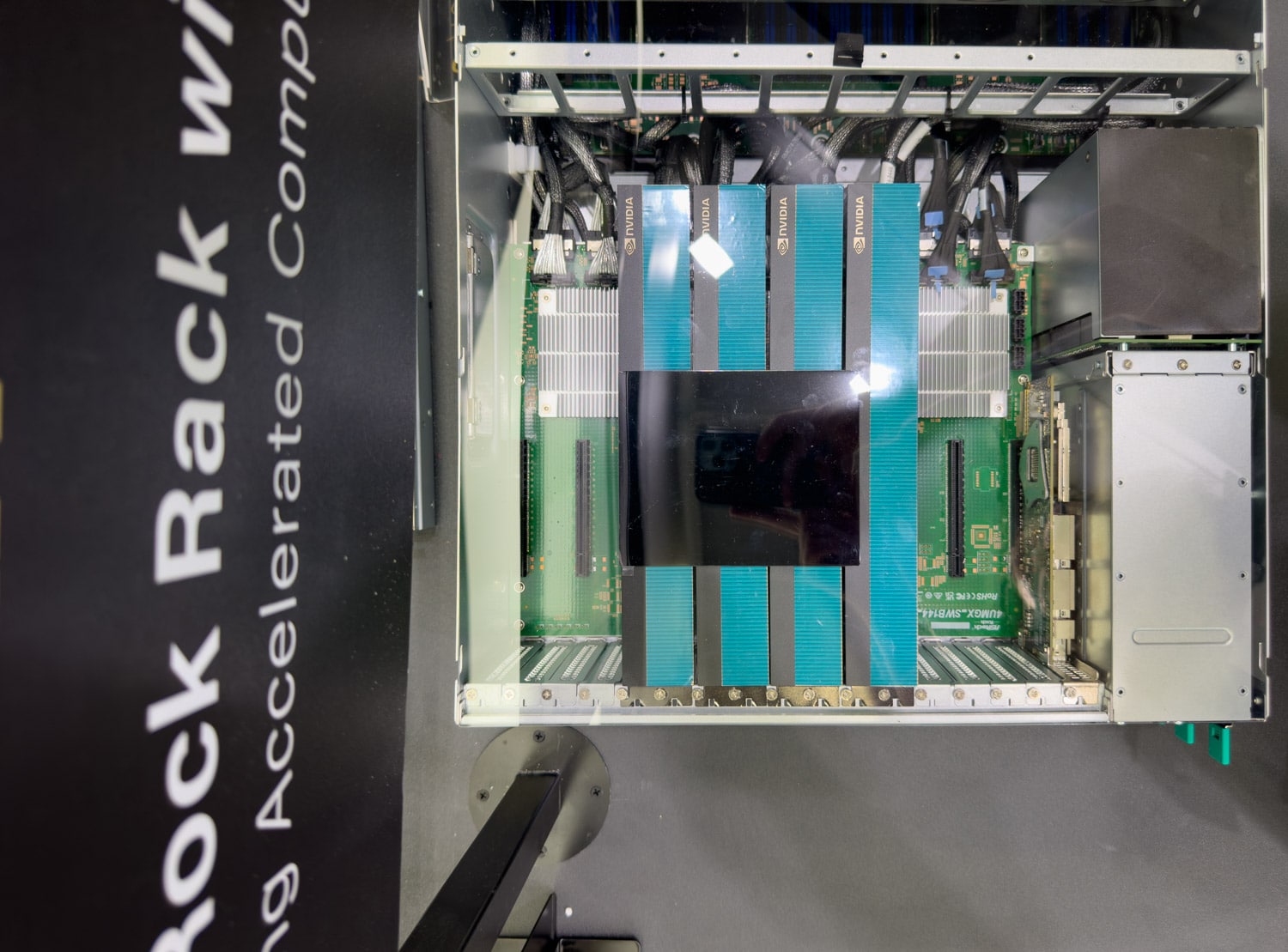

NVIDIA MGX モジュラー リファレンス アーキテクチャ

新製品に加えて、ASRock Rack は、NVIDIA MGX 4U アーキテクチャに準拠したデュアル ソケット GPU サーバーである 2UMGX-GNR4 を発表しました。このサーバーは、NVIDIA H200 NVL Tensor コア GPU など、最大 5.0 つの FHFL デュアルスロット GPU をサポートしており、主流のエンタープライズ サーバーに適しています。 16 つの FHHL PCIe 5.0 x16 スロットと 3 つの HHHL PCIe 7 x200 スロットを備え、複数の 400Gb/s または 16Gb/s ネットワーク接続用の NVIDIA BlueField-1 DPU および NVIDIA ConnectX®-5.0 NIC をサポートします。このサーバーには、E4.S (PCIe XNUMX xXNUMX) SSD 用の XNUMX 個のホットスワップ ドライブ ベイもあります。

ASRock Rack MGX プラットフォームの最も興味深い点の 1 つは、E16.S ストレージ ソリューションの実装です。なんと 1 台の E8.S ドライブの半分は CPU に直接接続されていますが、さらに興味深いことに、残りの XNUMX 台は GPU バックプレーンも接続されている PCI-e スイッチに接続されています。これは、GPU ダイレクト ストレージのいくつかの興味深く、非常に魅力的な使用例を示しています。

ASRock Rack ブースでは、ASRock Rack が今年初めに発売した MECAI-NVIDIA GH200 Grace Hopper スーパーチップ サーバーなど、より高度なサーバー システムを展示する予定です。 NVIDIA の Blackwell アーキテクチャを搭載した ASRock Rack の新しいサーバー ポートフォリオは、データ センターと AI テクノロジーの大幅な進歩を表しています。これらのシステムは、優れたパフォーマンス、柔軟性、拡張性を提供し、AI とハイ パフォーマンス コンピューティングの限界を押し広げようとしている企業のニーズを満たします。

StorageReview と連携する

ニュースレター | YouTube |ポッドキャスト iTunes/Spotifyは | Instagram | Twitter | TikTok | RSSフィード