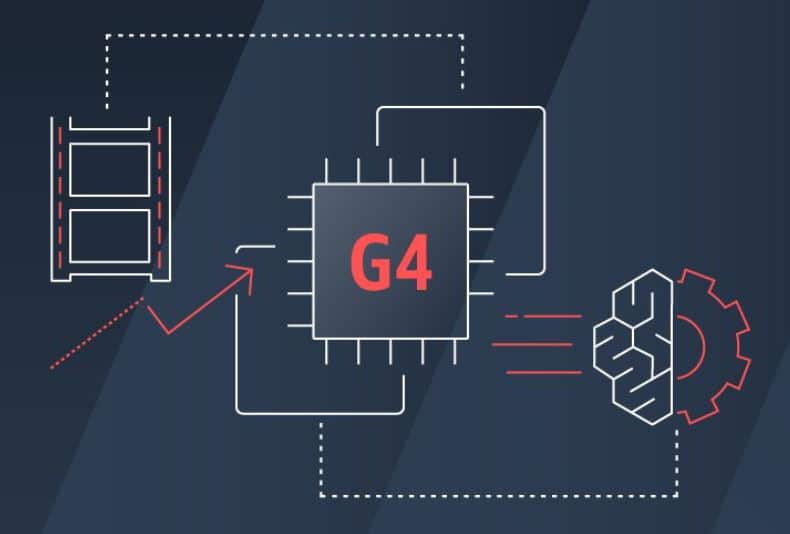

本日、Amazon Web Services, Inc. (AWS) は、新しい GPU を搭載した Amazon Elastic Compute Cloud (Amazon EC2) インスタンスである G4 インスタンスの一般提供を発表しました。この新しいインスタンスは、アプリケーションに対して業界で最もコスト効率の高い ML 推論を提供しながら、機械学習 (ML) 推論を高速化するように設計されています。新しいインスタンスは、コスト効率の高い方法でグラフィックスを多用するワークロードにも最適であり、リモート グラフィックス ワークステーション、ビデオ コード変換、フォトリアリスティックなデザイン、クラウドでのゲーム ストリーミングなど、グラフィックスを多用するアプリケーションの構築と実行に最適です。 。

AWS は、ML には、トレーニングと推論というコンピューティングを必要とする 3 つのプロセスが含まれると述べています。トレーニングには、ラベル付きデータを使用して、予測を行うことができるモデルを作成することが伴います。これは、強力なプロセッサーと高速ネットワーキングを必要とする計算集約型のタスクです。推論は、トレーニングされた機械学習モデルを使用して予測を行うプロセスであり、通常、多数の小規模なコンピューティング ジョブを同時に処理する必要があります。このジョブは、NVIDIA の強力な GPU に最適です。 AWS は ML 用のインスタンスに精通しており、XNUMX 年前に初めて PXNUMX インスタンスを立ち上げました。これは大きな一歩でしたが、ML ワークロードの運用コストの大部分を推論が占めています。

これに対処するために、AWS は、最新世代の NVIDIA T4 GPU、カスタムの第 4 世代 Intel Xeon スケーラブル (Cascade Lake) プロセッサ、最大 2 Gbps のネットワーク スループット、および最大 100 TB のローカル NVMe ストレージを活用する新しい G1.8 インスタンスをリリースしました。機械学習推論用に最もコスト効率の高い GPU インスタンスを提供します。新しい G4 インスタンスは、推論に最適な、最大 65 TFLOP の混合精度パフォーマンスを提供できます。 G4 は、トレーニング時間の影響を受けにくい小規模および入門レベルの機械学習トレーニング ジョブにもコスト効率よく使用できます。グラフィックスを多用するワークロードの場合、新しいインスタンスは、前世代の G1.8 インスタンスと比較して、グラフィックス パフォーマンスが最大 2 倍向上し、ビデオ トランスコーディング機能が最大 3 倍向上します。

利用状況

G4 インスタンスは、オンデマンド、リザーブド インスタンス、またはスポット インスタンスとして購入できます。

StorageReview ニュースレターにサインアップする