マイクロソフトは、今週の Microsoft Ignite イベントで、シリコン ポートフォリオの拡張を含む、カスタム チップ設計と AI インフラストラクチャに関するいくつかの新しい開発を発表しました。

Microsoft は、Ignite 2024 でカスタム チップ設計と AI インフラストラクチャにおけるいくつかの重要な開発を発表しました。同社は、AI コンピューティングに関して NVIDIA とのパートナーシップを強化しながら、新しいセキュリティおよびデータ処理チップでシリコン ポートフォリオを拡大しています。これらの更新は、Microsoft のクラウド サービス全体の効率、セキュリティ、パフォーマンスを向上させることを目的としています。

マイクロソフトのカスタムシリコン革命

Microsoft は、Azure Maia AI アクセラレータや Azure Cobalt CPU 以外にも、カスタム シリコン ポートフォリオを大幅に拡張しています。同社は、パフォーマンスを犠牲にすることなくキー管理を強化するように設計された社内セキュリティ チップである Azure Integrated HSM を導入しました。2025 年には、Microsoft はすべての新しいデータ センター サーバーに HSM セキュリティ モジュールを追加し、機密性の高い汎用ワークロードを保護する予定です。

Microsoft は、同社初のデータ処理ユニットである Azure Boost DPU も発表しました。この専用チップは、データ中心のワークロードを非常に効率的に処理します。この DPU を搭載した新しいサーバーは、電力使用量を 3 分の 2 削減し、現在のサーバーに比べて 4 倍のパフォーマンスを発揮します。

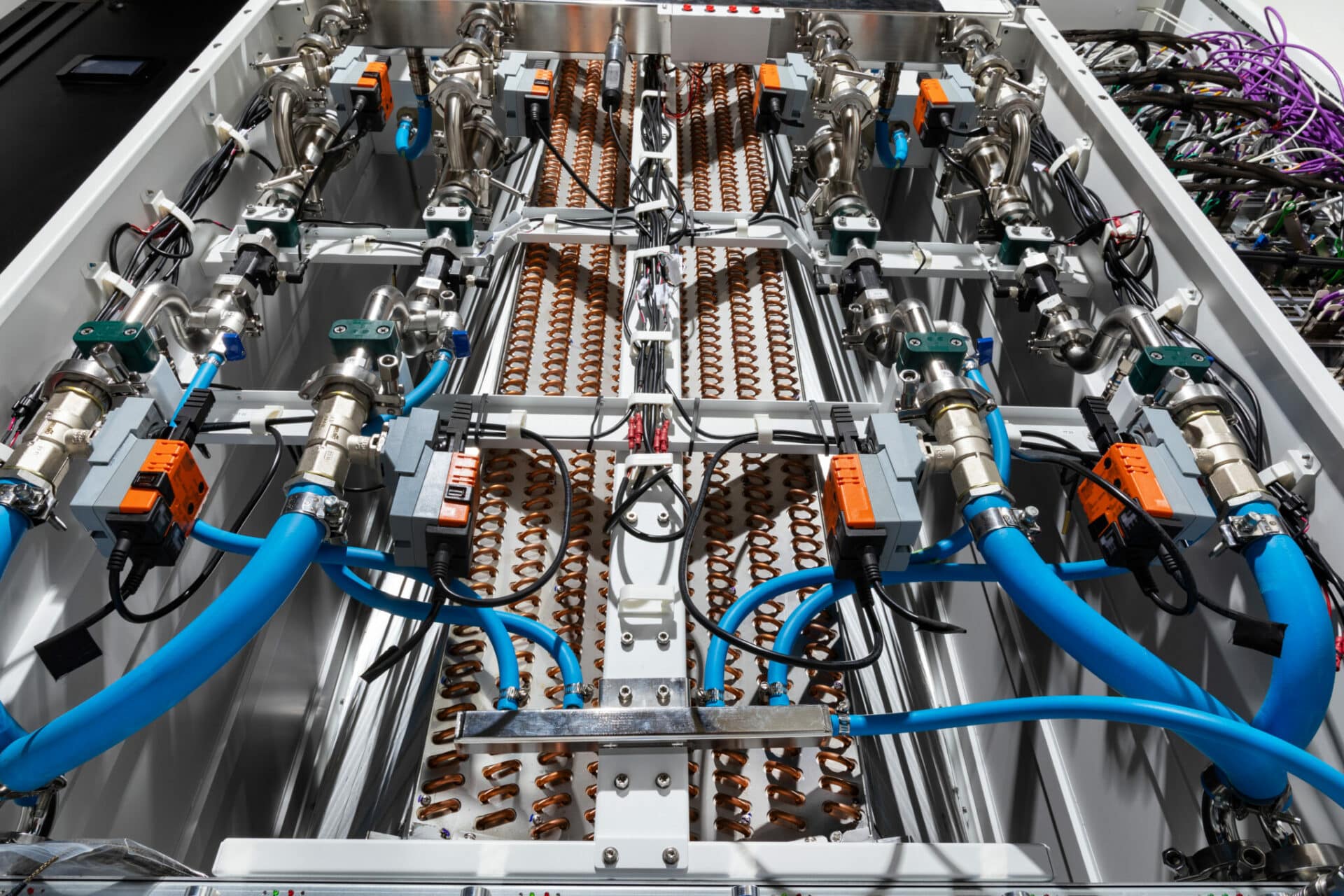

冷却および電力インフラ

Microsoft は、次世代の液体冷却「サイドキック」ラックを披露しました。この熱交換ユニットは、Azure データセンターに後付けして、NVIDIA の GB200 インフラストラクチャを含む大規模な AI システムをサポートできます。また、同社は Meta と連携して、400 ボルトの DC 電源を備えた分散型電源ラックの設計を行い、各サーバー ラックに最大 35% 多くの AI アクセラレータを搭載できるようにしました。

業界全体の進歩に向けて、Microsoft は Open Compute Project を通じてこれらの冷却および電源ラックの仕様をオープンソース化し、業界全体がこれらのイノベーションの恩恵を受けられるようにしています。

次世代AIとコンピューティングインフラストラクチャ

Azure の AI インフラストラクチャは、NVIDIA の H200 GPU を搭載した ND H5 V200 仮想マシン シリーズの導入により進化を続けています。このプラットフォームは、NVIDIA H100 と H200 GPU の間で業界のベンチマーク標準を XNUMX 倍上回る、目覚ましいパフォーマンスの向上を示しています。

Microsoft は、NVIDIA GB200 NVL 6 ラックスケール設計と Quantum InfiniBand ネットワークを組み込んだ、AI に最適化された新しい VM シリーズである Azure ND GB200 v72 も発表しました。この進歩により、数万の Blackwell GPU を接続して、大規模な AI スーパーコンピューティング パフォーマンスが可能になります。

CPU ベースのスーパーコンピューティングでは、カスタム AMD EPYC™ 5V9H プロセッサを搭載した新しい Azure HBv64 仮想マシンが、現在の代替品よりも最大 2025 倍高速なパフォーマンスを約束し、XNUMX 年にプレビュー版が利用可能になる予定です。

Azure コンテナー アプリと NVIDIA の統合

Azure Container Apps は NVIDIA GPU をサポートするようになり、簡素化されたスケーラブルな AI 展開が可能になりました。このサーバーレス コンテナー プラットフォームは、基盤となるインフラストラクチャを抽象化することで、マイクロサービス ベースのアプリケーションの展開と管理を簡素化します。秒単位の課金とゼロへのスケール機能により、お客様は使用したコンピューティングに対してのみ料金を支払い、経済的で効率的なリソース利用を実現します。

Azure 上の NVIDIA AI プラットフォームには、産業用 AI 向けの新しいリファレンス ワークフローと、AI を活用した臨場感あふれるビジュアルを作成するための NVIDIA Omniverse Blueprint が含まれています。産業オペレーションの 3D リモート モニタリング用のリファレンス ワークフローが近日中に提供され、開発者は産業システムの物理的に正確な 3D モデルを Azure IoT Operations および Power BI からのリアルタイム データに接続できるようになります。

RTX AI PCと高度なコンピューティング

NVIDIA は、現実世界と画面上の視覚イメージを理解するための新しいマルチモーダル SLM、NVIDIA Nemovision-4B Instruct を発表しました。まもなく RTX AI PC とワークステーションに導入されるこのテクノロジは、デジタル ヒューマン インタラクションのリアリティを高めます。

NVIDIA TensorRT Model Optimizer (ModelOpt) のアップデートにより、Windows 開発者は ONNX ランタイム展開用にモデルを最適化するための改善されたパスを利用できるようになりました。これにより、開発者は RTX GPU で高速化されるとより高速で正確な PC 用の AI モデルを作成できると同時に、ONNX ランタイムを使用して PC エコシステム全体に簡単に展開できるようになります。

600 を超える Windows アプリとゲームが、世界中の 100 億台を超える GeForce RTX AI PC 上で AI をローカルに実行し、高速で信頼性が高く、低遅延のパフォーマンスを実現しています。NVIDIA と Microsoft のコラボレーションにより、パーソナル コンピューティング デバイスのイノベーションが推進され、洗練された AI 機能が日常のユーザーにもたらされます。

Microsoft クラウドとハイブリッド インフラストラクチャ

マルチクラウドおよびハイブリッド ソリューションに対する Microsoft の取り組みは、現在世界中で 39,000 社を超える顧客にサービスを提供している Azure Arc に例証されています。新しい Azure Local は、AI 推論用の GPU サーバーを含む柔軟なオプションを備えた、安全なクラウド接続のハイブリッド インフラストラクチャを提供します。

Microsoft は、Azure Arc を活用してオンプレミスとクラウド環境全体でクラウド機能を提供する Windows Server 2025 と SQL Server 2025 も発表しました。SQL Server 2025 は、新しい組み込み AI 機能により AI アプリケーション開発が簡素化され、ベクター サポートによって RAG パターンがサポートされるなど、優れた特徴を備えています。

まとめ:

Microsoft の最近のイノベーションは、カスタム シリコン、AI インフラストラクチャ、ハイブリッド クラウド ソリューションの進歩に対する同社の取り組みを強調しています。Azure Integrated HSM や Azure Boost DPU などの画期的な開発により、Microsoft は安全で効率的、かつ高性能なデータ センター運用の新しいテンプレートを設定しています。次世代の冷却および電源テクノロジとオープン ソース イノベーションの導入は、業界のコラボレーションと持続可能性を促進するという Microsoft の取り組みを強調しています。

ND H200 V5 および ND GB200 v6 仮想マシンを含む Azure の AI およびコンピューティング インフラストラクチャの進化は、大規模な AI パフォーマンスを提供する Microsoft の能力を実証しています。一方、新しい HBv5 仮想マシンは、CPU ベースのスーパーコンピューティングのパフォーマンスを約束し、Azure がハイパフォーマンス コンピューティングのリーダーであり続けることを保証します。

最後に、Azure Arc の強力なハイブリッド機能と、SQL Server 2025 などの AI 強化ツールの導入により、Microsoft は、現代のワークロードの複雑さに対処するための柔軟でスケーラブルなソリューションを企業に提供しています。これらの進歩により、AI、クラウド、ハイブリッド インフラストラクチャの未来を推進するリーダーとしての Microsoft の地位が確固たるものになります。

StorageReview と連携する

ニュースレター | YouTube |ポッドキャスト iTunes/Spotifyは | Instagram | Twitter | TikTok | RSSフィード