NVIDIA GTC 2024 が登場しました。何年かぶりに個人的に戻ってきました。ジョーダンはイベントにライブで参加し、主要な AI イベントに関する最新ニュースと分析をすべて伝えます。

NVIDIA の GPU テクノロジ カンファレンス (GTC) が、仮想のみのイベントとして数年ぶりに再び開催されます。これは、イノベーター、研究者、科学者、テクノロジー愛好家にとって、テクノロジーの巨人の最新テクノロジーを見ることができる素晴らしいイベントです。テクノロジー コミュニティで待望されている今年の NVIDIA GTC 2024 では、AI、ディープラーニング、自動運転車、新しい Blackwell アーキテクチャの最新の進歩が紹介されます。

ここでは、NVIDIA の CEO、ジェンスン フアン氏の月曜日の基調講演のハイライトを紹介します。これは、NVIDIA の新しい Blackwell アーキテクチャ、ネットワーキング、量子コンピューティングの進歩、およびソフトウェア スタックの更新を取り囲んでいました。

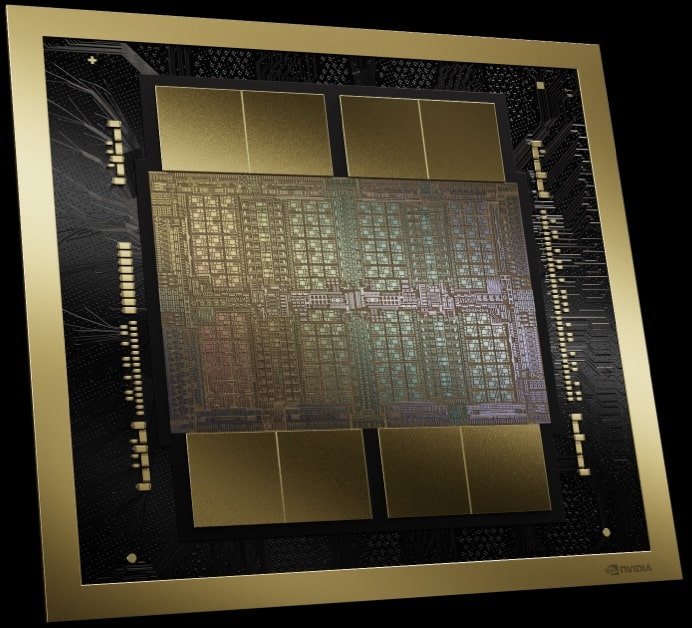

NVIDIA ブラックウェル

アクセラレーテッド コンピューティングを再定義する 6 つの画期的なテクノロジーが、Blackwell のイノベーションの中心となっています。データ処理の強化から医薬品設計の革新など、NVIDIA は新たな標準を確立しています。 Amazon や Microsoft などの著名な導入企業は、Blackwell の変革の可能性を期待してすでに列をなしています。

NVIDIA が達成したエンジニアリングの驚異を詳しく見てみましょう。 Blackwell GPU は、208 つのチップに 4 億個ものトランジスタを搭載しており、これは 10 レチクル制限の XNUMXNP TSMC プロセスを活用することで可能になりました。このアプローチは半導体製造の限界に挑戦し、XNUMXTB/秒の高速インターフェースでチップを接続する新しい方法を導入します。チップレット設計へのこの動きは、従来の境界を超えようとする NVIDIA の野心を反映しています。

| 製品仕様 | H100 | B100 | B200 |

| 最大メモリ | 80GB HBM3 | 192GBHBM3e | 192GBHBM3e |

| メモリ帯域幅 | 3.35TB /秒 | 8TB /秒 | 8TB /秒 |

| FP4 | – | 14PFLOPS | 18PFlops |

| FP6 | – | 7PFLOPS | 9PFLOPS |

| FP8/INT8 | 3.958PFLOPS/POPS | 7PFLOPS/POPS | 9PFLOPS/POPS |

| FP16/BF16 | 1979 TFLOPS | 3.5PFLOPS | 4.5PFLOPS |

| TF32 | 989 TFLOPS | 1.8PFLOPS | 2.2PFLOPS |

| FP64 | 67 TFLOPS | 30 TFLOPS | 40 TFLOPS |

| 最大電力消費量 | 700W | 700W | 1000W |

注: ここでのすべての数値は、疎行列計算のパフォーマンスを表します。

単にトランジスタをたくさん詰め込むだけではありません。 FP4 および FP6 コンピューティング機能の導入により、モデルのパフォーマンスに若干のトレードオフが生じますが、新しいレベルの効率的なモデル トレーニングがもたらされます。このトレードオフはプラットフォームの微妙な側面であり、効率と精度の間の複雑なバランスを反映しています。

Blackwell 内の第 4 世代のトランスフォーマー エンジンは、FP6 を使用する際のコンピューティング、帯域幅、モデル サイズの機能の飛躍的な向上を可能にし、将来の AI 開発にとって不可欠な改善をもたらします。さらに、PCIe Gen3 と新しい HBM1.8e メモリ テクノロジーの統合により、帯域幅が大幅に向上し、第 XNUMX 世代 NVLink と組み合わせると、帯域幅が前世代の XNUMX 倍の XNUMXTB/s という驚異的な値になります。

最も興味深い導入の 1 つは、大規模な AI 導入全体にわたって信頼性、可用性、保守性を強化する RAS エンジンです。このイノベーションにより、モデルのフロップ使用率が大幅に向上し、AI アプリケーションのスケーリングにおける重要な課題の 1 つが解決される可能性があります。

NVIDIA は Blackwell により、業界初の信頼できる実行環境 (TEE) I/O 対応 GPU などの新しい機密コンピューティング機能をもたらし、TEE を CPU を超えて GPU まで拡張します。これにより、生成 AI のトレーニングに不可欠なプライベート データの安全かつ高速な処理が保証されます。この革新は、プライバシー規制や機密情報を扱う業界にとって特に重要です。 NVIDIA Blackwell の Confidential Computing は、パフォーマンスを損なうことなく比類のないセキュリティを提供し、非暗号化モードとほぼ同等のスループットを提供します。この進歩により、大規模な AI モデルが保護されるだけでなく、機密の AI トレーニングとフェデレーテッド ラーニングが可能になり、AI の知的財産が保護されます。

NVIDIA Blackwell の解凍エンジンは、データ分析とデータベース ワークフローの大きな進歩を示します。このエンジンは、最大 800GB/秒という驚異的な速度でデータを解凍できるため、データ分析のパフォーマンスが大幅に向上し、洞察が得られるまでの時間が短縮されます。 8TB/秒の HBM3e メモリと高速 NVLink-C2C インターコネクトと連携してデータベース クエリを高速化し、クエリ ベンチマークにおいて Blackwell は CPU よりも 18 倍、以前の NVIDIA GPU よりも 6 倍高速になりました。このテクノロジーは最新の圧縮形式をサポートし、NVIDIA Blackwell をデータ分析と科学の強力な企業として位置づけ、エンドツーエンドの分析パイプラインを大幅に高速化します。

技術的な驚異にもかかわらず、特に詳細な消費電力データが不足していることを考えると、LLM 推論の運用コストとエネルギーを最大 25 倍削減するという NVIDIA の主張は眉をひそめます。この主張は注目に値するものではありますが、その影響を完全に評価するためにさらに明確にすることが有益となる可能性があります。

要約すると、NVIDIA の Blackwell プラットフォームは、AI とコンピューティングの可能性の限界を押し上げるという同社の絶え間ない追求の証です。革新的なテクノロジーと野心的な目標を持つ Blackwell は単なる一歩ではなく、大きな飛躍を遂げており、さまざまな業界にわたってさまざまな進歩を促進することを約束しています。加速コンピューティングと生成 AI のこの時代をさらに深く掘り下げると、NVIDIA のイノベーションが次の産業革命の触媒となる可能性があります。

NVIDIA ブラックウェル HGX

Blackwell アーキテクチャを採用して、NVIDIA は HGX サーバーとベースボード シリーズを刷新しました。以前のモデルからのこの大幅な進化は、魅力的な変化をもたらし、パフォーマンスを大幅に向上させながら総所有コストを大幅に削減します。この比較は驚くべきもので、FP8 と FP4 を比較すると、驚くべき 4.5 倍のパフォーマンス向上が見られます。 FP8 を前世代と同じにした場合でも、パフォーマンスはほぼ 8 倍になります。これは単なる速度の問題ではありません。これはメモリ効率の飛躍的な進歩であり、総メモリ帯域幅が XNUMX 倍に増加していることを示しています。

| 製品仕様 | HGX H100 | HGX H200 | HGX B100 | HGX B200 |

| 最大メモリ | 640GB HBM3 | 1.1TB HBM3e | 1.5TB HBM3e | 1.5TB HBM3e |

| メモリ帯域幅 | 7.2TB /秒 | 7.2TB /秒 | 8TB /秒 | 8 TB /秒 |

| FP4 | – | – | 112PFLOPS | 144PFLOPS |

| FP6 | – | – | 56PFLOPS | 72PFLOPS |

| FP8/INT8 | 32PFLOPS/POPS | 32PFLOPS/POPS | 56PFLOPS/POPS | 72PFLOPS/POPS |

| FP16/BF16 | 16PFLOPS | 16PFLOPS | 28PFLOPS | 36PFLOPS |

NVIDIA グレース-ブラックウェル スーパーチップ

Blackwell プラットフォームの武器の基礎である GB200 に焦点を当て、NVIDIA の最新の発表の複雑さをより深く掘り下げます。 NVIDIA がハイパフォーマンス コンピューティングの限界を押し広げ続ける中、GB200 は GPU 製品の大幅な進化を表し、最先端のテクノロジーと接続性と拡張性の戦略的進歩を融合させています。 GB200 には 200 つの B200 GPU が搭載されています。この構成は、GPU と Grace CPU の間の 200 対 900 接続を特徴とする前世代の GH2 とは異なります。今回は、両方の BXNUMX GPU が XNUMX GB/秒のチップ間 (CXNUMXC) リンクを介して同じ Grace CPU にリンクされています。

| 製品仕様 | GH200 | GB200 |

| 最大メモリ | 144GBHBM3e | 384GBHBM3e |

| メモリ帯域幅 | 8TB /秒 | 16TB/秒 (合計) |

| FP4 | – | 40PFLOPS |

| FP6 | – | 20PFLOPS |

| FP8/INT8 | 3.958PFLOPS/POPS | 20PFLOPS |

| FP16/BF16 | 1979 TFLOPS | 10PFLOPS |

| TF32 | 989 TFLOPS | 5PFLOPS |

| FP64 | 67 TFLOPS | 90 TFLOPS |

| PCIeレーン | 4x PCIe Gen 5 x16 | 2x PCIe Gen 6 x16 |

| 最大電力消費量 | 1000W | 2700W |

# 注: ここでのすべての数値は、疎行列計算のパフォーマンスを表します。

一見すると、前世代の 900GB/秒 C2C リンクを維持するという決定は制限のように思えるかもしれません。ただし、この設計の選択は、新しいレベルの拡張性への道を切り開きながら、既存のテクノロジーを活用するための計算された戦略を強調しています。 GB200 のアーキテクチャでは、第 576 世代 NVLink のおかげで、最大 1.8 個の GPU と XNUMXTB/秒の速度で通信できます。このレベルの相互接続は、最大かつ最も複雑な AI モデルのトレーニングとデプロイに必要な大規模並列コンピューティング環境を構築するために不可欠です。

NVIDIA ネットワーク スタックのアップデート

GB200 と NVIDIA の最新ネットワーキング テクノロジ、Quantum-X800 InfiniBand および Spectrum-X800 Ethernet プラットフォームの統合 接続と帯域幅に関して興味深い疑問が生じます。 800Gb/s 機能についての言及は、NVIDIA が PCIe Gen6 がもたらすメリットを検討していることを示唆しています。

デュアル GPU セットアップと高度なネットワーク オプションを備えた GB200 構成は、HPC の将来に対する NVIDIA のビジョンを表しています。このビジョンは、個々のコンポーネントの本来の能力だけではなく、これらのコンポーネントを一貫したスケーラブルなシステム内でどのように調整できるかについても目指しています。 NVIDIA は、より高度な相互接続を可能にし、計算能力とデータ転送速度のバランスを維持することにより、AI 研究開発における最も重要な課題のいくつか、特に急激に増大するモデル サイズと計算需要への対応に取り組んでいます。

NVIDIA 第 5 世代 NVLink および NVLink スイッチ

第 5 世代 NVLink は、ハイ パフォーマンス コンピューティングと AI における重要なマイルストーンを示します。このテクノロジーは、GPU 間の接続と通信の能力を強化します。これは、AI の基礎モデルの急速に進化する要求にとって重要な側面です。

第 576 世代 NVLink は、GPU 接続容量を 256 GPU に増強し、以前の XNUMX GPU の制限から大幅に増加しました。この拡張には、以前のバージョンと比較して帯域幅が XNUMX 倍になり、ますます複雑になる基礎的な AI モデルのパフォーマンスにとって重要な強化が加えられています。

Blackwell GPU の各リンクは、Hopper GPU と同様に 50 つの高速差動ペアを備えていますが、リンクごとに各方向で 18 GB/秒の有効帯域幅を実現します。これらの GPU には 1.8 個の第 14 世代 NVLink リンクが装備されており、合計 5 TB/秒という驚異的な帯域幅を提供します。このスループットは、現在の PCIe Gen XNUMX のスループットの XNUMX 倍以上です。

もう 130 つの注目すべき機能は、モデルの並列処理に不可欠な、単一の 72 GPU NVLink ドメイン (NVL72) で 8 TB/秒の GPU 帯域幅をサポートする NVIDIA NVLink スイッチです。このスイッチは、新しい NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP) FPXNUMX サポートにより、帯域幅効率も XNUMX 倍向上します。

さらに、NVIDIA Unified Fabric Manager (UFM) は、NVLink コンピューティング ファブリックに堅牢で実績のある管理を提供することで、NVLink スイッチを補完します。

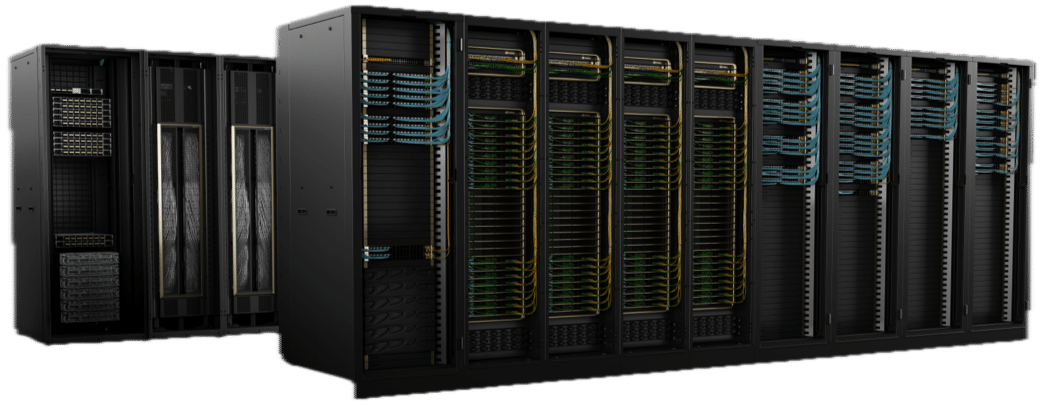

ラック内のエクサスケール コンピューティング

前世代の GraceHopper GH200 NVL32 によって築かれた強力な基盤の上に構築された DGX GB200 NVL72 は、単なるアップグレードではありません。これは、計算能力と効率の可能性を拡大するための基礎となる進歩です。 DGX GB200 NVL72 プラットフォームは、全体的に驚異的な進歩を示しています。各 DGX GB200 NVL72 システムは、18 個の GB200 SuperChip ノードで構成され、それぞれ 2 個の GB200 で構成されます。

このプラットフォームでは、GPU の数が 32 から 72 に 32 倍以上に増加し、CPU も 36 から 19.5 にわずかに増加しました。ただし、メモリの飛躍的な向上は注目に値し、30 TB から XNUMX TB まで大幅に増加しました。この拡大は、単により重要な数字に関するものではありません。それは、特に最も複雑な AI モデルとシミュレーションの処理において、新しい段階の計算能力を可能にすることです。

最も驚くべきアップグレードの 127 つは、計算パフォーマンスの飛躍的な向上です。 FP1.4 のパフォーマンスを比較すると、プラットフォームは 4 ペタ FLOPS から 11 ExaFLOPS にジャンプし、約 8 倍の増加を示しています。この比較は、特に AI と機械学習において、精度と速度の限界を押し上げるための NVIDIA の取り組みを浮き彫りにします。ただし、FP8 と FP5.6 を比較した場合でも、プラットフォームは 127PF から 720PF へ XNUMX 倍の増加を達成しており、効率と計算能力が大幅に向上していることがわかります。

完全水冷システムを維持するという取り組みは、持続可能性とパフォーマンスの最適化に対する NVIDIA の重点を反映しています。このアプローチにより、システムの運用効率が向上し、より環境に優しいデータセンター テクノロジを求める幅広い業界のトレンドに沿ったものになります。

NVIDIA GB200 Grace Blackwell スーパーチップを搭載した NVIDIA DGX SuperPOD

NVIDIA はまた、NVIDIA GB8 NVL200 Grace Blackwell システムを 72 台搭載した次世代 AI スーパーコンピューター DGX SuperPOD も発表しました。この強力なセットアップは、兆パラメータ モデルを処理するために設計されており、水冷ラックスケール アーキテクチャ全体で FP11.5 精度で 4 エクサフロップスの AI スーパーコンピューティング パワーを誇ります。各 GB200 NVL72 システムには 36 個の NVIDIA GB200 スーパーチップが含まれており、大規模な言語モデル推論ワークロードに対して、前世代の H30 と比べて 100 倍のパフォーマンス向上が約束されています。

NVIDIA の CEO であるジェンセン ファン氏によれば、DGX SuperPOD は「AI 産業革命の工場」になることを目指しています。

量子シミュレーションクラウド

NVIDIA は、研究者がさまざまな科学分野にわたって量子コンピューティングを探索できるようにする Quantum Simulation Cloud サービスも発表しました。オープンソースの CUDA-Q プラットフォームに基づいたこのサービスは、量子アルゴリズムとアプリケーションを構築およびテストするための強力なツールと統合を提供します。トロント大学と、Classiq や QC War などの企業とのコラボレーションは、量子コンピューティングのイノベーションを加速する NVIDIA の取り組みを強調しています。

NVIDIA NIM ソフトウェア スタック

もう 1 つの重要な発表は、数十のエンタープライズ グレードの生成 AI マイクロサービスを提供する NVIDIA NIM ソフトウェア スタックの発表でした。これらのサービスを使用すると、企業はプラットフォーム上でカスタム アプリケーションを作成して展開し、一般的な AI モデルの推論を最適化し、幅広いアプリケーション向けの NVIDIA CUDA-X マイクロサービスによる開発を強化できます。 Jensen Huang 氏は、これらのマイクロサービスがあらゆる業界の企業を AI を活用した組織に変える可能性を強調しました。

OVX コンピューティング システム

さまざまな業界における生成 AI の急速な成長に対応して、NVIDIA は、複雑な AI およびグラフィックスを多用するワークロードを合理化するように設計されたソリューションである OVX コンピューティング システムを導入しました。 AI 導入における高性能ストレージの重要な役割を認識し、NVIDIA は、DDN などの主要な貢献者とストレージ パートナー検証プログラムを開始しました。 デルのパワースケール、NetApp、Pure Storage、WEKA。

新しいプログラムは、パートナーがストレージ アプライアンスを検証するプロセスを標準化し、エンタープライズ AI ワークロードの最適なパフォーマンスとスケーラビリティを確保します。これらのストレージ システムは、厳格な NVIDIA テストを通じて、AI アプリケーションの困難な要件を反映するさまざまなパラメータに対して検証されています。

さらに、NVIDIA L40S GPU を搭載し、包括的なソフトウェアおよびネットワーキング ソリューションと統合された NVIDIA 認定の OVX サーバーは、さまざまなデータセンター環境に適合する柔軟なアーキテクチャを提供します。このアプローチは、データが存在するコンピューティングを高速化するだけでなく、生成 AI の固有のニーズにも応え、効率と費用対効果を保証します。 NVIDIA OVX サーバーには堅牢な GPU が装備されており、強化されたコンピューティング機能、高速ストレージ アクセス、低遅延ネットワーキングを提供します。これは、広範なデータ処理を必要とするチャットボットや検索ツールなどの要求の厳しいアプリケーションにとって特に重要です。

現在、GIGABYTE、Hewlett Packard Enterprise、Lenovo、Supermicro などのグローバル ベンダーから入手および出荷されている NVIDIA 認定 OVX サーバーは、複雑な AI ワークロードの処理において大幅な進歩を遂げ、エンタープライズ グレードのパフォーマンス、セキュリティ、およびスケーラビリティを約束します。

閉じた思考

さらに、自動車、ロボティクス、ヘルスケア、生成 AI の分野でも発表がありました。これらの発表はすべて、NVIDIA の絶え間ないイノベーションの追求を示しており、複数のドメインにわたって AI とコンピューティングの未来を推進する高度なツールとプラットフォームを提供しています。これらはすべて高度な技術的であり、特に量子コンピューティングやソフトウェア リリースの場合には多くの複雑さを伴います。これらの新しいリリースのそれぞれについてさらなる情報が得られ次第、発表に関する分析をお待ちください。

StorageReview と連携する

ニュースレター | YouTube |ポッドキャスト iTunes/Spotifyは | Instagram | Twitter | TikTok | RSSフィード