NVIDIA Hopper アーキテクチャは、AI データ センターの次の波を強化することに焦点を当て、NVIDIA GTC 中に中心的な舞台となりました。米国の先駆的なコンピューター科学者、グレース ホッパーにちなんで名付けられたこの次世代アクセラレーション コンピューティング プラットフォームは、前世代の NVIDIA Ampere よりも桁違いのパフォーマンスを提供します。

NVIDIA Hopper アーキテクチャは、AI データ センターの次の波を強化することに焦点を当て、NVIDIA GTC 中に中心的な舞台となりました。米国の先駆的なコンピューター科学者、グレース ホッパーにちなんで名付けられたこの次世代アクセラレーション コンピューティング プラットフォームは、前世代の NVIDIA Ampere よりも桁違いのパフォーマンスを提供します。

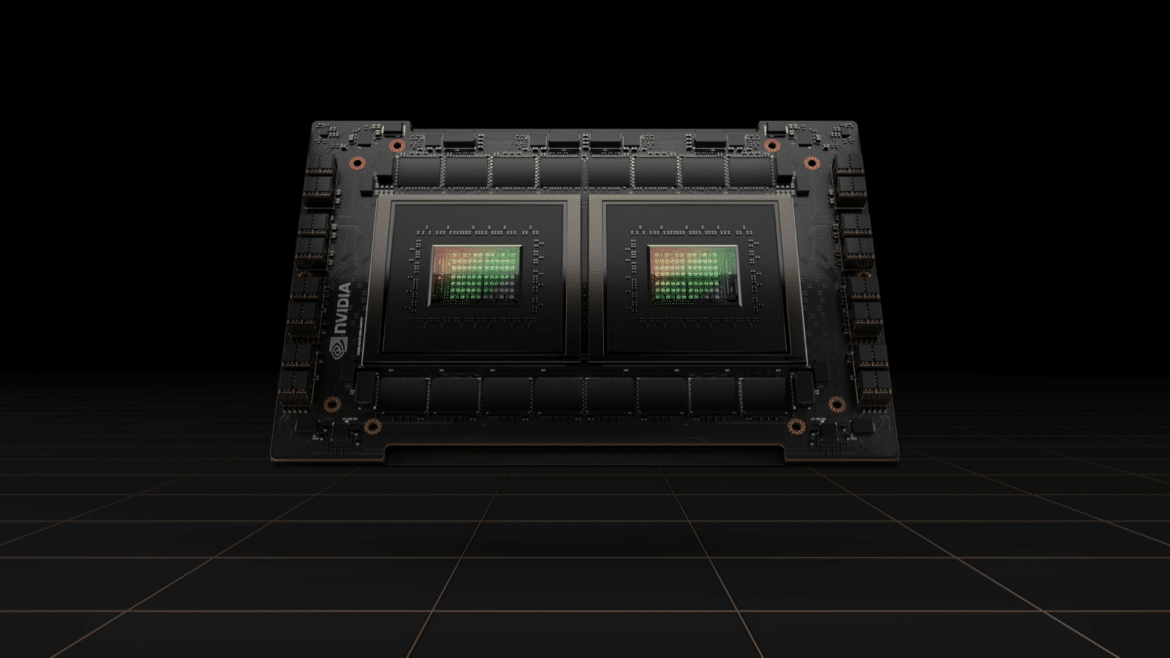

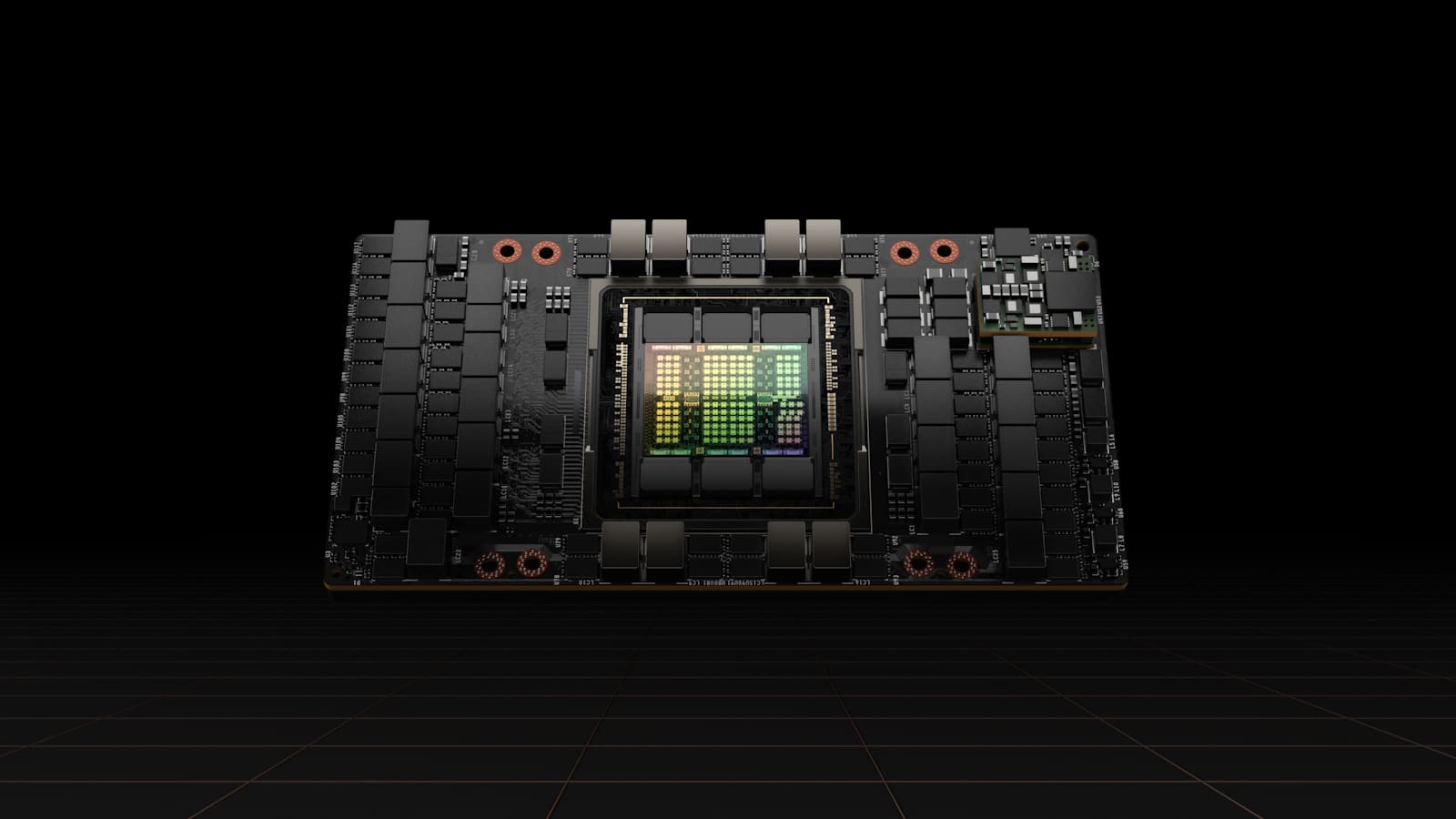

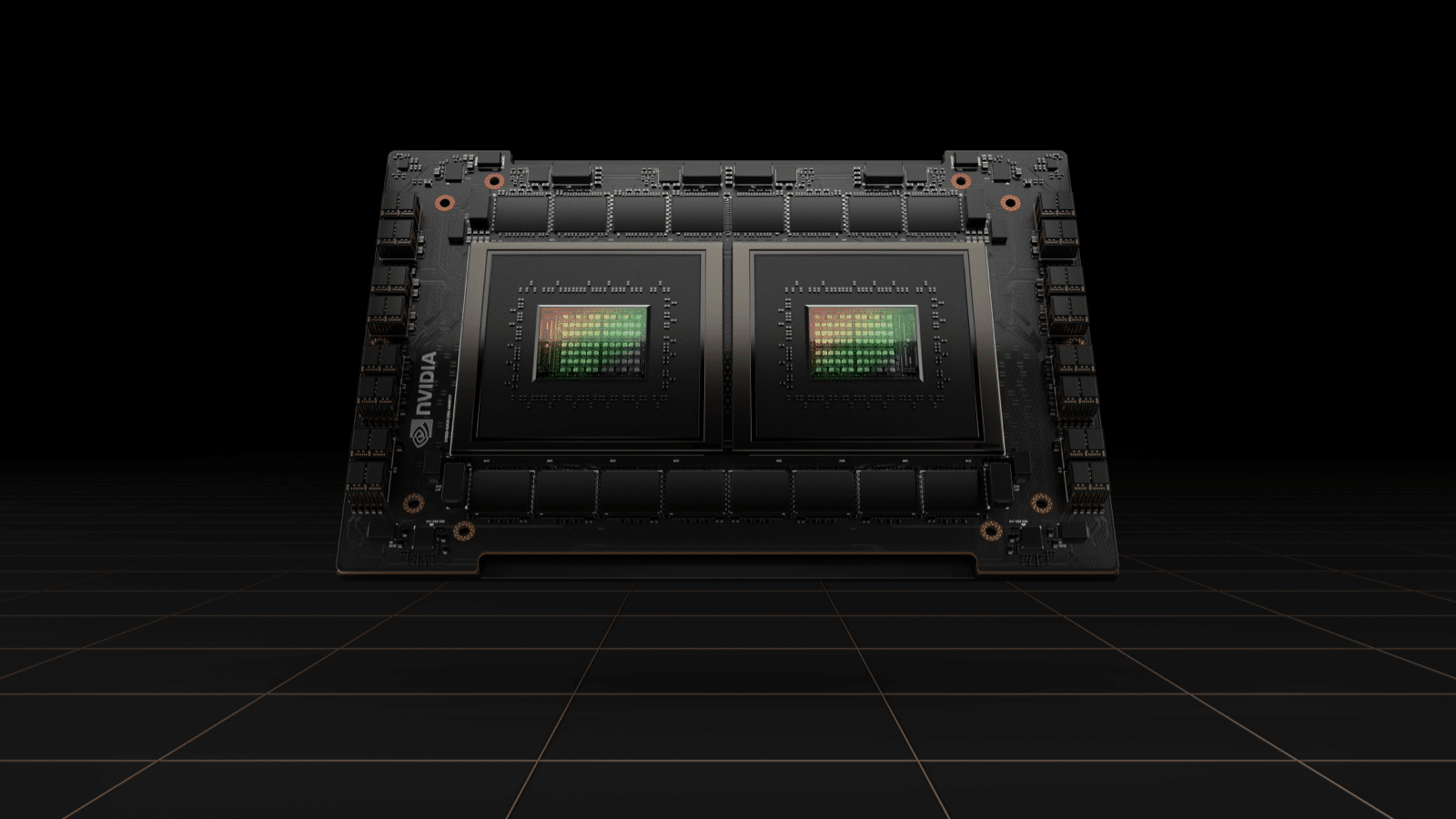

NVIDIA はまた、100 億個のトランジスタを搭載した初のホッパーベースの GPU、NVIDIA H80 も発表しました。世界最大かつ最も強力なアクセラレータとして宣伝されている H100 は、巨大な AI 言語モデル、ディープ レコメンダー システム、ゲノミクス、および複雑なデジタル ツインを進化させるための、Transformer Engine と拡張性の高い NVIDIA NVLink 相互接続を備えています。

NVIDIA の創設者兼 CEO のジェンセン フアン氏は、「データ センターは AI 工場になりつつあり、大量のデータを処理および精製してインテリジェンスを生成しています」と述べています。 「NVIDIA H100 は、企業が AI 主導のビジネスを加速するために使用する世界の AI インフラストラクチャのエンジンです。」

H100テクノロジー

H4 は、NVIDIA の高速化されたコンピューティング ニーズに合わせて設計された最先端の TSMC 100N プロセスを使用して構築されており、AI、HPC、メモリ帯域幅、相互接続、通信を高速化するための大幅な進歩を備えており、約 5TB/秒の外部接続が含まれます。 Hopper H100 は、PCIe Gen5 をサポートし、3TB/s のメモリ帯域幅を可能にする HBM3 (高帯域幅メモリ 3) を利用する最初の GPU です。 100 個の HXNUMX GPU は、全世界のインターネット トラフィックに相当する量を維持できるため、お客様は高度なレコメンダー システムと、リアルタイムでデータの推論を実行する大規模な言語モデルを提供できます。

自然言語処理の選択肢である Transformer Engine は、これまで発明された中で最も重要な深層学習モデルの 100 つです。 H6 アクセラレータのトランスフォーマー エンジンは、精度を損なうことなく、前世代と比較してこれらのネットワークを XNUMX 倍高速化するように構築されています。

マルチインスタンス GPU (MIG) テクノロジーを使用するホッパー アーキテクチャにより、単一の GPU を 7 つのより小さい完全に分離されたインスタンスに分割して、さまざまな種類のジョブを処理できます。 MIG 機能を前世代に比べて最大 XNUMX 倍拡張することにより、Hopper アーキテクチャはクラウド環境で各 GPU インスタンスにわたる安全なマルチテナント構成を提供します。

H100 は、処理中に AI モデルと顧客データを保護する機密コンピューティング機能を備えた世界初のアクセラレータです。また、医療、金融サービス、共有クラウド インフラストラクチャなど、プライバシーに敏感な業界向けのフェデレーテッド ラーニングに Confidential Computing を適用することもできます。

第 4 世代 NVIDIA NVLink は、サーバーを超えたスケールアップ ネットワークとして拡張する新しい外部 NVLink スイッチと結合し、NVIDIA HDR Quantum InfiniBand を使用して前世代と比較して 256 倍高い帯域幅で最大 100 個の H9 GPU を接続します。

NVIDIA H100 は、オンプレミス、クラウド、ハイブリッド クラウド、エッジを含む事実上すべてのデータ センターに導入でき、今年後半に利用可能になる予定です。

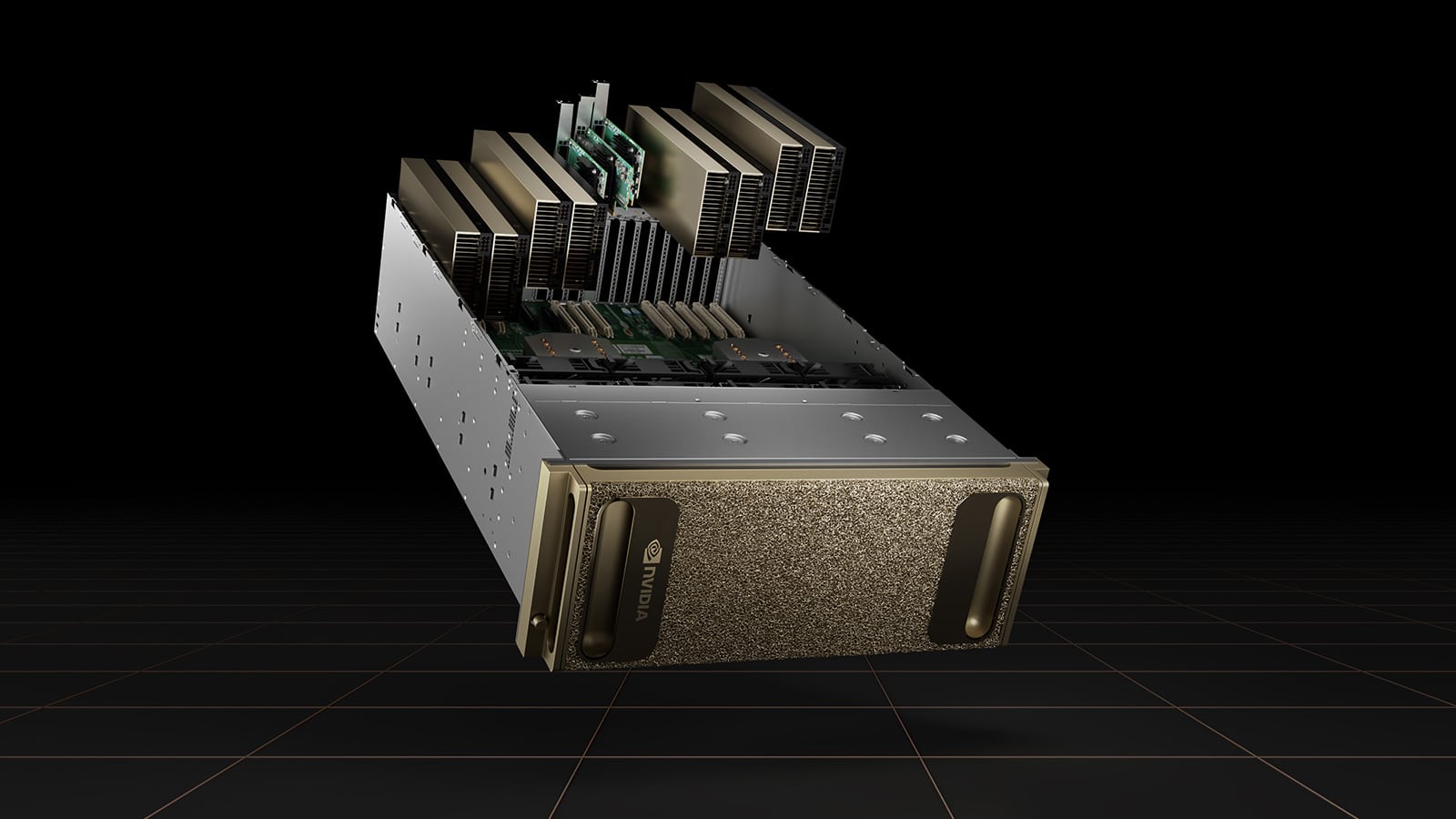

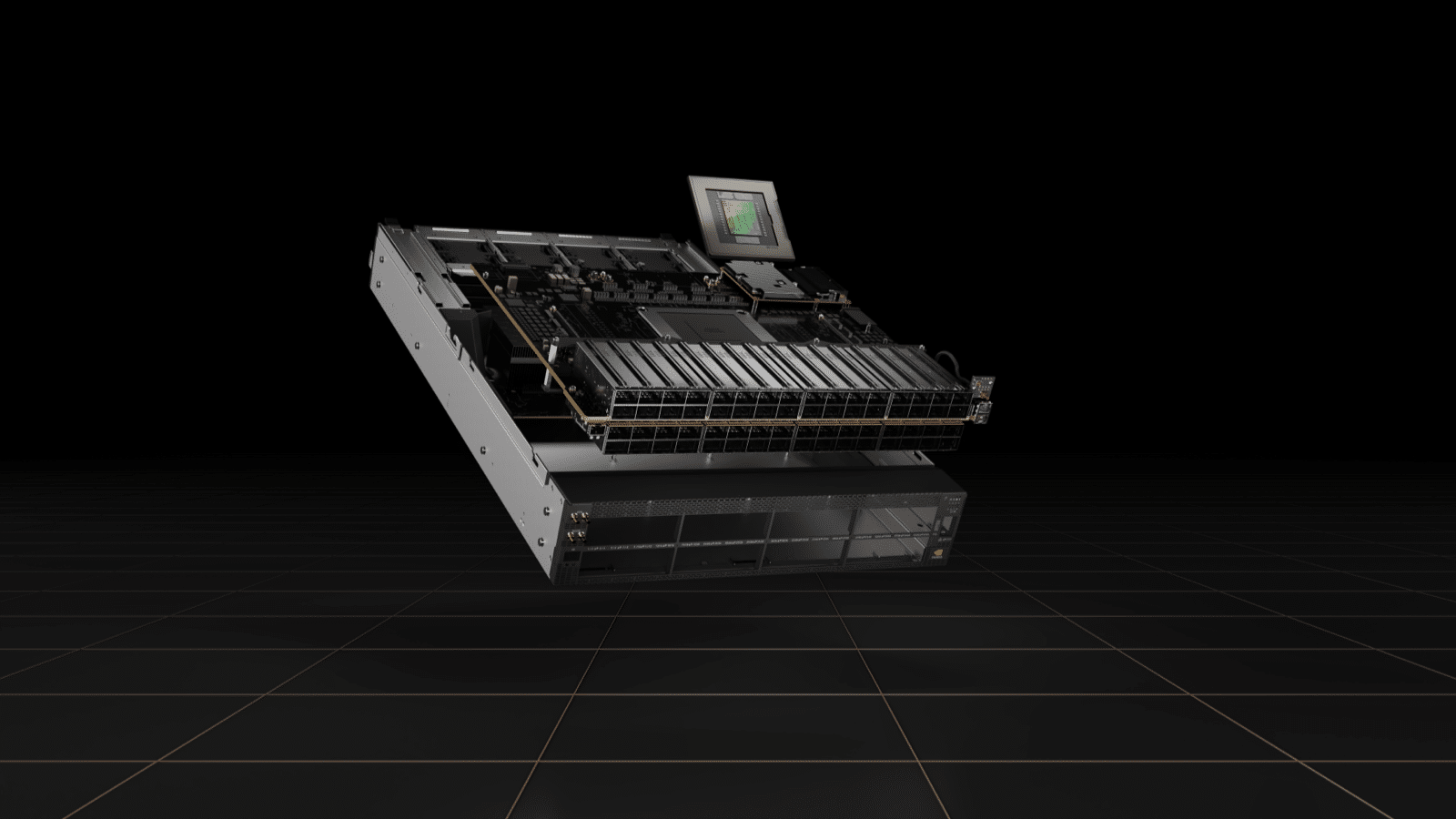

DGX H100 システム

NVIDIA は、100 つの H100 GPU を搭載し、新しい FP32 精度で 8 ペタフロップスの AI パフォーマンスを実現する第 XNUMX 世代 DGX システム DGX HXNUMX を発表しました。これにより、大規模な言語モデル、レコメンダー システム、ヘルスケア研究、気候科学の大規模なコンピューティング要件を満たすスケールが提供されます。 。

各 DGX H100 システムには 100 つの H900 GPU が搭載されており、第 1.5 世代 NVLink によって XNUMX つとして接続され、前世代の XNUMX 倍となる XNUMX GB/秒の接続を実現します。 NVIDIA の NVLink は、低遅延、ロスレスの GPU 間相互接続であり、リンクレベルのエラー検出やパケット再生メカニズムなどの復元機能を備え、データ配信の成功を保証します。

第 100 世代 NVLink に加えて、H256 には新しい NVLink ネットワーク インターコネクトも導入されています。このスケーラブルなバージョンの NVLink により、複数のコンピューティング ノード間で最大 64 個の GPU の GPU 間通信が可能になります。 NVIDIA はまた、サーバー、クラスター、データセンター環境で複数の GPU を接続するためのノードの内側と外側の両方にスイッチを含む第 7.2 世代 NVSwitch テクノロジーも導入しました。新しい NVSwitch を搭載したノードは、マルチ GPU 接続を高速化するために 13.6 ポートの NVLink を提供し、スイッチの総スループットを 100 Tbit/s から 32 Tbit/s にほぼ 100 倍にします。 NVSwitch を使用すると、XNUMX つの HXNUMX GPU すべてが NVLink 経由で接続できるようになります。外部 NVLink スイッチは、次世代 NVIDIA DGX SuperPOD スーパーコンピュータの最大 XNUMX 台の DGX HXNUMX ノードをネットワーク接続できます。

Grace CPU スーパーチップ

NVIDIA は、144 つのソケットに XNUMX 個の Arm コアを搭載した Grace CPU スーパーチップを発表しました。これは、AI インフラストラクチャとハイパフォーマンス コンピューティング向けに設計された初の Arm Neoverse ベースのディスクリート データセンター CPU であり、XNUMX 倍のメモリ帯域幅とエネルギー効率を実現します。

メモリ サブシステムは、速度と消費電力のバランスをとるためのエラー訂正コードを備えた LPDDR5x メモリで構成されています。 LPDDR5x メモリ サブシステムは、消費電力を大幅に削減しながら、従来の DDR5 設計の帯域幅を 1 TB/秒で XNUMX 倍にします。

Grace CPU スーパーチップは、NVIDIA RTX、NVIDIA HPC、NVIDIA AI、Omniverse など、NVIDIA のコンピューティング ソフトウェア スタックをすべて実行します。 Grace CPU スーパーチップと NVIDIA ConnectX-7 NIC は、スタンドアロンの CPU のみのシステムとして、または XNUMX、XNUMX、XNUMX、または XNUMX 個のホッパーベースの GPU を備えた GPU アクセラレーション サーバーとしてサーバーに構成できる柔軟性を提供し、お客様がパフォーマンスを最適化できるようにします。単一のソフトウェア スタックを維持しながら、特定のワークロードに対応します。

オムニバースコンピューティングシステム

データセンターに焦点を当て続け、NVIDIA は、大規模なデジタル ツインを強化するために設計されたコンピューティング システムである NVIDIA OVX を発表しました。デジタル ツインは、物理世界に接続された仮想世界です。 NVIDIA OVX は、リアルタイムの物理的に正確なワールド シミュレーションおよび 3D 設計コラボレーション プラットフォームである NVIDIA Omniverse 内で実行される複雑なデジタル ツイン シミュレーションを操作するように設計されています。

OVX システムは、高性能の GPU アクセラレーションによるコンピューティング、グラフィックス、AI と低遅延の高速ストレージ アクセスを組み合わせることで、現実世界の精度でデジタル ツインを作成するために必要なパフォーマンスを提供します。 OVX は、建物、工場、都市、世界をモデル化するための複雑なデジタル ツインをシミュレートできます。

OVX サーバーには、40 個の NVIDIA A6 GPU、200 個の ConnectX-1 DX 16Gbps NIC、32TB メモリ、および 3TB NVMe ストレージが含まれています。 OVX システムは、XNUMX 台の OVX サーバーからなる単一ポッドから、NVIDIA Spectrum-XNUMX スイッチまたは複数の OVX SuperPOD を介して接続された XNUMX 台のサーバーを備えた OVX SuperPOD まで拡張できます。

Jetson AGX Orin 開発者キット

NVIDIA はまた、高度なロボット工学、自律マシン、次世代の組み込みコンピューティングおよびエッジ コンピューティング向けのコンパクトでエネルギー効率の高い AI スーパーコンピューターである Jetson AGX Orin 開発者キットの入手可能性を発表しました。 Jetson AGX Orin のスペックは素晴らしく、手のひらサイズのフォーム ファクターを維持しながら、前モデルの 275 倍を超える処理能力である 8 秒あたり 78 兆回の演算を実現します。 NVIDIA Ampere アーキテクチャ GPU、Arm Cortex-AXNUMXAE CPU、次世代ディープラーニングおよびビジョン アクセラレータ、より高速なメモリ帯域幅、高速インターフェイス、マルチモーダル センサーを備えた Jetson AGX Orin は、複数の同時 AI アプリケーション パイプラインにフィードを提供できます。

Jetson AGX Orin を使用しているお客様は、ライブラリ、ツール、テクノロジのコレクションに対する 60 のアップデートを含む、NVIDIA CUDA-X アクセラレーション コンピューティング スタックを完全に活用できます。また、NVIDIA JetPack SDK、NVIDIA NGC カタログの事前トレーニング済みモデル、アプリケーション開発と最適化のための最新のフレームワークとツール (NVIDIA Isaac on Omniverse、NVIDIA Metropolis、NVIDIA TAO Toolkit など) にも完全にアクセスできます。

NVIDIA スペクトラム-4

NVIDIA はデータセンターに引き続き注力し、NVIDIA Spectrum-4 イーサネット プラットフォームを発表しました。次世代スイッチは、前世代に比べて 400 倍高いスイッチング スループットで 4 Gbps のエンドツーエンドを実現します。 Spectrum-4 には、ConnectX-7 SmartNIC、BlueField-3 DPLU、および DOCA データセンター インフラストラクチャ ソフトウェアが含まれています。

AI 向けに構築された Spectrum-4 スイッチは、ナノ秒の精度を実現し、前世代と比べてポートごとの帯域幅が 2 倍高速になり、スイッチの数が 4 倍減り、消費電力が 40% 削減されることで、ネットワーク ファブリックの高速化、簡素化、安全性を確保します。 51.2 Tbps の合計 ASIC 帯域幅サポート、128 ポートの 400GBE、適応ルーティング、および強化された輻輳制御メカニズムを備えた Spectrum-4 は、コンバージド イーサネット ファブリック上の RDMA を最適化し、データ センターを劇的に高速化します。

包む

NVIDIA の GTC イベントには、ソフトウェア、パフォーマンス、速度に関する新製品のアップデートが満載でした。データセンターに重点を置いていますが、自律移動ロボット (AMR) の対象者、そしてもちろんエッジにも取り組んでいます。ショーのハイライトは Hopper H100 GPU でしたが、その XNUMX つの製品が他の多くの発表と結びついていました。 NVIDIA はすべてのプレス リリースとブログ ハイライトを掲載しました こちら一見の価値があります。

StorageReview と連携する

ニュースレター | YouTube |ポッドキャスト iTunes/Spotifyは | Instagram | Twitter | Facebook | TikTok | RSSフィード