SAS 616iSD 10G は、JetStor が提供するブロックレベルのストレージ アレイの広範な製品ラインの一部です。 iSCSI 616iSD は、48U エンクロージャ内の 16 個の 3.5 インチ ベイを介して最大 3 TB のストレージを提供します。 JetStor は、デュアル冗長アクティブ/アクティブ RAID コントローラーと 10 つの 342GbE ポート (コントローラーごとに 64 つ) を備えています。各コントローラーは、Intel IOP48 616 ビット Chevelon デュアルコア ストレージ プロセッサを搭載しており、パリティ アシスト ASIC、iSCSI アシスト エンジン、TCP オフロード エンジン (TOE) などの機能を備えています。 716TB では不十分な場合は、240iSD を XNUMX つの JBOD シェルフ (SASXNUMXJ) で拡張して、アレイあたり最大 XNUMXTB の容量を実現できます。

JetStor SAS 616iSD 10G は、その性質上、シンプルになるように設計されています。電源を入れて、イーサネット ファブリックへのアクセスを許可すると、すぐに電源が切れます。 JetStor の設計のシンプルさは全体にわたって機能しており、内部にはケーブルレス設計などの機能が備わっており、おそらくこれまで見たことはありませんが、何か問題が発生した場合のサービスがさらに容易になります。このユニットには、デュアル電源、ターボ冷却ファン、およびユニットの耐用期間中、すべてのコンポーネントに電話および電子メールによるサポートを提供する XNUMX 年間の保証も含まれています。

Jetstor SAS 616iSD 10G 仕様

- ホスト ポート: iSCSI プロトコルを使用した 10 つの XNUMX ギガビット イーサネット、冗長コントローラごとの SFP+ ホスト インターフェイス

- ディスクインターフェイス: 3Gb/s SAS

- 提供されるハードドライブ: 300GB (15k)、450GB (15k)、 600GB SAS (15k)、1TB (7.2k)、2TB (7.2k)、3TB (7.2k)

- ドライブ: 16 (3.5 インチ)/160 つの 3Gb/s SAS 拡張ポートにより最大 XNUMX

- サポートされる RAID モード: RAID 0、0+1、1、3、5、6、10、30、50、および RAID 60、グローバル ホット スペア ディスク、自動再構築

- 各コントローラー上の Intel IOP342 64 ビット Chevelon デュアルコア ストレージ プロセッサ

- 2GB キャッシュ (デフォルト) – 4GB (オプション) / DDR2-800 ECC 登録 SDRAM

- オプションのバッテリーバックアップ

- 45 つの RJXNUMX/イーサネット管理/モニター ポート

- SMTPマネージャーとSNMPエージェント

- 電源と冷却

- 4 つのターボファン

- 電源 110 または 220 VAC、±20% @ 6 アンペア / 3 アンペア ピーク

- PFC 付き 460W PS/ファン モジュール XNUMX 個

- 環境

- 相対湿度 10% ~ 85%、結露なし (動作時)

- 動作温度50°Fから104°F

- 3U 物理寸法 (幅 x 奥行き x 高さ) 幅 19 インチ、奥行き 22 インチ、高さ 5.25 インチ

- 重量 (ドライブなし) 40 ポンド / 18 kg。

- サポートされるオペレーティング システム: VMWare ESX Server、vSphere、Windows Server 2008、Windows Server 2003、XenServer、Oracle/Solaris、Linux、MAC OS X、その他は今後発表予定

- 保証: ロジック 3 年、電源 3 年、SAS ドライブ 5 年、SATA ドライブ 3 年または 5 年

設計と構築

JetStor SAS 616iSD は、16 ベイ 10GbE を備えたデュアル コントローラー SAN です。 616iSD の前面には、Web ベースの管理に使用する IP を追跡するためにルーターや DHCP に飛び込む必要がなく、現在の管理 IP などの情報が表示される基本的なユーザー インターフェイスが備えられています。フロント コンソールには LCD と、メニューをドリルダウンしてローカルで SAN にアクセスするためのいくつかのボタンが含まれています。 JetStor モデルのハードウェア面を管理するには、表面全体を跳ね上げて、その下にある 3.5 個の XNUMX インチ ドライブ ベイにアクセスするだけです。

私たちのレビュー JetStor SAS 616iSD 10G には XNUMX 個が含まれています Seagate チーター 15K.7 ST3600057SS 600GB ただし、システムはさまざまな 15K および 7,200 RPM ドライブで構成できます。各ドライブは独自のホットスワップ キャディにマウントされているため、ドライブに障害が発生した場合でも簡単に交換できます。各ドライブ トレイには、実稼働環境で誤って間違ったドライブが取り出されるのを防ぐための基本的なロック機構も含まれています。

SAS 616iSD 10G を簡単にラックマウントできるように、JetStor には数分で簡単にセットアップできる基本的な非スライド レール キットが含まれています。 SAN の重量は「チームリフト」の範疇に入る可能性が高いため、レールを取り付けた後、SAN をラックに持ち上げるのに手伝ってもらうのが最善です。レールは受け取りスロットに簡単に差し込むことができ、しっかりと固定されます。 イートン 42U ラック 一度取り付けるとたるみの兆候はありません。

JetStor SAS 616iSD 10G の背面から見た図には、冗長ディスク コントローラーと電源が示されています。これらはどちらもつまみネジで素早く取り外すことができ、内蔵のレバーとハンドル機構を使用して、取り外しと所定の位置へのしっかりとしたラッチの両方を行います。背面のインターフェイス接続には、コントローラーごとに 8088 つの SFP+ 接続 (レビュー ユニットでは、それぞれの 716 つのポートに光ファイバー トランシーバーが取り付けられています)、コントローラーごとに 232 つの管理ポート、および外部 JBOD 拡張用にコントローラーごとに XNUMX つの SFF-XNUMX SAS コネクタが含まれます。 SASXNUMXJを使用。他の機器との通信を可能にする UPS および RS-XNUMX コネクタもあります。

万が一、コントローラの交換が必要になった場合でも、ラックに取り付けたアセンブリを取り外して再度挿入するのに 60 秒もかかりませんでした。ロック レバーにはつまみネジが付いていますが、JetStor では、すべてがしっかりと取り付けられていることを確認するために、フィールド技術者がマイナス ドライバーでネジを締めることを推奨しています。

電源の取り外しと再取り付けも同様に簡単でしたが、サイズが大きいため、テスト ラックの背面にある周囲のケーブルや機器を片付けるにはより慎重な作業が必要でした。

SAS 616iSD を構成するために提供される JetStor Web 管理ツールは理解しやすいですが、設計と実装の点ではかなり基本的です。最初のログインから、システムを操作するのは非常に簡単でしたが、インターフェイスが時々遅く見えることがありました。 SMB または小規模のエンタープライズ環境の場合、これらのプラットフォームをいくつかまとめて管理するのは簡単ですが、少数を超える環境では、各デバイスにログインして個別に構成する必要があるため、問題が発生する可能性があります。

テストの背景と比較対象

エンタープライズ ハードウェアのテストに関しては、その評価に使用されるテスト プロセスと同じくらい環境が重要です。 StorageReview では、テスト対象のデバイスが最終的に使用される多くのデータセンターと同じハードウェアとインフラストラクチャを提供しています。これには、エンタープライズ サーバーに加え、ネットワーク、ラック スペース、電源調整/監視、デバイスのパフォーマンスを適切に評価するための同クラスの同等のハードウェアなどの適切なインフラストラクチャ機器が含まれます。私たちのレビューはいずれも、私たちがテストしている機器のメーカーによって支払われたり、管理されたりするものではありません。

StorageReview エンタープライズ テスト ラボの概要

StorageReview 10GbE エンタープライズ テスト プラットフォーム:

- 2 x Intel Xeon X5650 (2.66GHz、12MB キャッシュ)

- Windows Server 2008 Standard Edition R2 SP1 64 ビットおよび CentOS 6.2 64 ビット

- インテル 5500+ ICH10R チップセット

- メモリ – 8GB (2 x 4GB) 1333Mhz DDR3 レジスタード RDIMM

Mellanox SX1036 10/40Gb イーサネット スイッチおよびハードウェア

- 36 個の 40GbE ポート (最大 64 個の 10GbE ポート)

- QSFP スプリッタ ケーブル 40GbE ~ 4x10GbE

- Mellanox ConnectX-3 EN PCIe 3.0 ツイン 10G イーサネット アダプター

当社の現在の 10/40Gb イーサネット SAN および NAS テスト インフラストラクチャは、Mellanox の 240 ポート 3/36GbE スイッチを介して接続された Mellanox ConnectX-10 PCIe アダプターを備えた Lenovo ThinkServer RD40 テスト プラットフォームで構成されています。この環境では、ネットワーク機器自体ではなく、テストしているストレージ デバイスが I/O ボトルネックになる可能性があります。

エンタープライズ総合ワークロード分析

ストレージ アレイのレビューでは、スレッドごとに 8 の未処理のキューを備えた 8 スレッドの高負荷で事前調整し、複数のスレッド/キューの深さのプロファイルで設定された間隔でテストして、軽い使用状況と重い使用状況でのパフォーマンスを示します。 100% 読み取りアクティビティのテストでは、100% 書き込みに切り替えられても、プリコンディショニングは同じワークロードで行われます。

プレコンディショニングおよび一次定常状態テスト:

- スループット (読み取り+書き込み IOPS 合計)

- 平均レイテンシ (読み取りと書き込みのレイテンシを合わせて平均)

- 最大遅延 (ピーク読み取りまたは書き込み遅延)

- レイテンシの標準偏差 (読み取りと書き込みの標準偏差を合わせて平均)

現時点では、Enterprise Synthetic Workload Analysis には、現実世界のアクティビティの反映を試みることができる、共通の順次プロファイルとランダム プロファイルが含まれています。これらは、当社の過去のベンチマークとある程度の類似性があること、および最大 4K 読み取りおよび書き込み速度、エンタープライズ ドライブで一般的に使用される 8K 70/30 など、広く公開されている値と比較するための共通の根拠を持つように選択されました。また、幅広い転送サイズの組み合わせを提供する従来のファイル サーバーと Web サーバーを含む、XNUMX つの従来の混合ワークロードも含めました。これらの最後の XNUMX つは、サイトで紹介されているカテゴリのアプリケーション ベンチマークとともに段階的に廃止され、新しい合成ワークロードに置き換えられます。

- 1024K(シーケンシャル)

- 100% 読み取りまたは 100% 書き込み

- 8K(シーケンシャル)

- 100% 読み取りまたは 100% 書き込み

- 4K(ランダム)

- 100% 読み取りまたは 100% 書き込み

- 8K 70/30 (ランダム)

- 70% 読み取り、30% 書き込み

- ファイルサーバー (ランダム)

- 80% 読み取り、20% 書き込み

- 10% 512b、5% 1k、5% 2k、60% 4k、2% 8k、4% 16k、4% 32k、10% 64k

- ウェブサーバー (ランダム)

- 100% 読み取り

- 22% 512b、15% 1k、8% 2k、23% 4k、15% 8k、2% 16k、6% 32k、7% 64k、1% 128k、1% 512k

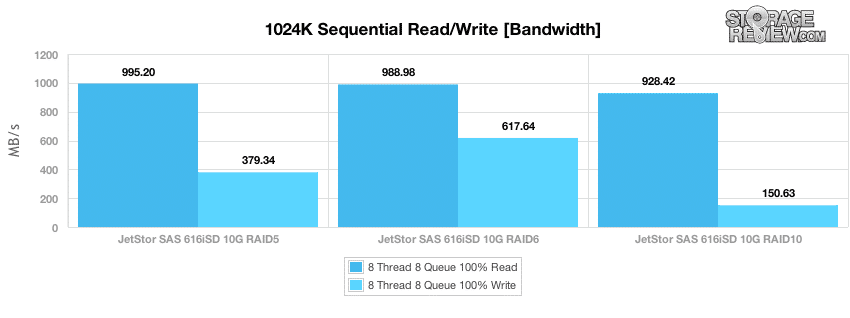

ベンチマークを開始するために、それぞれが 8 つの I/O の未処理のキューを持つ 8 つのスレッドの負荷による大規模ブロックのシーケンシャル パフォーマンスを調べます。これは、ネットワーク上の SAN の飽和率を示すように設計されています。この場合は、 MPIO を使用する 10 つの接続 (コントローラーごとに 5 つ) で 6GbE です。当社のテストでは、ピーク シーケンシャル パフォーマンスは RAID10 よりも RAID995 および RAID5 モードの方が優れていました。速度は、RAID928 の最高 10MB/s から RAID6 の 617MB/s までの範囲でした。書き込みパフォーマンスは RAID5 が最も高く、379MB/秒を測定しましたが、RAID10 は 150MB/秒で、RAIDXNUMX はわずか XNUMXMB/秒でした。

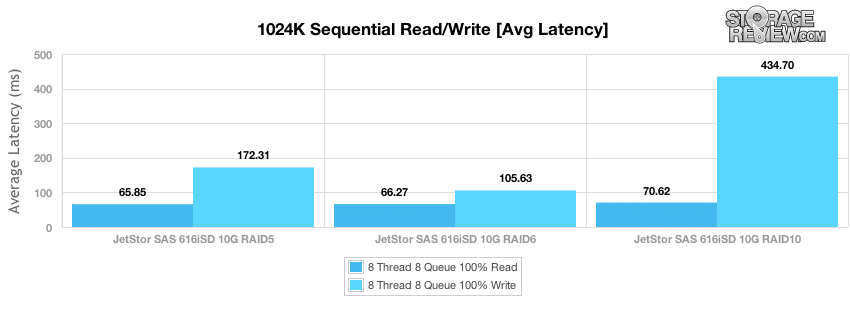

シーケンシャル転送パフォーマンスの平均遅延は、65k 読み取りテストで RAID5 で 66 ミリ秒、RAID6 で 70 ミリ秒、RAID10 で 1024 ミリ秒であり、書き込みセグメントでは RAID105 で 6 ミリ秒、RAID172 で 5 ミリ秒、RAID434 で 10 ミリ秒でした。

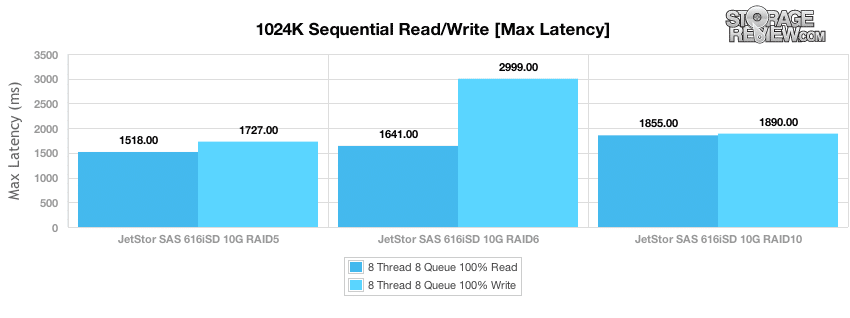

平均レイテンシは全体的なパフォーマンスを確認する際に考慮すべき重要な指標ですが、最悪の場合のレイテンシを知ることも同様に価値があります。 JetStor SAS 616iSD の場合、ピーク読み取り応答時間は、読み取りアクティビティでは 1,518 ~ 1,855 ミリ秒、書き込みアクティビティでは 1,727 ~ 2,999 ミリ秒に抑えられました。

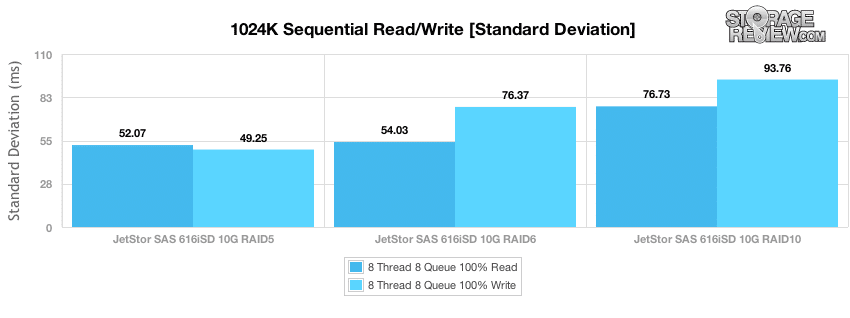

テストで確認する最後の指標はレイテンシの標準偏差で、テスト期間中のレイテンシの広がりがどの程度密接にグループ化されているかを確認します。 RAID5 の JetStor は、大ブロックの読み取りおよび書き込みアクティビティの両方で最も安定したパフォーマンスを提供し、RAID6 が 10 番目となり、読み取りおよび書き込みテストの両方で RAIDXNUMX の広がりが最も広かったです。

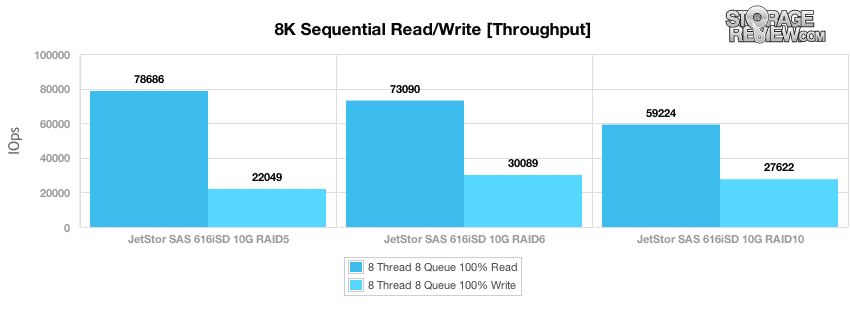

1024k シーケンシャル転送テストは帯域幅飽和後の状態を測定するように設計されていますが、次のテストでは、最良のシナリオで I/O スループットを測定するために、8K 転送による小ブロックのシーケンシャル アクティビティを調べます。実稼働環境で SAN が発生するアクティビティのほとんどは、より多くのシステムが SAN にアクセスするためランダムになりますが、夜間のバックアップやアイドル時間中のバックグラウンド アクティビティでは、これらの速度に近い速度が発生する可能性があります。私たちが測定したシーケンシャル 8K 読み取りのピーク パフォーマンスは、RAID78,686 構成で 5 IOPS でしたが、RAID73,090 では 6 IOPS、RAID59,224 では 10 IOPS に低下しました。 8K シーケンシャル書き込みのピーク パフォーマンスは、RAID30,089 で 6 IOPS と測定され、RAID10 では 27,622 IOPS、RAID5 では 22,049 IOPS でした。

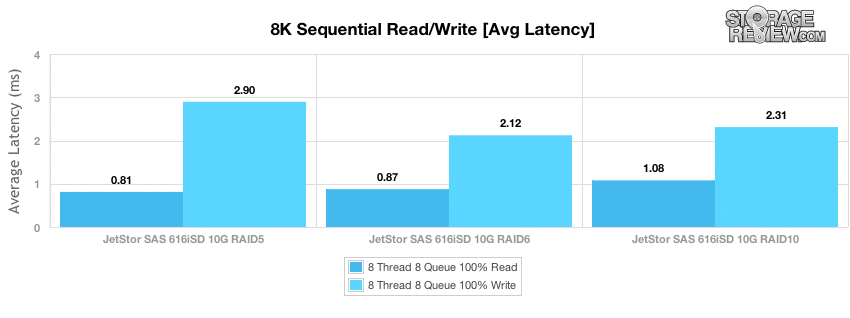

8K 転送テストでは、小ブロックの平均シーケンシャル レイテンシーは全体的に低く、RAID5 の読み取りが 0.81 ミリ秒の応答時間で最も速く、次に RAID6 が 0.87 ミリ秒、RAID10 が 1.08 ミリ秒でした。 I/O 転送の速度が遅いため、書き込みレイテンシはわずかに高く、RAID6 は 2.12 ミリ秒、RAID10 は 2.31 ミリ秒、RAID5 は 2.9 ミリ秒でした。

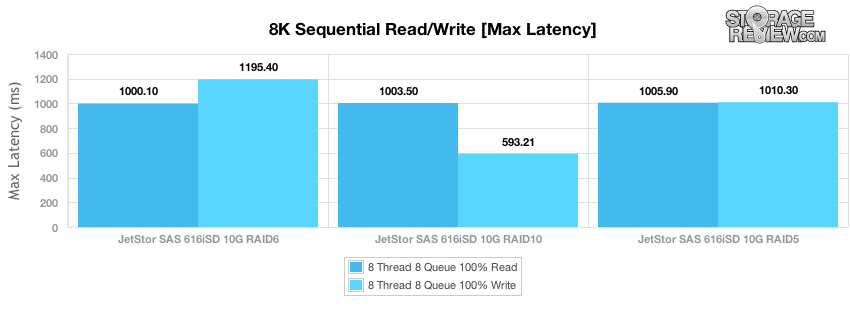

8K シーケンシャル転送テストの最大読み取り遅延は、テストの読み取りセグメント全体で約 1,000 ミリ秒のピークを測定し、書き込みのピーク遅延は RAID593 で 10 ミリ秒、RAID1,195 で最大 6 ミリ秒でした。

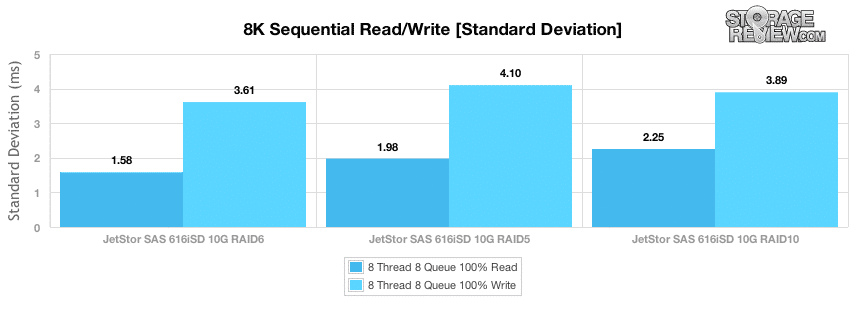

レイテンシの標準偏差の広がりを見ると、RAID6 モードが最も安定したシーケンシャル読み取りパフォーマンスを維持していましたが、RAID5 RAID10 は若干不安定でした。 RAID6 は、書き込み転送において最高の 8K シーケンシャル標準偏差も提供しました。

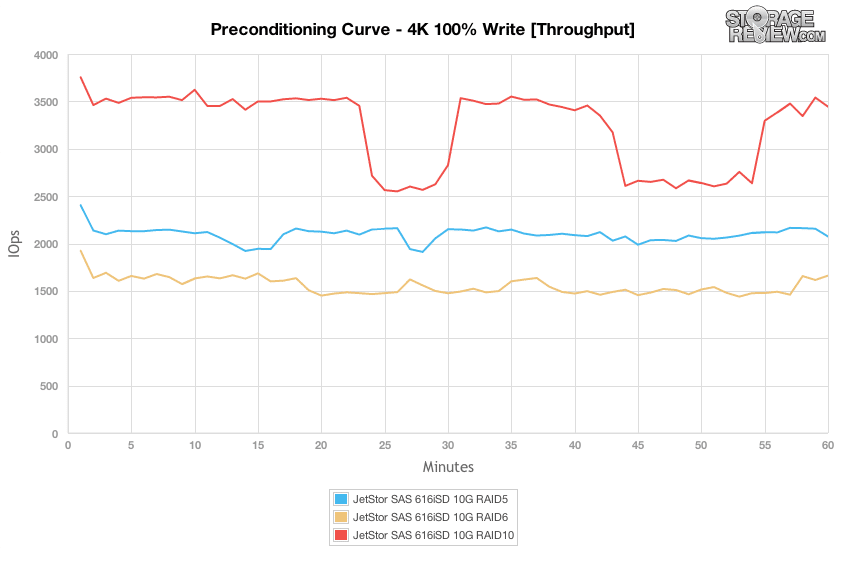

次のテスト グループはランダムなワークロードに焦点を移し、最初のテストはプリコンディショニング セグメントでの 100% 4K 書き込みです。 RAID モードの積み重ねに関しては、RAID10 が最高のスループットを提供し、RAID5 と RAID6 がその下にあります。しかし、興味深いのは、RAID10 アレイのパフォーマンスの低下でした。これは、おそらくバックグラウンド メンテナンスが原因であり、RAID5 および RAID6 のセットアップでは発生しませんでした。

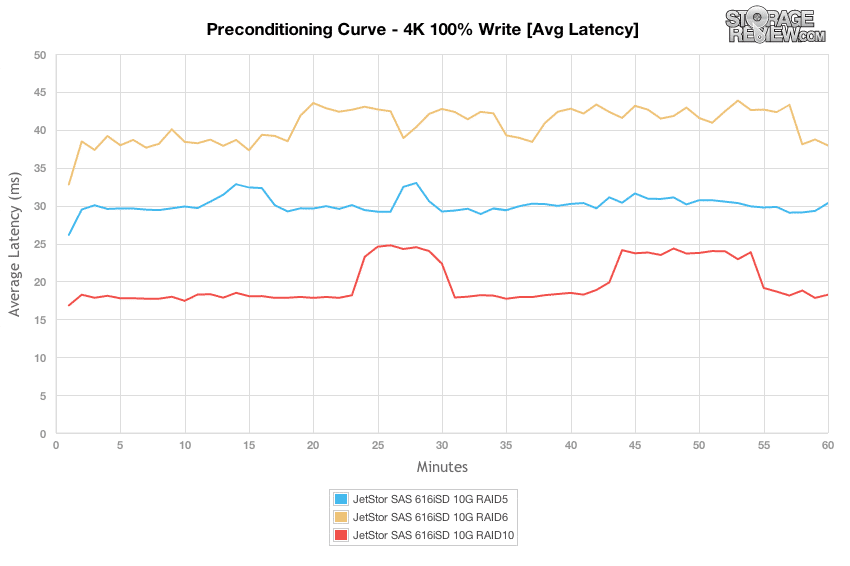

各 RAID モードのプリコンディショニング フェーズ中の平均レイテンシを見ると、ディスク自体のパフォーマンスが横ばいになる前に、オンボード キャッシュが入ってくるランダム アクティビティを 1 ~ 2 分間バッファリングした様子がわかります。

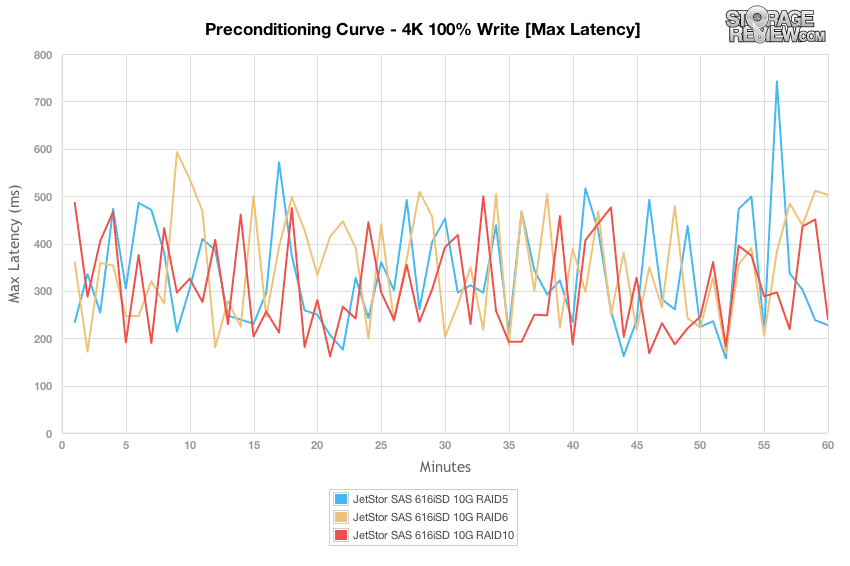

それぞれ 8 つの未処理 I/O を含む 8 つのスレッドの負荷中、200% 500K 書き込みアクティビティの各 RAID モードのピーク遅延は 100 ~ 4 ミリ秒の間で変動しました。

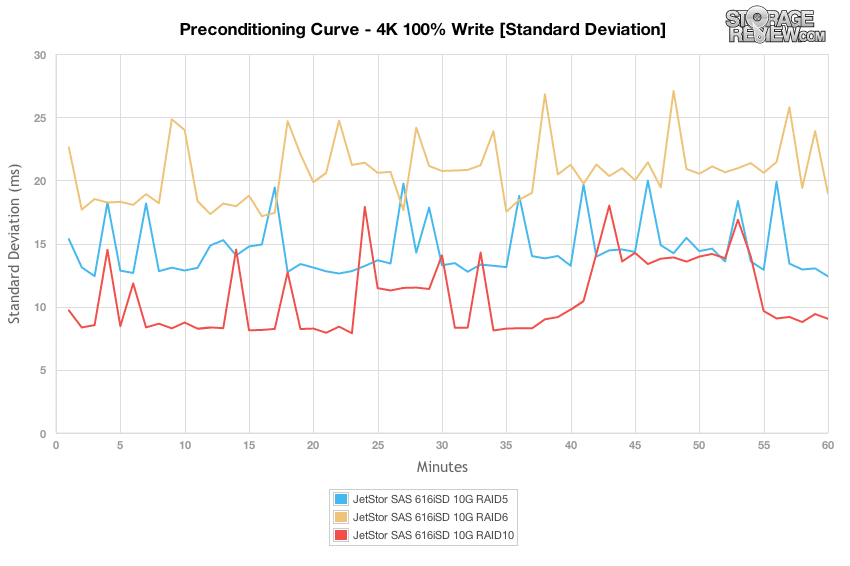

焦点をレイテンシの標準偏差に切り替えると、応答時間は RAID10 構成で最も安定しており、次に RAID5、RAID6 であることがわかります。

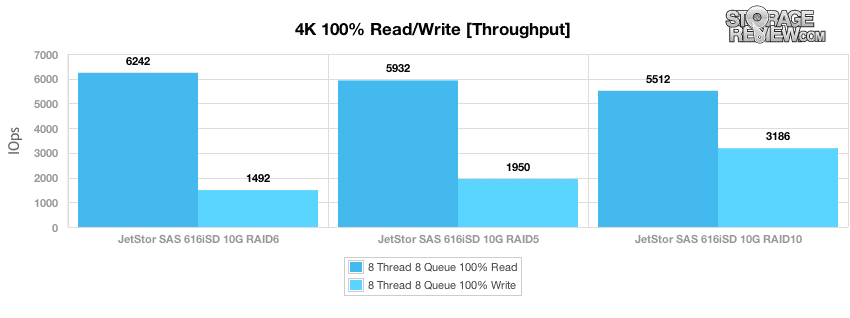

プレコンディショニング プロセスが完了した後、各 RAID モードから 100% 4K ランダム読み取りおよびランダム書き込みパフォーマンスのより長いサンプルを採取しました。 RAID6 は 6,242 IOPS という最速の読み取り速度を実現しましたが、書き込みパフォーマンスは 1,492 IOPS と遅くなります。 RAID10 は、3,186 IOPS という最高のランダム書き込みパフォーマンスを提供しましたが、4K ランダム読み取り速度は 5,512 IOPS と低速でした。

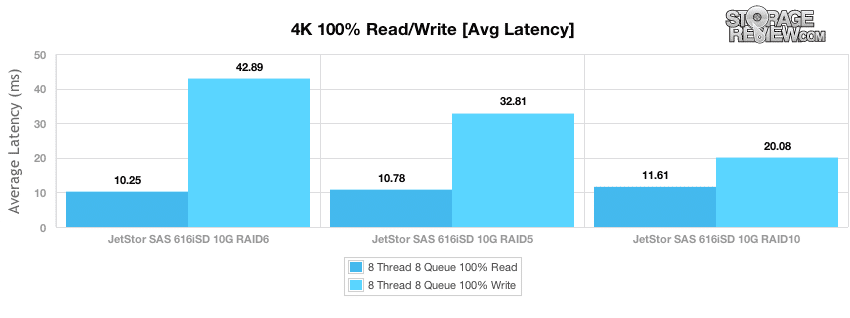

64 という卓越した有効キュー深度により、各 RAID モードで 4K のランダム読み取りおよび書き込み遅延を測定しました。ランダム 4K 読み取り遅延は、RAID10.25 の 6 ミリ秒から RAID11.61 の 10 ミリ秒の範囲でした。書き込みレイテンシーは、RAID20.08 の 10ms から RAID42.89 の 6ms にスケールされました。

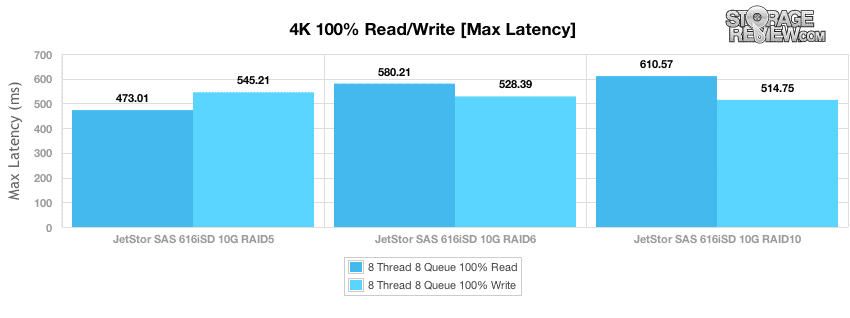

プレコンディショニング フェーズ以外の長いサンプリング期間では、読み取りトランザクションでは 473 ~ 610 ミリ秒、書き込みアクティビティでは 514 ~ 545 ミリ秒の範囲のピーク応答時間を測定しました。

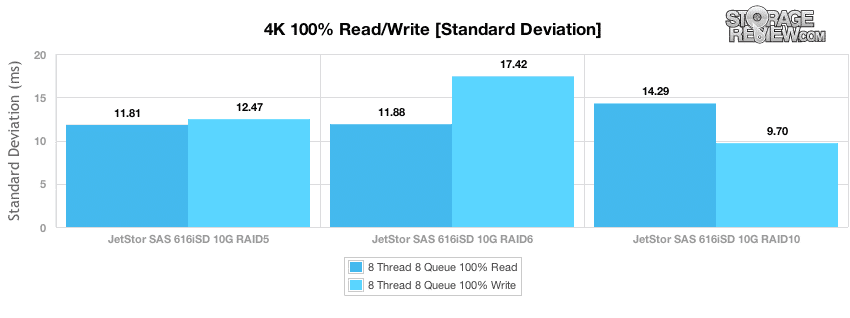

ピーク遅延はサンプリング期間全体で最悪の応答時間を示しますが、標準偏差はテスト期間全体での遅延の広がりを示します。 RAID5 は最も一貫したランダム 4K 読み取りレイテンシを提供し、RAID10 は最も一貫した 4K 書き込みレイテンシを提供しました。

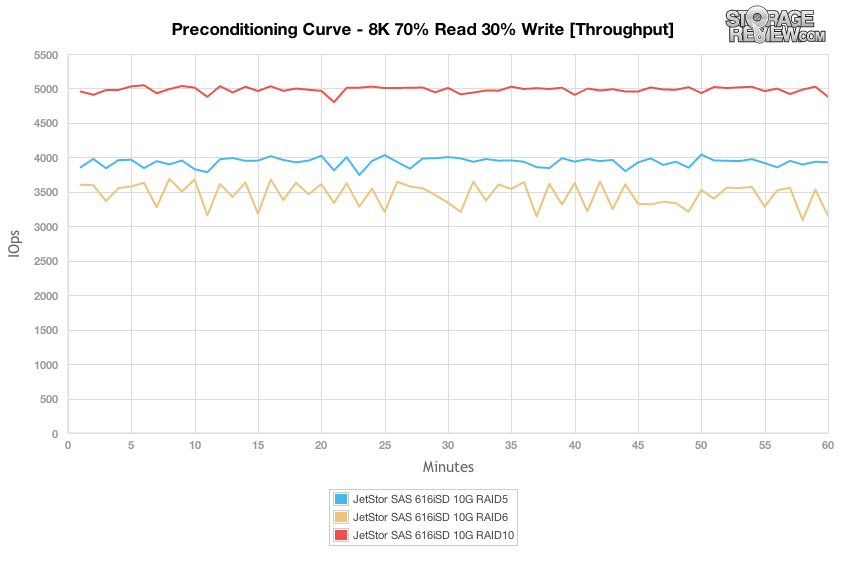

次の事前調整テストは、100K、1024% 100K、または 8% 100K ワークロードの 4% 書き込みアクティビティと比較して、より現実的な読み取り/書き込みワークロード分散で機能します。ここでは、70K ランダム転送が 30% の読み取りと 8% の書き込みで構成されています。 8 スレッドとスレッドあたり 70 キューの高負荷下での 30K 8/8 混合ワークロードを見ると、RAID10 が最高のスループットを提供し、次に RAID5、次に RAID6 であることがわかります。パフォーマンスはプレコンディショニング プロセスの期間中非常に安定しており、パフォーマンスにわずかな変化があっただけでした。

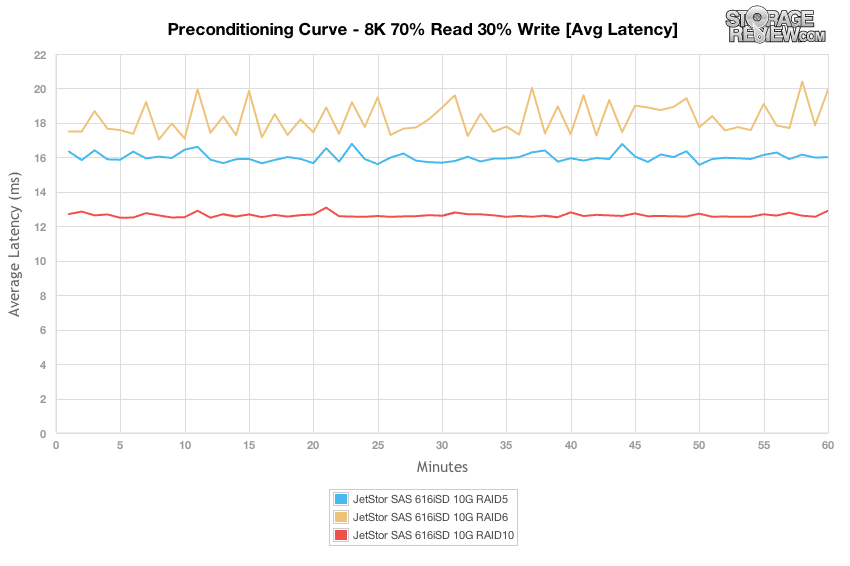

8K 70/30 ワークロード中の平均遅延の広がりを見ると、RAID10 が最も平坦で、テスト期間中 12 ~ 13 ミリ秒を測定し、次に RAID6 が約 16 ~ 17 ミリ秒、RAID5 が 17 ~ 20 ミリ秒でした。

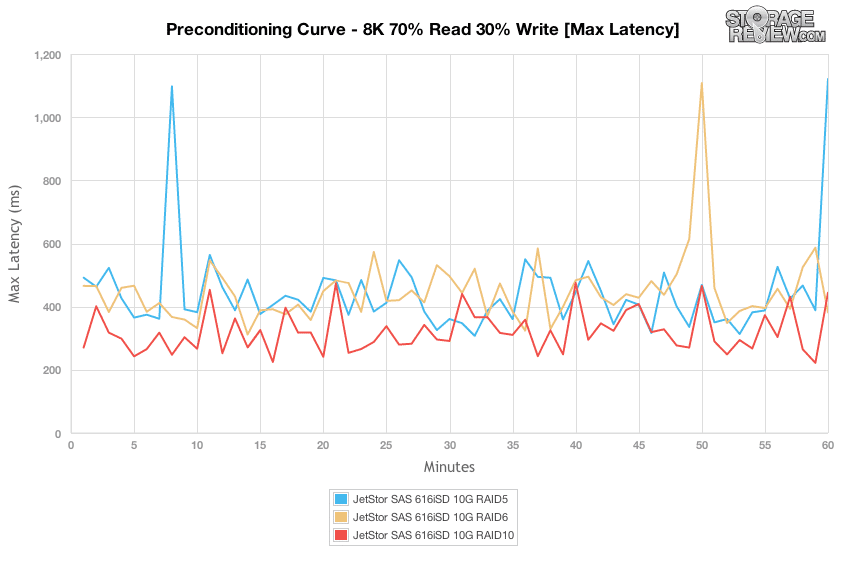

各 RAID タイプのピーク応答時間は 300 ~ 500 ミリ秒の範囲でかなり安定していましたが、RAID1,000 および RAID5 の RAID タイプでは 6 ミリ秒を超えると若干の変化がありました。

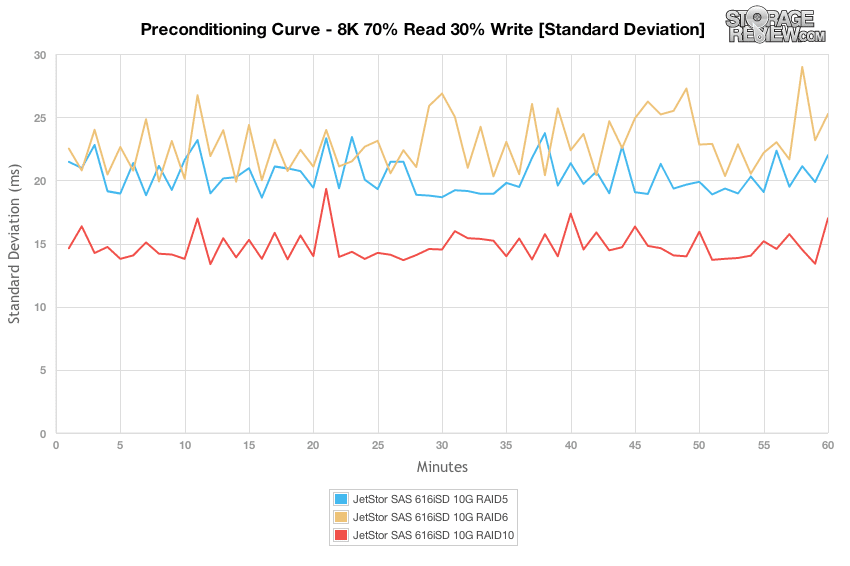

RAID タイプ間のレイテンシーの標準偏差の差を比較すると、RAID10 が最も安定したレイテンシーを示し、次に RAID5、次に RAID6 でした。

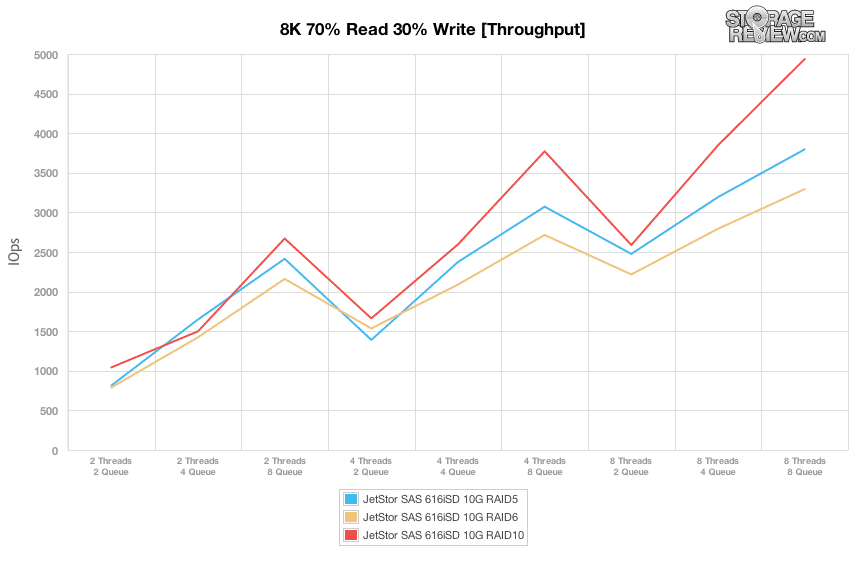

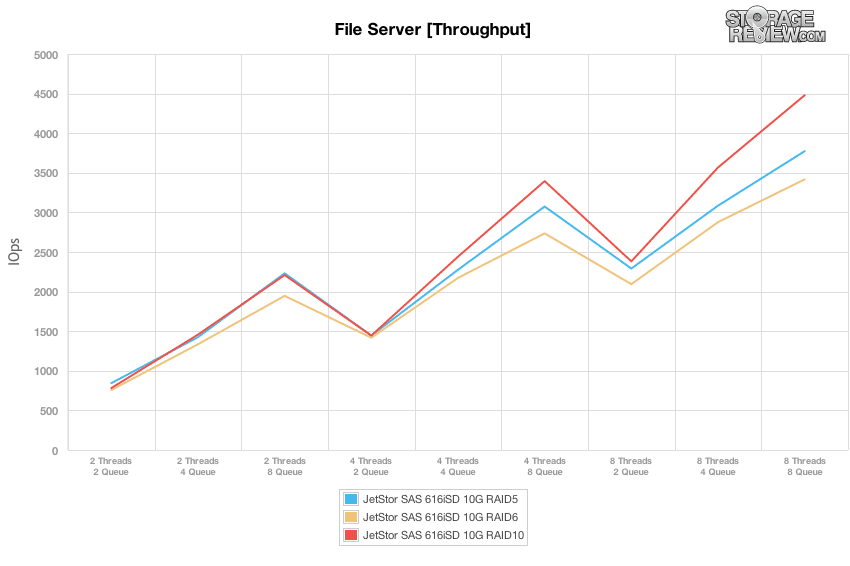

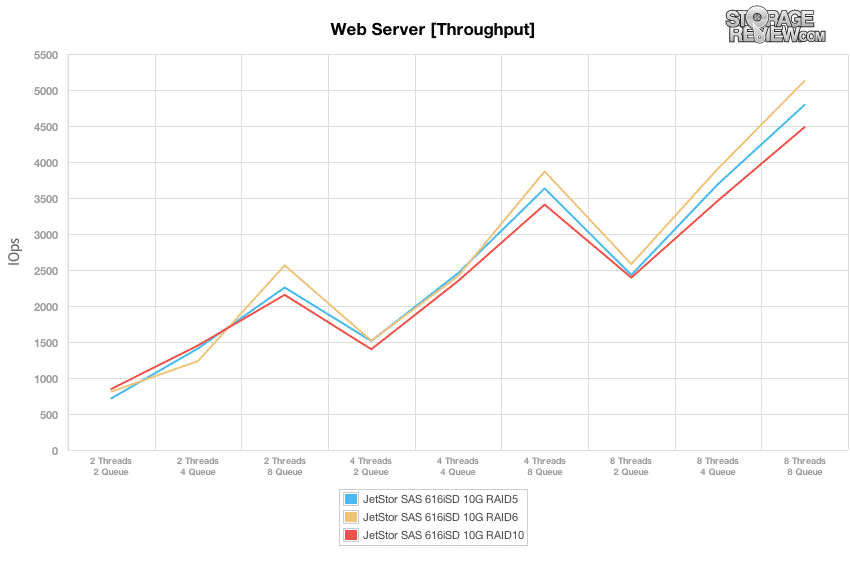

8% 8K、100K、および 4K テストで実行した固定の 8 スレッド、1024 キューの最大ワークロードと比較して、混合ワークロード プロファイルは、スレッドとキューの幅広い組み合わせにわたってパフォーマンスを拡張します。これらのテストでは、ワークロード強度を 2 スレッドと 2 キューから、最大 8 スレッドと 8 キューまで広げます。スループットの違いを見ると、有効キュー深さが 16 以下に留まった領域では、各 RAID モードはほぼ同等に実行されていました。 32T/4Q、8T/8Q、および 4T/8Q ワークロードで見られるように、8 を超えると、RAID10 モードが最高のパフォーマンスを提供し、次に RAID5、次に RAID6 が続きました。この範囲未満では、各 RAID モードで同様のパフォーマンスが得られました。

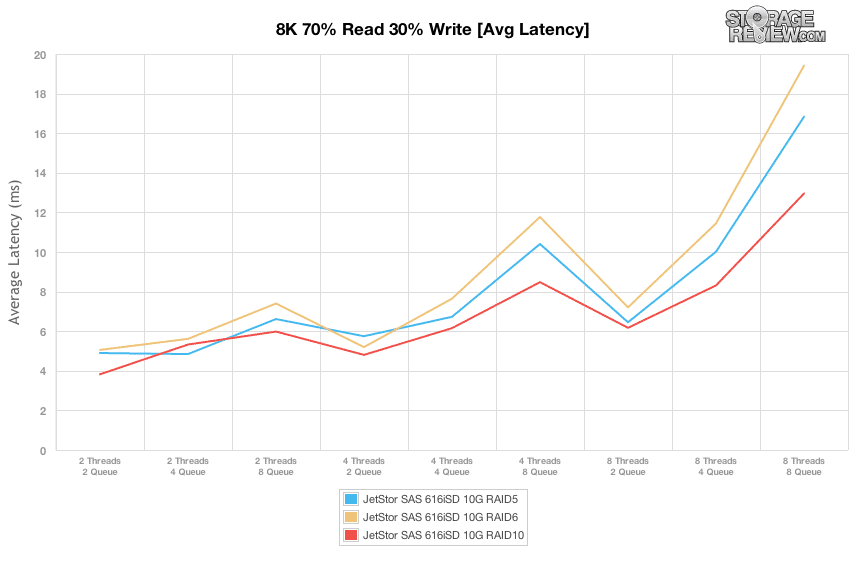

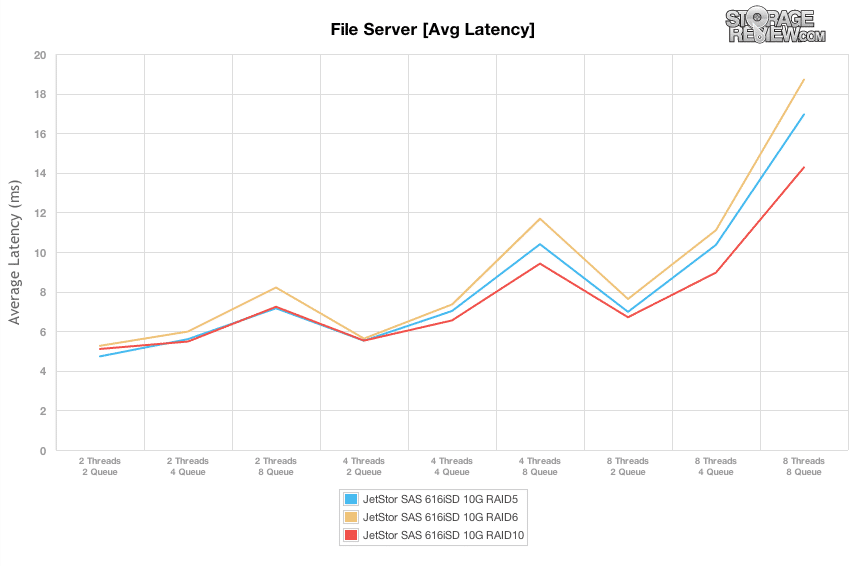

ピーク スループットの範囲を知ることは重要ですが、ストレージ アレイに合わせて負荷を調整する方法を知ることはさらに重要です。高速な I/O 速度と高いレイテンシが混在していると、ユーザー インタラクションが遅くなるだけです。そのため、レイテンシが大幅に増加し始める前に絞り出せるパフォーマンス レベルを把握することが、使いやすさにとって重要です。テストのスイート スポットは、最高のスループットを提供しながら、レイテンシーを 6 ~ 8 ミリ秒の間で比較的低く抑えられる 8T/2Q で、パフォーマンスの範囲は 2,250 ~ 2,750 IOPS でした。

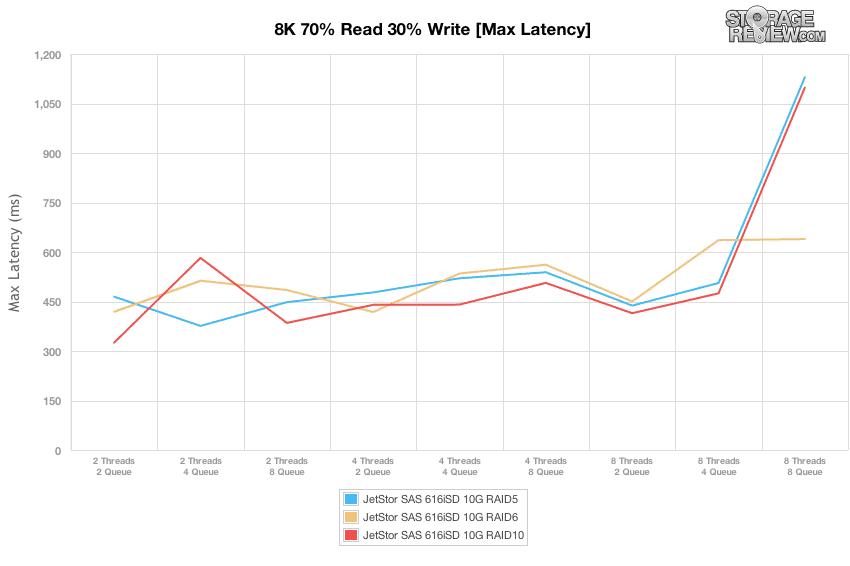

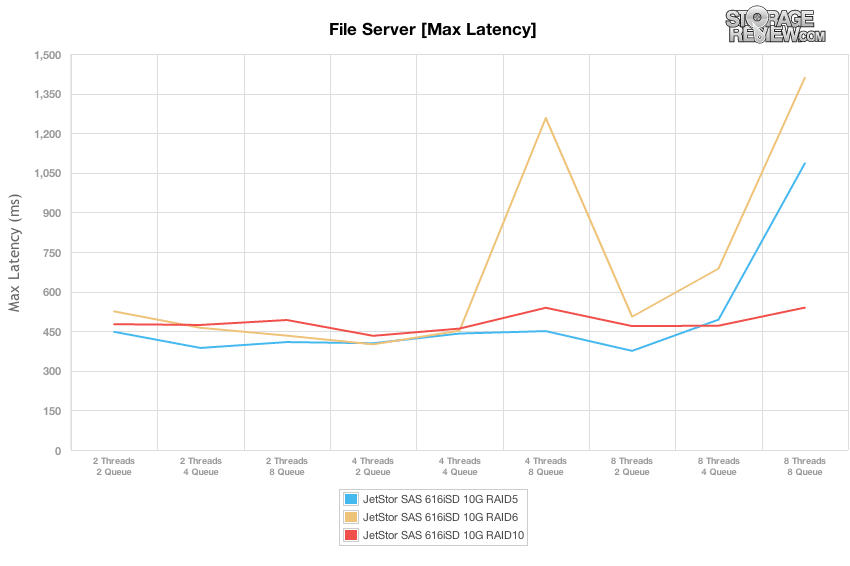

実効キューの深さと JetStor SAS 616iSD のピーク遅延を比較すると、SAN は 500T/8Q ワークロードまで、より高い応答時間を 8 ミリ秒未満に抑えることができました。その時点で、RAID5 と RAID6 のピーク遅延は XNUMX 倍になりました。

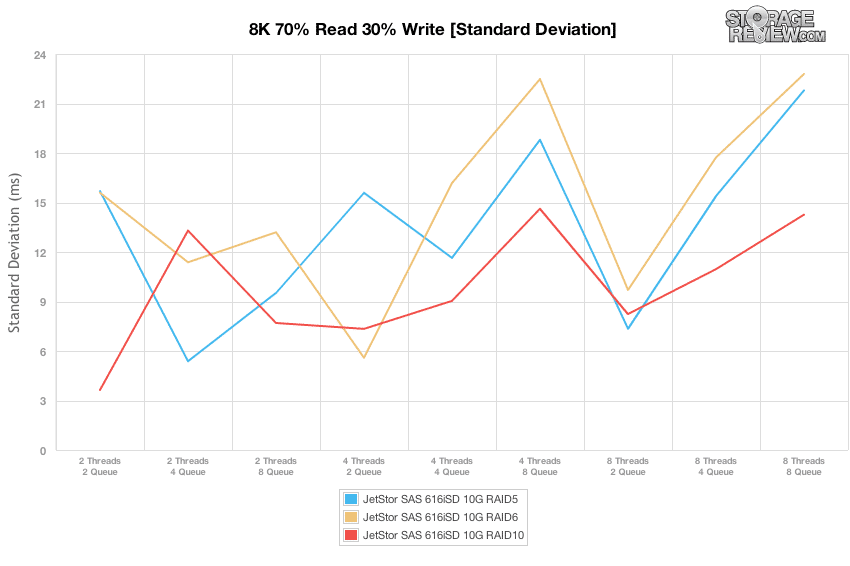

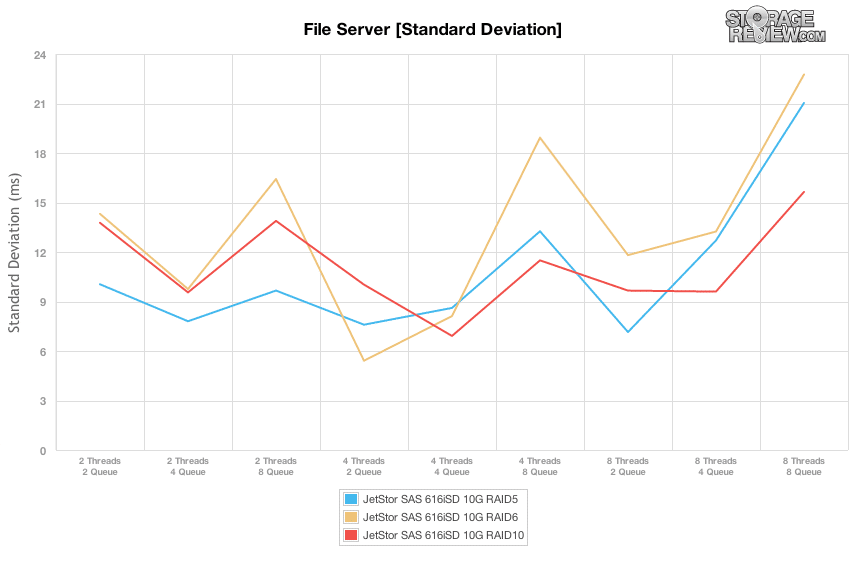

10 つの RAID タイプすべてのレイテンシー標準偏差を比較すると、RAID6 がわずかに有利であり、通常は RAID8 が最大の広がりを持っていました。ただし、最も安定したレイテンシのスイート スポットは 2T/XNUMXQ 負荷であり、これはすべての RAID タイプに最適でした。

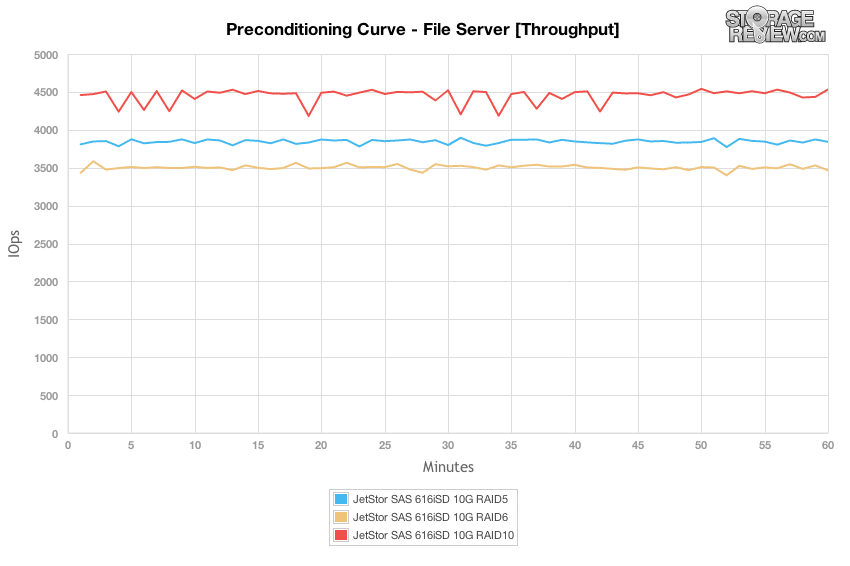

ファイル サーバーのワークロードは、特定の各アレイに当たるより大きな転送サイズのスペクトルを表しているため、SAN は静的な 4k または 8k ワークロードに落ち着くのではなく、512b から 64K の範囲のリクエストに対処する必要があります。他の完全にランダムなワークロードと同様に、RAID10 構成は最高のスループットを提供し、プリコンディショニング プロセス中に約 4,500 IOPS を測定しました。 RAID5 が 3,800 IOPS の速度で続き、RAID6 が約 3,500 IOPS で続きました。各 RAID タイプは、わずかな違いのみで、最初から最後まで同様のパフォーマンスを示しました。

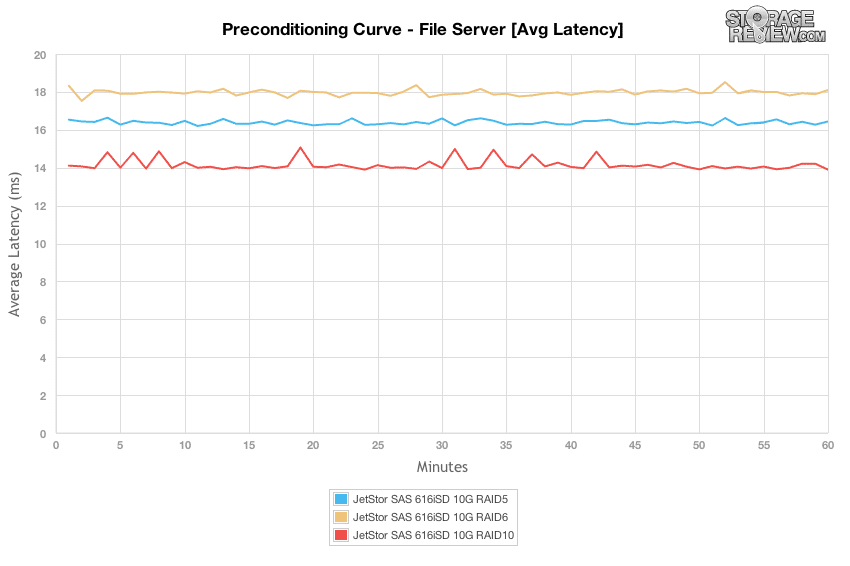

平均遅延を見ると、プリコンディショニング テスト期間中、各 RAID 構成はほぼ横ばいで、RAID10 モードは 14 ミリ秒、RAID5 は 16.5 ミリ秒、それ以上の RAID6 は 18 ミリ秒で安定しました。

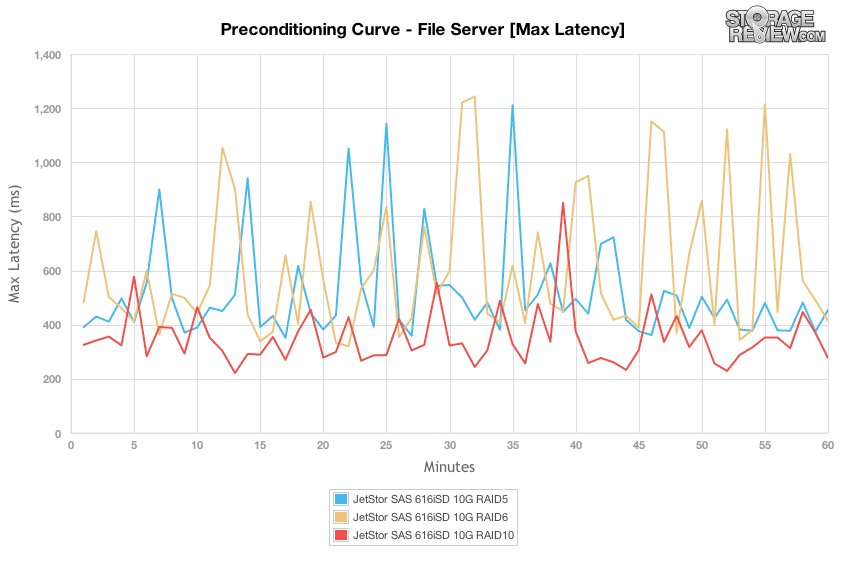

ピーク応答時間は、プレコンディショニング段階では、最低 200 ミリ秒から最高 1,200 ミリ秒までの範囲にさらに広がりました。 RAID10 構成は最も低いままで、その範囲は 250 ミリ秒から 800 ミリ秒強でした。ただし、RAID5 と RAID6 は、300 ミリ秒から 1,200 ミリ秒を超える範囲でピークに達しました。

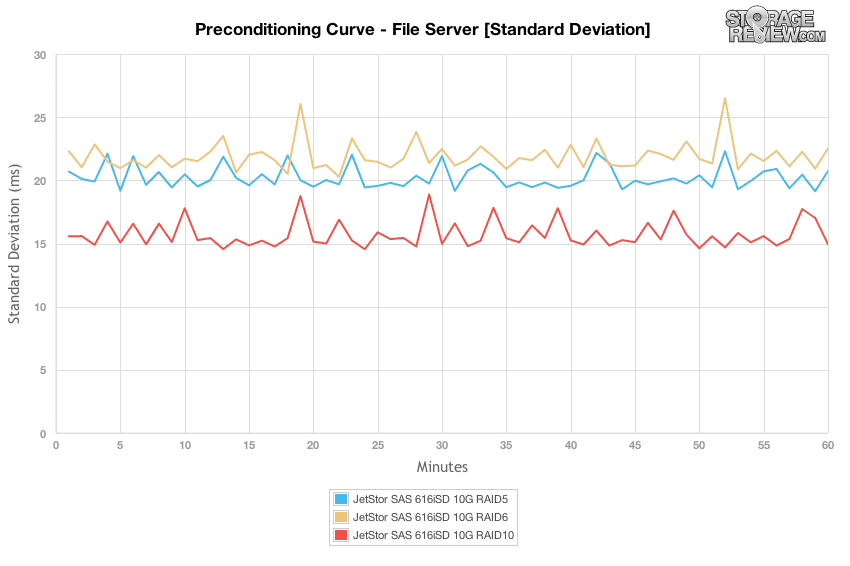

RAID10 は最も安定したレイテンシー標準偏差を示し、その次には 5 つ上の RAID6 と RAIDXNUMX が続きました。

負荷を 2T/2Q から 8T/8Q に増加させたスケーリングされたファイル サーバーのスループット グラフに切り替えると、有効キュー深度 16 以下では、各 RAID タイプ間でパフォーマンスの差がほとんどないという同様の傾向が見られました。 。そのレベルを超えると、RAID10 が最高のパフォーマンスを提供し、次に RAID5、次に RAID6 となりました。

ファイル サーバー ワークロードの平均レイテンシーのビューに切り替えると、実効キューの深さは 5 ミリ秒以下に留まりながら、応答時間は 8 ~ 16 ミリ秒の間で変動し、ピーク負荷時には 14 ~ 19 ミリ秒まで上昇しました。スイート スポットは、8K 70/30 ワークロードと同様に、やはり 8T/2Q で、JetStor SAS 606iSD は、2,000 ~ 2,500 ミリ秒の遅延で 7 ~ 8 IOPS の最高スループットを提供できました。

ファイル サーバー テストでは、RAID400 および RAID500 の最大遅延は 5T/6Q および 8T/4Q まで 8 ~ 8 ミリ秒以内に留まり、その後遅延が大幅に増加しました。 RAID10 からの最大応答時間は、テスト期間全体にわたって一貫したままでした。

すべての RAID タイプの標準偏差は、さまざまな負荷テストの期間中、一貫して一貫性がありませんでした。構成がキューの深さ 8 に達する高負荷では、ばらつきが全体的に増加しました。

最後のワークロードは、メイン出力と比較してテストの前処理フェーズを分析する方法がかなり独特です。ワークロードは 100% 読み取りアクティビティを想定して設計されているため、適切な事前調整手順がなければ、各デバイスの真の読み取りパフォーマンスを示すことは困難です。コンディショニングのワークロードをテストのワークロードと同じに保つために、パターンを反転して 100% 書き込みにしました。このため、事前調整チャートは最終的なワークロードの数値よりも遅くなります。

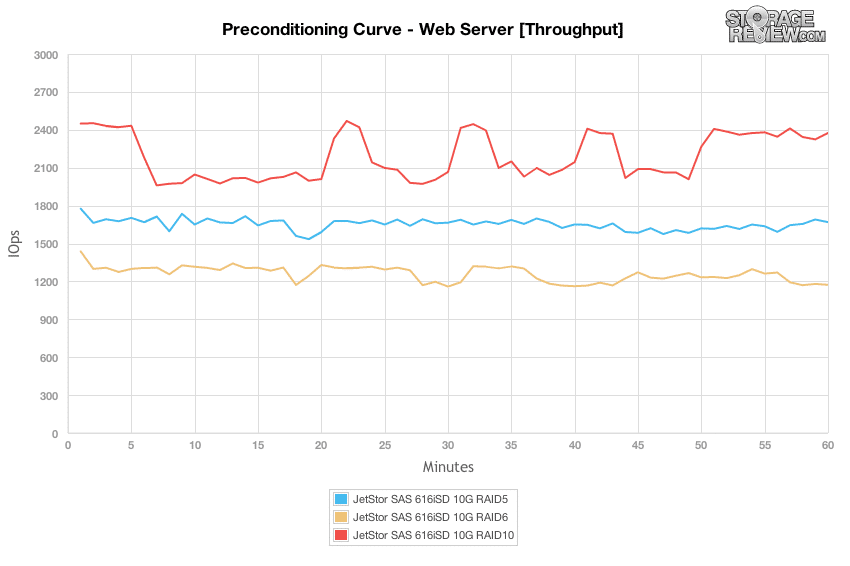

100% 書き込み条件の Web サーバー シナリオでは、RAID10 構成が最高のパフォーマンスを提供しましたが、4K ランダム テストで確認した動作と同様でしたが、バックグラウンド アクティビティが実行されるため、テストのセクション全体でパフォーマンスが低下しました。他の RAID プロファイルも同様の結果は得られませんでしたが、全体的に速度が遅くなりました。

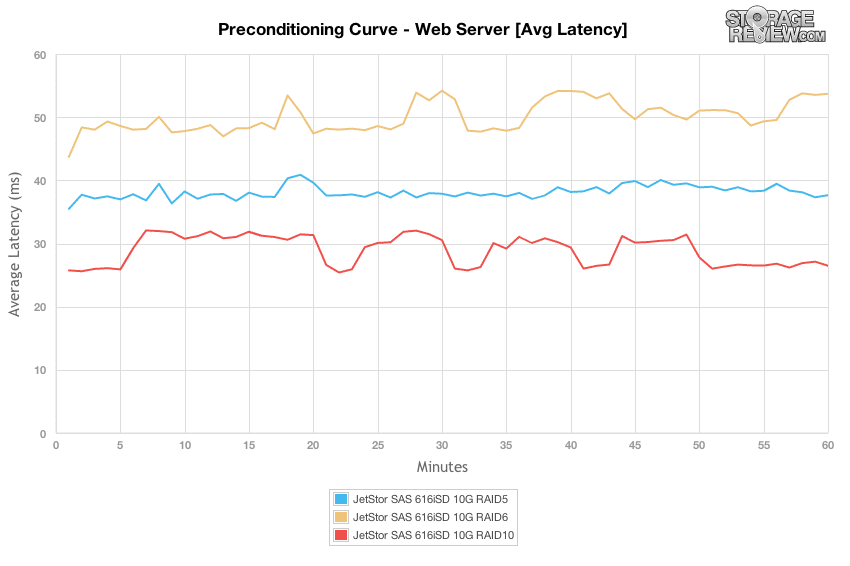

8T/8Q の負荷を伴う Web サーバーのプリコンディショニング プロセスでは、広範囲にわたるパフォーマンスの差があり、全体で最も速い応答時間は RAID10 で 26 ~ 32 ミリ秒、RAID5 では約 38 ~ 41 ミリ秒、RAID6 では 48 ~ 54 ミリ秒でした。

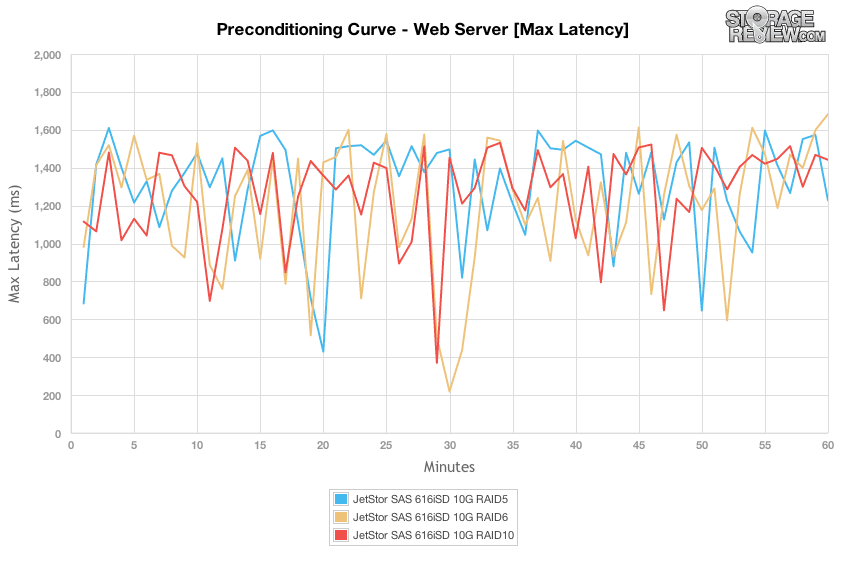

Web サーバーのプリコンディショニング ワークロードの最大遅延の違いを比較すると、すべての RAID タイプで合計 200 ~ 1,600 ミリ秒という同様の範囲のピーク応答時間が得られました。

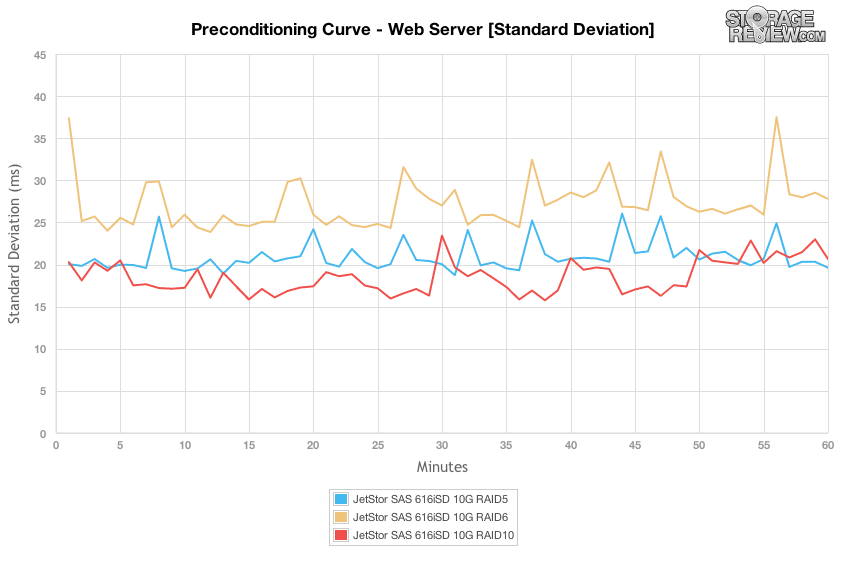

最大遅延を比較する場合、それほど大きな違いはなかったかもしれませんが、焦点を遅延の標準偏差に変えると、RAID10 が遅延のばらつきが最も狭く、次に RAID5、次に RAID6 であることがわかります。

プレコンディショニング段階の 100% 書き込みアクティビティから 100% 読み取りアクティビティに切り替えると、有効キューの深さが大きくなるまで、各 RAID タイプの違いはそれほど目立ちません。ピーク時には、RAID10 モードは 5,100 IOPS、RAID5 は 4,800、RAID6 は 4,500 IOPS をサポートできました。

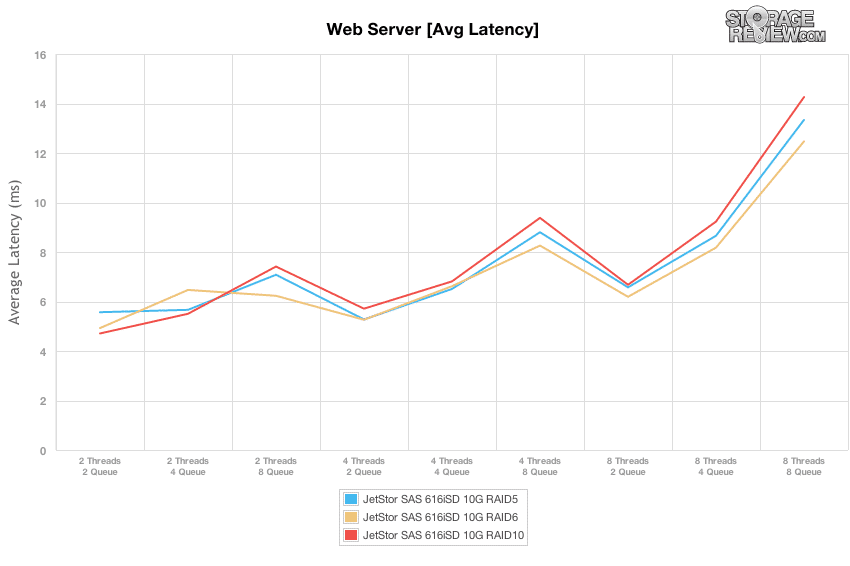

Web サーバー プロファイルの 100% 読み取りアクティビティのスイート スポットは依然として 8T/2Q 負荷であり、遅延が 6.2 ~ 6.6 ミリ秒に急増するまで、応答時間は 2,400 ~ 2,600 ミリ秒、スループットは 13 ~ 15 IOPS でした。

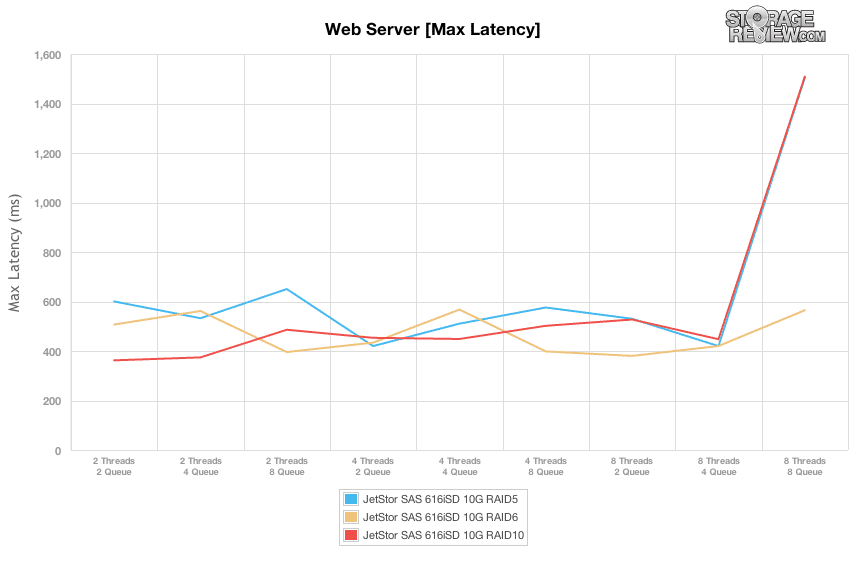

さまざまな負荷テストで最大遅延を比較すると、JetStor SAS 616iSD は、RAID400 および RAID600 構成で最大 8 ミリ秒に達する 8T/5Q ワークロードまで、10 ~ 1,500 ミリ秒の範囲を維持しました。

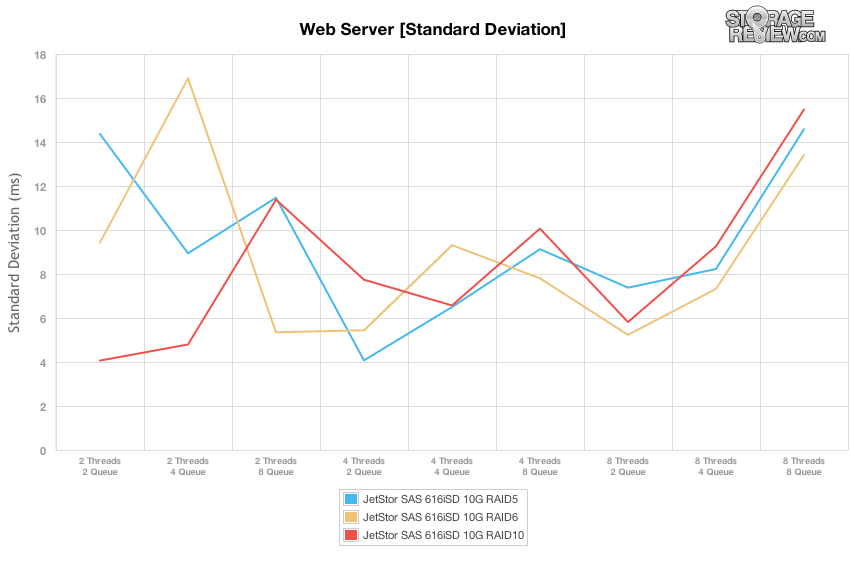

レイテンシーの標準偏差の違いを比較すると、JetStor SAN の各 RAID タイプは、ピーク負荷である 8T/8Q に達するまで、中程度の負荷下ではより安定した応答時間を提供しました。 8T/2Q のスイート スポット範囲では、RAID6 が最も安定したレイテンシを提供し、次に RAID10、RAID5 が続きました。

消費電力

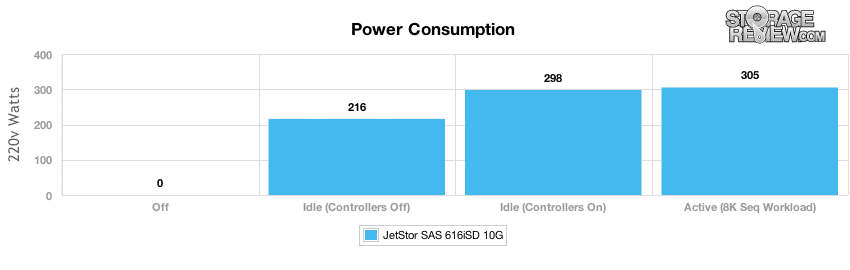

最新のデータセンターに設置されている他のデバイスと同様に、消費電力と熱出力は、デバイス自体の電力使用量と、動作中に発生する熱を相殺するために必要な冷却の両方で収益に 2 倍の影響を与えるため、常に念頭に置かれています。ほとんどの SAN および NAS アレイでは、全体的な電力使用量の最大の要素はドライブ自体です。かなり一定のアクセスがある場合、アイドル状態やスピンダウンにかかる時間はほとんどありません。テストでは、オフ状態、システムの電源はオンだがコントローラーの電源がオフの状態、システムの電源がオンでアイドル状態の状態、およびシステムの電源がオンで一定の高い I/O 負荷が見られる状態での電力を測定しました。

600 台の 15GB 216k SAS ハード ドライブが取り付けられている場合、電力使用量の大部分はこれらのドライブをアクティブに保つことで発生します。コントローラーがオフの場合、アレイはアイドル時に 298 ワットを必要としましたが、コントローラーをオンにすると 7 ワットに増加しました。アクティブな負荷があっても、305K シーケンシャル ワークロードの場合、電力使用量はさらに 8 ワット増加して 460 ワットになりました。デュアル 66 W 電源装置を備えた JetStor SAN は、15,000RPM のハード ドライブが取り付けられている状態でも XNUMX% の使用率に留まり、電力需要の点で適度にオーバープロビジョニングされていることがわかりました。 XNUMX つのベイが未使用であっても、電源装置に障害が発生して計算式から除外されたとしても、まだ十分なオーバーヘッドが残っています。

まとめ:

Jetstor SAS 616iSD 10G は、SMB の仮想化や一般的なストレージのニーズを満たすためにパフォーマンスまたは大容量のドライブと単独で使用したり、追加のシェルフと組み合わせて大規模企業のストレージの問題を解決したりできるという点で、やや不定形なストレージ アレイ カテゴリに当てはまります。 JetStor は 616iSD を適切に設計しており、内部と外部のすべてがよく考えられており、ユニットは簡単なフィールド サービスに適しています。ケーブルレスの内部設計や工具不要のコンポーネント交換などの項目により、技術者は実稼働環境で SAS 616-SD を稼働し続けるためにほとんど作業を行う必要がありません。セットアップも簡単で、少なくとも企業内での意味では、ほとんどプラグアンドプレイです。

パフォーマンスの面では、RAID5、RAID6、RAID10 の一般的な構成でアレイをテストしました。私たちのテストでは各モードで大きなばらつきが見られたため、10 つすべてに注目することは確かに関連性があります。 RAID5 は一貫して最高のパフォーマンスを示し、生のパフォーマンスと最小遅延の点で RAID6、次に RAID8 に続きました。企業がこのアレイまたは他のアレイの導入を検討している場合、パフォーマンスのスイートスポットを理解することは、ストレージ導入を成功させるために特に重要です。この場合、最高のパフォーマンス目標は 2 スレッド、606 キューであり、JetStor SAS 12iSD はほとんどのワークロードとすべての RAID タイプで高スループットと低レイテンシを提供できました。レイテンシは大幅に増加しますが、パフォーマンスはその点を超えて拡大し続ける可能性があります。電力面では、15 ドライブ 305k SAS 構成が負荷時に 460 ワットを消費することがわかりました。これは、各電源が処理できるように設計されている XNUMX ワットをはるかに下回っています。これにより、コンポーネント障害が発生した場合に単一の PSU から実行する必要がある場合でも、システムに十分なオーバーヘッド スペースが与えられます。

JetStor が少し問題に遭遇するのは、より高級市場をより大規模な顧客に移行しようとするときです。このような場合、管理レイヤーが非常に重要になりますが、JetStor にはそれがあまり詳しくありません。単一の管理ウィンドウを通じて大規模なコンピューティング プラットフォームとストレージ プラットフォームを管理できる EMC や NetApp などと比較すると、JetStor SAN は独自に構成する必要があります。少数のシステムを使用する場合、これは厳密には問題ではありません。むしろ、このボックスが市場のどのセグメントに関与しているかを理解することが問題です。 JetStor の名誉のために言っておきますが、彼らは大規模なエンタープライズ ストレージ アレイを SAS 616iSD に置き換えようとしているわけではありません。このデザインは非常に理にかなっている中間市場にしっかりと向けられています。

メリット

- 素晴らしい筐体/コンポーネント設計

- メンテナンスが簡単な非常に堅牢な設計

- 幅広いワークロードで強力で一貫したパフォーマンスを提供します

デメリット

- 大規模なエンタープライズ データ管理ソフトウェアが不足している

ボトムライン

JetStor はストレージに関してはそれほど有名な名前ではありませんが、おそらく 20 年近くのビジネスと強力な製品セットを考えれば、そう呼ばれるはずです。このレビューに特化して、JetStor SAS 616iSD 10G は求められたことをすべて実行し、パフォーマンスのニーズに合わせて 10GbE および 15K ハード ドライブを構成したり、大容量ストレージ用に大容量 3.5 インチ ハード ドライブを構成したりできる十分な柔軟性を備えています。このアレイは導入が簡単で、適切に設計されているため、中小企業やブランチ/リモート オフィスでの使用のためのアプリケーションおよび仮想化ストレージに適しています。