CoreWeave는 성능 통찰력을 갖춘 최초의 Dell XE9712 GB200 NVL-72 시스템을 공개했습니다!

CoreWeave는 새로운 Dell XE200 서버와 함께 최신 GB72 NVL-9712 시스템을 구축했습니다. 이 시스템은 Switch 최첨단 데이터 센터에서 라이브 데모로 선보였으며, 획기적인 성능과 고급 냉각 인프라를 강조했습니다.

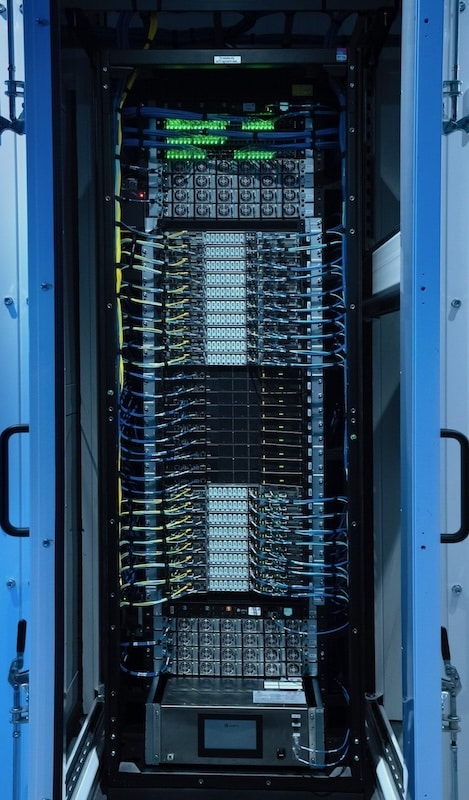

Rob Roy의 Evo Chamber에 보관된 CoreWeave의 GB200 NVL-72 시스템은 가장 까다로운 컴퓨팅 워크로드를 처리하도록 설계되었습니다. 라이브 데모는 랙의 72개 GPU에서 Nvidia NVLink 상호 연결의 초고대역폭과 낮은 대기 시간을 보여주는 벤치마크인 NCCL All-Reduce Test로 시작되었습니다. 이 테스트는 GPU 간의 원활한 통신을 보장합니다.

CoreWeave의 Sunk를 사용한 라이브 트레이닝

CoreWeave의 Sunk를 사용한 라이브 트레이닝

GB200 NVL-72는 Kubernetes(Sunk)에서 Slurm을 사용하여 라이브 트레이닝을 실행하여 Megatron 모델을 트레이닝하여 테스트되었습니다. 트레이닝 세션은 실제 워크로드로 랙을 검증하고 냉각 및 전력 인프라에 발생하는 부하를 보여주었습니다.

롭 로이의 에보 챔버

NVL72는 Rob Roy의 Evo Chamber에 보관되어 랙당 1MW의 인상적인 전력 및 냉각 용량을 제공합니다. 인프라의 이러한 발전은 250kW의 공기 냉각과 750kW의 직접 칩 액체 냉각 용량을 결합하여 가장 까다로운 AI 및 HPC 워크로드에 최적의 성능을 보장합니다. 챔버의 정교한 설계는 차세대 컴퓨팅 요구 사항을 지원하는 동시에 효율적인 전력 사용과 열 관리를 유지합니다.

결론

CoreWeave는 서비스로서의 AI 인프라를 제공하는 데 있어 분명한 업계 리더입니다. 그들의 성공의 대부분은 다른 클라우드보다 최신 AI 인프라를 더 빠르게 온보딩할 수 있는 능력 덕분입니다. 새로운 Dell GB200 NVL-72 시스템은 고성능 컴퓨팅의 새로운 시대를 대표합니다. 최첨단 GPU 성능, 고급 냉각 솔루션, 에너지 효율성을 결합하여 AI, 과학 연구, 데이터 집약적 애플리케이션의 요구 사항을 충족합니다. 이는 대규모 AI 워크로드를 실행하는 고객에게 큰 승리입니다.

StorageReview에 참여

뉴스레터 | 유튜브 | 팟캐스트 iTunes/스포티 파이 | 인스타그램 | 트위터 | 틱톡 서비스 | RSS 피드