GTC에서 발표 그리고 ISC에서 AIC로 사용 가능, NVIDIA A100 GPU가 이제 Google Cloud에 제공됩니다. 최초 발표 이후 약 한 달밖에 되지 않았다는 점을 고려하면 GPU가 주요 퍼블릭 클라우드로 이동하는 것은 정말 빠른 일입니다. Google은 Accelerator-Optimized VM(A100) 인스턴스 제품군에 A2 또는 Ampere GPU를 도입한 최초의 주요 퍼블릭 클라우드입니다.

GTC에서 발표 그리고 ISC에서 AIC로 사용 가능, NVIDIA A100 GPU가 이제 Google Cloud에 제공됩니다. 최초 발표 이후 약 한 달밖에 되지 않았다는 점을 고려하면 GPU가 주요 퍼블릭 클라우드로 이동하는 것은 정말 빠른 일입니다. Google은 Accelerator-Optimized VM(A100) 인스턴스 제품군에 A2 또는 Ampere GPU를 도입한 최초의 주요 퍼블릭 클라우드입니다.

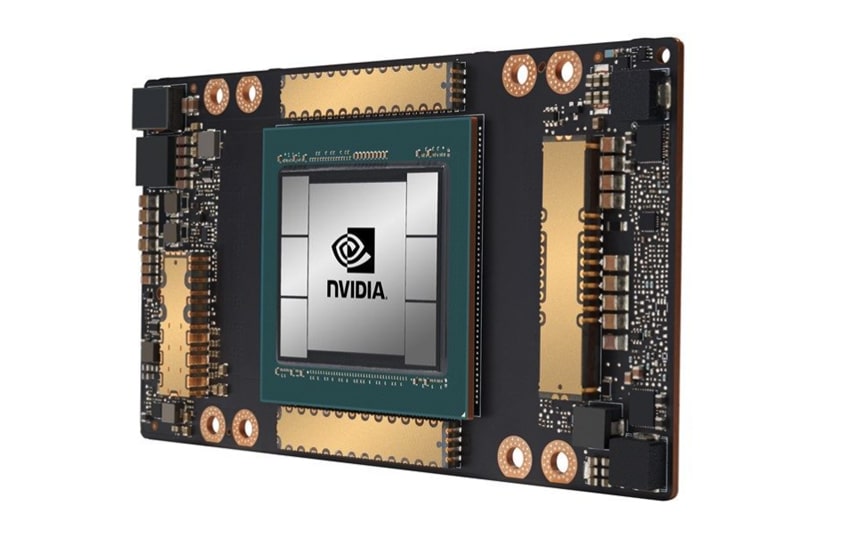

초기 발표에서 언급했듯이 NVIDIA의 첫 번째 7nm GPU는 NVIDIA A100입니다. A100은 NVIDIA의 Ampere 아키텍처를 기반으로 하며 54억 개의 트랜지스터를 포함합니다. 이전 NVIDIA 데이터 센터 GPU와 마찬가지로 A100에는 Tensor 코어가 포함되어 있습니다. Tensor 코어는 추론에 일반적으로 사용되는 유형의 행렬 곱셈 및 덧셈 계산을 신속하게 수행하도록 특별히 설계된 GPU의 특수 부품입니다. 더 강력해진 새로운 GPU와 함께 새롭고 더 강력한 Tensor 코어가 제공됩니다. 이전에 NVIDIA의 Tensor 코어는 최대 100비트 부동 소수점 숫자만 지원할 수 있었습니다. AXNUMX은 XNUMX비트 부동 소수점 연산을 지원하여 훨씬 더 정밀합니다.

여러 클라우드 사용 사례에는 특히 AI 교육 및 추론, 데이터 분석, 과학 컴퓨팅, 유전체학, 에지 비디오 분석, 5G 서비스 등 GPU가 제공할 수 있는 컴퓨팅 성능 유형이 필요합니다. 새로운 NVIDIA A100 GPU는 이전 제품에 비해 교육 및 추론 성능을 20배 향상시킬 수 있으므로 위의 경우에 이상적입니다.

Google Compute Engine은 A100을 확장 AI 교육 및 과학 컴퓨팅에서 추론 애플리케이션 확장, 실시간 대화형 AI 구현에 이르기까지 다양한 용도로 활용할 예정입니다. 새 인스턴스인 A2 VM은 다양한 크기의 워크로드에서 작동할 수 있습니다. 이 인스턴스는 CUDA 지원 기계 학습 교육 및 추론, 데이터 분석, 고성능 컴퓨팅 전반에서 작동합니다. 대규모 워크로드를 위해 Google은 2개의 A16 GPU와 함께 제공되는 a16-megagpu-100g 인스턴스를 제공하여 총 640GB의 GPU 메모리와 1.3TB의 시스템 메모리를 제공하며 모두 최대 9.6TB/s의 집계로 NVSwitch를 통해 연결됩니다. 대역폭. 그렇게 많은 전력이 필요하지 않은 고객을 위해 더 작은 A2 VM도 있습니다.

가까운 시일 내에 Google Cloud는 Google Kubernetes Engine, Cloud AI Platform 및 기타 Google Cloud 서비스에 대한 A100 지원을 출시할 예정입니다.

StorageReview에 참여

뉴스레터 | 유튜브 | 팟캐스트 iTunes/스포티 파이 | 인스타그램 | 트위터 | 페이스북 | RSS 피드