OCP(Open Compute Project)는 플랫폼에 Wiwynn ES200 에지 서버와 NVIDIA HGX-H100 GPU 베이스보드를 추가한다고 발표했습니다.

OCP(Open Compute Project)는 플랫폼에 Wiwynn ES200 에지 서버와 NVIDIA HGX-H100 GPU 베이스보드를 추가한다고 발표했습니다.

Wiwynn의 짧은 심도 에지 서버는 특히 즉각적인 AI 추론, 현장 데이터 분석 및 다중 채널 비디오 처리와 같은 애플리케이션을 위해 에지 사이트에서 컴퓨팅 성능에 대한 증가하는 수요를 처리하도록 설계되었습니다.

NVIDIA의 HGX-H100 GPU 베이스보드 물리적 사양은 OCP의 OAI 하위 프로젝트가 HGX를 활용하고 AI 및 HPC 애플리케이션의 고성능 컴퓨팅을 위한 비용 효율적, 고효율, 확장 가능한 플랫폼 및 시스템 사양을 개발하는 능력을 개선하는 데 도움이 될 것으로 예상됩니다.

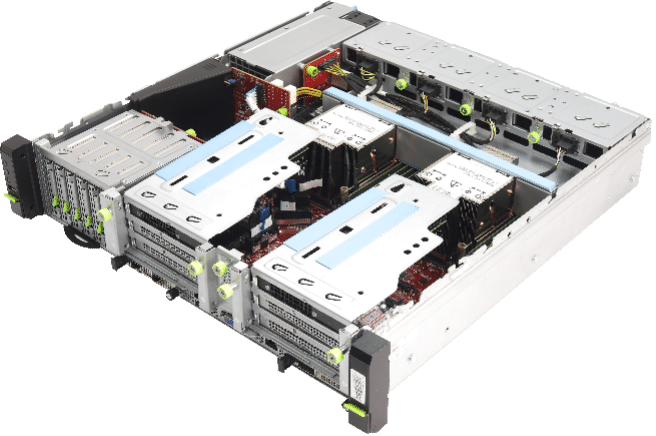

Wiwynn ES200 에지 서버

Wiwynn ES200은 2세대 Intel Xeon Scalable 프로세서로 구동되는 3U 듀얼 소켓 에지 서버입니다. NUMA 균형을 통해 설치된 각 프로세서의 컴퓨팅 성능을 제공하여 CPU 간에 통신 병목 현상을 일으키지 않고 서로 다른 워크로드를 개별적으로 처리할 수 있습니다.

또한 4개의 이중 폭 애드인 카드를 장착할 수 있는 추가 PCIe Gen16 xXNUMX 슬롯이 있습니다. 이것은 시스템에 많은 유연성을 추가하여 AI 추론 가속, 비디오 트랜스코딩, 데이터 분석과 같은 사용 사례와 추가 네트워크 연결이 필요한 사용 사례에 이상적입니다. 다음을 포함한 유연한 스토리지 모듈이 특징입니다. EDSFF(E1.S) 또는 U.2 SSD 및 3.0개의 OCP NIC 200 카드를 사용하여 ESXNUMX이 인상적인 로컬 데이터 처리 및 고대역폭 네트워크 연결을 생성할 수 있습니다.

ES200은 또한 NEBS-3과 호환되며 깊이가 짧은 소형 폼 팩터를 특징으로 합니다. 또한 Wiwynn은 어려운 작동 조건에서도 원활하게 실행할 수 있으며 다양한 엣지 사이트에 적합할 수 있음을 나타냅니다.

Wiwynn ES200 에지 서버 노드 사양

| 노드 사양 | |

| 프로세서 | 3세대 Intel Xeon 확장 가능 프로세서, TDP 250W/270W |

| 프로세서 소켓 | 2 |

| 칩셋 | 인텔 C621A 시리즈 |

| 보안 | TPM v2.0(옵션) |

| 시스템 버스 | Intel UltraPath 상호 연결; 11.2GT/s |

| 메모리 | 16개의 DIMM 슬롯; DDR4 최대 3200MT/s 및 DIMM당 최대 64GB; 최대 12개의 DCPMM이 있는 2개의 DIMM 슬롯(Intel Barlow Pass) |

| 스토리지 | ‧ 온보드 2280/22110 M.2 SSD 모듈 슬롯 XNUMX개 ‧ U.2 15개(7/1mm) 또는 EDSFF E5.9.S 9.5개(XNUMX/XNUMXmm) |

| 확장 슬롯 | 최대 4개의 PCIe GenXNUMX 슬롯: ‧ 16개의 PCIe x8 FHFL 이중 너비 + XNUMX개의 PCIe xXNUMX FHHL ‧ PCIe x16 FHHL 슬롯 8개 + PCIe xXNUMX FHHL XNUMX개 ‧ 8개의 PCIe xXNUMX FHHL 슬롯은 필요에 따라 선택 사항입니다. 온보드 OCP 3.0 NIC x16 XNUMX개 |

| 관리 LAN | ‧ GbE 전용 BMC 포트 XNUMX개 |

| I / O 포트 | ‧ LED가 있는 전원 버튼 ‧ LED가 있는 UID 버튼 ‧ RST 버튼 ‧ USB 포트 XNUMX개 ‧ BMC 관리 포트(전면) ‧ VGA 포트(D-sub) |

| 섀시 사양 | |

| 크기 | 2U 랙; 86(H) x 440(W) x 450(D)(mm) |

| PSU | 핫 플러그 가능, 예비(1+1) 1600W CRPS |

| 부채 | 8038개의 7 이중 로터, 예비(1+XNUMX) |

| 무게 | 14.47kg |

| 환경 | ‧ 주변 작동 온도 범위: 섭씨 -5 ~ +55도

‧ 작동 및 보관 상대 습도: 10% ~ 90%(비응결) ‧ 보관 온도 범위: -40 ~ +70℃ |

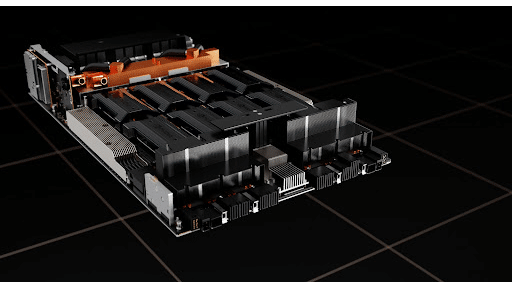

NVIDIA HGX-H100 베이스보드

NVIDIA HGX-H100은 가장 최근의 XNUMX개를 호스트하는 베이스보드입니다. 호퍼 GPU 모듈. HGX 베이스보드 물리적 사양은 물리적 차원 호스트 인터페이스, 관리 및 디버그 인터페이스와 같은 항목을 정의합니다. NVIDIA의 기여 패키지에는 베이스보드 물리적 사양, 베이스보드 입력/출력 핀 목록 및 핀 맵, 2D/3D 도면도 포함되어 있습니다.

OCP의 다음 목록은 NVIDIA HGX의 기여가 효율성, 확장성, 개방성 및 영향이라는 "네 가지 원칙"을 기반으로 구축되는 방식을 나타냅니다.

- 효율성 – 이것은 3세대 HGX 베이스보드 폼 팩터이며, 각 세대는 유사한 유효 전력을 소비하면서 ~3x-5x 더 높은 AI 교육 처리량을 제공했습니다. 그 결과 HGX 베이스보드는 이제 사실상의 표준이 되었으며 대부분의 글로벌 하이퍼스케일러는 AI 교육 및 추론을 위해 이 폼 팩터를 중심으로 설계합니다.

- 확장성 – 전 세계적으로 수십만 대의 HGX 시스템이 생산되고 있습니다. 이 폼 팩터를 위한 시스템 및 인클로저는 안정적이고 대규모로 구축됩니다. HGX 사양에는 대규모 서비스를 위한 물리적 차원, 모니터링/디버깅을 위한 관리 인터페이스 등이 포함됩니다.

- 개방성 – HGX 기반 시스템은 전 세계적으로 가장 일반적인 AI 교육 플랫폼입니다. 많은 OEM/ODM이 HGX 기반 AI 시스템을 구축했습니다. 이 HGX 물리적 사양의 기여로 OAI 그룹은 UBB2.0을 HGX 사양과 최대한 융합할 것입니다. OEM/ODM은 동일한 베이스보드 치수, 호스트 인터페이스, 관리 인터페이스, 전원 공급 등과 같은 UBB/HGX와 같은 베이스보드에서 서로 다른 가속기로 동일한 시스템 설계를 활용할 수 있습니다.

- 영향 – NVIDIA HGX 플랫폼은 사실상 AI 교육 플랫폼의 글로벌 표준이 되었습니다. 이 HGX 베이스보드 폼 팩터를 열면 다른 AI 가속기 공급업체가 시스템 및 인클로저의 HGX 에코시스템을 활용할 수 있습니다. 이는 다른 AI 공급업체가 기존 인프라를 활용하고 솔루션을 더 빨리 채택하도록 가속화할 것입니다. 이는 AI/HPC 분야의 혁신을 더욱 가속화합니다.

StorageReview에 참여

뉴스레터 | 유튜브 | 팟캐스트 iTunes/스포티 파이 | 인스타그램 | 트위터 | 페이스북 | 틱톡 서비스 | RSS 피드