최신 MLPerf 결과 AI 추론을 위해 클라우드에서 에지까지 최고의 성능과 효율성을 제공하는 NVIDIA와 함께 발표되었습니다. MLPerf는 독립적인 타사 벤치마크로서 AI 성능에 대한 유용한 측정으로 남아 있습니다. NVIDIA의 AI 플랫폼은 최신 MLPerf Inference 3.0 벤치마크를 포함하여 MLPerf가 시작된 이래로 교육 및 추론 분야에서 XNUMX위를 차지했습니다.

최신 MLPerf 결과 AI 추론을 위해 클라우드에서 에지까지 최고의 성능과 효율성을 제공하는 NVIDIA와 함께 발표되었습니다. MLPerf는 독립적인 타사 벤치마크로서 AI 성능에 대한 유용한 측정으로 남아 있습니다. NVIDIA의 AI 플랫폼은 최신 MLPerf Inference 3.0 벤치마크를 포함하여 MLPerf가 시작된 이래로 교육 및 추론 분야에서 XNUMX위를 차지했습니다.

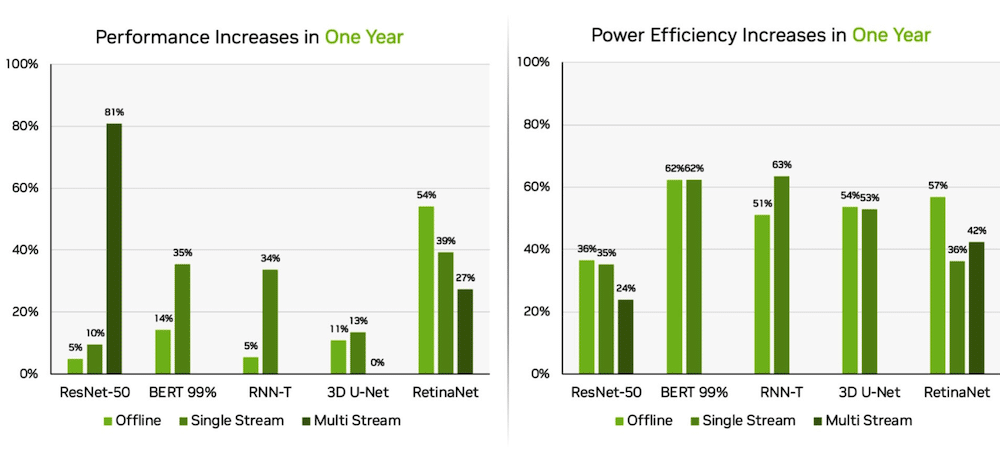

소프트웨어 최적화 덕분에 DGX H100 시스템에서 실행되는 NVIDIA H100 Tensor Core GPU는 AI 추론의 모든 테스트에서 54월 데뷔보다 100% 향상된 최고의 성능을 제공했습니다. 의료 분야에서 H31 GPU는 의료 이미징을 위한 MLPerf 벤치마크인 3D-UNet에서 XNUMX%의 성능 향상을 제공했습니다.

9680X H8 GPU가 장착된 Dell PowerEdge XE100

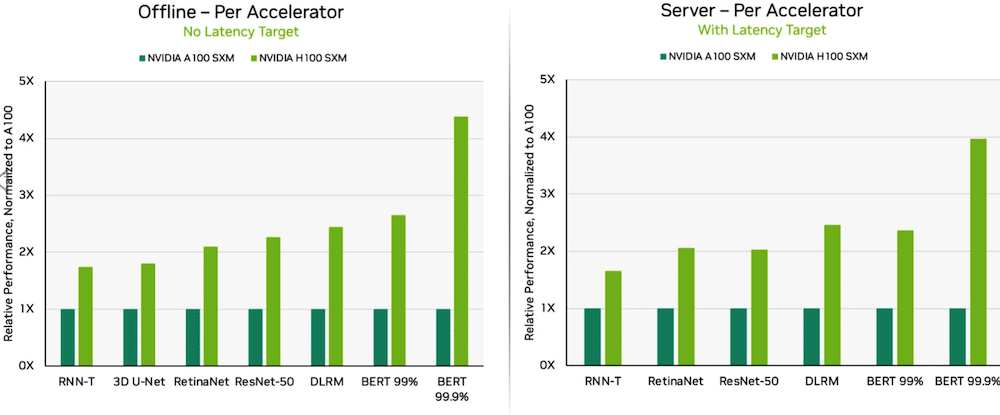

Transformer Engine으로 구동되는 H100 GPU는 Hopper 아키텍처를 기반으로 BERT에서 탁월했습니다. BERT는 Google에서 개발한 자연어 처리용 모델로 텍스트의 양방향 표현을 학습하여 다양한 작업에서 라벨이 지정되지 않은 텍스트의 문맥적 이해를 크게 향상시킵니다. 이는 RoBERTa, ALBERT 및 DistilBERT와 같은 BERT와 유사한 전체 모델 제품군의 기반입니다.

Generative AI를 통해 사용자는 텍스트, 이미지, 3D 모델 등을 빠르게 만들 수 있습니다. 신생 기업에서 클라우드 서비스 제공업체에 이르기까지 기업들은 새로운 비즈니스 모델을 가능하게 하고 기존 비즈니스 모델의 속도를 높이기 위해 제너레이티브 AI를 채택하고 있습니다. 최근 뉴스에 등장한 생성 AI 도구는 쿼리 및 입력에 따른 즉각적인 응답을 기대하는 수백만 명이 사용하는 ChatGPT입니다.

딥 러닝이 모든 곳에 배포됨에 따라 공장 현장에서 온라인 추천 시스템에 이르기까지 추론 성능이 매우 중요합니다.

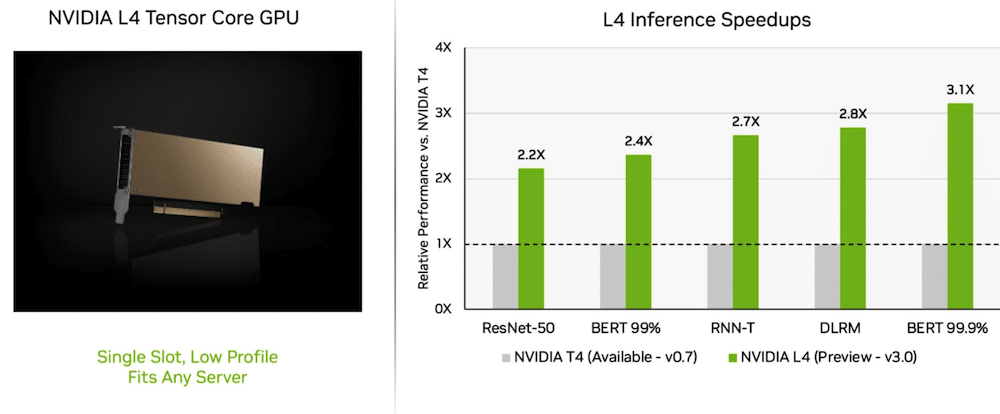

놀라운 성능을 제공하는 L4 GPU

처녀항해에서, 엔비디아 L4 Tensor Core GPU는 이전 세대 T3 GPU보다 4배 이상 빠른 속도로 실행되었습니다. 로우 프로파일 폼 팩터에 패키지된 L4 GPU 가속기는 거의 모든 서버 플랫폼에서 높은 처리량과 낮은 대기 시간을 제공하도록 설계되었습니다. L4 Tensor GPU는 모든 MLPerf 워크로드를 실행했으며 FP8 형식에 대한 지원 덕분에 성능에 굶주린 BERT 모델에서 결과가 뛰어났습니다.

뛰어난 AI 성능 외에도 L4 GPU는 최대 10배 더 빠른 이미지 디코딩, 최대 3.2배 더 빠른 비디오 처리, 4배 이상 더 빠른 그래픽 및 실시간 렌더링 성능을 제공합니다. 몇 주 전에 GTC에서 발표된 가속기는 시스템 제조업체와 클라우드 서비스 제공업체에서 사용할 수 있습니다.

무슨 네트워크 사업부?

NVIDIA의 전체 스택 AI 플랫폼은 새로운 MLPerf 테스트인 네트워크 분할 벤치마크에서 그 가치를 보여주었습니다!

네트워크 부문 벤치마크는 데이터를 원격 추론 서버로 스트리밍합니다. 기업 방화벽 뒤에 저장된 데이터로 클라우드에서 AI 작업을 실행하는 기업 사용자의 일반적인 시나리오를 반영합니다.

BERT에서 원격 NVIDIA DGX A100 시스템은 최대 로컬 성능의 최대 96%를 제공했으며 CPU가 일부 작업을 완료하기를 기다리는 동안 부분적으로 느려졌습니다. GPU로만 처리되는 컴퓨터 비전용 ResNet-50 테스트에서 100%에 도달했습니다.

NVIDIA Quantum Infiniband 네트워킹, NVIDIA ConnectX SmartNIC 및 NVIDIA GPUDirect와 같은 소프트웨어가 테스트 결과에서 중요한 역할을 했습니다.

Orin은 가장자리에서 향상됩니다.

이와는 별도로 NVIDIA Jetson AGX Orin 시스템 온 모듈은 작년 결과에 비해 에너지 효율성이 최대 63%, 성능이 81% 향상되었습니다. Jetson AGX Orin은 배터리 구동 시스템을 포함하여 저전력 수준의 제한된 공간에서 AI가 필요할 때 추론을 제공합니다.

더 적은 전력을 필요로 하는 더 작은 모듈인 Jetson Orin NX 16G는 벤치마크에서 좋은 성능을 보였습니다. Jetson Xavier NX 프로세서 성능의 최대 3.2배를 제공했습니다.

엔비디아 AI 생태계

MLPerf 결과는 NVIDIA AI가 머신 러닝의 광범위한 생태계에 의해 지원됨을 보여줍니다. Microsoft Azure 클라우드 서비스 및 시스템 제조업체, ASUS, Dell Technologies, GIGABYTE, H3C, Lenovo, Nettrix, Supermicro, xFusion 등 XNUMX개 회사가 이번 라운드에서 NVIDIA 플랫폼에 대한 결과를 제출했습니다. 그들의 작업은 사용자가 클라우드와 자체 데이터 센터에서 실행되는 서버 모두에서 NVIDIA AI로 뛰어난 성능을 얻을 수 있음을 보여줍니다.

StorageReview에 참여

뉴스레터 | 유튜브 | 팟캐스트 iTunes/스포티 파이 | 인스타그램 | 트위터 | 틱톡 서비스 | RSS 피드