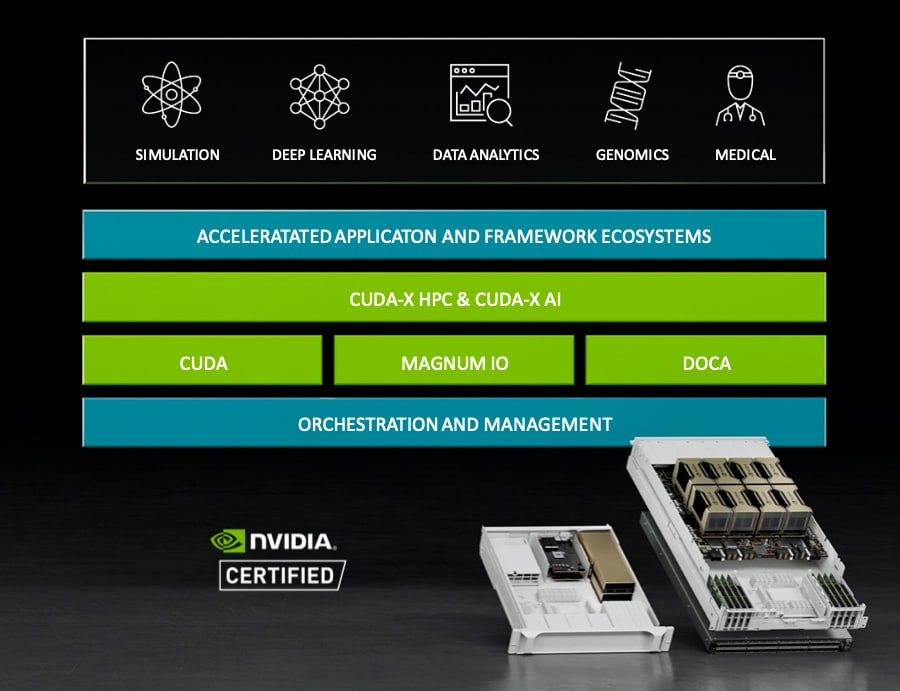

오늘 NVIDIA는 일부 글로벌 파트너의 도움을 받아 새로운 NVIDIA HGX A100 시스템을 출시한다고 발표했습니다. 새로운 시스템은 NVIDIA A100 80GB PCIe GPU, NVIDIA NDR 400G InfiniBand 네트워킹 및 NVIDIA Magnum IO GPUDirect 스토리지 소프트웨어와 같은 NVIDIA 요소를 추가하여 AI 및 HPC를 가속화할 계획입니다. 이 새로운 HGX 시스템은 Atos, Dell Technologies, Hewlett Packard Enterprise(HPE), Lenovo, Microsoft Azure 및 NetApp을 포함한 파트너에 의해 출시될 예정입니다.

오늘 NVIDIA는 일부 글로벌 파트너의 도움을 받아 새로운 NVIDIA HGX A100 시스템을 출시한다고 발표했습니다. 새로운 시스템은 NVIDIA A100 80GB PCIe GPU, NVIDIA NDR 400G InfiniBand 네트워킹 및 NVIDIA Magnum IO GPUDirect 스토리지 소프트웨어와 같은 NVIDIA 요소를 추가하여 AI 및 HPC를 가속화할 계획입니다. 이 새로운 HGX 시스템은 Atos, Dell Technologies, Hewlett Packard Enterprise(HPE), Lenovo, Microsoft Azure 및 NetApp을 포함한 파트너에 의해 출시될 예정입니다.

NVIDIA는 수년간 고성능 GPU를 만들어 왔습니다. 특히 HPC에서 떠오르는 AI 시장은 회사의 기술을 활용하기 위해 점점 더 많은 슈퍼컴퓨터를 구동했습니다. NVIDIA는 지난 몇 년 동안 DGX 및 HGX 모델로 HPC 서버와 워크스테이션을 만들어 왔습니다. 후자는 더 나은 성능을 위해 여러 NVIDIA IP를 한 지붕 아래에 모았습니다. 새로운 시스템은 NVIDIA가 제공하는 최신 및 최고의 기능을 통해 이를 한 번 더 수행합니다.

엔비디아 A100 80GB PCIe GPU

NVIDIA A100은 작년 GTC에서 발표되었습니다. 이 새로운 7nm GPU는 회사의 Ampere 아키텍처를 활용하고 54만 개의 트랜지스터를 포함합니다. NVIDIA는 NVIDIA A100 80GB PCIe GPU를 도입하여 제품을 빠르게 개선하여 메모리를 두 배로 늘렸습니다. A100 80GB PCIe GPU는 새로운 HGX A100 시스템의 첫 번째 부품입니다. 대용량 메모리와 높은 대역폭을 통해 더 많은 데이터와 더 큰 신경망을 메모리에 저장할 수 있습니다. 이는 노드 간 통신이 적고 에너지 소비가 적다는 것을 의미합니다. 높은 메모리는 또한 더 빠른 결과로 이어질 수 있는 더 높은 처리량을 허용합니다.

언급한 바와 같이 NVIDIA A100 80GB PCIe GPU는 회사의 Ampere 아키텍처로 구동됩니다. 이 아키텍처는 MIG라고도 하는 멀티 인스턴스 GPU를 특징으로 합니다. MIG는 더 작은 워크로드, 즉 AI 추론을 위한 가속화를 제공할 수 있습니다. 이 기능을 통해 사용자는 보장된 QoS로 컴퓨팅 및 메모리를 모두 축소할 수 있습니다.

NVIDIA A100 80GB PCIe GPU를 둘러싼 파트너로는 Atos, Cisco, Dell Technologies, Fujitsu, H3C, HPE, Inspur, Lenovo, Penguin Computing, QCT 및 Supermicro가 있습니다. AWS, Azure 및 Oracle을 포함하여 기술을 제공하는 몇 가지 클라우드 서비스가 있습니다.

NVIDIA NDR 400G InfiniBand 네트워킹

NVIDIA HGX A100 시스템 퍼즐의 두 번째 조각은 새로운 NVIDIA NDR 400G InfiniBand 스위치 시스템입니다. 다소 당연하게 들릴 수 있지만 HPC 시스템에는 매우 높은 데이터 처리량이 필요합니다. NVIDIA는 몇 년 전 거의 7억 달러에 Mellanox를 인수했습니다.. 그 이후로 NVIDIA의 Mellanox 이름을 천천히 단계적으로 제거하면서 신제품을 꾸준히 출시해 왔습니다. 작년에는 400배의 포트 밀도와 3배의 AI 가속 기능을 갖춘 NVIDIA NDR 32G InfiniBand가 출시되었습니다. 이것은 NVIDIA Quantum-2 고정 구성 스위치 시스템을 통해 새로운 HGX 시스템에 통합되고 있습니다. 이 시스템은 포트당 NDR 64Gb/s InfiniBand의 400개 포트 또는 NDR128의 200개 포트를 제공한다고 합니다.

회사에 따르면 새로운 NVIDIA Quantum-2 모듈식 스위치는 초당 2,048페타비트의 총 양방향 처리량으로 최대 400개의 NDR 4,096Gb/s InfiniBand 포트(또는 200개의 NDR1.64 포트)까지 확장 가능한 포트 구성을 제공합니다. 이는 5배 더 큰 확장성으로 이전 세대보다 6.5배 이상 향상되었음을 나타냅니다. DragonFly+ 네트워크 토폴로지를 사용하여 사용자는 백만 개 이상의 노드에 연결할 수 있습니다. 마지막으로 이 회사는 3세대 NVIDIA SHARP In-Network Computing 데이터 감소 기술을 추가하여 이전 세대에 비해 32배 더 높은 AI 가속을 볼 수 있다고 주장합니다.

NVIDIA Quantum-2 스위치는 이전 버전과 이전 버전 모두 호환됩니다. 제조 파트너로는 Atos, DDN, Dell Technologies, Excelero, GIGABYTE, HPE, Lenovo, Penguin, QCT, Supermicro, VAST 및 WekaIO가 있습니다.

매그넘 IO GPU다이렉트 스토리지

새로운 NVIDIA HDX A100 퍼즐의 마지막 조각은 새로운 Magnum IO GPUDirect 스토리지입니다. 이를 통해 GPU 메모리와 스토리지 간에 직접 메모리 액세스가 가능합니다. 이는 낮은 I/O 대기 시간, 네트워크 어댑터의 대역폭 사용, CPU에 미치는 영향 감소 등 여러 가지 이점이 있습니다. 현재 DDN, Dell Technologies, Excelero, HPE, IBM Storage, Micron, NetApp, Pavilion, ScaleFlux, VAST 및 WekaIO를 포함하여 여러 파트너가 Magnum IO GPUDirect Storage를 사용할 수 있습니다.

StorageReview에 참여

뉴스레터 | 유튜브 | 링크드인 | 인스타그램 | 트위터 | 페이스북 | 틱톡 서비스 | RSS 피드