슈퍼마이크로는 생성 AI 배치를 발전시키기 위한 새로운 솔루션 세트를 출시해 대규모 언어 모델(LLM)을 위한 인프라 발전에 중요한 진전을 이루었습니다. 이러한 SuperCluster 솔루션은 현재와 미래의 AI 수요를 지원하기 위한 핵심 구성 요소로 설계되었습니다.

슈퍼마이크로는 생성 AI 배치를 발전시키기 위한 새로운 솔루션 세트를 출시해 대규모 언어 모델(LLM)을 위한 인프라 발전에 중요한 진전을 이루었습니다. 이러한 SuperCluster 솔루션은 현재와 미래의 AI 수요를 지원하기 위한 핵심 구성 요소로 설계되었습니다.

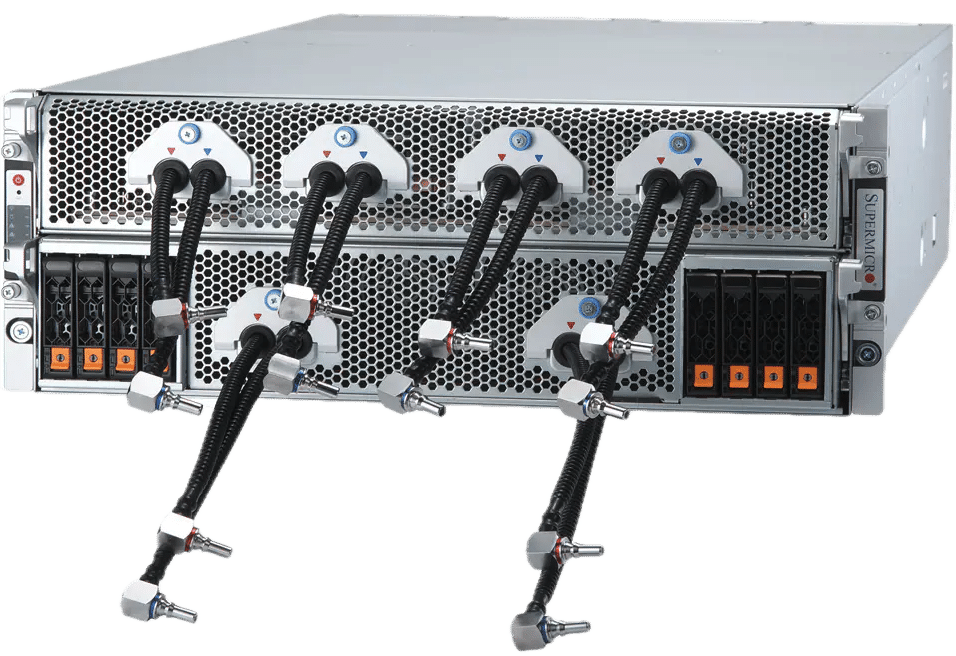

이 새 릴리스에는 생성적 AI 작업에 맞게 조정된 세 가지 SuperCluster 구성이 포함되어 있습니다. 옵션에는 집중적인 LLM 교육 및 대용량 LLM 추론을 위해 설계된 4U 수냉식 시스템과 8U 공냉식 설정이 포함됩니다. 또한 Supermicro NVIDIA MGX 시스템을 갖춘 1U 공랭식 변형은 클라우드 규모 추론 애플리케이션에 맞춰져 있습니다. 이러한 시스템은 LLM 추론을 위한 대규모 배치 크기 및 상당한 볼륨 처리 기능과 같은 기능을 자랑하며 LLM 교육에서 탁월한 성능을 제공하도록 구축되었습니다.

AI 클러스터 용량 확장

매월 최대 5,000개의 랙을 생산할 수 있는 능력을 갖춘 Supermicro는 완전한 생성 AI 클러스터를 신속하게 공급할 수 있는 위치에 있으며 고객에게 더 빠른 배송 속도를 약속합니다. 예를 들어 64노드 클러스터는 512개의 NVIDIA HGX H200 GPU를 통합하고 고속 NVIDIA Quantum-2 InfiniBand 및 Spectrum-X 이더넷 네트워킹을 활용하여 강력한 AI 교육 환경을 구현할 수 있습니다. NVIDIA AI Enterprise 소프트웨어와 함께 이 구성은 수조 개의 매개변수로 정교한 LLM을 교육하는 것을 목표로 하는 기업 및 클라우드 인프라에 이상적인 솔루션입니다.

냉각 및 성능 혁신

새로운 Supermicro 4U NVIDIA HGX H100/H200 8-GPU 시스템은 액체 냉각을 활용하여 8U 공냉식 시스템에 비해 밀도를 두 배로 높여 에너지 소비를 낮추고 데이터 센터의 총 소유 비용을 절감합니다. 이러한 시스템은 최대 성능을 위해 최적의 온도를 유지하는 효율적인 냉각 기술을 갖춘 차세대 NVIDIA Blackwell 아키텍처 기반 GPU를 지원합니다.

슈퍼클러스터 사양

Supermicro SuperClusters는 대규모 기반 모델을 훈련하고 클라우드 규모의 LLM 추론 인프라를 생성하기 위한 확장 가능한 솔루션입니다. 확장성이 뛰어난 네트워크 아키텍처를 갖춘 이러한 시스템은 32개 노드에서 수천 개 노드로 확장할 수 있어 원활한 확장성을 보장합니다. 고급 액체 냉각과 포괄적인 테스트 프로세스를 통합하면 운영 효율성과 효과가 보장됩니다.

Supermicro는 두 가지 기본 구성, 즉 소형 설치 공간에서 최대 4개의 GPU를 지원할 수 있는 512U 수냉식 시스템을 갖춘 SuperCluster와 대용량, 낮은 지연 시간 추론 작업을 위해 설계된 1U 공냉식 NVIDIA MGX 시스템을 갖춘 SuperCluster를 자세히 설명합니다. . 두 구성 모두 LLM 교육 및 추론에 필수적인 높은 네트워크 성능으로 강조됩니다.

사양에 대한 간략한 요약은 다음과 같습니다.

4개 랙에 5U 수냉식 시스템 또는 8개 랙에 9U 공랭식 시스템을 갖춘 SuperCluster

- 하나의 확장 가능한 장치에 256개의 NVIDIA H100/H200 Tensor Core GPU

- 공랭식 512 GPU, 64노드 솔루션과 동일한 설치 공간에서 256 GPU, 32노드를 지원하는 액체 냉각

- 하나의 확장 가능한 장치에 NVIDIA H20이 포함된 3TB HBM100 또는 NVIDIA H36이 포함된 3TB HBM200e

- 1:1 네트워킹은 각 GPU에 최대 400Gbps를 제공하여 최대 수조 개의 매개변수가 있는 대규모 언어 모델을 교육하기 위한 GPUDirect RDMA 및 스토리지를 활성화합니다.

- NVIDIA Quantum-400 InfiniBand 및 NVIDIA Spectrum-X 이더넷 플랫폼을 포함하여 확장성이 뛰어난 스파인-리프 네트워크 토폴로지를 갖춘 400G InfiniBand 또는 2GbE 이더넷 스위치 패브릭입니다.

- 업계 최고의 병렬 파일 시스템 옵션을 갖춘 맞춤형 AI 데이터 파이프라인 스토리지 패브릭

- 대규모로 AI 모델 배포를 가속화하는 새로운 NVIDIA NIM 추론 마이크로서비스를 지원하는 NVIDIA AI Enterprise 5.0 소프트웨어

1개 랙에 9U 공랭식 NVIDIA MGX 시스템을 갖춘 SuperCluster

- 하나의 확장 가능한 장치에 256개의 GH200 Grace Hopper 슈퍼칩

- 클라우드 규모, 대용량, 짧은 대기 시간 및 높은 배치 크기 추론에 적합한 최대 144GB의 HBM3e + 480GB의 LPDDR5X 통합 메모리로, 하나의 노드에 70B+ 매개변수 모델을 맞출 수 있습니다.

- 확장성이 뛰어난 스파인-리프 네트워크 토폴로지를 갖춘 400G InfiniBand 또는 400G 이더넷 스위치 패브릭

- 노드당 최대 8개의 내장 E1.S NVMe 스토리지 장치

- NVIDIA BlueField-3 DPU와 업계 최고의 병렬 파일 시스템 옵션을 갖춘 맞춤형 AI 데이터 파이프라인 스토리지 패브릭으로 각 GPU에 높은 처리량과 짧은 지연 시간의 스토리지 액세스 제공

- NVIDIA AI 엔터프라이즈 5.0 소프트웨어

Supermicro, NVIDIA Blackwell 아키텍처를 사용한 새로운 시스템과 랙으로 AI 포트폴리오 확장

Supermicro는 또한 대규모 생성 AI를 목표로 하는 NVIDIA의 최신 데이터 센터 혁신을 포함하여 AI 시스템 제품의 확장을 발표했습니다. 이러한 신기술 중에는 NVIDIA GB200 Grace Blackwell Superchip과 B200 및 B100 Tensor Core GPU가 있습니다.

이러한 발전을 수용하기 위해 Supermicro는 기존 제품을 원활하게 업그레이드하고 있습니다. 엔비디아 HGX H100/H200 NVIDIA HGX B8 100-GPU 및 B8을 통합하는 200-GPU 시스템입니다. 또한, NVIDIA HGX 라인업은 200개의 NVIDIA Blackwell GPU가 장착된 포괄적인 랙 수준 솔루션을 포함하여 NVIDIA GB72을 갖춘 새로운 모델로 강화될 것입니다. 이러한 발전에 더해, 슈퍼마이크로는 새로운 4U NVIDIA HGX B200 8-GPU 수냉식 시스템을 도입하고 있으며, 직접 칩 수냉식 기술을 활용하여 최신 GPU의 증가된 열 수요를 처리하고 NVIDIA의 전체 성능 기능을 활용합니다. 블랙웰 기술.

새로운 Supermicro의 GPU 최적화 시스템은 곧 출시될 예정이며, NVIDIA Blackwell B200 및 B100 Tensor Core GPU와 완벽하게 호환되며 최신 NVIDIA AI Enterprise 소프트웨어에 대해 인증되었습니다. Supermicro 라인업에는 NVIDIA HGX B100 및 B200 8-GPU 시스템부터 최대 20개의 B100 GPU를 수용할 수 있는 SuperBlade에 이르기까지 다양한 구성이 포함되어 광범위한 AI 애플리케이션 전반에 걸쳐 다양성과 고성능을 보장합니다. 이러한 시스템에는 고급 NVIDIA NVLink 상호 연결 기술을 갖춘 최초의 NVIDIA HGX B200 및 B100 8-GPU 모델이 포함됩니다. Supermicro는 LLM에 대한 교육 결과를 3배 더 빠르게 제공하고 까다로운 AI 워크로드를 위한 확장 가능한 클러스터링을 지원하여 AI 계산 효율성과 성능에 있어 상당한 도약을 이룰 준비가 되어 있음을 나타냅니다.

StorageReview에 참여

뉴스레터 | 유튜브 | 팟캐스트 iTunes/스포티 파이 | 인스타그램 | 트위터 | 틱톡 서비스 | RSS 피드