SAS 616iSD 10G는 JetStor에서 제공하는 광범위한 블록 수준 스토리지 어레이 라인의 일부입니다. iSCSI 616iSD는 48U 인클로저에 16개의 3.5인치 베이를 통해 최대 3TB의 스토리지를 제공합니다. JetStor는 듀얼 중복 활성/활성 RAID 컨트롤러와 10개의 342GbE 포트(컨트롤러당 64개)를 제공합니다. 각 컨트롤러는 Intel IOP48 616비트 Chevelon 듀얼 코어 스토리지 프로세서로 구동되며 패리티 지원 ASIC, iSCSI 지원 엔진 및 TOE(TCP 오프로드 엔진)와 같은 기능을 포함합니다. 716TB가 부족한 경우 240개의 JBOD 선반(SASXNUMXJ)으로 XNUMXiSD를 확장하여 어레이당 최대 용량을 XNUMXTB까지 확장할 수 있습니다.

본질적으로 JetStor SAS 616iSD 10G는 단순하도록 설계되었습니다. 전원을 켜고 이더넷 패브릭에 대한 액세스 권한을 부여하면 됩니다. JetStor의 단순한 디자인은 내부적으로 케이블이 없는 디자인과 같은 기능을 통해 전체적으로 작동하며, 아마도 본 적이 없을 수도 있지만 문제가 발생할 경우 더 쉽게 서비스를 제공합니다. 또한 이 장치에는 이중 전원 공급 장치, 터보 냉각 팬 및 장치 수명 동안 전화 및 이메일 지원과 함께 모든 구성 요소에 적용되는 XNUMX년 보증이 포함됩니다.

Jetstor SAS 616iSD 10G 사양

- 호스트 포트: iSCSI 프로토콜을 사용하는 10개의 XNUMX기가비트 이더넷, 중복 컨트롤러당 SFP+ 호스트 인터페이스

- 디스크 인터페이스: 3Gb/s SAS

- 제공되는 하드 드라이브: 300GB(15k), 450GB(15k), 600GB SAS(15k), 1TB(7.2k), 2TB(7.2k) 및 3TB(7.2k)

- 드라이브: 16개(3.5인치)/160개의 3Gb/s SAS 확장 포트를 통한 최대 XNUMX개

- 지원되는 RAID 모드: RAID 0, 0+1, 1, 3, 5, 6, 10, 30, 50 및 RAID 60, 글로벌 핫 스페어 디스크, 자동 재구축

- 각 컨트롤러의 Intel IOP342 64비트 Chevelon 듀얼 코어 스토리지 프로세서

- 2GB 캐시(기본값) – 4GB(옵션) / DDR2-800 ECC 등록 SDRAM

- 선택적 배터리 백업

- 45개의 RJXNUMX/이더넷 관리/모니터 포트

- SMTP 관리자 및 SNMP 에이전트

- 전원 및 냉각

- XNUMX개의 터보 팬

- 전원 110 또는 220VAC, ±20% @ 6amps / 3amps 피크

- 460개의 XNUMXW PS/팬 모듈(PFC 포함)

- 환경

- 상대 습도 10% ~ 85% 비응축(작동)

- 작동 온도 50°F ~ 104°F

- 3U 물리적 치수(W x D x H) 폭 19″, 깊이 22″, 높이 5.25″

- 무게(드라이브 제외) 40lb. / 18kg.

- 지원되는 운영 체제: VMWare ESX Server, vSphere, Windows Server 2008, Windows Server 2003, XenServer, Oracle/Solaris, Linux, MAC OS X 및 기타 발표 예정

- 보증: 3년 논리, 3년 전원 공급 장치, 5년 SAS 드라이브, 3년 또는 5년 SATA 드라이브

설계 및 구축

JetStor SAS 616iSD는 16베이 10GbE 장착 듀얼 컨트롤러 SAN입니다. 616iSD의 전면에는 웹 기반 관리를 위해 적중할 IP를 추적하기 위해 라우터나 DHCP에 뛰어들 필요 없이 현재 관리 IP와 같은 정보를 표시하는 기본 사용자 인터페이스가 있습니다. 전면 콘솔에는 LCD와 로컬에서 SAN에 액세스하기 위해 메뉴를 드릴다운할 수 있는 소수의 버튼이 포함되어 있습니다. JetStor 모델의 하드웨어 측면을 관리하려면 전체 표면을 뒤집고 아래에 있는 3.5개의 XNUMX인치 드라이브 베이에 액세스하십시오.

검토한 JetStor SAS 616iSD 10G에는 XNUMX개가 포함되어 있습니다. 씨게이트 치타 15K.7 ST3600057SS 600GB 그러나 시스템은 다양한 15K 및 7,200RPM 드라이브로 구성될 수 있습니다. 각 드라이브는 자체 핫스왑 캐디에 장착되어 드라이브 장애 시 쉽게 교체할 수 있습니다. 각 드라이브 트레이에는 생산 환경에서 실수로 잘못된 드라이브가 배출되는 것을 방지하기 위한 기본 잠금 장치도 포함되어 있습니다.

SAS 616iSD 10G를 랙에 쉽게 장착할 수 있도록 JetStor에는 몇 분 안에 쉽게 설치할 수 있는 기본 미끄럼 방지 레일 키트가 포함되어 있습니다. SAN의 무게는 "팀 리프트" 범주에 속하기 쉬우므로 레일을 장착한 후 SAN을 랙으로 들어 올릴 때 도움을 받는 것이 가장 좋습니다. 레일은 수신 슬롯으로 쉽게 향할 수 있으며 우리의 Eaton 42U 랙 일단 장착되면 처짐의 징후가 없습니다.

JetStor SAS 616iSD 10G의 후면에서 보면 중복 디스크 컨트롤러와 전원 공급 장치가 보입니다. 이 두 가지 모두 내장된 레버와 핸들 메커니즘을 사용하여 엄지 나사로 신속하게 제거하여 제자리에 단단히 고정시킵니다. 후면의 인터페이스 연결에는 컨트롤러당 8088개의 SFP+ 연결(리뷰 장치의 광섬유 트랜시버로 채워진 각 포트 716개), 컨트롤러당 232개의 관리 포트, 외부 JBOD 확장을 위한 컨트롤러당 XNUMX개의 SFF-XNUMX SAS 커넥터가 포함됩니다. SASXNUMXJ를 사용합니다. 다른 장비와의 통신을 허용하는 UPS 및 RS-XNUMX 커넥터도 있습니다.

드물지만 컨트롤러를 교체해야 하는 경우 랙에 설치했을 때 어셈블리를 제거하고 다시 삽입하는 데 60초도 걸리지 않았습니다. 잠금 레버에 나비 나사가 있지만 JetStor는 여전히 현장 기술자가 일자 드라이버로 나사를 조여 모든 것이 안전하게 설치되도록 할 것을 권장합니다.

전원 공급 장치의 크기가 클수록 테스트 랙 뒤에 있는 주변 케이블과 장비를 치우려면 더 많은 노력이 필요했지만 제거 및 재설치가 간단했습니다.

SAS 616iSD를 구성하기 위해 제공되는 JetStor 웹 관리 도구는 따라하기 쉽지만 설계 및 구현 측면에서 상당히 기본적입니다. 처음 로그인할 때부터 시스템을 작동시키는 것은 매우 쉬웠지만 인터페이스가 때때로 느려 보였습니다. SMB 또는 소규모 엔터프라이즈 환경의 경우 이러한 플랫폼 중 몇 개를 함께 관리하는 것이 쉬울 것입니다. 소수 이상의 환경에서는 개별적으로 구성하기 위해 각 장치에 로그인해야 하는 몇 가지 문제가 발생할 수 있습니다.

테스트 배경 및 유사 항목

엔터프라이즈 하드웨어를 테스트할 때 환경은 이를 평가하는 데 사용되는 테스트 프로세스만큼 중요합니다. StorageReview에서 우리는 우리가 테스트하는 장치가 궁극적으로 향하게 될 많은 데이터 센터에서 발견되는 것과 동일한 하드웨어 및 인프라를 제공합니다. 여기에는 엔터프라이즈 서버는 물론 네트워킹, 랙 공간, 전력 조절/모니터링, 장치 성능을 제대로 평가하기 위한 동급 하드웨어와 같은 적절한 인프라 장비가 포함됩니다. 우리의 리뷰는 우리가 테스트하는 장비 제조업체에 의해 지불되거나 통제되지 않습니다.

StorageReview 10GbE 엔터프라이즈 테스트 플랫폼:

- 2 x Intel Xeon X5650(2.66GHz, 12MB 캐시)

- Windows Server 2008 Standard Edition R2 SP1 64비트 및 CentOS 6.2 64비트

- 인텔 5500+ ICH10R 칩셋

- 메모리 – 8GB(2GB 4개) 1333Mhz DDR3 등록 RDIMM

Mellanox SX1036 10/40Gb 이더넷 스위치 및 하드웨어

- 36GbE 포트 40개(64GbE 포트 최대 10개)

- QSFP 스플리터 케이블 40GbE - 4x10GbE

- Mellanox ConnectX-3 EN PCIe 3.0 트윈 10G 이더넷 어댑터

당사의 현재 10/40Gb 이더넷 SAN 및 NAS 테스트 인프라는 Mellanox의 240포트 3/36GbE 스위치를 통해 연결된 Mellanox ConnectX-10 PCIe 어댑터가 장착된 Lenovo ThinkServer RD40 테스트 플랫폼으로 구성됩니다. 이 환경에서는 네트워킹 장비 자체가 아니라 우리가 테스트 중인 스토리지 장치가 I/O 병목 현상이 될 수 있습니다.

엔터프라이즈 종합 워크로드 분석

스토리지 어레이 검토를 위해 우리는 스레드당 8개의 대기 중인 대기열이 있는 8개의 스레드의 과부하로 사전 조건을 지정한 다음 여러 스레드/대기열 깊이 프로파일에서 설정된 간격으로 테스트하여 사용량이 적은 경우와 많은 경우의 성능을 보여줍니다. 읽기 활동이 100%인 테스트의 경우 100% 쓰기로 전환되었지만 사전 조건은 동일한 워크로드로 이루어집니다.

사전 조건화 및 기본 정상 상태 테스트:

- 처리량(읽기+쓰기 IOPS 집계)

- 평균 대기 시간(읽기+쓰기 대기 시간을 함께 평균화)

- 최대 대기 시간(최대 읽기 또는 쓰기 대기 시간)

- 대기 시간 표준 편차(함께 평균화된 읽기+쓰기 표준 편차)

현재 Enterprise Synthetic Workload Analysis에는 실제 활동을 반영하려고 시도할 수 있는 공통 순차 및 임의 프로필이 포함되어 있습니다. 이러한 항목은 과거 벤치마크와 어느 정도 유사하고 최대 4K 읽기 및 쓰기 속도와 기업용 드라이브에 일반적으로 사용되는 8K 70/30과 같이 널리 게시된 값과 비교하기 위한 공통 기반으로 선택되었습니다. 또한 다양한 전송 크기를 제공하는 기존 파일 서버 및 웹 서버를 포함하여 두 가지 레거시 혼합 워크로드를 포함했습니다. 이 마지막 두 개는 해당 범주의 애플리케이션 벤치마크가 우리 사이트에 소개됨에 따라 단계적으로 제거되고 새로운 합성 워크로드로 대체됩니다.

- 1024K(순차)

- 100% 읽기 또는 100% 쓰기

- 8K(순차)

- 100% 읽기 또는 100% 쓰기

- 4K(랜덤)

- 100% 읽기 또는 100% 쓰기

- 8K 70/30(랜덤)

- 70% 읽기, 30% 쓰기

- 파일 서버(랜덤)

- 80% 읽기, 20% 쓰기

- 10% 512b, 5% 1k, 5% 2k, 60% 4k, 2% 8k, 4% 16k, 4% 32k, 10% 64k

- 웹서버(랜덤)

- 100% 읽기

- 22% 512b, 15% 1k, 8% 2k, 23% 4k, 15% 8k, 2% 16k, 6% 32k, 7% 64k, 1% 128k, 1% 512k

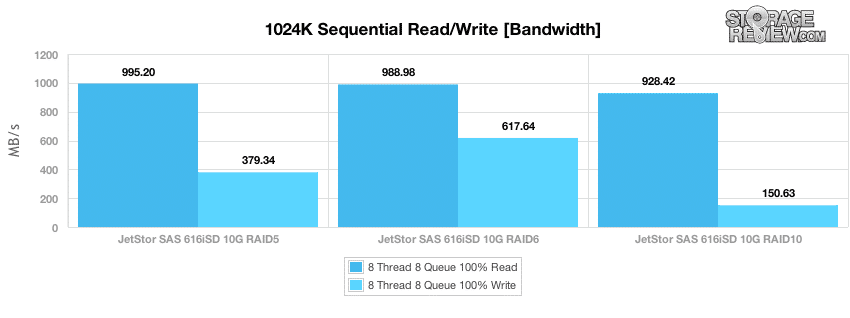

벤치마킹을 시작하기 위해 각각 8개의 I/O 대기열이 있는 8개의 스레드 로드가 있는 대형 블록 순차 성능을 살펴봅니다. 이는 네트워크를 통한 SAN의 포화 속도를 보여주도록 설계되었습니다. 컨트롤러당 하나씩 MPIO를 사용하는 두 개의 연결을 통한 10GbE입니다. 테스트에서 최대 순차 성능은 RAID5보다 RAID6 및 RAID10 모드에서 선호되었습니다. 속도는 RAID995의 경우 최고 5MB/s에서 RAID928의 경우 10MB/s까지 다양했습니다. 쓰기 성능은 RAID6에서 가장 강력했으며 617MB/s, RAID5는 379MB/s, RAID10은 150MB/s에 불과했습니다.

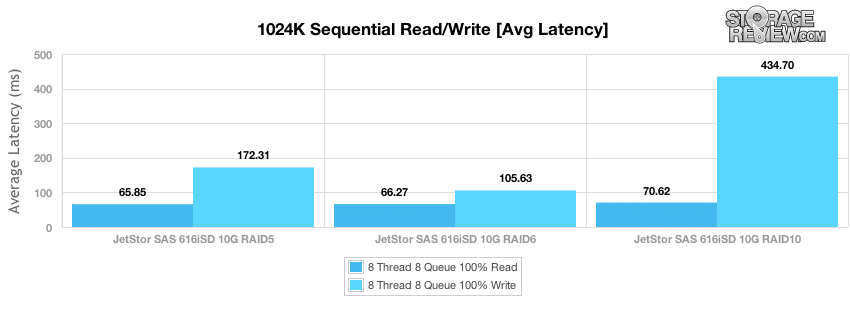

순차 전송 성능 중 평균 대기 시간은 65k 읽기 테스트에서 RAID5의 경우 66ms, RAID6의 경우 70ms, RAID10의 경우 1024ms, 쓰기 세그먼트의 경우 RAID105의 경우 6ms, RAID172의 경우 5ms, RAID434의 경우 10ms로 측정되었습니다.

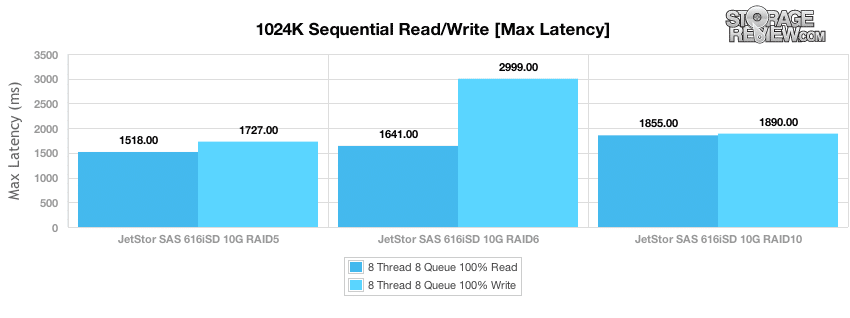

평균 대기 시간은 전체 성능을 살펴볼 때 고려해야 할 중요한 메트릭이지만 최악의 대기 시간이 무엇인지 아는 것도 똑같이 중요합니다. JetStor SAS 616iSD의 경우 최대 읽기 응답 시간은 읽기 작업에서 1,518-1,855ms로 유지되었고 쓰기 작업에서는 1,727-2,999ms로 유지되었습니다.

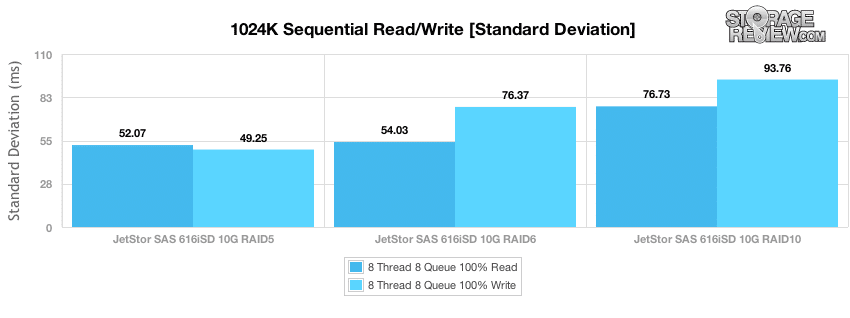

테스트에서 마지막으로 살펴보는 지표는 대기 시간 표준 편차로, 테스트 기간 동안 대기 시간 확산이 얼마나 밀접하게 그룹화되었는지 확인합니다. RAID5의 JetStor는 큰 블록 읽기 및 쓰기 활동 모두에서 가장 일관된 성능을 제공했으며, RAID6이 그 뒤를 이었습니다. RAID10은 읽기 및 쓰기 테스트 모두에서 가장 널리 퍼졌습니다.

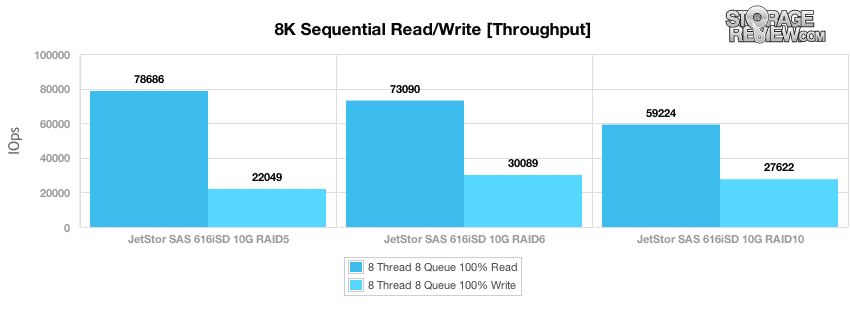

1024k 순차 전송 테스트는 대역폭 포화 상태 이후를 측정하도록 설계되었지만 다음 테스트는 최상의 시나리오에서 I/O 처리량을 측정하기 위해 8K 전송으로 작은 블록 순차 활동을 살펴봅니다. 생산 환경에서 SAN이 볼 수 있는 대부분의 활동은 더 많은 시스템이 SAN에 액세스함에 따라 임의적이지만 유휴 시간 동안 야간 백업 또는 백그라운드 활동은 이러한 속도에 가깝게 볼 수 있습니다. 우리가 측정한 최대 순차 8K 읽기 성능은 RAID78,686 구성에서 5 IOPS였으며 RAID73,090에서는 6 IOPS, RAID59,224에서는 10 IOPS로 떨어졌습니다. 최대 8K 순차 쓰기 성능은 RAID30,089에서 6 IOPS로 측정되었으며 RAID10은 27,622 IOPS, RAID5는 22,049 IOPS로 측정되었습니다.

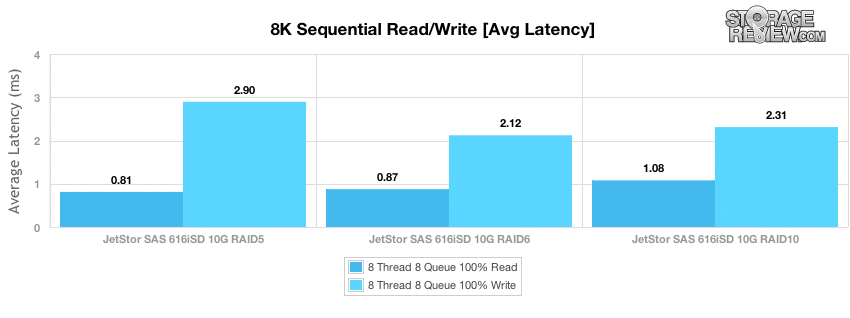

평균 작은 블록 순차 대기 시간은 8K 전송 테스트에서 전반적으로 낮았습니다. RAID5 읽기는 0.81ms의 응답 시간으로 가장 빠르게, RAID6은 0.87ms로, 그 다음으로는 RAID10이 1.08ms로 나타났습니다. 쓰기 대기 시간은 RAID6이 2.12ms, RAID10이 2.31ms, RAID5가 2.9ms로 더 느린 I/O 전송 결과를 감안할 때 약간 더 높았습니다.

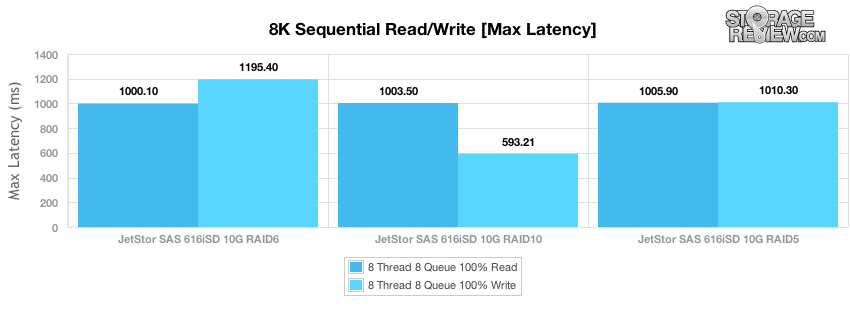

8K 순차 전송 테스트의 최대 읽기 대기 시간은 테스트의 읽기 세그먼트에서 보드 전체에 걸쳐 약 1,000ms의 피크를 측정했으며 쓰기 피크 대기 시간은 RAID593에서 10ms, RAID1,195에서 최대 6ms를 측정했습니다.

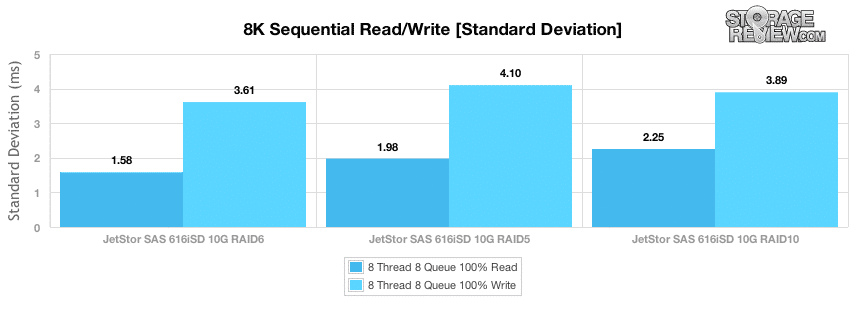

대기 시간 표준 편차 스프레드를 살펴보면 RAID6 모드가 가장 일관된 순차 읽기 성능을 유지했으며 RAID5 RAID10은 약간 더 일관성이 없었습니다. RAID6은 또한 쓰기 전송에서 최고의 8K 순차 표준 편차를 제공했습니다.

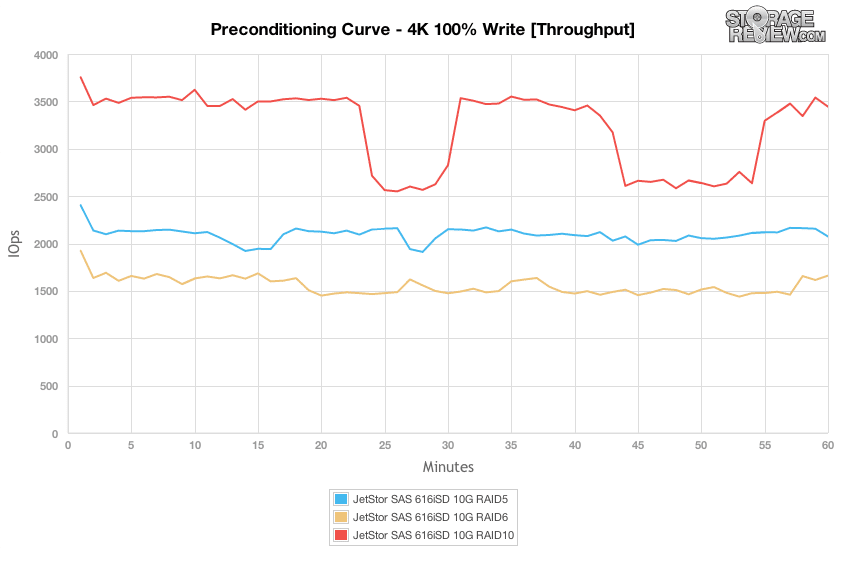

다음 테스트 그룹은 무작위 워크로드로 초점을 이동합니다. 첫 번째 테스트는 전제 조건 세그먼트에서 100% 4K 쓰기입니다. RAID 모드가 쌓이는 방식 측면에서 RAID10은 가장 높은 처리량을 제공했으며 RAID5 및 RAID6은 그 아래에 있습니다. 그러나 흥미로운 점은 RAID10 및 RAID5 설정에는 없는 백그라운드 유지 관리로 인해 RAID6 어레이의 성능이 저하되었다는 것입니다.

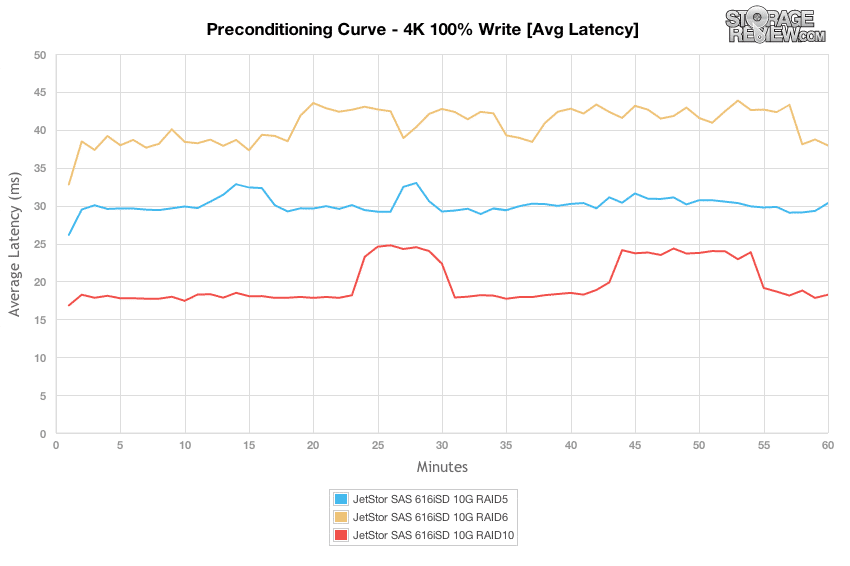

사전 조정 단계 동안의 평균 대기 시간을 보면 각 RAID 모드에 대해 온보드 캐시가 디스크 자체의 성능을 평준화하기 전에 1-2분 동안 들어오는 임의 활동을 버퍼링한 방법을 확인할 수 있습니다.

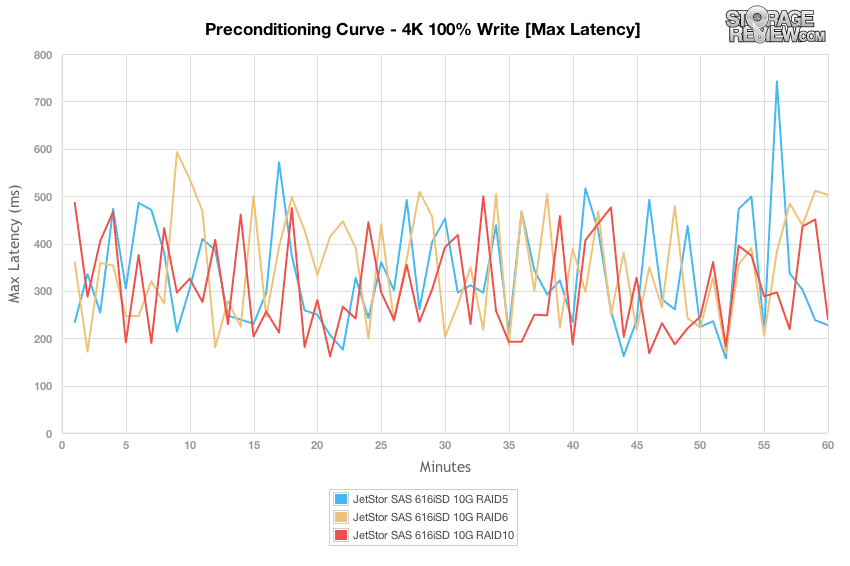

각각 8개의 뛰어난 I/O가 있는 8개의 스레드를 로드하는 동안 최대 대기 시간은 200% 500K 쓰기 활동으로 각 RAID 모드에 대해 100-4ms 사이에서 부동했습니다.

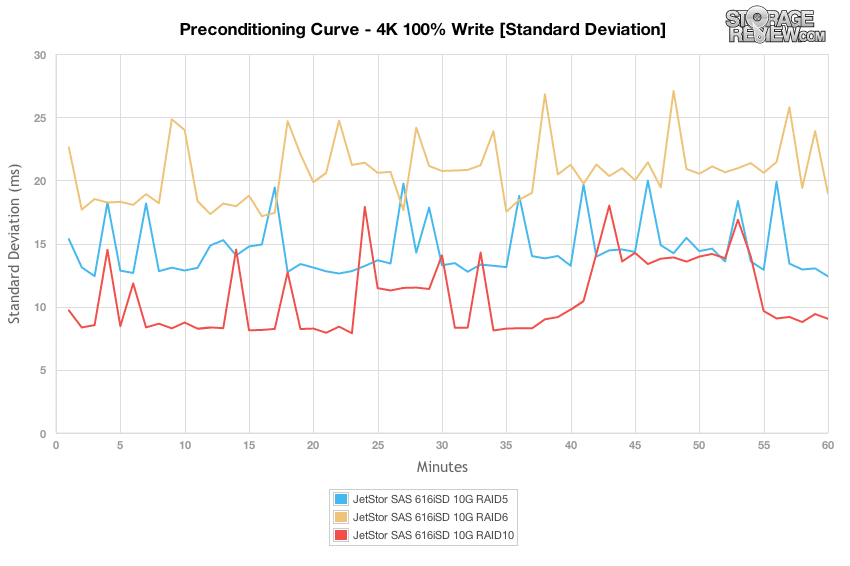

대기 시간 표준 편차로 초점을 전환하면 응답 시간이 RAID10 구성과 가장 일치하고 RAID5 및 RAID6이 그 뒤를 따른다는 것을 알 수 있습니다.

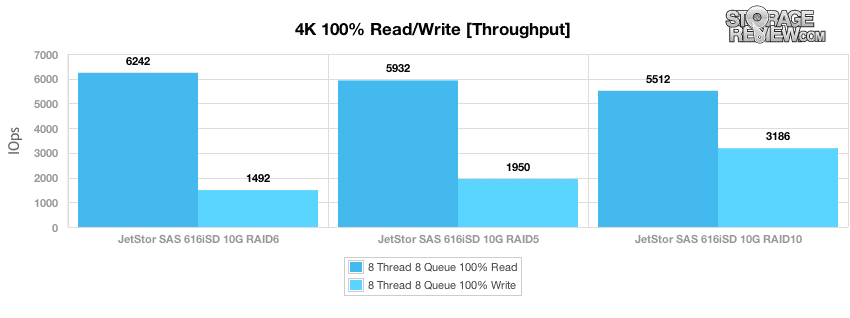

전제 조건 프로세스가 완료된 후 각 RAID 모드에서 100% 4K 임의 읽기 및 임의 쓰기 성능의 더 긴 샘플을 가져왔습니다. RAID6은 6,242 IOPS의 가장 빠른 읽기 속도를 제공했지만 더 느린 쓰기 성능은 1,492 IOPS로 측정되었습니다. RAID10은 3,186 IOPS로 측정되는 최고의 임의 쓰기 성능을 제공했지만 4K 임의 읽기 속도는 5,512 IOPS로 더 느렸습니다.

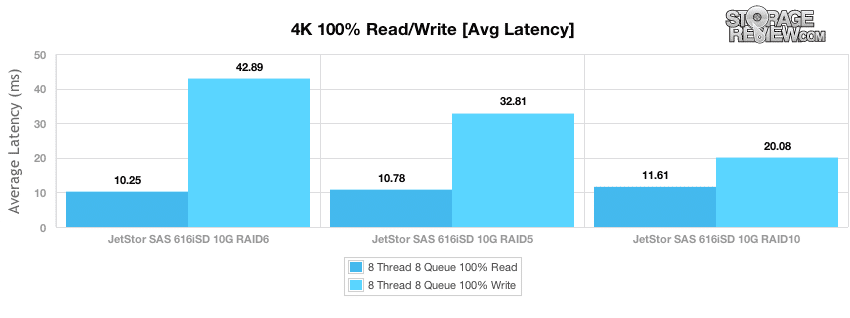

64라는 뛰어난 유효 대기열 깊이로 각 RAID 모드에서 4K 임의 읽기 및 쓰기 대기 시간을 측정했습니다. 임의 4K 읽기 대기 시간은 RAID10.25에서 6ms에서 RAID11.61에서 10ms까지 다양했습니다. 쓰기 대기 시간이 RAID20.08의 10ms에서 RAID42.89의 6ms로 확장되었습니다.

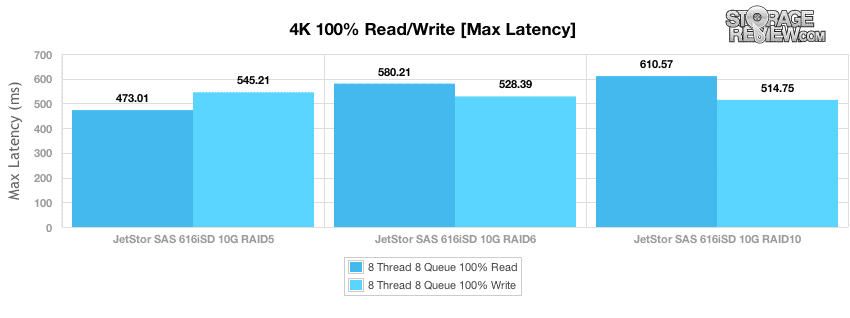

사전 조건화 단계 이외의 더 긴 샘플링 기간에서 우리는 읽기 트랜잭션에서 473-610ms, 쓰기 활동 동안 514-545ms 범위의 피크 응답 시간을 측정했습니다.

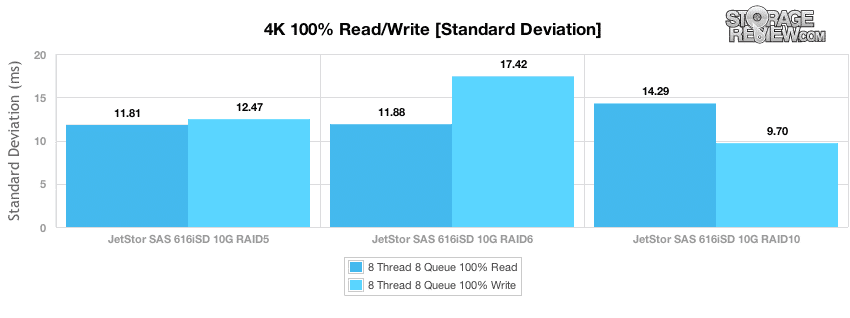

최대 대기 시간은 샘플링 기간 동안 최악의 응답 시간을 보여주지만 표준 편차는 전체 테스트 기간 동안 대기 시간의 확산을 보여줍니다. RAID5는 가장 일관된 임의 4K 읽기 대기 시간을 제공했으며 RAID10은 가장 일관된 4K 쓰기 대기 시간을 제공했습니다.

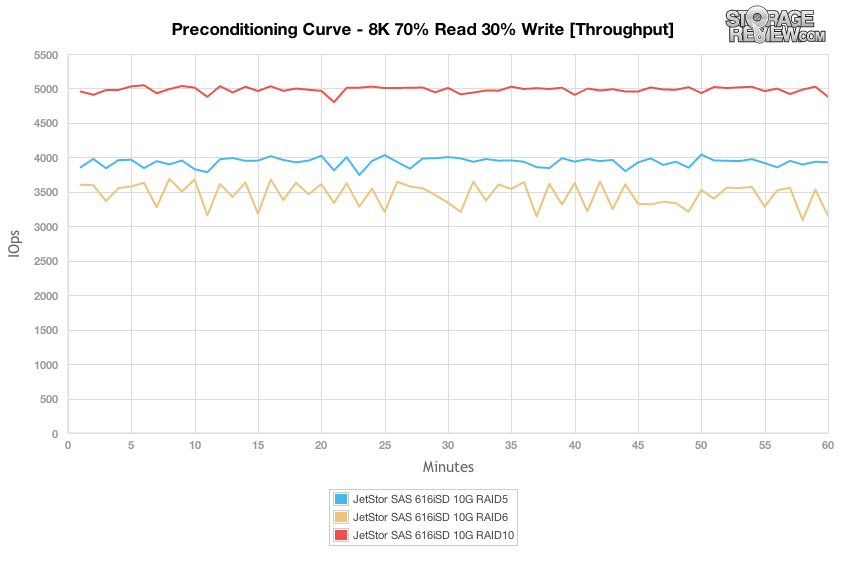

다음 사전 조건 테스트는 100K, 1024% 100K 또는 8% 100K 워크로드의 4% 쓰기 활동과 비교하여 보다 현실적인 읽기/쓰기 워크로드 분산으로 작동합니다. 여기에서는 70K 임의 전송의 30% 읽기 및 8% 쓰기 혼합이 있습니다. 8개의 스레드와 스레드당 70개의 대기열이 많은 로드에서 30K 8/8 혼합 워크로드를 살펴보면 RAID10이 가장 높은 처리량을 제공했고 RAID5와 RAID6이 그 뒤를 잇는 것을 볼 수 있습니다. 성능은 사전 조정 프로세스 기간 동안 매우 일관되었으며 약간의 성능 저하만 있었습니다.

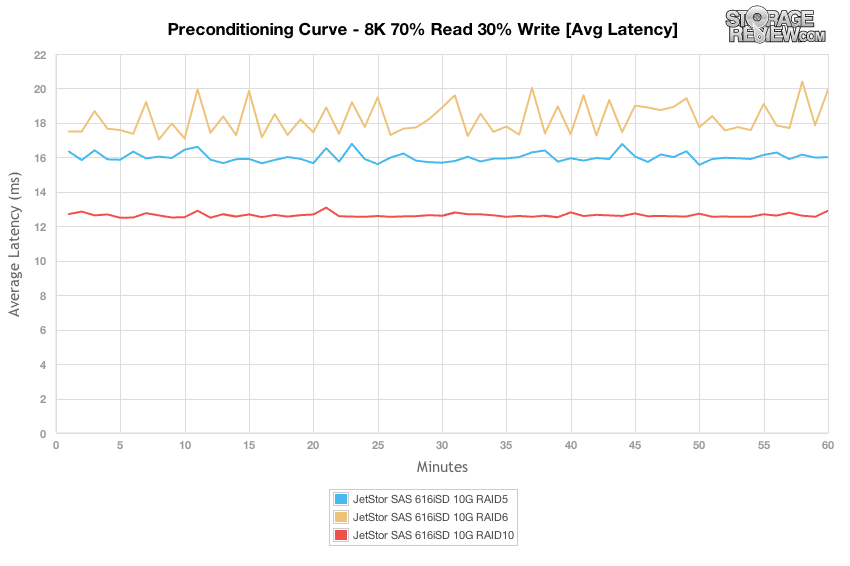

8K 70/30 워크로드 동안의 평균 대기 시간 분포를 살펴보면 RAID10이 테스트 기간 동안 12~13ms로 가장 평탄했으며 RAID6이 약 16~17ms, RAID5가 17~20ms로 그 뒤를 이었습니다.

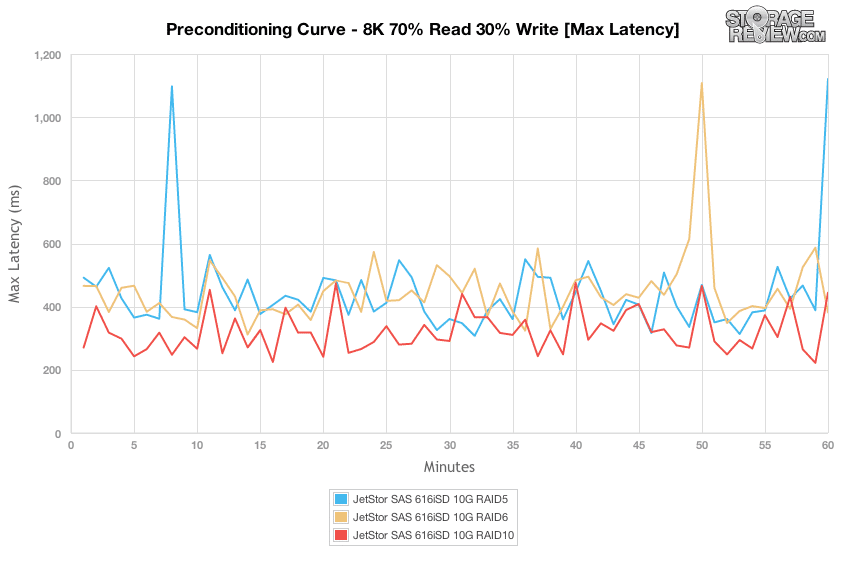

각 RAID 유형의 최대 응답 시간은 300-500ms 대역에서 상당히 일관되었으며 RAID1,000 및 RAID5 RAID 유형에서 6ms 이상에서 약간의 깜박임이 발생했습니다.

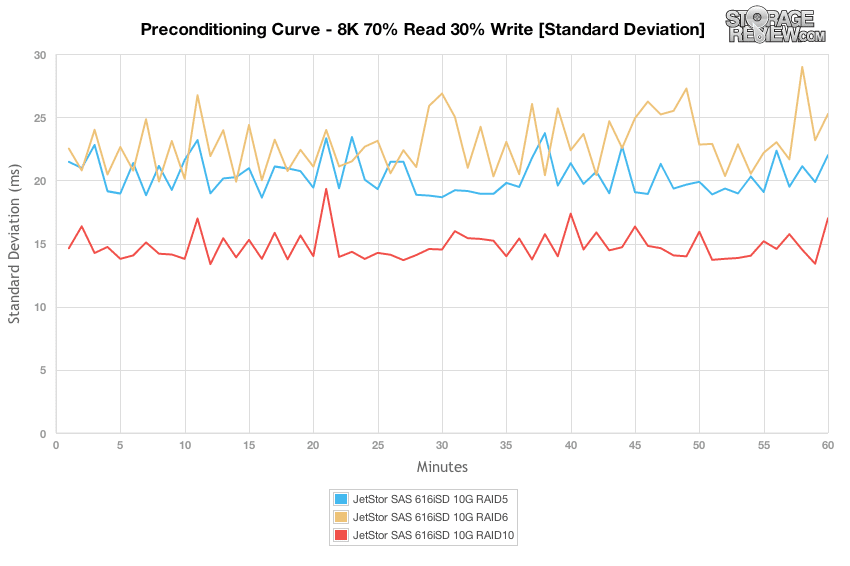

RAID 유형 간의 대기 시간 표준 편차 차이를 비교하면 RAID10이 가장 일관된 대기 시간을 제공했으며 RAID5, RAID6 순이었습니다.

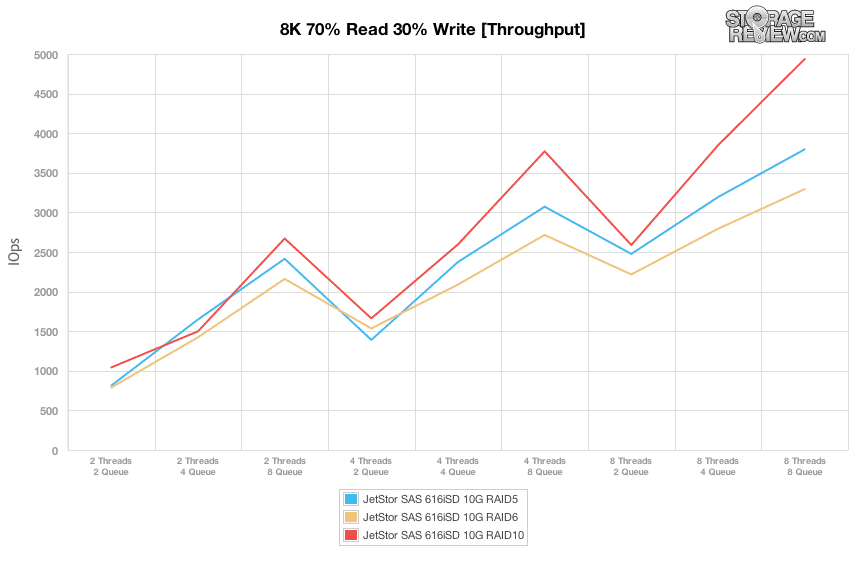

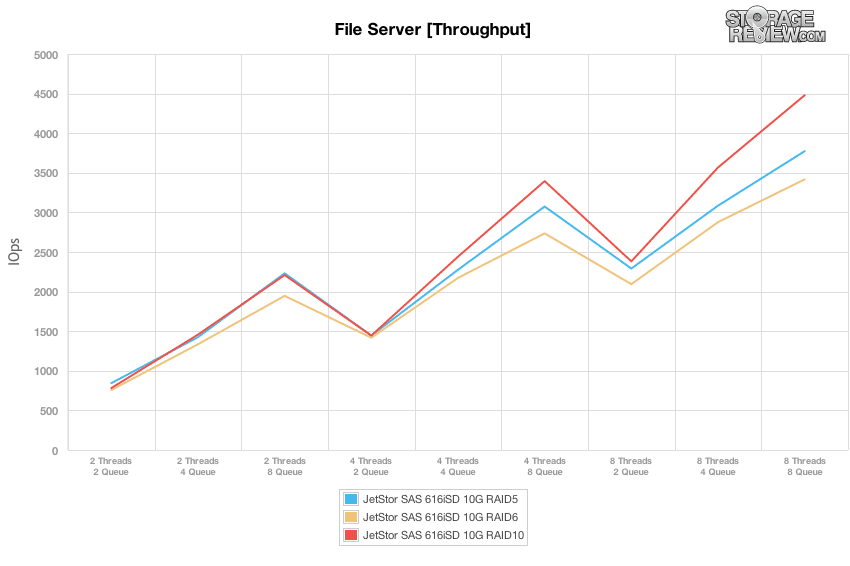

8% 8K, 100K 및 4K 테스트에서 수행한 고정 8 스레드, 1024 큐 최대 워크로드와 비교하여 혼합 워크로드 프로필은 광범위한 스레드/큐 조합에서 성능을 확장합니다. 이 테스트에서 우리는 2개의 스레드와 2개의 대기열에서 최대 8개의 스레드와 8개의 대기열까지 워크로드 강도를 확장합니다. 처리량의 차이를 살펴보면 각 RAID 모드는 유효 대기열 깊이가 16 이하로 유지되는 영역에서 서로 거의 동등하게 실행되고 있었습니다. 32T/4Q, 8T/8Q 및 4T/8Q 워크로드에서 볼 수 있듯이 8 이상이 되면 RAID10 모드가 가장 높은 성능을 제공했으며 그 다음은 RAID5, 그 다음은 RAID6입니다. 그 범위 아래에서 각 RAID 모드는 유사한 성능을 제공했습니다.

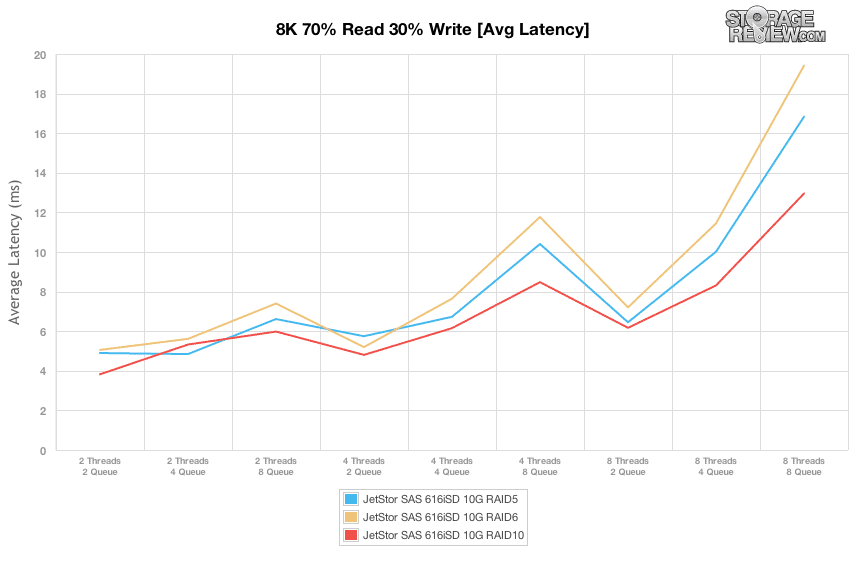

최대 처리량 범위를 아는 것도 중요하지만 스토리지 어레이에 맞게 로드를 조정하는 방법을 아는 것이 훨씬 더 중요합니다. 대기 시간이 긴 빠른 I/O 속도는 사용자 상호 작용이 느리다는 것을 의미하므로 대기 시간이 크게 증가하기 전에 짜낼 수 있는 성능 수준을 아는 것이 유용성에 매우 중요합니다. 가장 높은 처리량을 제공하면서도 대기 시간을 6-8ms 사이로 상대적으로 낮게 유지한 우리 테스트의 스윗 스팟은 성능 범위가 8~2 IOPS인 2,250T/2,750Q였습니다.

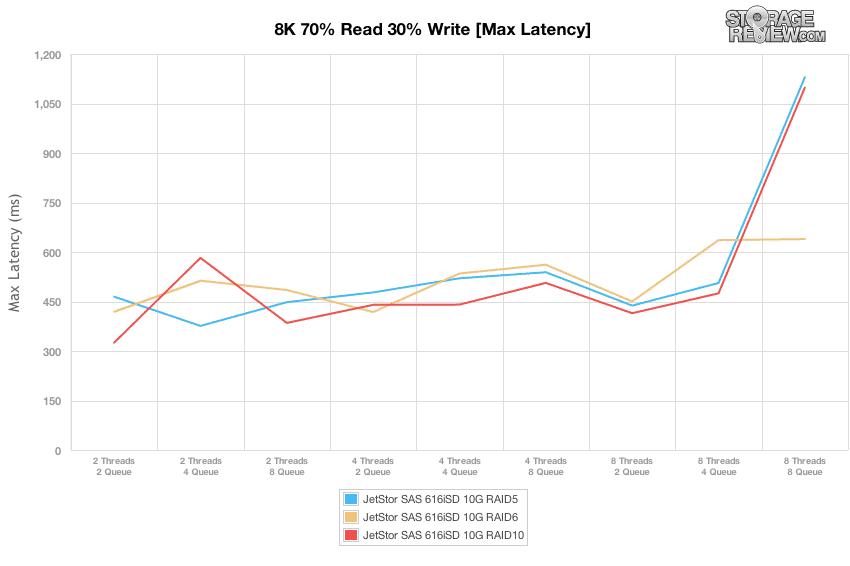

효과적인 대기열 깊이를 JetStor SAS 616iSD의 최대 대기 시간과 비교하면 SAN은 500T/8Q 워크로드까지 8ms 미만으로 더 높은 응답 시간을 포함할 수 있었습니다. 그 시점에서 RAID5 및 RAID6의 최대 대기 시간은 두 배가 되었습니다.

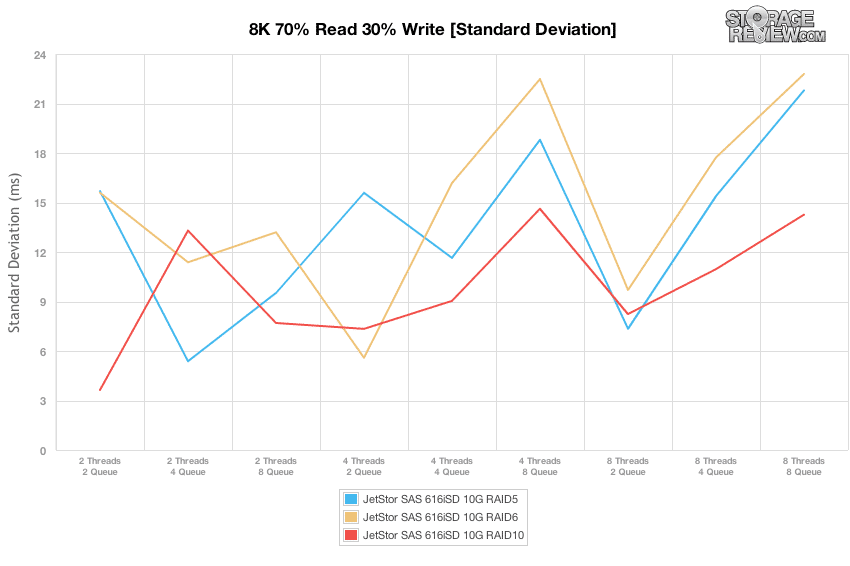

세 가지 RAID 유형 모두에서 대기 시간 표준 편차를 비교하면 RAID10이 약간의 이점을 제공했으며 일반적으로 RAID6이 가장 큰 확산을 보였습니다. 그러나 가장 일관된 대기 시간에 대한 스윗 스팟은 모든 RAID 유형에 최적인 8T/2Q 로드였습니다.

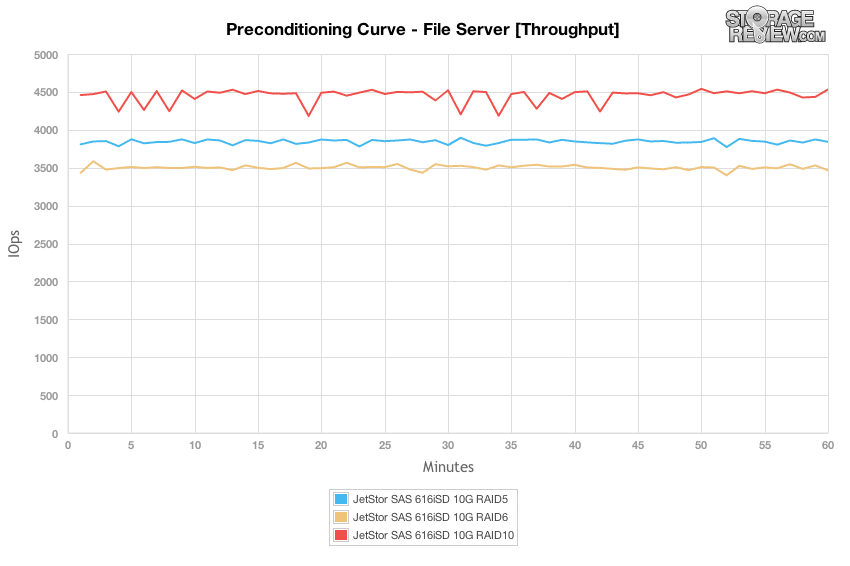

파일 서버 워크로드는 각 특정 어레이에 도달하는 더 큰 전송 크기 스펙트럼을 나타내므로 정적 4k 또는 8k 워크로드에 정착하는 대신 SAN은 512b에서 64K 범위의 요청에 대처해야 합니다. 다른 완전 무작위 워크로드와 유사하게 RAID10 구성은 사전 조정 프로세스 기간 동안 약 4,500 IOPS를 측정하여 가장 높은 처리량을 제공했습니다. RAID5는 3,800 IOPS의 속도로 뒤를 이었고, RAID6은 약 3,500 IOPS로 그 뒤를 이었습니다. 각 RAID 유형은 사소한 차이만 제외하고 처음부터 끝까지 비슷한 성능을 제공했습니다.

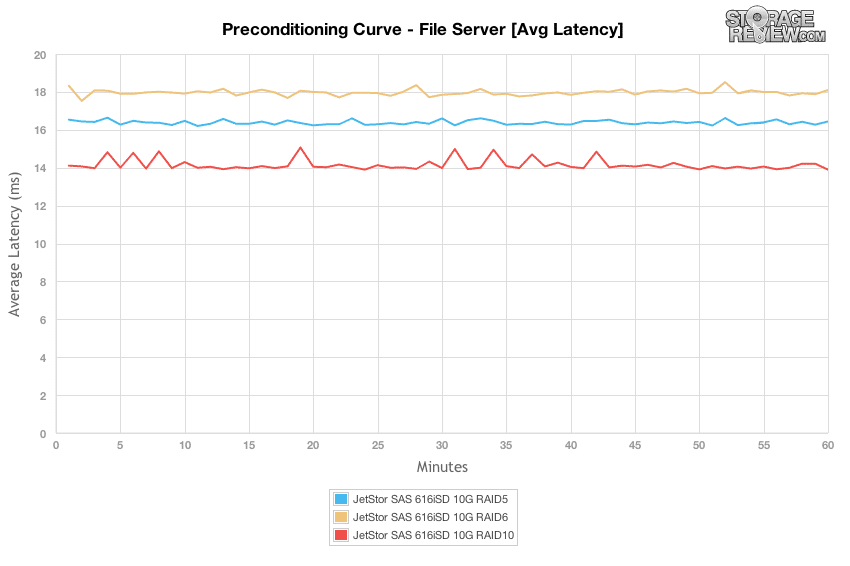

평균 대기 시간을 살펴보면 각 RAID 구성은 전제 조건 테스트 기간 동안 상당히 평평하게 유지되었으며 RAID10 모드는 14ms, RAID5는 16.5ms, RAID6는 18ms에서 안정화되었습니다.

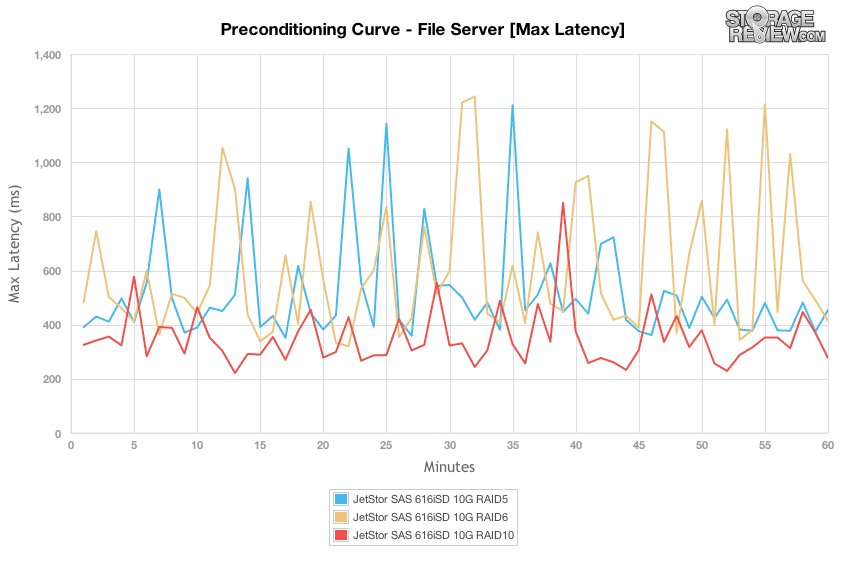

피크 응답 시간은 사전 조정 단계에서 최저 200ms에서 최고 1,200ms까지 더 넓게 퍼졌습니다. RAID10 구성은 250ms에서 800ms를 약간 넘는 범위로 가장 낮게 유지되었습니다. RAID5 및 RAID6은 300ms에서 1,200ms 이상으로 피크가 높았습니다.

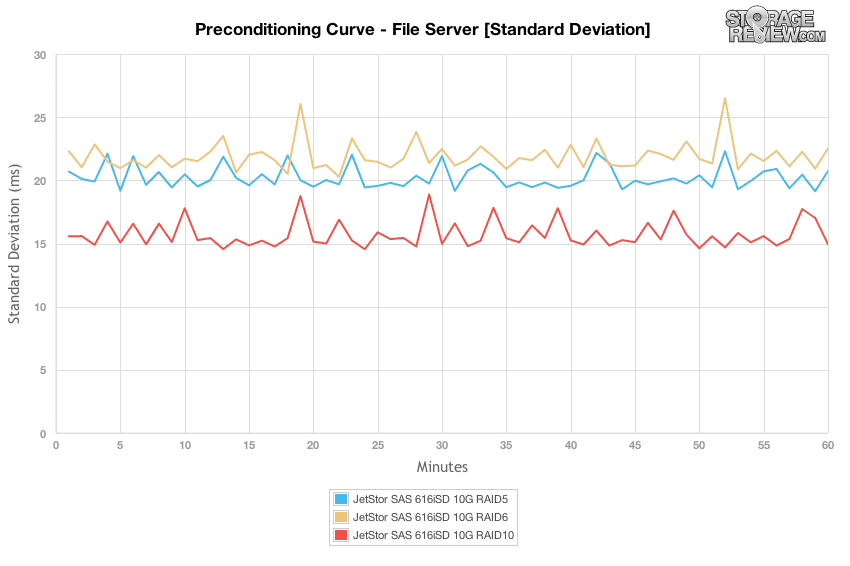

RAID10은 가장 일관된 대기 시간 표준 편차를 제공했으며, RAID5와 RAID6이 그 뒤를 이었습니다.

부하를 2T/2Q에서 8T/8Q로 증가시키는 확장된 파일 서버 처리량 차트로 전환하면 유효 대기열 깊이 16 이하에서 각 RAID 유형 간에 성능 차이가 거의 없는 유사한 추세를 확인했습니다. . 그 이상에서는 RAID10이 가장 높은 성능을 제공했고 RAID5, RAID6 순이었습니다.

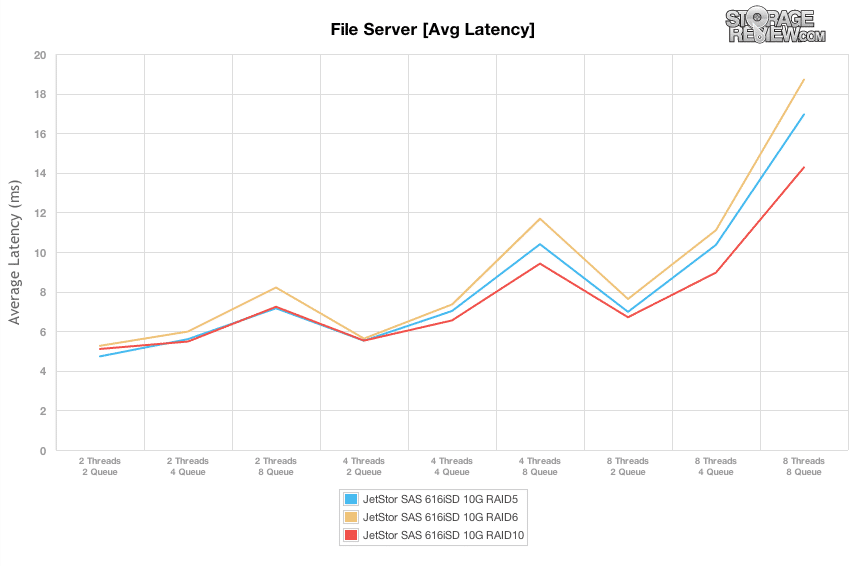

파일 서버 워크로드의 평균 대기 시간 보기로 전환하면 응답 시간이 5~8ms 사이에서 변동하는 반면 유효 대기열 깊이는 16 이하로 유지된 다음 최대 부하에서 14~19ms까지 급증했습니다. 8K 70/30 워크로드와 유사한 스위트 스폿은 다시 8T/2Q였으며 JetStor SAS 606iSD는 2,000-2,500ms의 대기 시간으로 7-8 IOPS의 최고 처리량을 제공할 수 있었습니다.

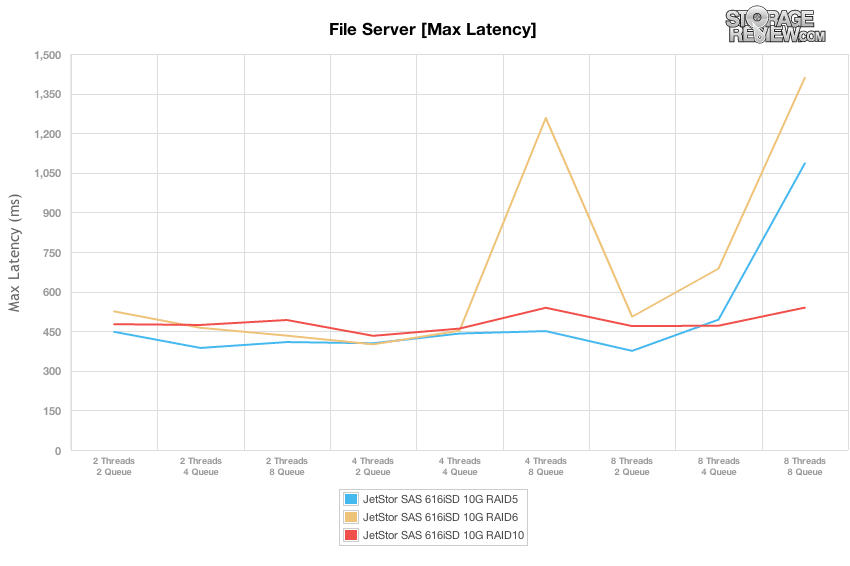

파일 서버 테스트에서 대기 시간이 크게 증가하기 전에 최대 대기 시간은 최대 400T/500Q 및 5T/6Q까지 RAID8 및 RAID4의 경우 8-8ms 이내로 유지되었습니다. RAID10의 최대 응답 시간은 전체 테스트 기간 동안 일관되게 유지되었습니다.

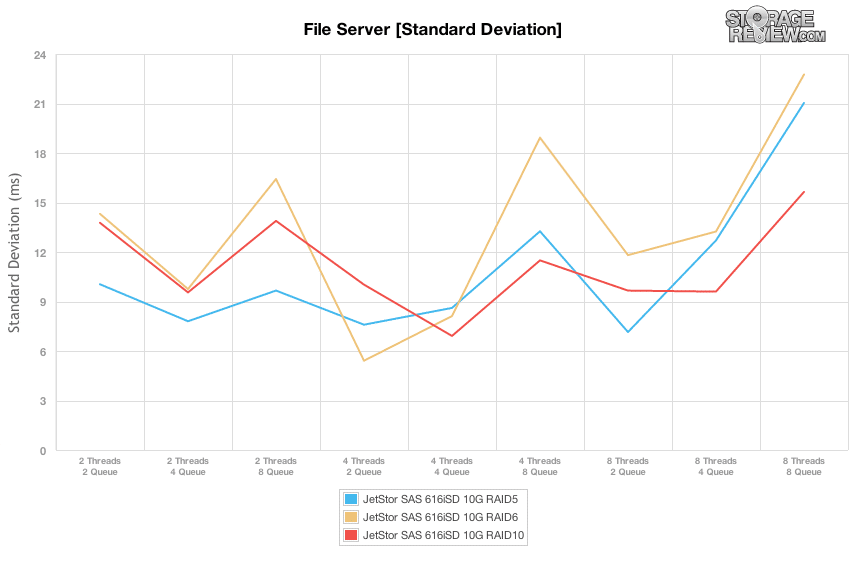

모든 RAID 유형의 표준 편차는 다양한 부하 테스트 기간 동안 일관되지 않게 유지되었습니다. 구성이 대기열 깊이 8에 도달한 더 높은 로드에서 변동이 전반적으로 증가했습니다.

마지막 워크로드는 기본 출력과 비교하여 테스트의 사전 조건화 단계를 분석하는 방식에서 다소 독특합니다. 100% 읽기 활동으로 설계된 워크로드로서 적절한 사전 조정 단계 없이는 각 장치의 진정한 읽기 성능을 보여주기 어렵습니다. 컨디셔닝 워크로드를 테스트 워크로드와 동일하게 유지하기 위해 패턴을 100% 쓰기로 전환했습니다. 이러한 이유로 전제조건 차트는 최종 워크로드 수치보다 느립니다.

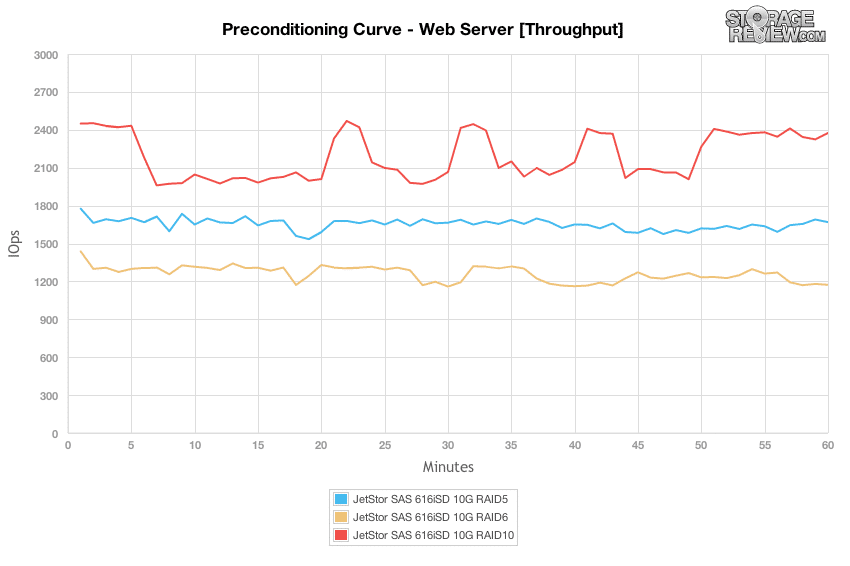

100% 쓰기 조건의 웹 서버 시나리오에서 RAID10 구성은 최고의 성능을 제공했지만 4K 랜덤 테스트에서 언급한 동작과 유사하지만 백그라운드 작업을 수행하면서 테스트 섹션 전체에서 저하되었습니다. 다른 RAID 프로필은 전반적으로 더 느렸지만 동일한 결과를 얻지 못했습니다.

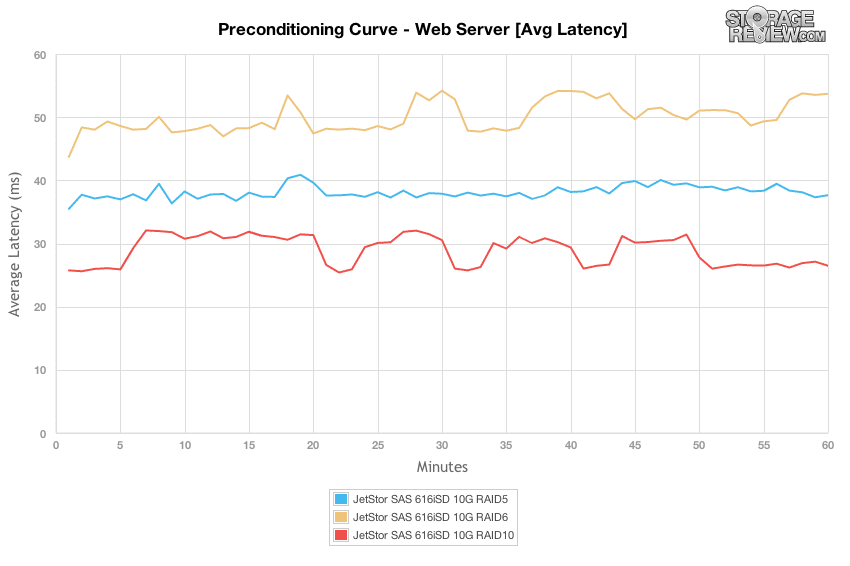

8T/8Q 로드가 있는 웹 서버 사전 조정 프로세스에서 RAID10은 전체적으로 가장 빠른 응답 시간인 26~32ms, RAID5는 약 38~41ms, RAID6은 48~54ms로 성능 차이가 컸습니다.

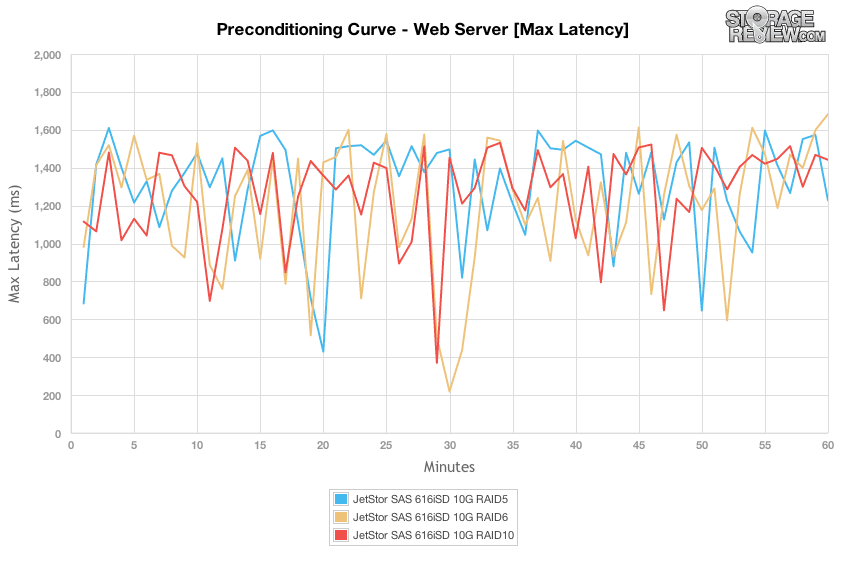

웹 서버 사전 조정 워크로드에서 최대 대기 시간의 차이를 비교하면 모든 RAID 유형이 총 200-1,600ms로 측정되는 유사한 최대 응답 시간 범위를 제공했습니다.

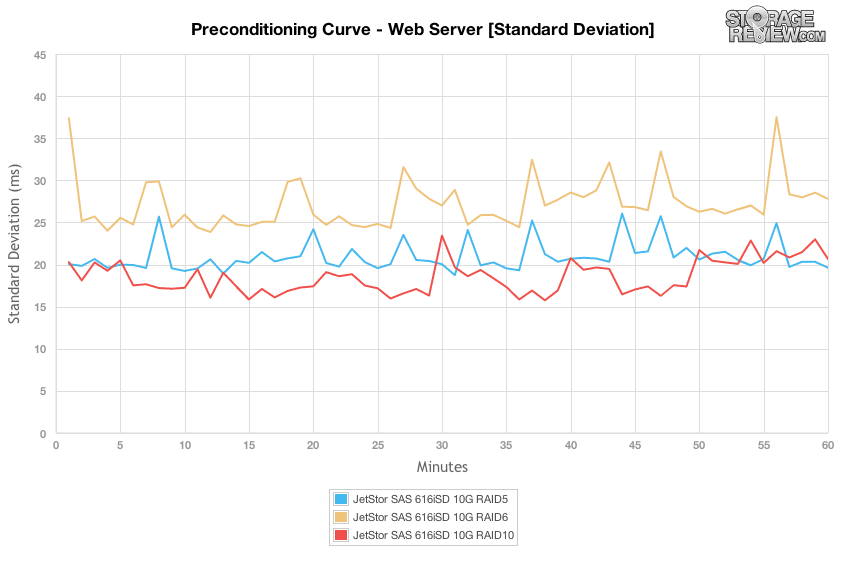

최대 대기 시간을 비교할 때 큰 차이가 없었을 수 있지만 대기 시간 표준 편차로 초점을 바꾸면 RAID10이 대기 시간에서 가장 좁은 범위를 제공하고 RAID5, RAID6이 그 뒤를 잇는 것을 볼 수 있습니다.

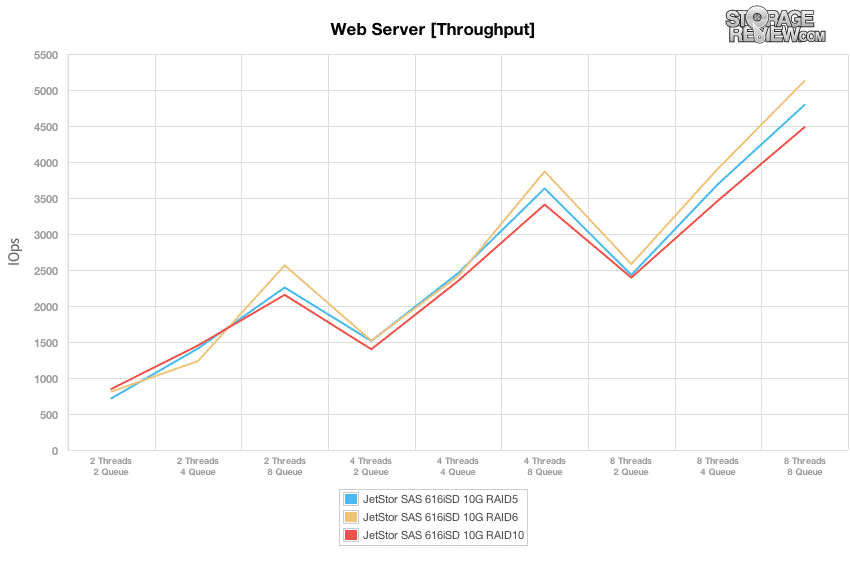

사전 조건화 단계의 100% 쓰기 활동에서 100% 읽기 활동으로 전환하면 각 RAID 유형 간의 차이는 유효 큐 깊이가 높아질 때까지 눈에 띄지 않습니다. 피크에서 RAID10 모드는 5,100 IOPS, RAID5는 4,800, RAID6은 4,500을 지원할 수 있었습니다.

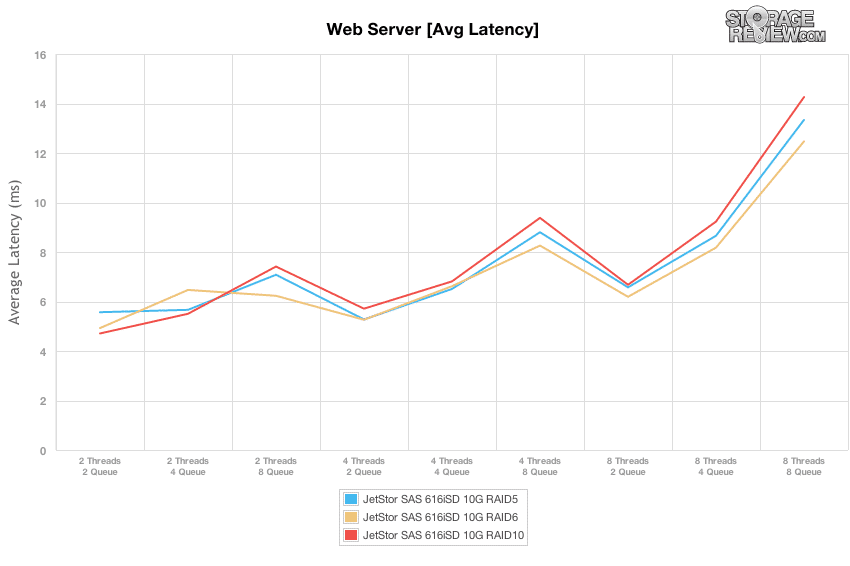

웹 서버 프로필에서 읽기 활동이 100%인 스위트 스팟은 여전히 8T/2Q 로드였으며 대기 시간이 6.2-6.6ms로 급증하기 전에 2,400-2,600 IOPS의 처리량으로 13-15ms 응답 시간을 제공했습니다.

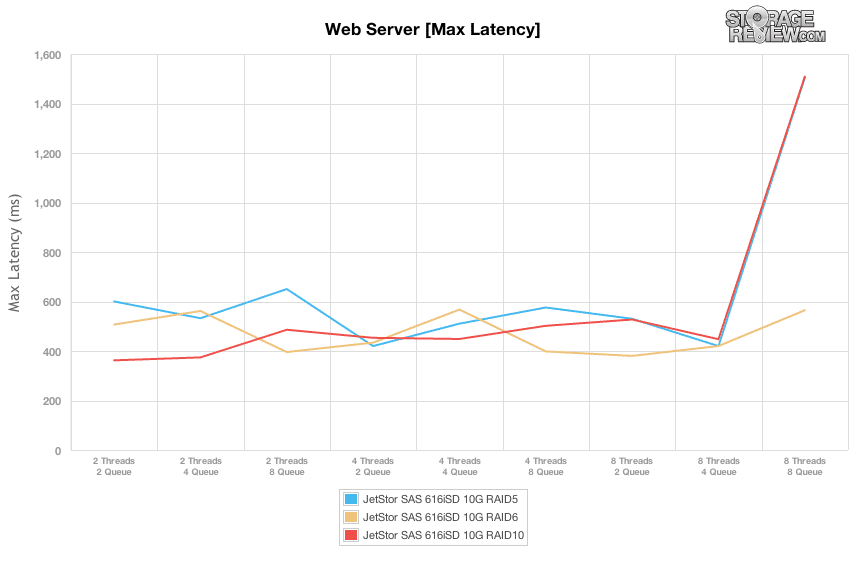

다양한 로드 테스트에서 최대 대기 시간을 비교하면 JetStor SAS 616iSD는 RAID400 및 RAID600 구성이 최대 8ms인 8T/5Q 워크로드까지 10-1,500ms 범위를 유지했습니다.

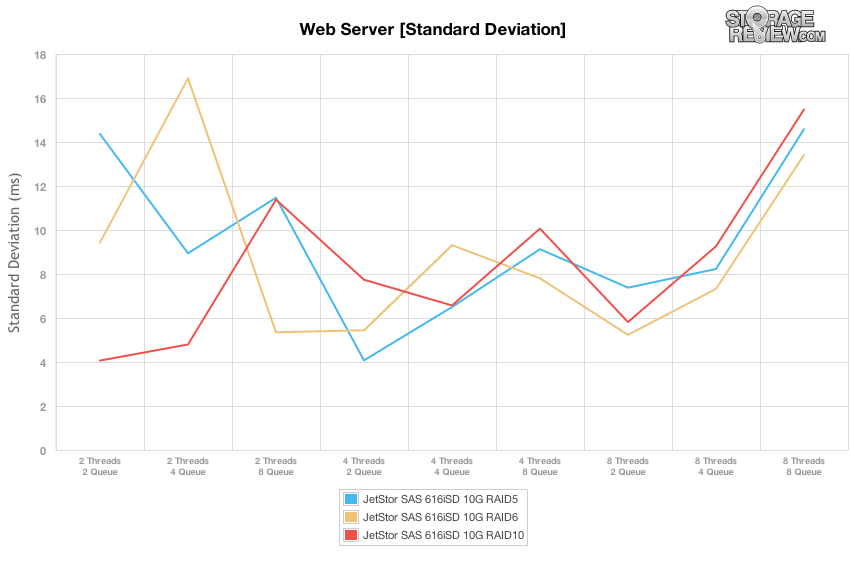

대기 시간 표준 편차의 차이를 비교하면 JetStor SAN의 각 RAID 유형은 8T/8Q의 최대 부하에 놓일 때까지 적당한 부하에 있을 때 더 일관된 응답 시간을 제공했습니다. 8T/2Q의 스위트 스폿 범위에서 RAID6이 가장 일관된 대기 시간을 제공했고 RAID10과 RAID5가 그 뒤를 이었습니다.

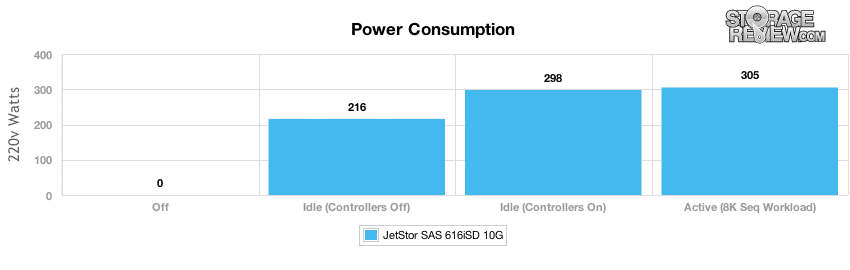

전력 소비

최신 데이터 센터에 있는 모든 장치와 마찬가지로 전력 소비 및 열 출력은 장치 자체의 전력 사용량과 작동 중에 발생하는 열을 상쇄하는 데 필요한 냉각 모두에서 최종 결과에 두 배로 영향을 미치기 때문에 항상 최우선적으로 고려해야 합니다. 대부분의 SAN 및 NAS 어레이에서 전체 전력 사용량의 가장 큰 구성 요소는 드라이브 자체이며, 상당히 지속적으로 액세스할 수 있다면 유휴 및 스핀다운 시간이 거의 없음을 의미합니다. 테스트에서 전원이 꺼진 상태, 시스템이 켜져 있지만 컨트롤러 전원이 꺼진 상태, 시스템 전원이 켜진 상태에서 유휴 상태, 시스템 전원이 켜진 상태에서 지속적으로 높은 I/O 로드를 보이는 상태에서 전원을 측정했습니다.

600개의 15GB 216k SAS 하드 드라이브가 설치된 상태에서 대부분의 전력 사용량은 이러한 드라이브를 활성 상태로 유지하는 데서 나옵니다. 컨트롤러를 끈 상태에서 어레이는 유휴 상태에서 298와트가 필요했고 컨트롤러를 켠 상태에서는 7와트로 증가했습니다. 활성 부하가 있는 경우에도 전력 사용량은 305K 순차 워크로드에서 8w로 460와트만 추가로 증가했습니다. 이중 66W 전원 공급 장치를 사용하는 JetStor SAN은 15,000RPM 하드 드라이브가 설치된 상태에서 XNUMX%의 사용률을 유지했기 때문에 전력 요구 사항 측면에서 다소 과도하게 프로비저닝된 것으로 나타났습니다. XNUMX개의 베이를 사용하지 않더라도 전원 공급 장치가 고장나서 방정식에서 제거되더라도 여전히 많은 오버헤드가 남아 있었습니다.

결론

Jetstor SAS 616iSD 10G는 자체적으로 성능 또는 대용량 드라이브와 함께 사용하여 중소기업의 가상화 또는 일반 스토리지 요구 사항을 충족하거나 추가 선반과 함께 사용하여 대기업 스토리지 문제를 해결할 수 있다는 점에서 다소 비정형적인 스토리지 어레이 범주에 적합합니다. JetStor는 616iSD를 훌륭하게 설계했으며 내부와 외부의 모든 것을 세심하게 고려했으며 이 장치는 현장 서비스가 용이합니다. 케이블이 없는 내부 설계 또는 도구가 필요 없는 구성 요소 교체와 같은 항목은 기술자가 생산 환경에서 SAS 616-SD를 계속 실행하는 데 필요한 작업이 거의 없음을 의미합니다. 설정도 간단합니다. 거의 플러그 앤 플레이 방식입니다. 최소한 기업의 의미 내에서는 그렇습니다.

성능 측면에서 RAID5, RAID6 및 RAID10의 공통 구성에서 어레이를 테스트했습니다. 우리의 테스트에서 각 모드에서 상당한 변동성이 나타났기 때문에 세 가지 모두를 보는 것은 확실히 관련이 있습니다. RAID10은 일관되게 최고의 성능을 보여주었고 원시 성능과 최저 대기 시간 측면에서 RAID5와 RAID6이 그 뒤를 이었습니다. 이 어레이 또는 다른 어레이의 배치를 고려하는 기업으로서 성능의 스위트 스폿을 이해하는 것이 스토리지 배치의 성공에 특히 중요합니다. 이 경우 JetStor SAS 8iSD가 대부분의 워크로드 및 모든 RAID 유형에서 낮은 대기 시간과 높은 처리량을 제공할 수 있는 2개 스레드, 606개 대기열에서 최고의 성능 목표를 확인했습니다. 대기 시간이 크게 증가하더라도 성능은 해당 지점을 넘어 계속 확장될 수 있습니다. 전력 측면에서 우리는 12-드라이브 15k SAS 구성이 부하 상태에서 305와트를 소비한다는 것을 발견했습니다. 이는 각 전원 공급 장치가 처리하도록 설계된 460와트보다 훨씬 낮습니다. 따라서 구성 요소 오류가 발생한 경우 단일 PSU에서 실행해야 하는 경우에도 시스템에 충분한 오버헤드 공간이 제공됩니다.

JetStor가 약간의 문제에 부딪히는 부분은 그들이 더 많은 고급 시장을 더 큰 고객으로 옮기려고 할 때입니다. 이러한 경우 관리 계층이 매우 중요해지며 이는 JetStor가 그다지 깊이 있지 않은 것입니다. 단일 관리 창을 통해 광범위한 컴퓨팅 및 스토리지 플랫폼을 관리할 수 있는 EMC 또는 NetApp과 비교할 때 JetStor SAN은 자체적으로 구성해야 합니다. 몇 가지 시스템으로 작업할 때 정확히 문제가 되는 것이 아니라 이 상자가 어떤 시장 세그먼트를 담당하는지 이해하는 것이 더 중요합니다. JetStor는 SAS 616iSD로 대규모 엔터프라이즈 스토리지 어레이를 대체하려는 것이 아닙니다. 그들은 이 디자인이 많은 의미가 있는 중간 시장을 확실히 겨냥하고 있습니다.

장점

- 멋진 인클로저/구성 요소 디자인

- 서비스하기 쉬운 매우 견고한 설계

- 다양한 워크로드에서 강력하고 일관된 성능 제공

단점

- 대규모 엔터프라이즈 데이터 관리 소프트웨어 부족

히프 라인

JetStor는 거의 20년의 사업 기간과 강력한 제품 세트를 제공해야 하지만 스토리지와 관련하여 정확히 모든 사람이 아는 이름은 아닙니다. 이 검토에서 특히 JetStor SAS 616iSD 10G는 요구되는 모든 작업을 수행하며 성능 요구 사항을 위한 10GbE 및 15K 하드 드라이브 또는 대용량 스토리지를 위한 고용량 3.5인치 하드 드라이브로 구성할 수 있는 충분한 유연성을 갖추고 있습니다. 이 어레이는 배포가 간단하고 잘 설계되어 SMB 및 지사/원격 사무실용 애플리케이션 및 가상화 스토리지에 적합합니다.