De nieuwste technologie van AMD ondersteunt LM Studio voor hoogwaardige AI-functionaliteit zonder dat er programmeerkennis of technische kennis nodig is.

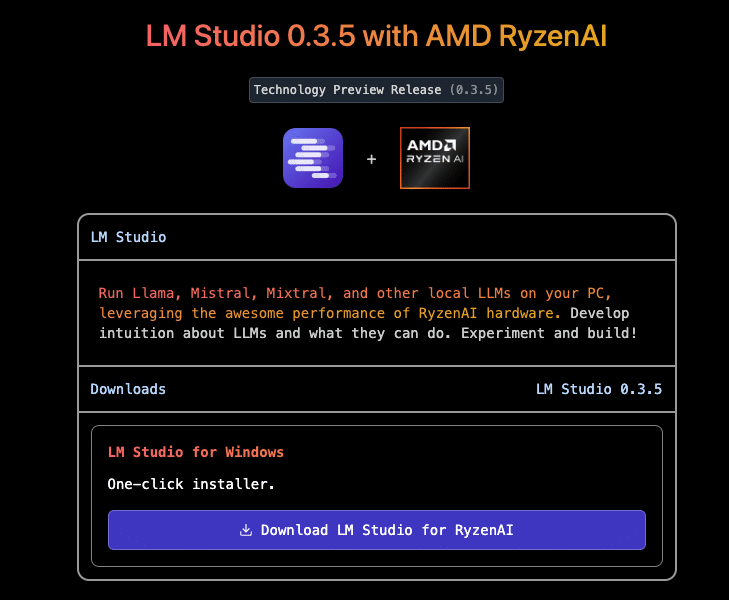

Recente ontwikkelingen in grote taalmodellen (LLM's), waaronder toegankelijke tools zoals LM Studio, hebben gebruikers in staat gesteld om geavanceerde AI-modellen snel en moeiteloos te implementeren. De nieuwste technologie van AMD ondersteunt de hoogwaardige AI-functionaliteit van LM Studio zonder dat er programmeerkennis of technische kennis vereist is.

LM Studio is ontwikkeld op het llama.cpp-framework en is ontworpen voor snelle LLM-implementatie. Dit framework werkt zonder afhankelijkheden en presteert efficiënt op CPU's, hoewel GPU-versnelling beschikbaar is. Om de prestaties voor x86-gebaseerde CPU's te optimaliseren, maakt LM Studio gebruik van AVX2-instructies, wat de compatibiliteit en snelheid op moderne processors verbetert.

AMD Ryzen AI, geïntegreerd in de Ryzen 9 HX 375-processor, verbetert LLM-prestaties in applicaties zoals LM Studio, met name voor x86-laptops. Hoewel LLM's sterk afhankelijk zijn van geheugensnelheid, levert de AI-versnelling van AMD Ryzen leiderschapsprestaties. In tests presteerde de Ryzen 7500 HX 8533 tot 9% beter dan Intel in tokens per seconde, ondanks dat de RAM-snelheid van de AMD-laptop 375 MT/s bedroeg vergeleken met 27 MT/s van Intel, een metriek die aangeeft hoeveel woorden per seconde de LLM genereert.

In het Meta Llama 3.2 1b Instruct-model (met 4-bits kwantisering) liet de AMD Ryzen 9 HX 375 een piekoutput zien van 50.7 tokens per seconde. Voor grotere modellen bereikte het een tot 3.5x snellere "time to first token" vergeleken met concurrerende processors. Dit is een belangrijke benchmark die de latentie meet tussen prompt submission en eerste respons.

Elk van de drie accelerators binnen AMD Ryzen AI CPU's is geoptimaliseerd voor specifieke taken, waarbij de op XDNA 2-architectuur gebaseerde NPU's uitblinken in efficiëntie voor persistente AI. Terwijl CPU's brede compatibiliteit ondersteunen met AI-tools, verwerken iGPU's veel on-demand AI-bewerkingen, wat flexibiliteit biedt voor realtime-applicaties.

De aanpassing van llama.cpp door LM Studio maakt gebruik van de Vulkan API voor platformonafhankelijke GPU-versnelling. Deze optimalisatie heeft een verbetering van 31% laten zien in de Meta Llama 3.2 1b Instruct-prestaties bij het offloaden van taken naar de GPU. In grotere modellen, zoals Mistral Nemo 2407 12b Instruct, leidde deze aanpak tot een prestatieverbetering van 5.1%. Testen op concurrerende processors lieten geen significante winst zien in GPU-offloading voor de meeste modellen, dus deze resultaten werden uitgesloten voor een eerlijke vergelijking.

Bovendien beschikken de Ryzen AI 300 Series-processors van AMD over Variable Graphics Memory (VGM), waarmee de toegewezen iGPU-toewijzing kan worden uitgebreid door tot 75% van het systeem-RAM te gebruiken. Toen VGM was ingeschakeld, namen de prestaties in Meta Llama 3.2 1b Instruct met 22% toe, wat resulteerde in een totale snelheidswinst van 60% bij iGPU-versnelde taken. Zelfs grote modellen profiteerden van VGM en behaalden tot 17% betere prestaties ten opzichte van CPU-only-verwerking.

Hoewel de laptopconfiguratie van de concurrentie niet profiteerde van Vulkan-gebaseerde GPU-offloading in LM Studio, werden de prestaties beoordeeld met behulp van Intel's AI Playground voor een objectieve vergelijking. Tests met vergelijkbare kwantificering lieten zien dat de AMD Ryzen 9 HX 375 8.7% sneller was in het Phi 3.1-model en 13% sneller in Mistral 7b Instruct 0.3.

AMD's toewijding aan het bevorderen van AI is duidelijk: door krachtige, consumentvriendelijke LLM-implementatietools zoals LM Studio mogelijk te maken, wil AMD AI democratiseren. Met de toevoeging van functies zoals Variable Graphics Memory zijn AMD Ryzen AI-processors klaar om ongeëvenaarde AI-ervaringen te bieden op x86-laptops, waardoor gebruikers state-of-the-art modellen kunnen benutten zodra ze beschikbaar zijn.

Neem contact op met StorageReview

Nieuwsbrief | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed