Tijdens een presentatie op ISC 23 benadrukte Intel zijn prestatieleiderschap voor high-performance computing (HPC) en kunstmatige intelligentie (AI) workloads, deelde zijn portfolio van toekomstige HPC- en AI-producten en kondigde ambitieuze plannen aan voor een internationale inspanning om de Aurora te gebruiken supercomputer om generatieve AI-modellen voor wetenschap en samenleving te ontwikkelen.

Tijdens een presentatie op ISC 23 benadrukte Intel zijn prestatieleiderschap voor high-performance computing (HPC) en kunstmatige intelligentie (AI) workloads, deelde zijn portfolio van toekomstige HPC- en AI-producten en kondigde ambitieuze plannen aan voor een internationale inspanning om de Aurora te gebruiken supercomputer om generatieve AI-modellen voor wetenschap en samenleving te ontwikkelen.

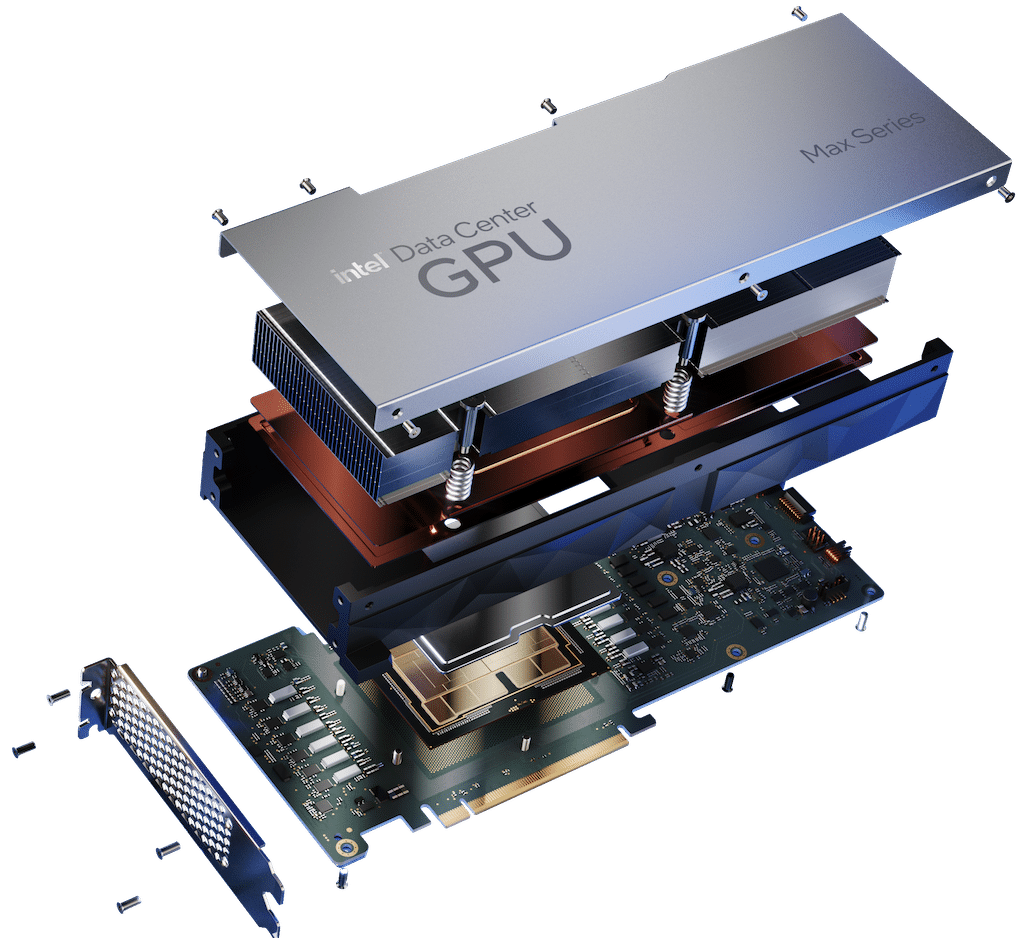

De concurrentieprestaties stonden bovenaan de lijst, waarbij de resultaten van Intel duidelijke winnaars waren ten opzichte van de concurrentie. Intel's Data Center GPU Max-serie presteerde gemiddeld 100 procent beter dan de NVIDIA H30 PCIe-kaart bij diverse workloads. Onafhankelijke resultaten van softwareleverancier Ansys wezen op een versnelling van 50 procent voor de Max Series GPU ten opzichte van de H100 op AI-versnelde HPC-applicaties.

De CPU uit de Xeon Max-serie vertoonde een verbetering van 65 procent in vergelijking met AMD's Genoa-processor op de HPCG-benchmark (High-Performance Conjugate Gradients), en verbruikte minder stroom. Een HPC-favoriet, de 4e generatie Intel Xeon Scalable Processor, leverde een gemiddelde versnelling van 50 procent ten opzichte van AMD's Milan4. BP's nieuwste 4e generatie Xeon HPC-cluster vertoonde een 8x betere prestatie dan zijn vorige generatie processor met verbeterde energie-efficiëntie. De Gaudi2 deep learning-versneller presteerde competitief op het gebied van deep learning, training en inferentie, met tot 2.4x snellere prestaties dan NVIDIA's A100.

Next-Gen CPU's en AI-geoptimaliseerde GPU's

Intel's Jeff McVeigh, Intel corporate vice president en general manager van de Super Compute Group, introduceerde Intel's volgende generatie CPU's die zijn ontworpen om te voldoen aan de hoge eisen aan geheugenbandbreedte. Intel heeft een nieuw type DIMM ontwikkeld – Multiplexer Combined Ranks (MCR) – voor Granite Rapids. MCR bereikt snelheden van 8,800 megatransfers per seconde op basis van DDR5 en meer dan 1.5 terabytes/seconde (TB/s) aan geheugenbandbreedte in een systeem met twee sockets.

Intel heeft ook een nieuw, AI-geoptimaliseerd x8 Max Series GPU-subsysteem van Supermicro onthuld, ontworpen om deep learning-training te versnellen. OEM's zullen naar verwachting ergens deze zomer oplossingen aanbieden met Max Series GPU's x4 en x8 OAM-subsystemen en PCIe-kaarten.

Intel's next-generation Max Series GPU, Falcon Shores, geeft klanten de flexibiliteit om CPU- en discrete GPU-combinaties op systeemniveau te implementeren voor nieuwe en steeds veranderende workloads van de toekomst. Het Falcon Shores-systeem maakt gebruik van een modulaire, op tegels gebaseerde architectuur, waardoor het:

- Ondersteuning van HPC- en AI-gegevenstypen van FP64 tot BF16 tot FP8.

- Maak tot 288 GB HBM3-geheugen mogelijk met een totale bandbreedte tot 9.8 TB/s en sterk verbeterde high-speed I/O.

- Versterk het CXL-programmeermodel.

- Presenteer een uniforme GPU-programmeerinterface via oneAPI.

Generatieve AI voor de wetenschap

Argonne National Laboratory heeft in samenwerking met Intel en HPE plannen aangekondigd om een reeks generatieve AI-modellen te creëren voor de wetenschappelijke onderzoeksgemeenschap. Deze generatieve AI-modellen voor de wetenschap worden getraind op algemene tekst, code, wetenschappelijke teksten en gestructureerde wetenschappelijke gegevens uit de biologie, scheikunde, materiaalkunde, natuurkunde, geneeskunde en andere bronnen.

De resulterende modellen (met maar liefst 1 biljoen parameters) zullen worden gebruikt in een verscheidenheid aan wetenschappelijke toepassingen, van het ontwerp van moleculen en materialen tot de synthese van kennis uit miljoenen bronnen om nieuwe en opwindende experimenten in systeembiologie, polymeerchemie te suggereren. en energiematerialen, klimaatwetenschap en kosmologie. Het model zal ook worden gebruikt om de identificatie van biologische processen die verband houden met kanker en andere ziekten te versnellen en om doelen voor het ontwerpen van geneesmiddelen voor te stellen.

Om het project vooruit te helpen, leidt Argonne een internationale samenwerking die omvat:

- Intel

- HPE

- Afdeling Energielaboratoria

- Amerikaanse en internationale universiteiten

- Non-profitorganisaties

- Internationale partners

Aurora zal bij de lancering dit jaar naar verwachting meer dan twee exaflops aan piekprestaties met dubbele precisie bieden.

oneAPI Voordelen HPC-applicaties

De nieuwste Intel oneAPI-tools leveren versnellingen voor HPC-applicaties met OpenMP GPU-offload, breiden de ondersteuning voor OpenMP en Fortran uit, en versnellen AI en deep learning door geoptimaliseerde frameworks, waaronder TensorFlow en PyTorch, en AI-tools, waardoor betere prestatieverbeteringen mogelijk zijn.

Programmeren met meerdere architectuur is eenvoudiger voor programmeurs dankzij oneAPI's SYCL-implementatie, oneAPI-plug-ins voor NVIDIA- en AMD-processors ontwikkeld door Codeplay, en de Intel DPC++ Compatibility Tool die code migreert van CUDA naar SYCL en C++, waar 90-95 procent van de code doorgaans automatisch migreert . De resulterende SYCL-code vertoont vergelijkbare prestaties met dezelfde code die wordt uitgevoerd op NVIDIA- en AMD-native systeemtalen. Gegevens tonen aan dat SYCL-code voor de DPEcho-astrofysica-applicatie die op de Max Series GPU draait, 100 procent beter presteert dan dezelfde CUDA-code op NVIDIA H48.

Neem contact op met StorageReview

Nieuwsbrief | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed