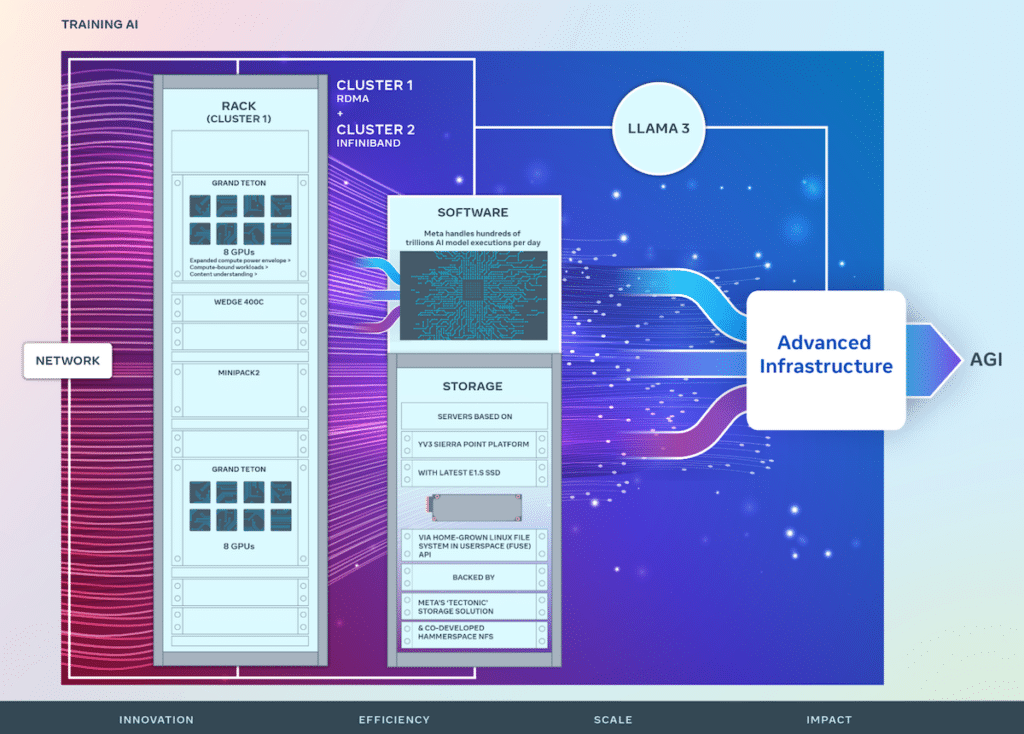

Meta zet zijn AI-innovatie voort door strategische investeringen in hardware-infrastructuur, cruciaal voor het bevorderen van AI-technologieën. Het bedrijf heeft onlangs details onthuld over twee iteraties van zijn datacenterschaalcluster met 24,576 GPU's, dat een belangrijke rol speelt bij het aansturen van AI-modellen van de volgende generatie, waaronder de ontwikkeling van Llama 3.

Meta zet zijn AI-innovatie voort door strategische investeringen in hardware-infrastructuur, cruciaal voor het bevorderen van AI-technologieën. Het bedrijf heeft onlangs details onthuld over twee iteraties van zijn datacenterschaalcluster met 24,576 GPU's, dat een belangrijke rol speelt bij het aansturen van AI-modellen van de volgende generatie, waaronder de ontwikkeling van Llama 3. Dit initiatief vormt de basis van Meta's visie om open en verantwoord gebouwde datacenters te genereren. kunstmatige algemene intelligentie (AGI) die voor iedereen toegankelijk is.

Foto met dank aan META Engineering

In zijn voortdurende reis heeft Meta zijn AI Research SuperCluster (RSC), oorspronkelijk onthuld in 2022, verfijnd met 16,000 NVIDIA A100 GPU's. Het RSC heeft een cruciale rol gespeeld bij het bevorderen van open AI-onderzoek en het bevorderen van de creatie van geavanceerde AI-modellen met toepassingen die vele domeinen bestrijken, waaronder computervisie, natuurlijke taalverwerking (NLP), spraakherkenning en meer.

Voortbouwend op de successen van het RSC verbeteren de nieuwe AI-clusters van Meta de end-to-end AI-systeemontwikkeling met de nadruk op het optimaliseren van de ervaring van onderzoekers en ontwikkelaars. Deze clusters integreren 24,576 NVIDIA Tensor Core H100 GPU's en maken gebruik van krachtige netwerkstructuren om complexere modellen te ondersteunen dan voorheen mogelijk was, waardoor een nieuwe standaard wordt gezet voor GenAI-productontwikkeling en onderzoek.

De infrastructuur van Meta is zeer geavanceerd en aanpasbaar en verwerkt dagelijks honderden biljoenen AI-modeluitvoeringen. Het op maat gemaakte ontwerp van hardware en netwerkstructuren zorgt voor geoptimaliseerde prestaties voor AI-onderzoekers, terwijl de efficiënte werking van het datacenter behouden blijft.

Er zijn innovatieve netwerkoplossingen geïmplementeerd, waaronder een cluster met externe directe geheugentoegang (RDMA) via geconvergeerd Ethernet (RoCE) en een andere met NVIDIA Quantum2 InfiniBand-fabric, beide geschikt voor 400 Gbps-interconnecties. Deze technologieën maken schaalbaarheid en prestatie-inzichten mogelijk die cruciaal zijn voor het ontwerp van toekomstige grootschalige AI-clusters.

Grand Teton geïntroduceerd tijdens OCP 2022

Meta's Grand Teton, een intern ontworpen, open GPU-hardwareplatform, draagt bij aan het Open Compute Project (OCP) en belichaamt jarenlange AI-systeemontwikkeling. Het combineert stroom-, controle-, reken- en fabric-interfaces tot een samenhangende eenheid, waardoor snelle implementatie en schaalvergroting binnen datacenteromgevingen mogelijk wordt gemaakt.

Om de vaak onderbelichte maar cruciale rol van opslag in AI-training aan te pakken, heeft Meta een aangepaste Linux Filesystem in Userspace (FUSE) API geïmplementeerd, ondersteund door een geoptimaliseerde versie van de 'Tectonic' gedistribueerde opslagoplossing. Deze opstelling, gecombineerd met het mede ontwikkelde Hammerspace parallelle netwerkbestandssysteem (NFS), biedt een schaalbare opslagoplossing met hoge doorvoer die essentieel is voor het verwerken van de enorme gegevensbehoeften van multimodale AI-trainingstaken.

Meta's YV3 Sierra Point-serverplatform, ondersteund door Tectonic- en Hammerspace-oplossingen, onderstreept de toewijding van het bedrijf aan prestaties, efficiëntie en schaalbaarheid. Deze vooruitziende blik zorgt ervoor dat de opslaginfrastructuur aan de huidige eisen kan voldoen en kan worden geschaald om tegemoet te komen aan de groeiende behoeften van toekomstige AI-initiatieven.

Naarmate AI-systemen steeds complexer worden, zet Meta zijn open-source innovatie op het gebied van hardware en software voort, waardoor een aanzienlijke bijdrage wordt geleverd aan OCP en PyTorch, waardoor gezamenlijke vooruitgang binnen de AI-onderzoeksgemeenschap wordt bevorderd.

De ontwerpen van deze AI-trainingsclusters zijn een integraal onderdeel van Meta's roadmap, gericht op het uitbreiden van de infrastructuur met de ambitie om tegen eind 350,000 100 NVIDIA H2024 GPU's te integreren. Dit traject benadrukt Meta's proactieve benadering van infrastructuurontwikkeling, klaar om te voldoen aan de dynamische eisen van toekomstig AI-onderzoek en -toepassingen.

Neem contact op met StorageReview

Nieuwsbrief | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed