Supermicro heeft een nieuwe reeks oplossingen gelanceerd om de inzet van generatieve AI te bevorderen, wat een belangrijke stap markeert in de evolutie van de infrastructuur voor grote taalmodellen (LLM's). Deze SuperCluster-oplossingen zijn ontworpen als kerncomponenten om de huidige en toekomstige AI-eisen te ondersteunen.

Supermicro heeft een nieuwe reeks oplossingen gelanceerd om de inzet van generatieve AI te bevorderen, wat een belangrijke stap markeert in de evolutie van de infrastructuur voor grote taalmodellen (LLM's). Deze SuperCluster-oplossingen zijn ontworpen als kerncomponenten om de huidige en toekomstige AI-eisen te ondersteunen.

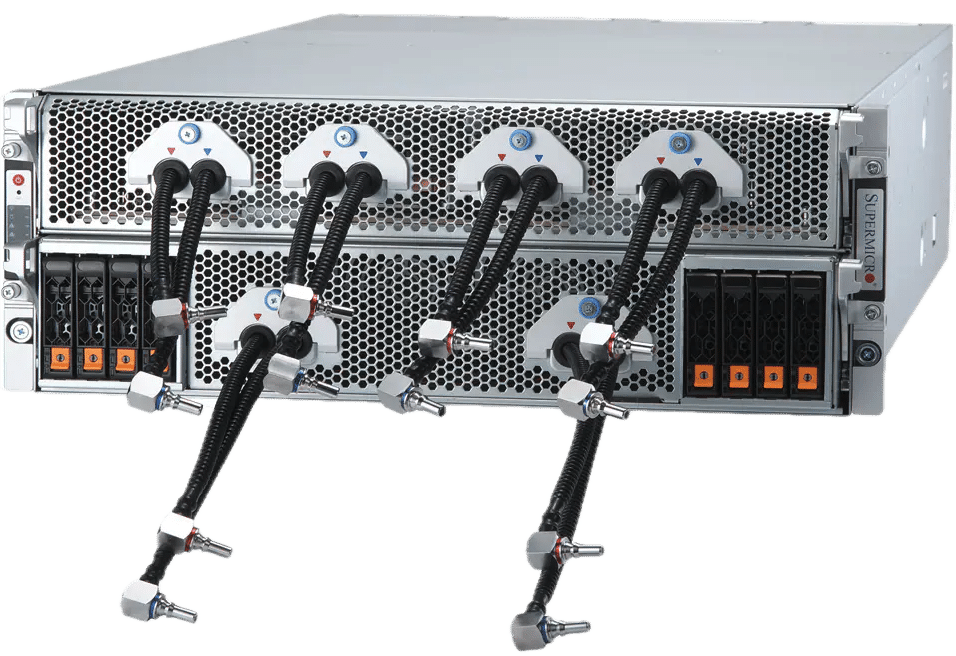

Deze nieuwe release bevat drie verschillende SuperCluster-configuraties die zijn afgestemd op generatieve AI-taken. Opties zijn onder meer een 4U vloeistofgekoeld systeem en een 8U luchtgekoelde opstelling, ontworpen voor intensieve LLM-training en LLM-gevolgtrekking met hoge capaciteit. Bovendien is een 1U luchtgekoelde variant met Supermicro NVIDIA MGX-systemen gericht op inferentietoepassingen op cloudschaal. Deze systemen zijn gebouwd om ongeëvenaarde prestaties te leveren bij LLM-training en beschikken over functies zoals grote batchgroottes en substantiële volumeverwerkingsmogelijkheden voor LLM-inferentie.

Uitbreiding van de capaciteit voor AI-clusters

Met de mogelijkheid om tot 5,000 racks per maand te produceren, is Supermicro gepositioneerd om snel complete generatieve AI-clusters te leveren, wat snellere leveringssnelheden aan zijn klanten belooft. Een cluster met 64 knooppunten kan bijvoorbeeld 512 NVIDIA HGX H200 GPU's bevatten, waarbij gebruik wordt gemaakt van snelle NVIDIA Quantum-2 InfiniBand- en Spectrum-X Ethernet-netwerken om een robuuste AI-trainingsomgeving te realiseren. In combinatie met NVIDIA AI Enterprise-software is deze configuratie een ideale oplossing voor bedrijfs- en cloudinfrastructuren die ernaar streven geavanceerde LLM's te trainen met biljoenen parameters.

Innovatieve koeling en prestaties

De nieuwe Supermicro 4U NVIDIA HGX H100/H200 8-GPU-systemen maken gebruik van vloeistofkoeling om de dichtheid te verdubbelen in vergelijking met de 8U luchtgekoelde alternatieven, wat resulteert in een lager energieverbruik en een verlaging van de totale eigendomskosten voor datacenters. Deze systemen ondersteunen op NVIDIA Blackwell-architectuur gebaseerde GPU's van de volgende generatie, met efficiënte koelingstechnologieën die optimale temperaturen handhaven voor maximale prestaties.

SuperCluster-specificaties

De Supermicro SuperClusters zijn schaalbare oplossingen voor het trainen van enorme basismodellen en het creëren van LLM-inferentie-infrastructuren op cloudschaal. Met een zeer schaalbare netwerkarchitectuur kunnen deze systemen uitbreiden van 32 knooppunten naar duizenden, waardoor naadloze schaalbaarheid wordt gegarandeerd. De integratie van geavanceerde vloeistofkoeling en uitgebreide testprocessen garanderen operationele efficiëntie en effectiviteit.

Supermicro beschrijft twee primaire configuraties: de SuperCluster met 4U vloeistofgekoeld systeem, geschikt voor ondersteuning van maximaal 512 GPU's in een compact formaat, en de SuperCluster met 1U luchtgekoeld NVIDIA MGX-systeem, ontworpen voor inferentietaken met een hoog volume en lage latentie . Beide configuraties worden benadrukt vanwege hun hoge netwerkprestaties, wat essentieel is voor LLM-training en gevolgtrekking.

Hier is een kort overzicht van hun specificaties:

SuperCluster met 4U vloeistofgekoeld systeem in 5 racks of 8U luchtgekoeld systeem in 9 racks

- 256 NVIDIA H100/H200 Tensor Core GPU's in één schaalbare eenheid

- Vloeistofkoeling maakt 512 GPU's, 64 knooppunten mogelijk, in dezelfde footprint als de luchtgekoelde oplossing met 256 GPU's, 32 knooppunten

- 20TB HBM3 met NVIDIA H100 of 36TB HBM3e met NVIDIA H200 in één schaalbare eenheid

- 1:1-netwerken leveren tot 400 Gbps aan elke GPU om GPUDirect RDMA en opslag mogelijk te maken voor het trainen van grote taalmodellen met maximaal biljoenen parameters

- 400G InfiniBand- of 400GbE Ethernet-switch-fabrics met zeer schaalbare 'spinleaf'-netwerktopologie, inclusief NVIDIA Quantum-2 InfiniBand en NVIDIA Spectrum-X Ethernet Platform.

- Aanpasbare AI-datapijplijnopslagstructuur met toonaangevende parallelle bestandssysteemopties

- NVIDIA AI Enterprise 5.0-software, die ondersteuning biedt voor nieuwe NVIDIA NIM-inferentiemicroservices die de implementatie van AI-modellen op schaal versnellen

SuperCluster met 1U luchtgekoeld NVIDIA MGX-systeem in 9 racks

- 256 GH200 Grace Hopper Superchips in één schaalbare eenheid

- Tot 144 GB HBM3e + 480 GB LPDDR5X verenigd geheugen geschikt voor cloud-schaal, hoog volume, lage latentie en hoge batchgrootte-inferentie, geschikt voor een parametermodel van meer dan 70 miljard in één knooppunt.

- 400G InfiniBand- of 400G Ethernet-switch-fabrics met zeer schaalbare netwerktopologie

- Maximaal 8 ingebouwde E1.S NVMe-opslagapparaten per knooppunt

- Aanpasbare AI-datapijplijnopslagstructuur met NVIDIA BlueField-3 DPU's en toonaangevende parallelle bestandssysteemopties voor opslagtoegang met hoge doorvoer en lage latentie voor elke GPU

- NVIDIA AI Enterprise 5.0-software

Supermicro breidt AI-portfolio uit met nieuwe systemen en racks met behulp van NVIDIA Blackwell-architectuur

Supermicro kondigt ook de uitbreiding aan van zijn AI-systeemaanbod, inclusief de nieuwste NVIDIA-datacenterinnovaties gericht op grootschalige generatieve AI. Tot deze nieuwe technologieën behoren de NVIDIA GB200 Grace Blackwell Superchip en de B200 en B100 Tensor Core GPU's.

Om aan deze ontwikkelingen tegemoet te komen, is Supermicro zijn bestaande systemen naadloos aan het upgraden NVIDIA HGX H100/H200 8-GPU-systemen om de NVIDIA HGX B100 8-GPU en B200 te integreren. Bovendien zal de NVIDIA HGX-reeks worden versterkt met de nieuwe modellen met de NVIDIA GB200, inclusief een uitgebreide oplossing op rackniveau uitgerust met 72 NVIDIA Blackwell GPU's. Naast deze verbeteringen introduceert Supermicro een nieuw 4U NVIDIA HGX B200 8-GPU vloeistofgekoeld systeem, waarbij gebruik wordt gemaakt van direct-to-chip vloeistofkoelingstechnologie om aan de toegenomen thermische eisen van de nieuwste GPU's te voldoen en de volledige prestatiemogelijkheden van NVIDIA's te ontsluiten. Blackwell-technologie.

De GPU-geoptimaliseerde systemen van de nieuwe Supermicro zullen binnenkort beschikbaar zijn, volledig compatibel met de NVIDIA Blackwell B200 en B100 Tensor Core GPU's en gecertificeerd voor de nieuwste NVIDIA AI Enterprise-software. De Supermicro-reeks omvat diverse configuraties, van NVIDIA HGX B100 en B200 8-GPU-systemen tot SuperBlades die plaats bieden aan maximaal 20 B100 GPU's, wat veelzijdigheid en hoge prestaties garandeert voor een breed scala aan AI-toepassingen. Deze systemen omvatten de eerste NVIDIA HGX B200 en B100 8-GPU-modellen op de markt met geavanceerde NVIDIA NVLink-interconnect-technologie. Supermicro geeft aan dat ze klaar zijn om trainingsresultaten voor LLM's te leveren (3x sneller) en schaalbare clustering te ondersteunen voor veeleisende AI-workloads, wat een aanzienlijke sprong voorwaarts betekent in de rekenefficiëntie en prestaties van AI.

Supermicro vloeistofkoelingtechnologie

Neem contact op met StorageReview

Nieuwsbrief | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed