A mais recente tecnologia da AMD oferece suporte ao LM Studio para funcionalidade de IA de alto desempenho sem exigir experiência em codificação ou conhecimento técnico.

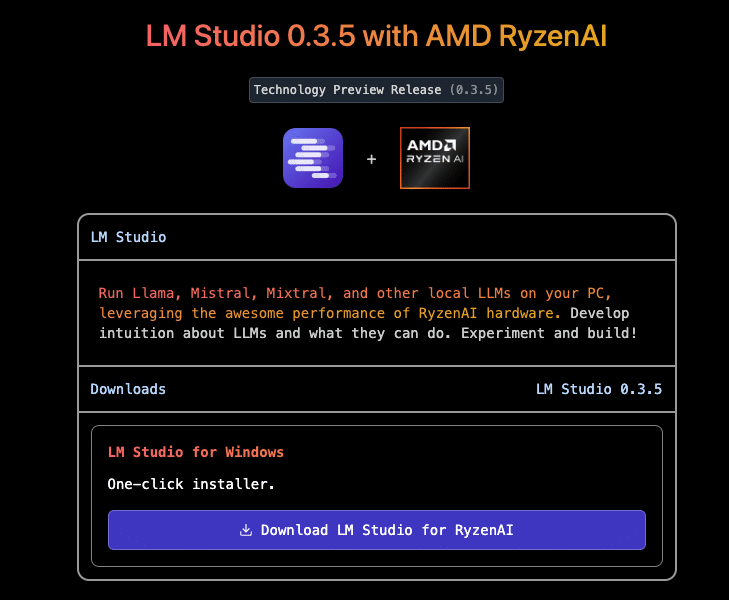

Avanços recentes em modelos de linguagem grande (LLMs), incluindo ferramentas acessíveis como o LM Studio, capacitaram os usuários a implantar modelos de IA sofisticados de forma rápida e sem esforço. A mais recente tecnologia da AMD suporta a funcionalidade de IA de alto desempenho do LM Studio sem exigir experiência em codificação ou conhecimento técnico.

Desenvolvido no framework llama.cpp, o LM Studio foi projetado para implantação rápida de LLM. Este framework opera sem dependências e tem desempenho eficiente em CPUs, embora a aceleração de GPU esteja disponível. Para otimizar o desempenho de CPUs baseadas em x86, o LM Studio aproveita as instruções AVX2, aprimorando a compatibilidade e a velocidade em processadores modernos.

AMD Ryzen AI, integrado ao processador Ryzen 9 HX 375, aumenta o desempenho do LLM em aplicativos como o LM Studio, especialmente para laptops x86. Embora os LLMs dependam significativamente da velocidade da memória, a aceleração de IA do AMD Ryzen oferece desempenho de liderança. Em testes, apesar da velocidade da RAM do laptop AMD ser de 7500 MT/s em comparação com os 8533 MT/s da Intel, o Ryzen 9 HX 375 superou a Intel em até 27% em tokens por segundo — uma métrica que indica quantas palavras por segundo o LLM gera.

No modelo Meta Llama 3.2 1b Instruct (usando quantização de 4 bits), o AMD Ryzen 9 HX 375 demonstrou uma saída de pico de 50.7 tokens por segundo. Para modelos maiores, ele atingiu um “tempo para o primeiro token” até 3.5x mais rápido em comparação com processadores concorrentes. Este é um benchmark significativo que mede a latência entre o envio rápido e a resposta inicial.

Cada um dos três aceleradores dentro das CPUs AMD Ryzen AI é otimizado para tarefas específicas, com as NPUs baseadas na arquitetura XDNA 2 se destacando em eficiência para IA persistente. Enquanto as CPUs suportam ampla compatibilidade entre ferramentas de IA, as iGPUs lidam com muitas operações de IA sob demanda, oferecendo flexibilidade para aplicativos em tempo real.

A adaptação do llama.cpp do LM Studio usa a API Vulkan para aceleração de GPU independente de plataforma. Essa otimização mostrou uma melhoria de 31% no desempenho do Meta Llama 3.2 1b Instruct ao descarregar tarefas para a GPU. Em modelos maiores, como o Mistral Nemo 2407 12b Instruct, essa abordagem levou a um aumento de desempenho de 5.1%. Os testes em processadores concorrentes não mostraram ganhos significativos no descarregamento de GPU para a maioria dos modelos, então esses resultados foram excluídos para uma comparação justa.

Além disso, os processadores Ryzen AI 300 Series da AMD apresentam Variable Graphics Memory (VGM), que permite estender a alocação dedicada de iGPU usando até 75% da RAM do sistema. Quando o VGM foi habilitado, o desempenho no Meta Llama 3.2 1b Instruct aumentou em 22%, resultando em um ganho total de velocidade de 60% em tarefas aceleradas por iGPU. Até mesmo modelos grandes se beneficiaram do VGM, alcançando até 17% de desempenho melhorado em relação ao processamento somente de CPU.

Embora a configuração do laptop da concorrência não tenha se beneficiado do offloading de GPU baseado em Vulkan no LM Studio, o desempenho foi avaliado usando o AI Playground da Intel para uma comparação objetiva. Testes com quantização comparável descobriram que o AMD Ryzen 9 HX 375 foi 8.7% mais rápido no modelo Phi 3.1 e 13% mais rápido no Mistral 7b Instruct 0.3.

O compromisso da AMD com o avanço da IA é claro: ao habilitar ferramentas de implantação de LLM poderosas e amigáveis ao consumidor, como o LM Studio, a AMD visa democratizar a IA. Com a adição de recursos como Variable Graphics Memory, os processadores AMD Ryzen AI estão prontos para oferecer experiências de IA inigualáveis em laptops x86, garantindo que os usuários possam aproveitar modelos de última geração assim que estiverem disponíveis.

Envolva-se com a StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS feed