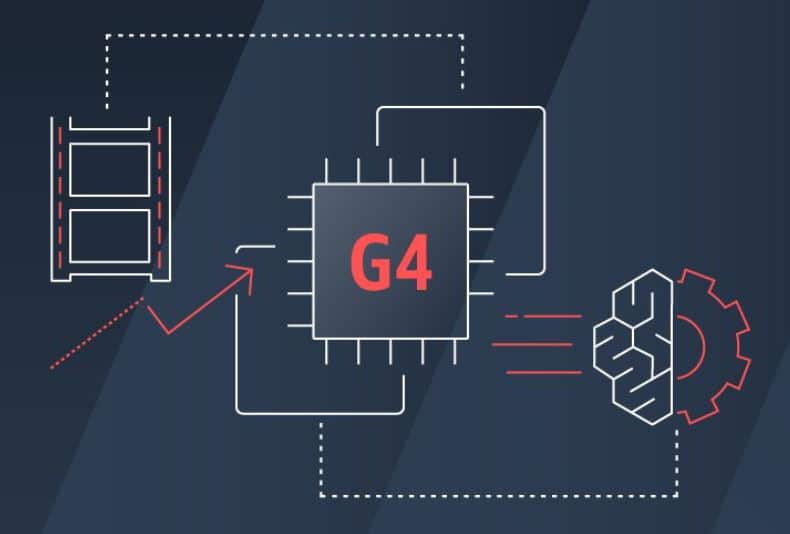

Hoje, a Amazon Web Services, Inc. (AWS) anunciou a disponibilidade geral de uma nova instância do Amazon Elastic Compute Cloud (Amazon EC2) movida a GPU, a G4 Instance. Essa nova instância foi projetada para acelerar a inferência de aprendizado de máquina (ML), ao mesmo tempo em que fornece a inferência de ML mais econômica do setor para aplicativos. A nova instância também é ótima para cargas de trabalho com uso intensivo de gráficos de maneira econômica e seria ideal para criar e executar aplicativos com uso intensivo de gráficos, como estações de trabalho gráficas remotas, transcodificação de vídeo, design fotorrealista e streaming de jogos na nuvem .

A AWS afirma que o ML envolve dois processos que exigem computação – treinamento e inferência. O treinamento envolve o uso de dados rotulados para criar um modelo capaz de fazer previsões, uma tarefa de computação intensiva que requer processadores poderosos e rede de alta velocidade. A inferência é o processo de usar um modelo de aprendizado de máquina treinado para fazer previsões, o que normalmente requer o processamento de vários pequenos trabalhos de computação simultaneamente. Este trabalho é ideal para as poderosas GPUs da NVIDIA. A AWS não é estranha a instâncias para ML, lançando a instância P3 pela primeira vez há dois anos. Embora esse tenha sido um grande passo, a inferência ocupa a maior parte dos custos operacionais das cargas de trabalho de ML.

Para resolver isso, a AWS lançou as novas instâncias G4 que aproveitam as GPUs NVIDIA T4 de última geração, processadores personalizados Intel Xeon Scalable (Cascade Lake) de segunda geração, até 2 Gbps de taxa de transferência de rede e até 100 TB de armazenamento NVMe local, para forneça as instâncias de GPU mais econômicas para inferência de aprendizado de máquina. As novas instâncias G1.8 podem fornecer até 4 TFLOPs de desempenho de precisão mista, ótimo para inferência. Os G65 também podem ser usados de forma econômica para trabalhos de treinamento de aprendizado de máquina de nível básico e de pequena escala que são menos sensíveis ao tempo de treinamento. Para cargas de trabalho com uso intensivo de gráficos, as novas instâncias oferecem aumento de até 4x no desempenho gráfico e capacidade de transcodificação de vídeo de até 1.8x em relação às instâncias G2 da geração anterior.

Disponibilidade

As instâncias G4 estão disponíveis para compra como sob demanda, instâncias reservadas ou instâncias spot.

Inscreva-se no boletim informativo StorageReview