O acelerador de aprendizado profundo Intel Habana Gaudi2 e os processadores Intel Xeon Scalable de 4ª geração demonstraram resultados impressionantes no benchmark MLPerf Training 3.0, de acordo com um comunicado de imprensa da empresa. O benchmark, publicado pela MLCommons, é um padrão da indústria amplamente reconhecido para desempenho de IA.

O acelerador de aprendizado profundo Intel Habana Gaudi2 e os processadores Intel Xeon Scalable de 4ª geração demonstraram resultados impressionantes no benchmark MLPerf Training 3.0, de acordo com um comunicado de imprensa da empresa. O benchmark, publicado pela MLCommons, é um padrão da indústria amplamente reconhecido para desempenho de IA.

Os resultados desafiam a narrativa predominante do setor de que IA generativa e modelos de linguagem grande (LLMs) só podem ser executados em GPUs NVIDIA. O portfólio de soluções de IA da Intel oferece alternativas competitivas para clientes que buscam se afastar de ecossistemas fechados que limitam a eficiência e a escalabilidade.

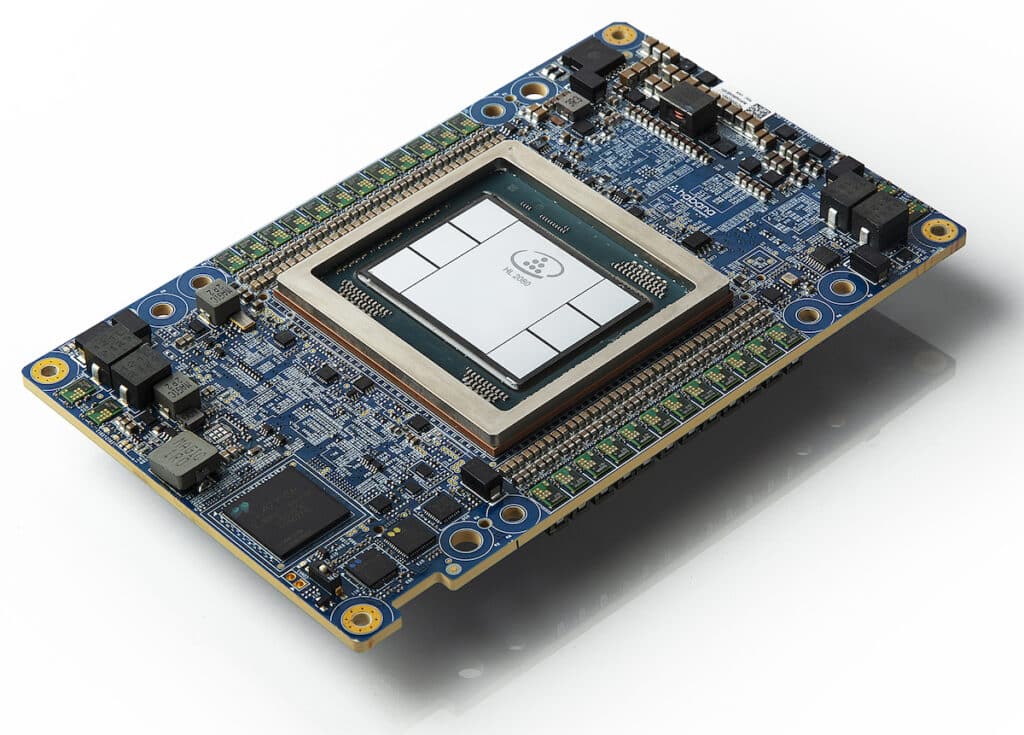

Uma foto mostra o Habana Gaudi2 Mezzanine Card. Em 10 de maio de 2022, o Habana Labs, a equipe de data center da Intel focada em tecnologias de processador de aprendizado profundo de IA, lançou seus processadores de aprendizado profundo de segunda geração para treinamento e inferência: Habana Gaudi2 e Habana Greco. (Crédito: Intel Corporation)

O que é MLPerf?

A Treinamento MLPerf 3.0 suíte de referência mede a velocidade na qual diferentes sistemas podem treinar modelos para atender a uma métrica de qualidade especificada. Os benchmarks cobrem várias áreas, incluindo visão, linguagem e comércio, e usam diferentes conjuntos de dados e metas de qualidade.

Detalhes do comparativo de mercado

| Área | referência | Conjunto de dados | Alvo de qualidade | Modelo de implementação de referência |

|---|---|---|---|---|

| Visão | Classificação de imagem | IMAGEnet | 75.90% classificação | ResNet-50 v1.5 |

| Visão | Segmentação de imagem (médica) | KiTS19 | 0.908 Pontuação média do DICE | U-Net Modelo 3D |

| Visão | Detecção de objetos (peso leve) | Abrir imagens | 34.0% mAP | RetinaNet |

| Visão | Detecção de objetos (peso pesado) | COCO | 0.377 Caixa min AP e 0.339 Máscara min AP | Máscara R-CNN |

| Língua | Reconhecimento de fala | LibriSpeech | 0.058 Taxa de Erro de Palavra | RNN-T |

| Língua | PNL | Wikipédia 2020/01/01 | 0.72 Precisão da máscara-LM | BERT-grande |

| Língua | LLM | C4 | 2.69 registros de perplexidade | GPT3 |

| Varejo | Recomendação | Criteo 4TB multiquente | 0.8032 AUC | DLRM-dcnv2 |

No campo de visão, os benchmarks incluem classificação de imagens usando o conjunto de dados ImageNet com uma meta de qualidade de 75.90% de precisão de classificação. O modelo de referência para esta tarefa é o ResNet-50 v1.5. Outros benchmarks de visão incluem segmentação de imagens usando o conjunto de dados médicos KiTS19 e detecção de objetos usando os conjuntos de dados Open Images e COCO.

Para tarefas de linguagem, os benchmarks incluem reconhecimento de fala usando o conjunto de dados LibriSpeech com uma meta de qualidade de 0.058 Word Error Rate. O modelo de referência para esta tarefa é o RNN-T. Outros benchmarks de linguagem incluem processamento de linguagem natural (NLP) usando o conjunto de dados Wikipedia 2020/01/01 e treinamento de modelo de linguagem grande (LLM) usando o conjunto de dados C4.

Na área de comércio, o benchmark é uma tarefa de recomendação usando o conjunto de dados multi-hot Criteo 4TB com uma meta de qualidade de 0.8032 AUC. O modelo de referência para esta tarefa é DLRM-dcnv2.

Métrica de medição

O conjunto de benchmark mede o tempo para treinar um modelo em um conjunto de dados específico para atingir um alvo de qualidade especificado. Devido à variabilidade inerente nos tempos de treinamento de aprendizado de máquina, os resultados finais são obtidos executando o benchmark várias vezes, descartando os resultados mais altos e mais baixos e, em seguida, calculando a média dos resultados restantes. Apesar disso, ainda há alguma variação nos resultados, com resultados de benchmark de imagem tendo aproximadamente +/- 2.5% de variação e outros benchmarks tendo cerca de +/- 5% de variação.

Divisões de referência

O MLPerf incentiva a inovação em software e hardware, permitindo que os participantes reimplementem as implementações de referência. Existem duas divisões no MLPerf: as divisões fechada e aberta. A divisão Closed foi projetada para comparar plataformas de hardware ou estruturas de software diretamente e requer o uso do mesmo modelo e otimizador da implementação de referência. Por outro lado, a divisão Open incentiva o desenvolvimento de modelos e otimizadores mais rápidos e permite que qualquer abordagem de aprendizado de máquina atinja a qualidade desejada.

Disponibilidade do sistema

O MLPerf categoriza os resultados de benchmark com base na disponibilidade do sistema. Os sistemas classificados como “Disponíveis” consistem apenas em componentes que podem ser adquiridos ou alugados na nuvem. Espera-se que os sistemas de “visualização” estejam disponíveis na próxima rodada de envio. Por fim, os sistemas categorizados como “Pesquisa, Desenvolvimento ou Interno (RDI)” contêm hardware ou software experimental, em desenvolvimento ou para uso interno.

Intel Habana Guadi2 aparece

O acelerador de aprendizado profundo Gaudi2, em particular, mostrou forte atuação no modelo de linguagem grande, GPT-3, tornando-o uma das duas únicas soluções de semicondutores a enviar resultados de desempenho para treinamento LLM de GPT-3. O Gaudi2 também oferece vantagens de custo significativas em custos de servidor e sistema, tornando-o uma alternativa atraente de preço/desempenho para o H100 da NVIDIA.

Os processadores Xeon de 4ª geração com mecanismos Intel AI demonstraram que os clientes podem criar um sistema universal de IA para pré-processamento de dados, treinamento de modelo e implantação, oferecendo desempenho, eficiência, precisão e escalabilidade de IA.

O Gaudi2 apresentou um tempo de treinamento impressionante no GPT-3, alcançando 311 minutos em 384 aceleradores e escala quase linear de 95% de 256 para 384 aceleradores no modelo GPT-3. Também apresentou excelentes resultados de treinamento em visão computacional e modelos de processamento de linguagem natural. O resultados Gaudi2 foram enviados "prontos para uso", o que significa que os clientes podem esperar resultados de desempenho comparáveis ao implementar o Gaudi2 no local ou na nuvem.

Os processadores Xeon de 4ª geração, como a única apresentação de CPU entre inúmeras soluções alternativas, provaram que os processadores Intel Xeon fornecem às empresas recursos prontos para uso para implantar IA em sistemas de uso geral, evitando o custo e a complexidade da introdução de IA dedicada sistemas.

Cluster Habana Gaudi2 de 8 nós

Na tarefa de Processamento de Linguagem Natural (NLP) usando o conjunto de dados da Wikipedia e o modelo BERT-large, o Gaudi2 alcançou um tempo de treinamento de 2.103 minutos com 64 aceleradores.

Na tarefa de segmentação de imagem (médica) usando o conjunto de dados KiTS19 e o modelo 3D U-Net, o Gaudi2 alcançou um tempo de treinamento de 16.460 minutos com TensorFlow e 20.516 minutos com PyTorch, ambos com oito aceleradores.

Na tarefa Recomendação usando o conjunto de dados Criteo 4TB e o modelo DLRM-dcnv2, o Gaudi2 alcançou um tempo de treinamento de 14.794 minutos com PyTorch e 14.116 minutos com TensorFlow, ambos com oito aceleradores.

Na divisão fechada, os Xeons de 4ª geração podem treinar os modelos BERT e ResNet-50 em menos de 50 e menos de 90 minutos, respectivamente. Com o BERT na divisão aberta, o Xeon treinou o modelo em cerca de 30 minutos ao expandir para 16 nós.

Esses resultados destacam a excelente eficiência de dimensionamento possível usando adaptadores de rede Intel Ethernet 800 Series econômicos e prontamente disponíveis que utilizam o software Intel Ethernet Fabric Suite de código aberto baseado em Intel oneAPI.

Impacto no mercado

Os resultados do Intel Habana Gaudi2 no benchmark MLPerf Training 3.0 ressaltam o compromisso da empresa em fornecer soluções de IA competitivas e eficientes para uma ampla gama de aplicativos, desde o data center até a borda inteligente. A NVIDIA é claramente a líder do clube nesse aspecto, e todos os fornecedores de servidores estão tropeçando em si mesmos para mostrar ao setor uma ampla variedade de caixas pesadas de GPU que estão prontas para cargas de trabalho de IA. Mas esses dados reafirmam que a IA não é uma categoria de tamanho único e a Intel está fazendo sua parte para oferecer opções à indústria. O resultado líquido é uma vitória para as organizações que implantam IA, já que mais competição e escolha geralmente é uma coisa muito boa.

Envolva-se com a StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS feed