Durante uma apresentação no ISC 23, a Intel destacou sua liderança em desempenho para cargas de trabalho de computação de alto desempenho (HPC) e inteligência artificial (IA), compartilhou seu portfólio de futuros produtos de HPC e IA e anunciou planos ambiciosos para um esforço internacional para usar o Aurora supercomputador para desenvolver modelos de IA generativos para a ciência e a sociedade.

Durante uma apresentação no ISC 23, a Intel destacou sua liderança em desempenho para cargas de trabalho de computação de alto desempenho (HPC) e inteligência artificial (IA), compartilhou seu portfólio de futuros produtos de HPC e IA e anunciou planos ambiciosos para um esforço internacional para usar o Aurora supercomputador para desenvolver modelos de IA generativos para a ciência e a sociedade.

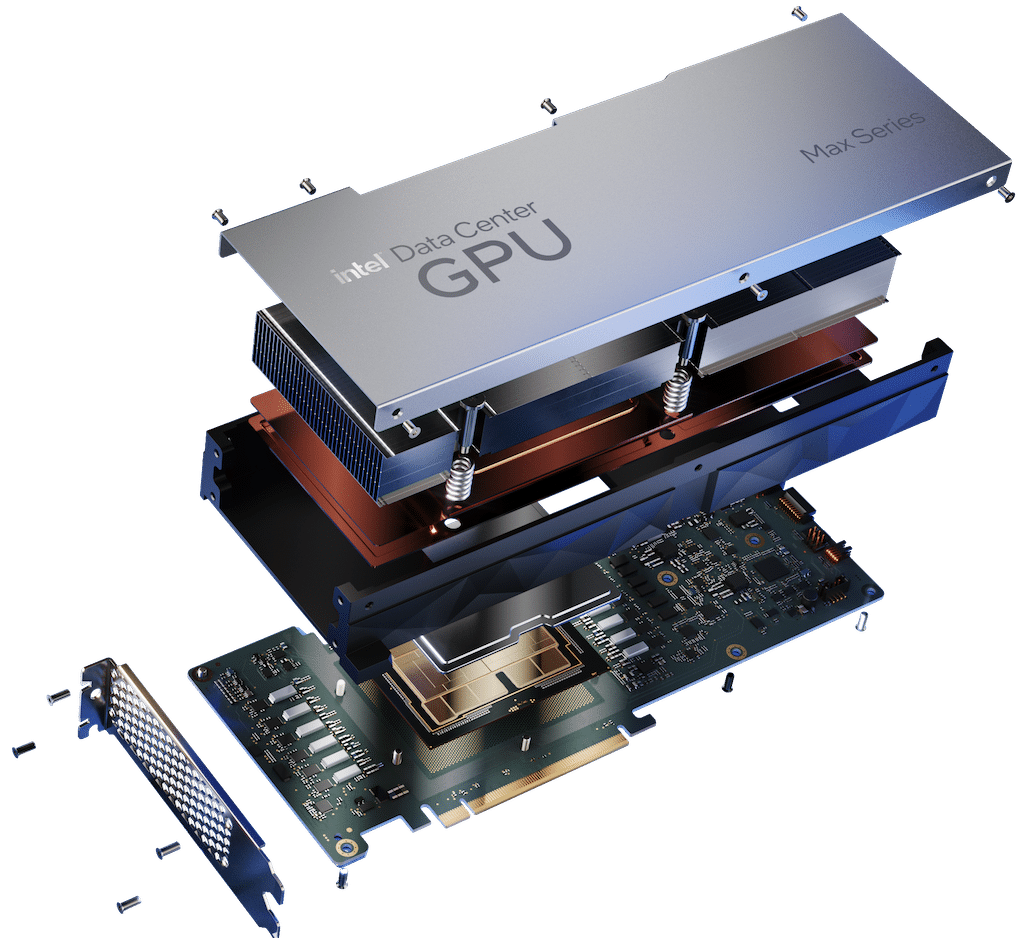

O desempenho competitivo superou a conta, onde os resultados da Intel foram vencedores claros contra a concorrência. O Data Center GPU Max Series da Intel superou a placa NVIDIA H100 PCIe em uma média de 30% em diversas cargas de trabalho. Resultados independentes do fornecedor de software Ansys indicaram uma aceleração de 50% para a GPU Max Series em relação ao H100 em aplicativos HPC acelerados por IA.

A CPU Xeon Max Series demonstrou uma melhoria de 65 por cento em comparação com o processador Genoa da AMD no benchmark High-Performance Conjugate Gradients (HPCG) e usou menos energia. Um favorito da HPC, o processador escalável Intel Xeon de 4ª geração, apresentou uma aceleração média de 50% em relação ao Milan4 da AMD. O mais novo cluster Xeon HPC de 4ª geração da BP mostrou um aumento de 8x no desempenho em relação ao processador da geração anterior com eficiência energética aprimorada. O acelerador de aprendizado profundo Gaudi2 teve desempenho competitivo em aprendizado profundo, treinamento e inferência, com desempenho até 2.4 vezes mais rápido que o A100 da NVIDIA.

CPUs de última geração e GPUs otimizadas para IA

Jeff McVeigh da Intel, vice-presidente corporativo da Intel e gerente geral do Super Compute Group, apresentou as CPUs de próxima geração da Intel projetadas para atender às altas demandas de largura de banda de memória. A Intel desenvolveu um novo tipo de DIMM–Multiplexer Combined Ranks (MCR)– para Granite Rapids. O MCR atinge velocidades de 8,800 megatransferências por segundo com base em DDR5 e mais de 1.5 terabytes/segundo (TB/s) de capacidade de largura de banda de memória em um sistema de dois soquetes.

A Intel também divulgou um novo subsistema baseado em GPU da série x8 Max otimizado para IA da Supermicro, projetado para acelerar o treinamento de aprendizado profundo. Espera-se que os OEMs ofereçam soluções com subsistemas OAM x4 e x8 de GPUs Max Series e placas PCIe ainda neste verão.

A GPU Max Series de próxima geração da Intel, Falcon Shores, dará aos clientes a flexibilidade de implementar combinações discretas de CPU e GPU no nível do sistema para cargas de trabalho novas e em constante mudança no futuro. O sistema Falcon Shores utiliza uma arquitetura modular baseada em blocos, que permite:

- Suporta tipos de dados HPC e AI de FP64 a BF16 a FP8.

- Habilite até 288 GB de memória HBM3 com largura de banda total de até 9.8 TB/s e E/S de alta velocidade amplamente aprimorada.

- Capacite o modelo de programação CXL.

- Apresente uma interface de programação de GPU unificada por meio de uma API.

IA generativa para a ciência

O Argonne National Laboratory, em colaboração com a Intel e a HPE, anunciou planos para criar uma série de modelos generativos de IA para a comunidade de pesquisa científica. Esses modelos generativos de IA para ciência serão treinados em textos gerais, códigos, textos científicos e dados científicos estruturados de biologia, química, ciência de materiais, física, medicina e outras fontes.

Os modelos resultantes (com até 1 trilhão de parâmetros) serão usados em uma variedade de aplicações científicas, desde o design de moléculas e materiais até a síntese de conhecimento em milhões de fontes para sugerir novos e empolgantes experimentos em biologia de sistemas, química de polímeros e materiais de energia, ciência do clima e cosmologia. O modelo também será usado para acelerar a identificação de processos biológicos relacionados ao câncer e outras doenças e sugerir alvos para o desenvolvimento de medicamentos.

Para avançar no projeto, Argonne está liderando uma colaboração internacional que inclui:

- Intel

- HPE

- Departamento de Laboratórios de Energia

- Universidades dos EUA e Internacionais

- Organizações sem fins lucrativos

- parceiros internacionais

Espera-se que o Aurora ofereça mais de dois exaflops de desempenho de computação de precisão dupla quando lançado este ano.

Aplicativos de HPC de benefícios oneAPI

As mais recentes ferramentas oneAPI da Intel fornecem acelerações para aplicativos HPC com descarregamento de GPU OpenMP, estendem o suporte para OpenMP e Fortran e aceleram a IA e o aprendizado profundo por meio de estruturas otimizadas, incluindo TensorFlow e PyTorch, e ferramentas de IA, permitindo maiores melhorias de desempenho.

A programação multiarquitetura é mais fácil para os programadores por meio da implementação SYCL do oneAPI, plug-ins oneAPI para processadores NVIDIA e AMD desenvolvidos pela Codeplay e a ferramenta de compatibilidade Intel DPC++ que migra o código de CUDA para SYCL e C++, onde 90-95 por cento do código normalmente migra automaticamente . O código SYCL resultante mostra desempenho comparável com o mesmo código executado em linguagens de sistemas nativas NVIDIA e AMD. Os dados mostram que o código SYCL para o aplicativo de astrofísica DPEcho em execução na GPU Max Series supera o mesmo código CUDA na NVIDIA H100 em 48%.

Envolva-se com a StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS feed