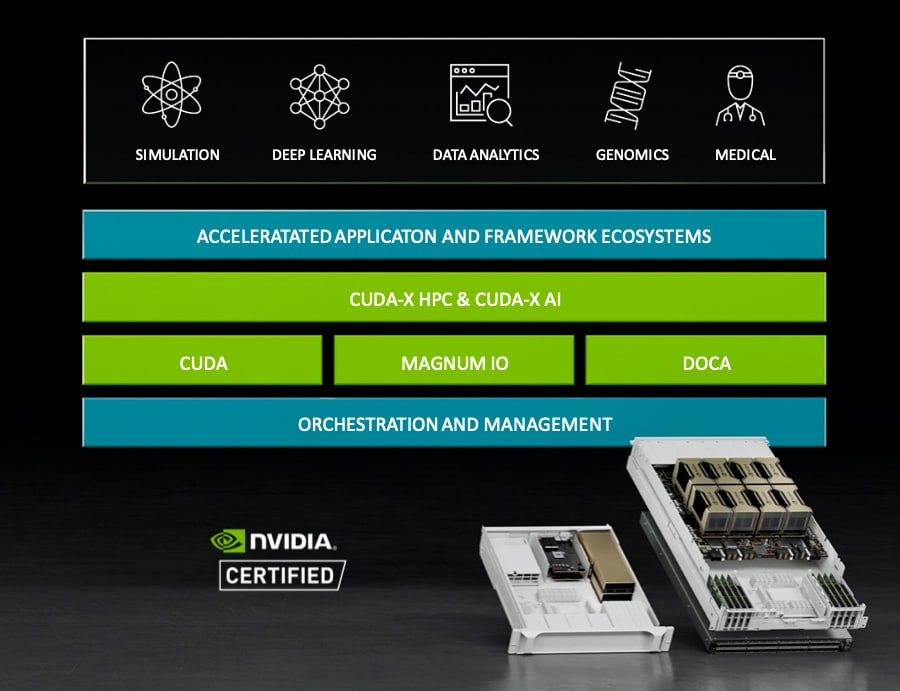

Hoje a NVIDIA anunciou que, com a ajuda de alguns de seus parceiros globais, está lançando novos sistemas NVIDIA HGX A100. Os novos sistemas procuram acelerar AI e HPC adicionando elementos NVIDIA, como NVIDIA A100 80GB PCIe GPU, NVIDIA NDR 400G InfiniBand networking e NVIDIA Magnum IO GPUDirect Storage software. Esses novos sistemas HGX serão lançados no mercado por parceiros como Atos, Dell Technologies, Hewlett Packard Enterprise (HPE), Lenovo, Microsoft Azure e NetApp.

Hoje a NVIDIA anunciou que, com a ajuda de alguns de seus parceiros globais, está lançando novos sistemas NVIDIA HGX A100. Os novos sistemas procuram acelerar AI e HPC adicionando elementos NVIDIA, como NVIDIA A100 80GB PCIe GPU, NVIDIA NDR 400G InfiniBand networking e NVIDIA Magnum IO GPUDirect Storage software. Esses novos sistemas HGX serão lançados no mercado por parceiros como Atos, Dell Technologies, Hewlett Packard Enterprise (HPE), Lenovo, Microsoft Azure e NetApp.

A NVIDIA fabrica GPUs de alta potência há anos. O emergente mercado de IA, particularmente em HPC, levou cada vez mais supercomputadores a alavancar a tecnologia da empresa. A própria NVIDIA fabrica servidores e estações de trabalho HPC nos últimos anos com modelos DGX e HGX. Este último reuniu vários IPs da NVIDIA sob o mesmo teto para melhor desempenho. Os novos sistemas fazem isso mais uma vez com o que a NVIDIA tem de melhor e mais recente a oferecer.

GPU NVIDIA A100 80GB PCIe

A NVIDIA A100 foi anunciada no ano passado na GTC. Esta nova GPU de 7 nm aproveita a arquitetura Ampere da empresa e contém 54 milhões de transistores. A NVIDIA aprimorou rapidamente o produto com a introdução da GPU NVIDIA A100 80GB PCIe, dobrando sua memória. A GPU A100 80GB PCIe é a primeira parte dos novos sistemas HGX A100. Sua grande capacidade de memória e alta largura de banda permitem que mais dados e redes neurais maiores sejam mantidos na memória. Isso significa menos comunicação entre nós, bem como menos consumo de energia. A alta memória também permite maior rendimento, o que pode levar a resultados mais rápidos.

Conforme declarado, a GPU PCIe NVIDIA A100 de 80 GB é alimentada pela arquitetura Ampere da empresa. Essa arquitetura apresenta GPU de várias instâncias, também conhecida como MIG. O MIG pode fornecer aceleração para cargas de trabalho menores, ou seja, inferência de IA. Esse recurso permite que os usuários dimensionem a computação e a memória para baixo com uma QoS garantida.

Os parceiros em torno da GPU NVIDIA A100 80GB PCIe incluem Atos, Cisco, Dell Technologies, Fujitsu, H3C, HPE, Inspur, Lenovo, Penguin Computing, QCT e Supermicro. Existem alguns serviços de nuvem que fornecem a tecnologia, incluindo AWS, Azure e Oracle.

Rede NVIDIA NDR 400G InfiniBand

A segunda peça do quebra-cabeça do sistema NVIDIA HGX A100 são os novos sistemas de switch NVIDIA NDR 400G InfiniBand. Isso pode parecer um pouco óbvio, mas os sistemas HPC precisam de uma taxa de transferência de dados muito alta. A NVIDIA adquiriu a Mellanox há alguns anos por quase US$ 7 bilhões. Desde então, tem lançado constantemente novos produtos, ao mesmo tempo em que substitui lentamente o nome Mellanox por apenas NVIDIA. No ano passado foi lançada a NVIDIA NDR 400G InfiniBand com 3x a densidade de portas e 32x a aceleração AI. Isso está sendo integrado aos novos sistemas HGX por meio do sistema de switch de configuração fixa NVIDIA Quantum-2. Diz-se que este sistema fornece 64 portas de NDR 400 Gb/s InfiniBand por porta ou 128 portas de NDR200.

De acordo com a empresa, os novos switches modulares NVIDIA Quantum-2 fornecem configurações de porta escaláveis de até 2,048 portas de NDR 400Gb/s InfiniBand (ou 4,096 portas de NDR200) com uma taxa de transferência bidirecional total de 1.64 petabits por segundo. Isso representa uma melhoria de mais de 5 vezes em relação à geração anterior, com escalabilidade 6.5 vezes maior. Usando uma topologia de rede DragonFly+, os usuários podem se conectar a mais de um milhão de nós. Por fim, a empresa adicionou em sua tecnologia de redução de dados NVIDIA SHARP In-Network Computing de 3ª geração, que afirma poder obter uma aceleração de IA 32 vezes maior em comparação com as gerações anteriores.

Os switches NVIDIA Quantum-2 são compatíveis com versões anteriores e futuras. Os parceiros de fabricação incluem Atos, DDN, Dell Technologies, Excelero, GIGABYTE, HPE, Lenovo, Penguin, QCT, Supermicro, VAST e WekaIO.

Armazenamento Magnum IO GPUDirect

A peça final do novo quebra-cabeça NVIDIA HDX A100 é o novo Magnum IO GPUDirect Storage. Isso permite acesso direto à memória entre a memória e o armazenamento da GPU. Isso tem vários benefícios, incluindo menor latência de E/S, uso excessivo de largura de banda dos adaptadores de rede e menos impacto na CPU. Vários parceiros têm Magnum IO GPUDirect Storage disponível agora, incluindo DDN, Dell Technologies, Excelero, HPE, IBM Storage, Micron, NetApp, Pavilion, ScaleFlux, VAST e WekaIO.

Envolva-se com a StorageReview

Newsletter | YouTube | LinkedIn | Instagram | Twitter | Facebook | TikTok | RSS feed