O SAS 616iSD 10G faz parte de uma extensa linha de matrizes de armazenamento em nível de bloco oferecidas pela JetStor. O iSCSI 616iSD oferece até 48 TB de armazenamento por meio de 16 baias de 3.5″ em um gabinete de 3U. O JetStor apresenta controladores RAID ativos/ativos redundantes duplos e quatro portas 10GbE, duas por controlador. Cada controlador é alimentado por um processador de armazenamento Intel IOP342 Chevelon dual-core de 64 bits e inclui recursos como ASIC com assistência de paridade, mecanismo com assistência iSCSI e mecanismo de descarregamento TCP (TOE). Caso 48 TB sejam insuficientes, o 616iSD pode ser expandido com quatro prateleiras JBOD (SAS716J) para uma capacidade máxima de 240 TB por array.

Por sua natureza, o JetStor SAS 616iSD 10G foi projetado para ser simples. Ligue-o, dê-lhe acesso à malha Ethernet e pronto. A simplicidade de design do JetStor opera por toda parte, com recursos como um design sem cabos internamente, que embora provavelmente nunca tenha sido visto, oferece uma maior facilidade de serviço caso algo dê errado. A unidade também inclui fontes de alimentação duplas, ventiladores de resfriamento turbo e uma garantia de três anos que cobre todos os componentes com suporte por telefone e e-mail durante a vida útil da unidade.

Especificações Jetstor SAS 616iSD 10G

- Portas de host: Duas, 10 Gigabit Ethernet usando o protocolo iSCSI, SFP+ Host Interfaces por controlador redundante

- Interface de disco: 3Gb/s SAS

- Discos rígidos oferecidos: 300 GB (15k), 450 GB (15k), SAS de 600 GB (15k), 1TB (7.2k), 2TB (7.2k) e 3TB (7.2k)

- Unidades: 16 (3.5”)/Até 160 por meio de duas portas de expansão 3Gb/s SAS

- Modos RAID suportados: RAID 0, 0+1, 1, 3, 5, 6, 10, 30, 50 e RAID 60, Global Hot Spare Disk, Reconstrução automática

- Processador de armazenamento Intel IOP342 Chevelon dual-core de 64 bits em cada controlador

- Cache de 2 GB (padrão) – 4 GB (opcional) / DDR2-800 ECC SDRAM registrado

- Backup de bateria opcional

- Duas portas RJ45/Ethernet Management/Monitor

- Gerenciador SMTP e agente SNMP

- Potência e refrigeração

- Quatro Ventiladores Turbo

- Potência 110 ou 220 VAC, ±20% @ 6 amps / 3 amps de pico

- Dois módulos PS/Fan de 460 W com PFC

- Ambiental

- Umidade Relativa 10% a 85% sem condensação (operacional)

- Temperatura de operação 50°F a 104°F

- Dimensões físicas 3U (L x P x A) 19" de largura, 22" de profundidade, 5.25" de altura

- Peso (sem unidades) 40 lb. / 18 kg.

- Sistemas operacionais suportados: VMWare ESX Server, vSphere, Windows Server 2008, Windows Server 2003, XenServer, Oracle/Solaris, Linux, MAC OS X e outros a serem anunciados

- Garantia: 3 anos de lógica, 3 anos de fontes de alimentação, 5 anos de unidades SAS, 3 ou 5 anos de unidades SATA

Design e Construção

O JetStor SAS 616iSD é um SAN de controlador duplo equipado com 16GbE e 10 baias. A parte frontal do 616iSD apresenta uma interface de usuário básica que exibe informações como o IP de gerenciamento atual sem ter que mergulhar em seu roteador ou DHCP para rastrear qual IP atingir para seu gerenciamento baseado na web. O console frontal inclui um LCD, bem como um punhado de botões para detalhar os menus para obter acesso ao SAN localmente. Para gerenciar os aspectos de hardware do modelo JetStor, basta abrir a face inteira e obter acesso aos dezesseis compartimentos de unidade de 3.5 polegadas abaixo.

Nossa análise JetStor SAS 616iSD 10G incluiu doze Seagate Cheetah 15K.7 ST3600057SS 600 GB discos rígidos, embora o sistema possa ser configurado com uma variedade de unidades de 15K e 7,200 RPM. Cada unidade é montada em seu próprio caddy hot-swap, o que permite uma fácil substituição em caso de falha da unidade. Cada bandeja de unidade também inclui um mecanismo de bloqueio básico para evitar a ejeção acidental da unidade errada em um ambiente de produção.

Para montar facilmente o SAS 616iSD 10G em rack, o JetStor inclui um kit básico de trilhos não deslizantes que é facilmente configurado em poucos minutos. Com o peso da SAN pesando facilmente na categoria de “elevação em equipe”, provavelmente é melhor obter ajuda para levantar a SAN no rack depois que os trilhos estiverem montados. Os trilhos são fáceis de direcionar para os slots de recebimento e permanecem firmemente posicionados em nosso Rack Eaton 42U sem qualquer indicação de flacidez uma vez montado.

A visão da parte traseira do JetStor SAS 616iSD 10G mostra os controladores de disco redundantes e fontes de alimentação. Ambos são rapidamente removidos com parafusos de dedo, usando uma alavanca embutida e um mecanismo de alça para remover e travar firmemente no lugar. As conexões de interface na parte traseira incluem duas conexões SFP+ por controlador (uma porta em cada uma é preenchida com um transceptor de fibra óptica em nossa unidade de análise), uma porta de gerenciamento por controlador, bem como um conector SFF-8088 SAS por controlador para expansão JBOD externa usando o SAS716J. Existem também conectores UPS e RS-232 para permitir a comunicação com outros equipamentos.

No caso improvável de um controlador precisar ser substituído, não levamos mais de 60 segundos para remover e reinserir o conjunto quando instalado em nosso rack. Embora as alavancas de travamento tenham parafusos de orelhas, a JetStor ainda recomenda que os técnicos de campo apertem os parafusos com uma chave de fenda de ponta chata para garantir que tudo esteja instalado com segurança.

A fonte de alimentação foi igualmente simples de remover e reinstalar, embora seu tamanho maior exigisse um esforço mais cuidadoso para limpar cabos e equipamentos ao redor na parte traseira de nosso rack de teste.

As ferramentas de gerenciamento da Web JetStor oferecidas para configurar o SAS 616iSD são fáceis de seguir, mas bastante básicas em termos de design e implementação. Desde o primeiro login, foi muito fácil colocar o sistema operacional, embora a interface parecesse lenta às vezes. Para um SMB ou ambiente corporativo de menor escala, seria fácil gerenciar algumas dessas plataformas juntas, embora um ambiente com mais de um punhado possa causar alguns problemas ao fazer login em cada dispositivo para configurar individualmente.

Histórico de testes e comparáveis

Quando se trata de testar o hardware corporativo, o ambiente é tão importante quanto os processos de teste usados para avaliá-lo. Na StorageReview, oferecemos o mesmo hardware e infraestrutura encontrados em muitos datacenters aos quais os dispositivos que testamos seriam destinados. Isso inclui servidores corporativos, bem como equipamentos de infraestrutura adequados, como rede, espaço em rack, condicionamento/monitoramento de energia e hardware comparável de mesma classe para avaliar adequadamente o desempenho de um dispositivo. Nenhuma de nossas revisões é paga ou controlada pelo fabricante do equipamento que estamos testando.

Visão geral do laboratório de teste StorageReview Enterprise

Plataforma de teste empresarial StorageReview 10GbE:

- 2 x Intel Xeon X5650 (2.66 GHz, 12 MB de cache)

- Windows Server 2008 Standard Edition R2 SP1 64 bits e CentOS 6.2 64 bits

- Chipset Intel 5500+ ICH10R

- Memória – 8GB (2 x 4GB) 1333Mhz DDR3 RDIMMs registrados

Hardware e comutador Ethernet Mellanox SX1036 10/40Gb

- 36 portas 40GbE (até 64 portas 10GbE)

- Cabos divisores QSFP 40GbE a 4x10GbE

- Adaptador Ethernet Mellanox ConnectX-3 EN PCIe 3.0 Twin 10G

Nossa atual infraestrutura de teste de SAN e NAS de 10/40 Gb Ethernet consiste em nossa plataforma de teste Lenovo ThinkServer RD240 equipada com adaptadores Mellanox ConnectX-3 PCIe conectados por meio do switch Mellanox de 36 portas 10/40 GbE. Esse ambiente permite que o dispositivo de armazenamento que estamos testando seja o gargalo de E/S, em vez do próprio equipamento de rede.

Análise de Carga de Trabalho Sintética Corporativa

Para análises de matriz de armazenamento, pré-condicionamos uma carga pesada de 8 threads com uma fila pendente de 8 por thread e, em seguida, testamos em intervalos definidos em vários perfis de profundidade de thread/fila para mostrar o desempenho sob uso leve e pesado. Para testes com 100% de atividade de leitura, o pré-condicionamento está com a mesma carga de trabalho, embora invertida para 100% de gravação.

Testes de pré-condicionamento e estado estacionário primário:

- Rendimento (Agregado de IOPS de Leitura+Gravação)

- Latência média (latência de leitura+gravação calculada em conjunto)

- Latência máxima (latência máxima de leitura ou gravação)

- Desvio padrão de latência (desvio padrão de leitura + gravação calculado em conjunto)

Atualmente, o Enterprise Synthetic Workload Analysis inclui perfis sequenciais e aleatórios comuns, que podem tentar refletir a atividade do mundo real. Eles foram escolhidos para ter alguma semelhança com nossos benchmarks anteriores, bem como um terreno comum para comparação com valores amplamente publicados, como velocidade máxima de leitura e gravação de 4K, bem como 8K 70/30 comumente usado para unidades corporativas. Também incluímos duas cargas de trabalho mistas herdadas, incluindo o servidor de arquivos tradicional e o servidor da Web, oferecendo uma ampla combinação de tamanhos de transferência. Esses dois últimos serão eliminados gradualmente com benchmarks de aplicativos nessas categorias à medida que são introduzidos em nosso site e substituídos por novas cargas de trabalho sintéticas.

- 1024K (Sequencial)

- 100% de leitura ou 100% de gravação

- 8K (Sequencial)

- 100% de leitura ou 100% de gravação

- 4K (aleatório)

- 100% de leitura ou 100% de gravação

- 8K 70/30 (Aleatório)

- 70% de leitura, 30% de gravação

- Servidor de arquivos (aleatório)

- 80% de leitura, 20% de gravação

- 10% 512b, 5% 1k, 5% 2k, 60% 4k, 2% 8k, 4% 16k, 4% 32k, 10% 64k

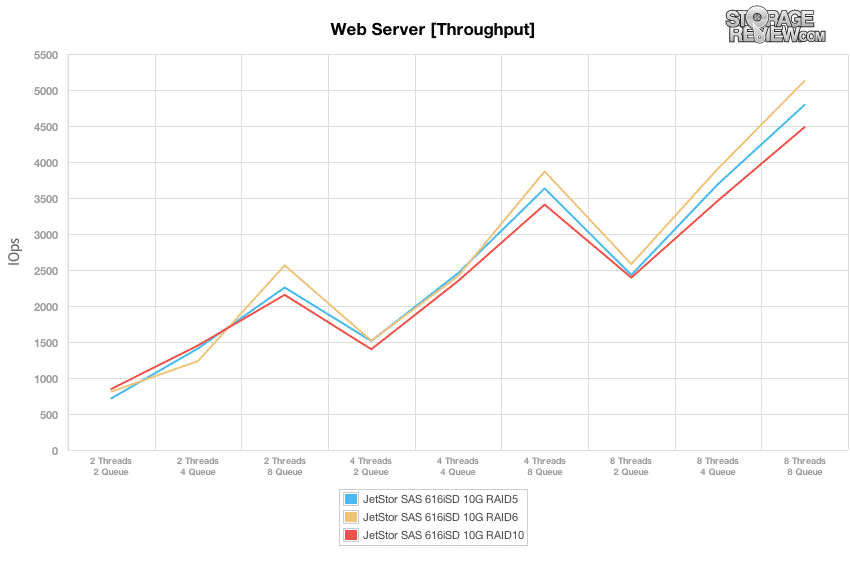

- Servidor Web (Aleatório)

- 100% lido

- 22% 512b, 15% 1k, 8% 2k, 23% 4k, 15% 8k, 2% 16k, 6% 32k, 7% 64k, 1% 128k, 1% 512k

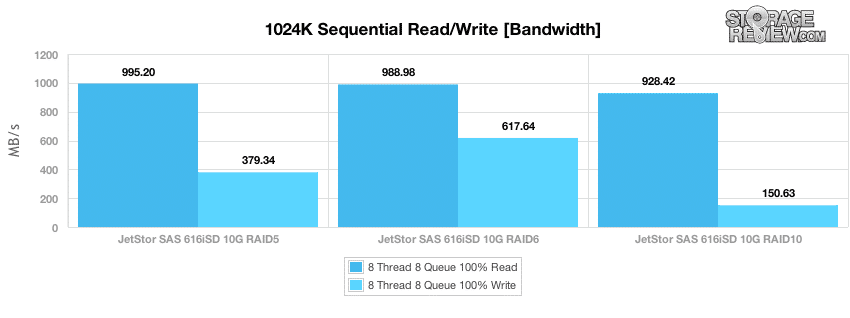

Para iniciar nosso benchmarking, observamos o desempenho sequencial de blocos grandes com uma carga de 8 threads, cada uma com uma fila pendente de 8 E/S, projetada para mostrar a taxa de saturação da SAN na rede, que neste caso é de 10 GbE em duas conexões utilizando MPIO, uma por controlador. Em nossos testes, o desempenho sequencial máximo foi favorecido pelos modos RAID5 e RAID6 em vez do RAID10. As velocidades variaram de 995 MB/s no máximo com RAID5 até 928 MB/s com RAID10. O desempenho de gravação foi mais forte com RAID6, medindo 617 MB/s, com RAID5 chegando com 379 MB/s e RAID10 medindo apenas 150 MB/s.

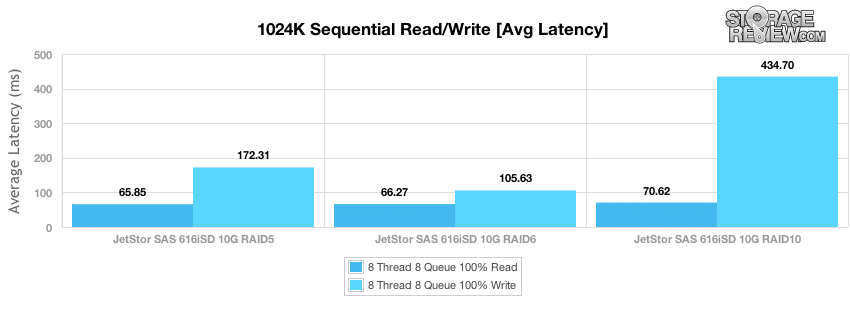

A latência média durante nosso desempenho de transferência sequencial mediu 65ms para RAID5, 66ms para RAID6 e 70ms para RAID10 em nosso teste de leitura de 1024k e 105ms em RAID6, 172ms em RAID5 e 434ms para RAID10 em nosso segmento de gravação.

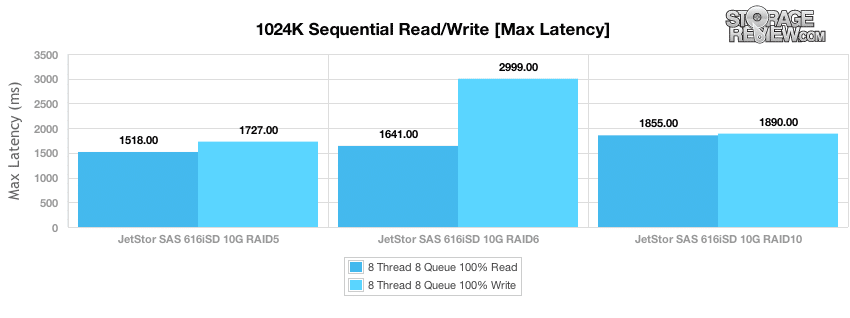

Embora a latência média seja uma métrica importante a ser considerada ao observar o desempenho geral, saber qual pode ser a pior latência é igualmente valioso. No caso do JetStor SAS 616iSD, os tempos de resposta de leitura de pico foram mantidos em 1,518-1,855ms na atividade de leitura e 1,727-2,999ms na atividade de gravação.

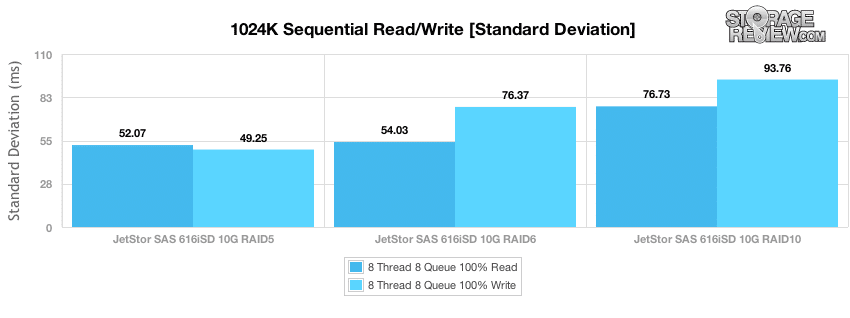

A última métrica que examinamos em nossos testes é o desvio padrão da latência, para ver o quão próximo o agrupamento da latência foi ao longo da duração do teste. O JetStor em RAID5 ofereceu o desempenho mais consistente na atividade de leitura e gravação de blocos grandes, com o RAID6 vindo em segundo lugar, e o RAID10 teve a maior dispersão em ambos os nossos testes de leitura e gravação.

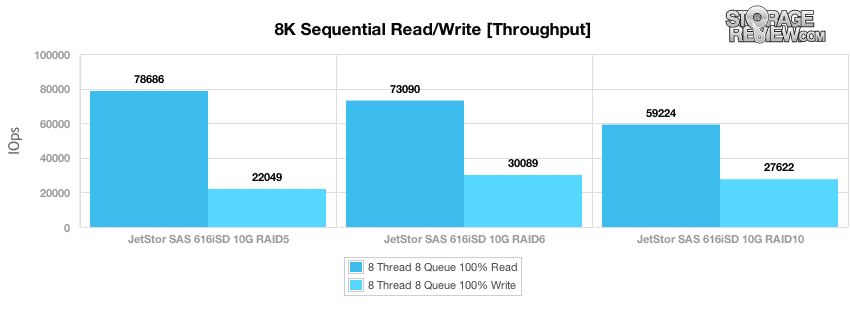

Embora o teste de transferência sequencial de 1024k tenha sido projetado para medir a pós-saturação da largura de banda, nosso próximo teste examina a atividade sequencial de pequenos blocos com uma transferência de 8K para medir a taxa de transferência de E/S no melhor cenário possível. Embora a maioria das atividades que uma SAN possa ver em um ambiente de produção seja aleatória conforme mais sistemas o acessam, o backup noturno ou a atividade em segundo plano durante o tempo ocioso pode se aproximar dessas velocidades. O desempenho máximo de leitura sequencial de 8K que medimos chegou a 78,686 IOPS em uma configuração RAID5, caindo para 73,090 IOPS em RAID6 para 59,224 IOPS em RAID10. O desempenho máximo de gravação sequencial de 8K foi medido em 30,089 IOPS em RAID6, com RAID10 chegando com 27,622 IOPS e RAID5 com 22,049 IOPS.

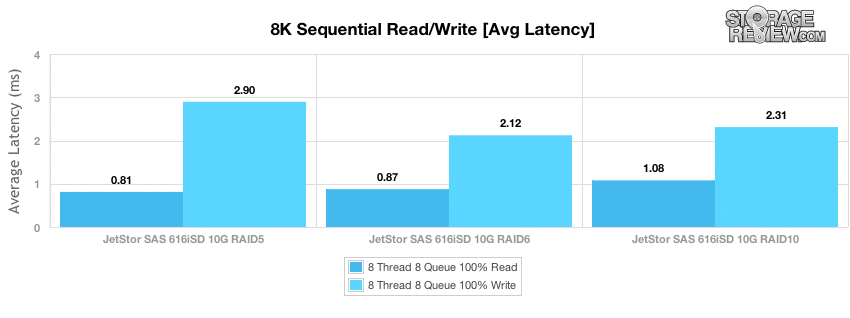

A latência sequencial média de pequenos blocos foi baixa em nosso teste de transferência de 8K, com a leitura de RAID5 chegando mais rapidamente com um tempo de resposta de 0.81ms, RAID6 chegando em seguida com 0.87ms e RAID10 com 1.08ms. As latências de gravação foram um pouco maiores devido aos resultados de transferência de E/S mais lentos, com RAID6 medindo 2.12ms, RAID10 com 2.31ms e RAID5 com 2.9ms.

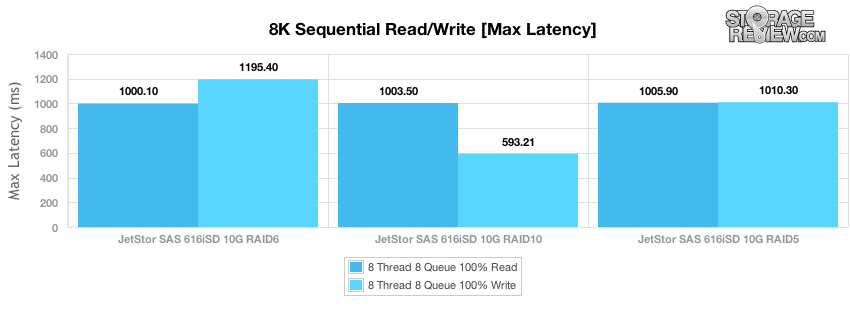

A latência máxima de leitura em nosso teste de transferência sequencial de 8K mediu um pico de cerca de 1,000ms em toda a placa no segmento de leitura de nosso teste, com latência de pico de gravação medindo 593ms em RAID10 até 1,195ms em RAID6.

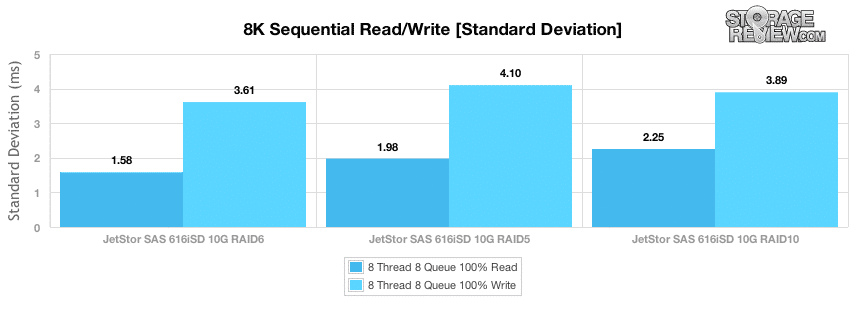

Observando a propagação do desvio padrão da latência, o modo RAID6 manteve o desempenho de leitura sequencial mais consistente, com RAID5 RAID10 sendo um pouco mais inconsistente. O RAID6 também ofereceu o melhor desvio padrão sequencial de 8K em transferências de gravação.

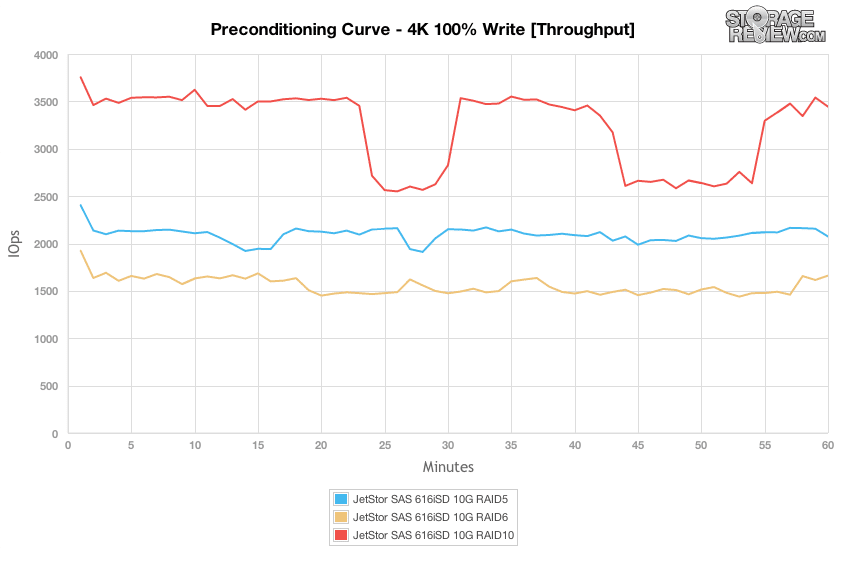

Nosso próximo grupo de testes muda o foco para cargas de trabalho aleatórias, sendo a primeira gravação 100% 4K no segmento de pré-condicionamento. Em termos de como os modos RAID se comportaram, o RAID10 ofereceu o maior rendimento, com RAID5 e RAID6 chegando abaixo dele. O que foi interessante, porém, foram as quedas no desempenho da matriz RAID10, provavelmente causadas pela manutenção em segundo plano, que as configurações RAID5 e RAID6 não tinham.

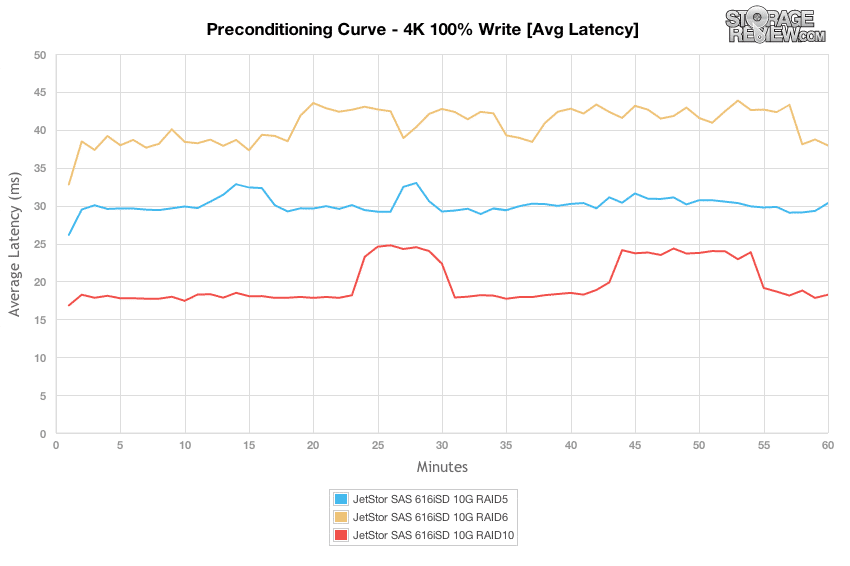

Observando a latência média durante nossa fase de pré-condicionamento, para cada modo de RAID, você pode ver como o cache integrado armazenou em buffer a atividade aleatória de entrada por 1 a 2 minutos, antes de nivelar o desempenho dos próprios discos.

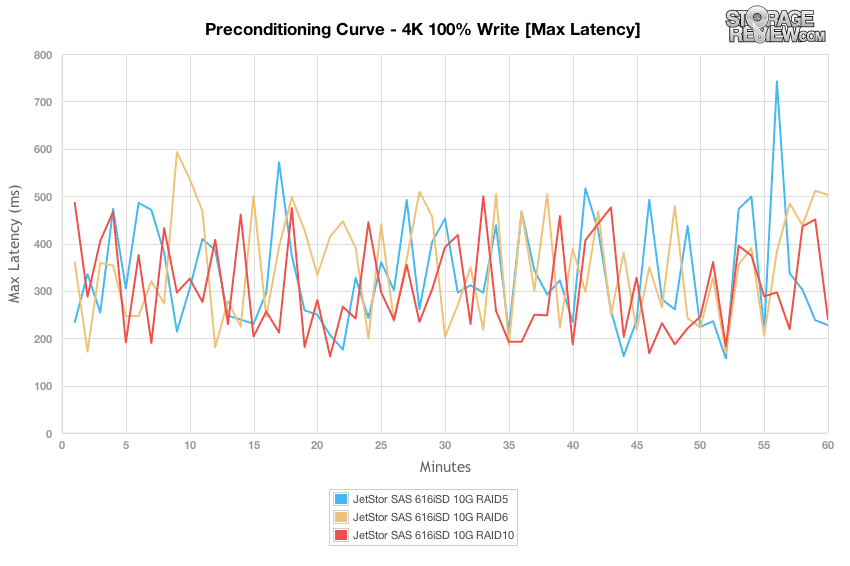

Durante nossa carga de 8 threads, cada uma com 8 I/Os excelentes, a latência de pico flutuou entre 200-500ms para cada modo RAID com 100% de atividade de gravação 4K.

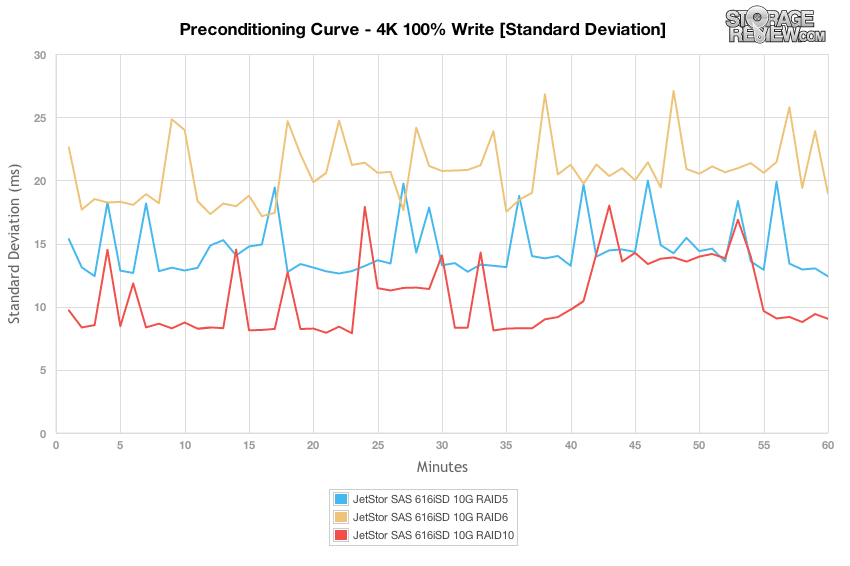

Mudando nosso foco para o desvio padrão da latência, podemos ver que os tempos de resposta foram mais consistentes com a configuração RAID10, seguida por RAID5 e RAID6.

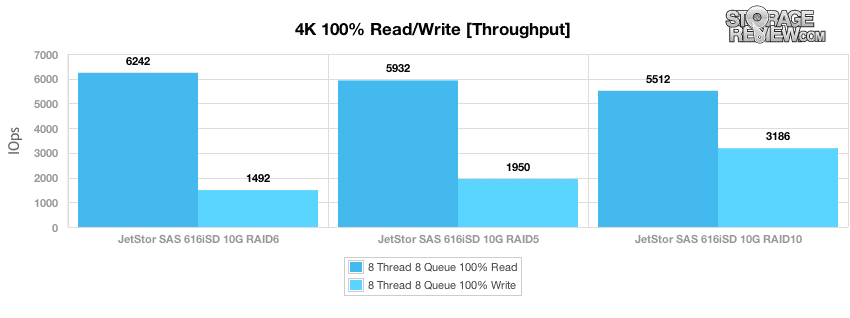

Após a conclusão do processo de pré-condicionamento, coletamos amostras mais longas de desempenho de leitura e gravação aleatória 100% 4K de cada modo RAID. O RAID6 ofereceu as velocidades de leitura mais rápidas de 6,242 IOPS, embora o desempenho de gravação mais lento medisse 1,492 IOPS. O RAID10 ofereceu o melhor desempenho de gravação aleatória medindo 3,186 IOPS, mas teve uma velocidade de leitura aleatória 4K mais lenta de 5,512 IOPS.

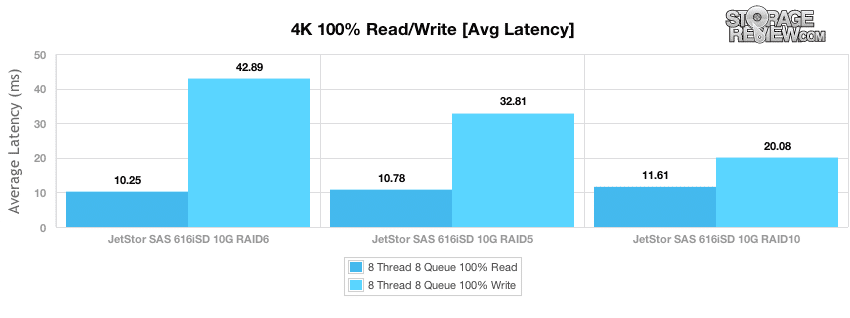

Com uma profundidade de fila efetiva excepcional de 64, medimos a latência de leitura e gravação aleatória de 4K em cada modo RAID. A latência de leitura aleatória de 4K variou de 10.25ms em RAID6 a 11.61ms em RAID10. Latência de gravação escalada de 20.08ms em RAID10 para 42.89ms em RAID6.

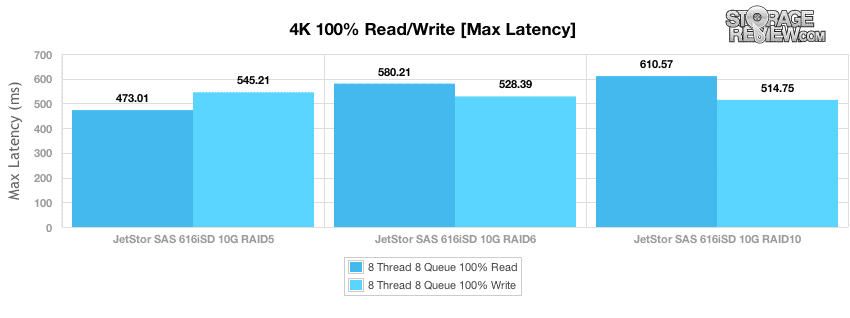

Em nosso período de amostragem mais longo fora da fase de pré-condicionamento, medimos tempos de resposta de pico variando de 473-610ms em transações de leitura e 514-545ms durante a atividade de gravação.

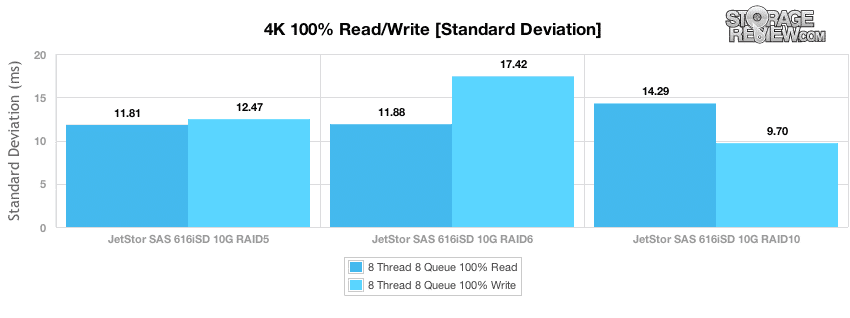

Enquanto a latência de pico mostra os piores tempos de resposta durante o período de amostragem, o desvio padrão mostra a propagação da latência durante todo o período de teste. O RAID5 ofereceu a latência de leitura aleatória de 4K mais consistente, enquanto o RAID10 ofereceu a latência de gravação de 4K mais consistente.

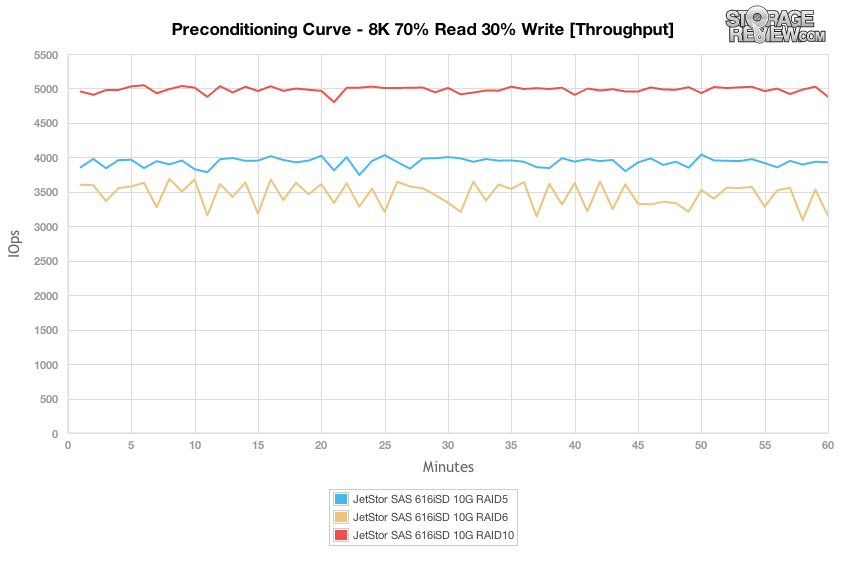

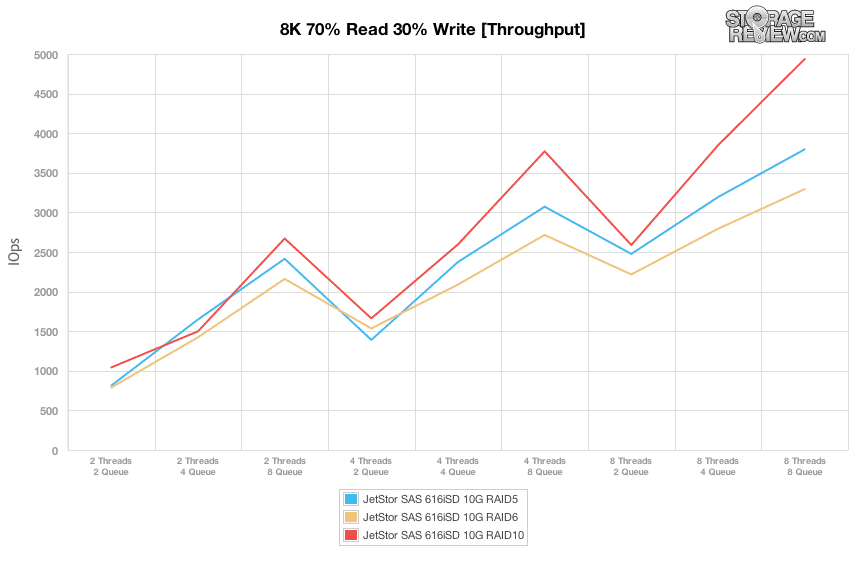

O próximo teste de pré-condicionamento funciona com uma distribuição de carga de trabalho de leitura/gravação mais realista, em comparação com a atividade de gravação de 100% em nossas cargas de trabalho de 1024K, 100% 8K ou 100% 4K. Aqui, temos uma mistura de 70% de leitura e 30% de gravação de transferências aleatórias de 8K. Observando nossa carga de trabalho mista 8K 70/30 sob uma carga pesada de 8 threads e 8 filas por thread, vemos que o RAID10 ofereceu a maior taxa de transferência, seguido pelo RAID5 e depois pelo RAID6. O desempenho foi muito consistente durante o processo de pré-condicionamento, com apenas pequenas falhas no desempenho.

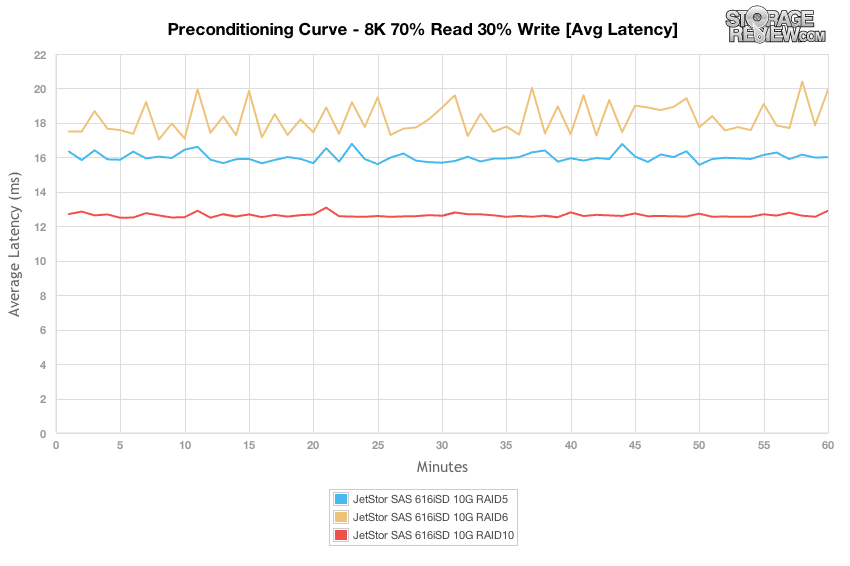

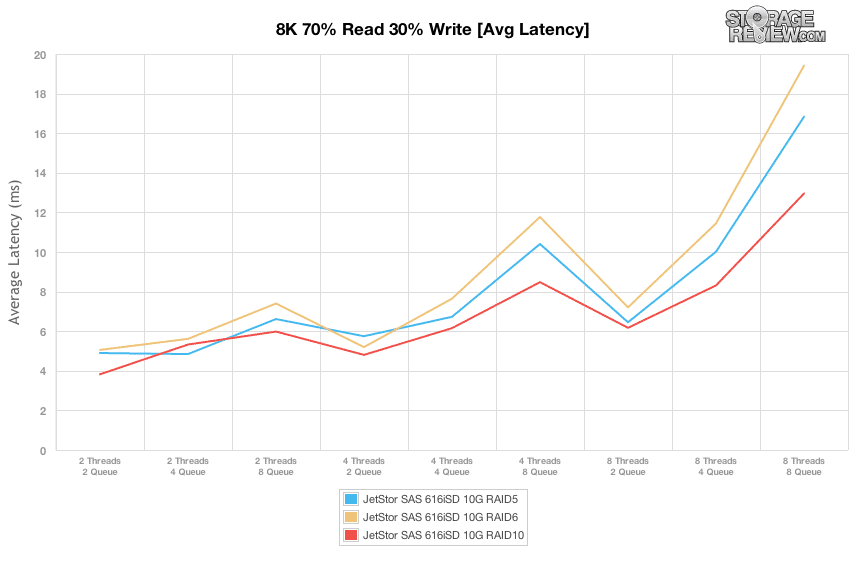

Observando a distribuição da latência média durante nossa carga de trabalho de 8K 70/30, o RAID10 foi o mais plano, medindo 12-13ms durante o teste, seguido pelo RAID6 com cerca de 16-17ms, com o RAID5 medindo 17-20ms.

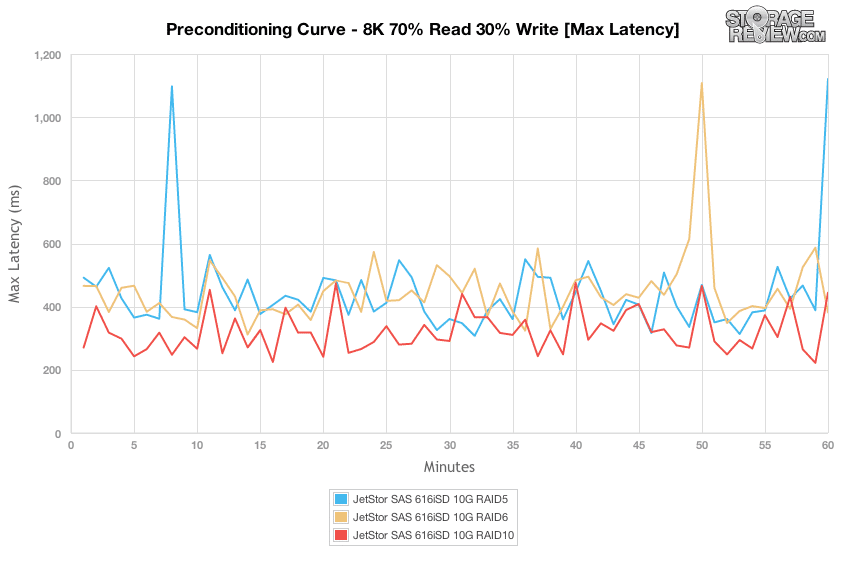

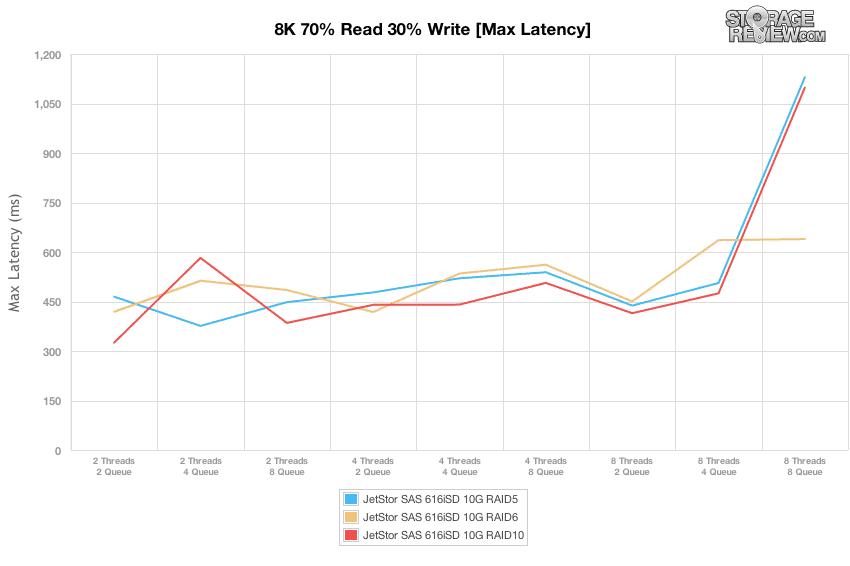

Os tempos de resposta de pico para cada tipo de RAID foram bastante consistentes na faixa de 300-500ms, com alguns blips acima de 1,000ms dos tipos de RAID RAID5 e RAID6.

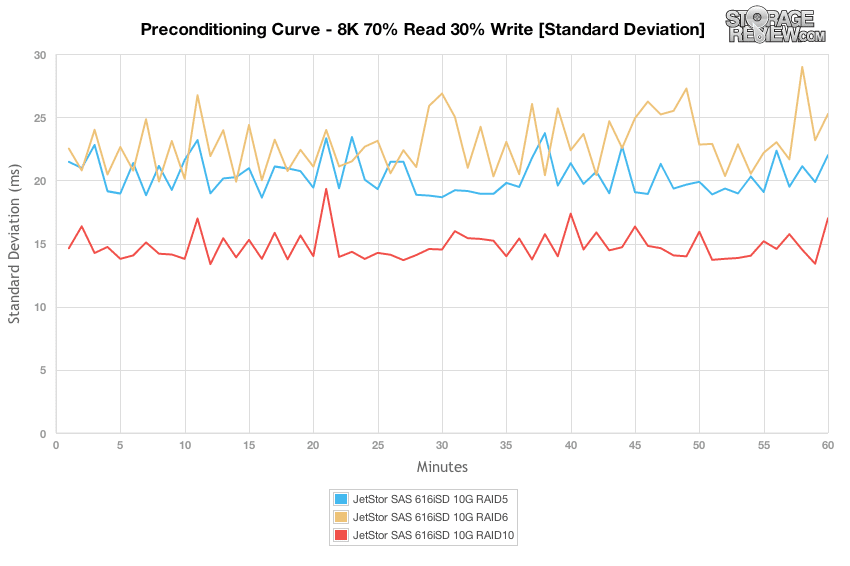

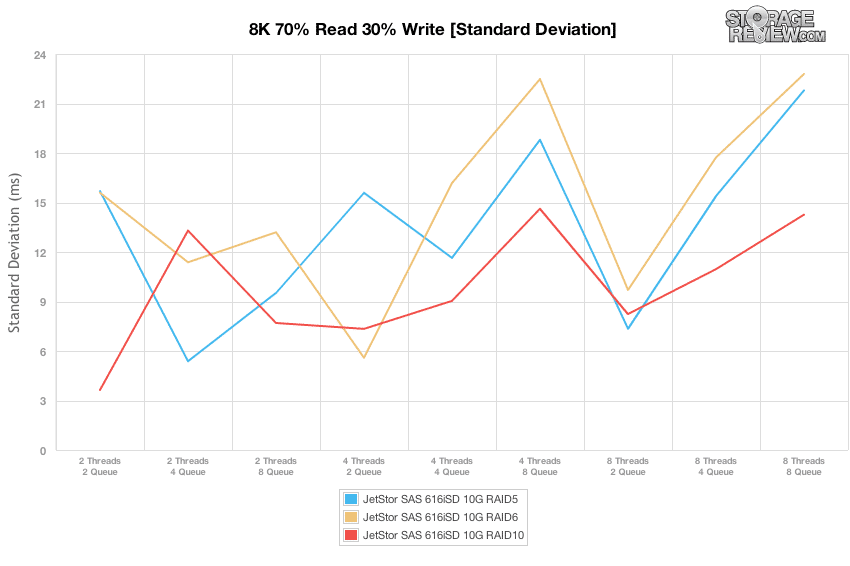

Comparando as diferenças de desvio padrão de latência entre os tipos de RAID, o RAID10 ofereceu a latência mais consistente, seguido pelo RAID5 e depois pelo RAID6.

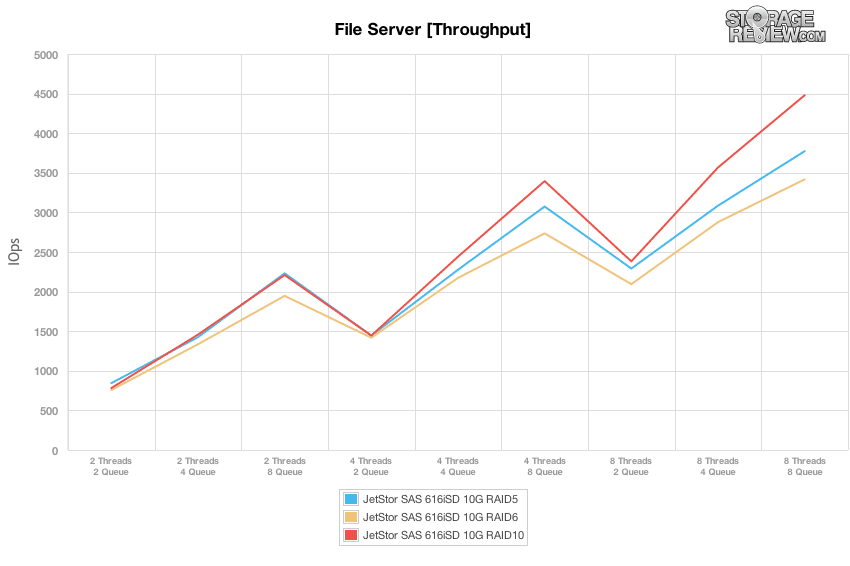

Em comparação com a carga de trabalho fixa de 8 threads, 8 filas máximas que realizamos nos testes 100% 4K, 8K e 1024K, nossos perfis de carga de trabalho mistos dimensionam o desempenho em uma ampla variedade de combinações de thread/fila. Nesses testes, expandimos nossa intensidade de carga de trabalho de 2 threads e 2 filas até 8 threads e 8 filas. Observando as diferenças na taxa de transferência, cada modo de RAID estava sendo executado praticamente em pé de igualdade um com o outro em áreas onde a profundidade efetiva da fila permanecia 16 ou menos. Uma vez acima de 32, visto nas cargas de trabalho 4T/8Q, 8T/4T e 8T/8Q, o modo RAID10 ofereceu o maior desempenho, seguido pelo RAID5 e depois pelo RAID6. Abaixo dessa faixa, cada modo RAID oferece desempenho semelhante.

Embora seja importante conhecer o intervalo de taxa de transferência de pico, saber como ajustar sua carga para corresponder à matriz de armazenamento é ainda mais importante. Velocidades rápidas de E/S combinadas com alta latência significam apenas uma interação lenta do usuário, portanto, saber o nível de desempenho que você pode obter antes que a latência comece a aumentar significativamente é fundamental para a usabilidade. O ponto ideal em nossos testes, que ofereceu o maior throughput, mas também manteve a latência relativamente baixa entre 6-8ms, foi em 8T/2T, onde o desempenho variou entre 2,250 e 2,750 IOPS.

Comparando a profundidade efetiva da fila com a latência de pico do JetStor SAS 616iSD, o SAN foi capaz de conter os tempos de resposta mais altos abaixo de 500ms até a carga de trabalho 8T/8Q. Nesse ponto, a latência de pico dobrou para RAID5 e RAID6.

Comparando o desvio padrão de latência em todos os três tipos de RAID, o RAID10 ofereceu uma pequena vantagem, com o RAID6 geralmente tendo a maior dispersão. O ponto ideal para a latência mais consistente foi a carga 8T/2Q, que foi ideal para todos os tipos de RAID.

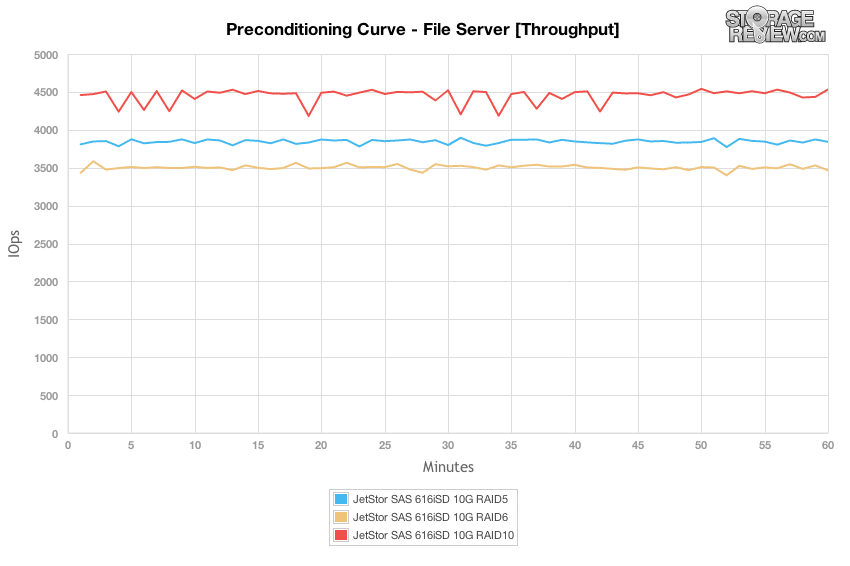

A carga de trabalho do servidor de arquivos representa um espectro de tamanho de transferência maior atingindo cada array específico, portanto, em vez de se contentar com uma carga de trabalho estática de 4k ou 8k, a SAN deve lidar com solicitações que variam de 512b a 64K. Semelhante a outras cargas de trabalho totalmente aleatórias, a configuração RAID10 ofereceu a taxa de transferência mais alta, medindo cerca de 4,500 IOPS durante nosso processo de pré-condicionamento. O RAID5 ficou atrás com uma velocidade de 3,800 IOPS, seguido pelo RAID6 com cerca de 3,500 IOPS. Cada tipo de RAID ofereceu desempenho semelhante do início ao fim, com apenas uma pequena variação.

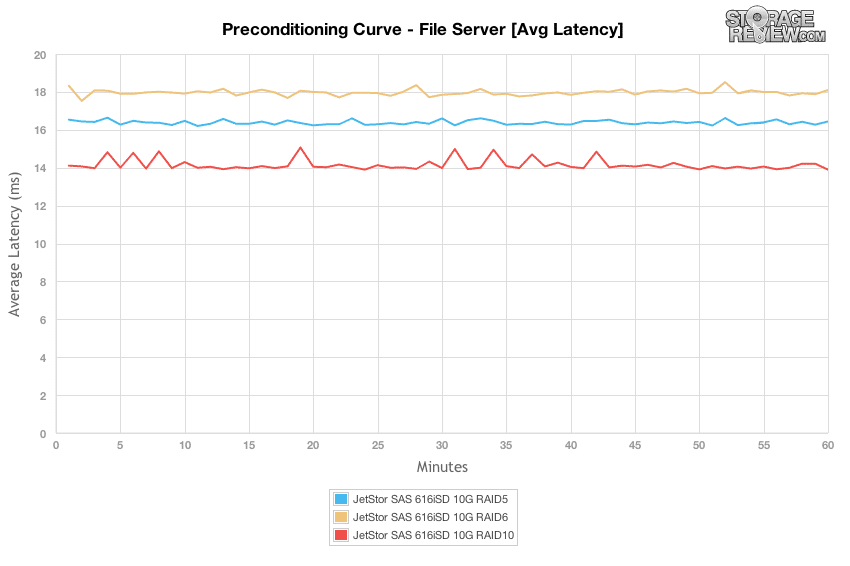

Observando a latência média, cada configuração de RAID permaneceu bastante estável durante o teste de pré-condicionamento, com o modo RAID10 se estabelecendo em 14ms, RAID5 em 16.5ms e RAID6 acima em 18ms.

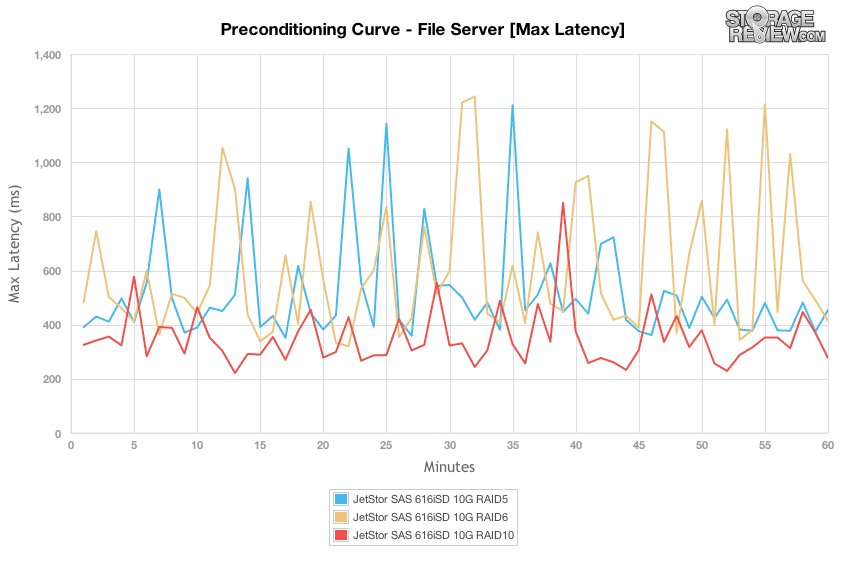

Os tempos de resposta de pico foram mais dispersos, variando de 200ms a 1,200ms durante a fase de pré-condicionamento. A configuração RAID10 permaneceu a mais baixa, com um spread de 250ms para pouco mais de 800ms. RAID5 e RAID6, no entanto, atingiram picos mais altos, variando de 300ms a mais de 1,200ms.

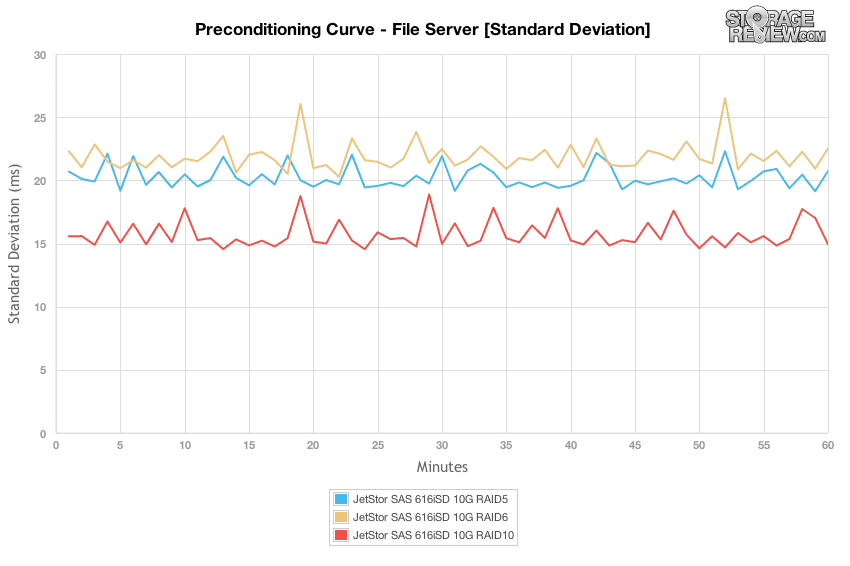

O RAID10 ofereceu o desvio padrão de latência mais consistente, seguido pelo RAID5 e RAID6, que estavam um passo acima dele.

Mudando para nosso gráfico de taxa de transferência do servidor de arquivos em escala, onde aumentamos a carga de 2T/2Q para 8T/8T, observamos uma tendência semelhante em que, em ou abaixo de uma profundidade de fila efetiva de 16, havia muito pouca diferença de desempenho entre cada um dos tipos de RAID . Acima desse nível, o RAID10 ofereceu o desempenho mais alto, seguido pelo RAID5 e depois pelo RAID6.

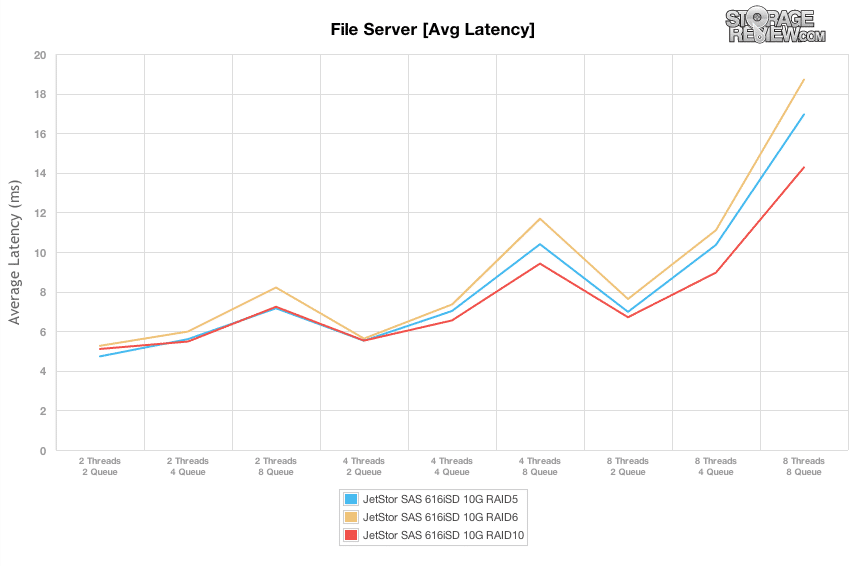

Mudando para a visualização da latência média com a carga de trabalho do servidor de arquivos, os tempos de resposta oscilaram entre 5 e 8 ms, enquanto a profundidade efetiva da fila permaneceu igual ou inferior a 16 e, em seguida, saltou para 14 a 19 ms sob carga de pico. O ponto ideal, semelhante à carga de trabalho 8K 70/30, foi novamente em 8T/2T, onde o JetStor SAS 606iSD foi capaz de oferecer a taxa de transferência mais alta de 2,000 a 2,500 IOPS com uma latência de 7 a 8 ms.

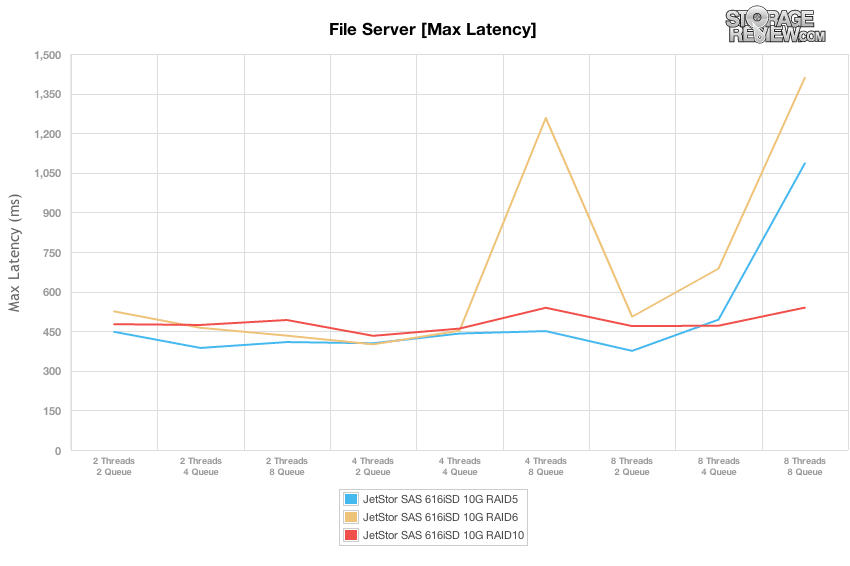

Em nosso teste de servidor de arquivos, a latência máxima permaneceu entre 400-500ms para RAID5 e RAID6 até 8T/4T e 8T/8T, antes que a latência aumentasse substancialmente. Os tempos máximos de resposta do RAID10 permaneceram consistentes durante toda a duração de nossos testes.

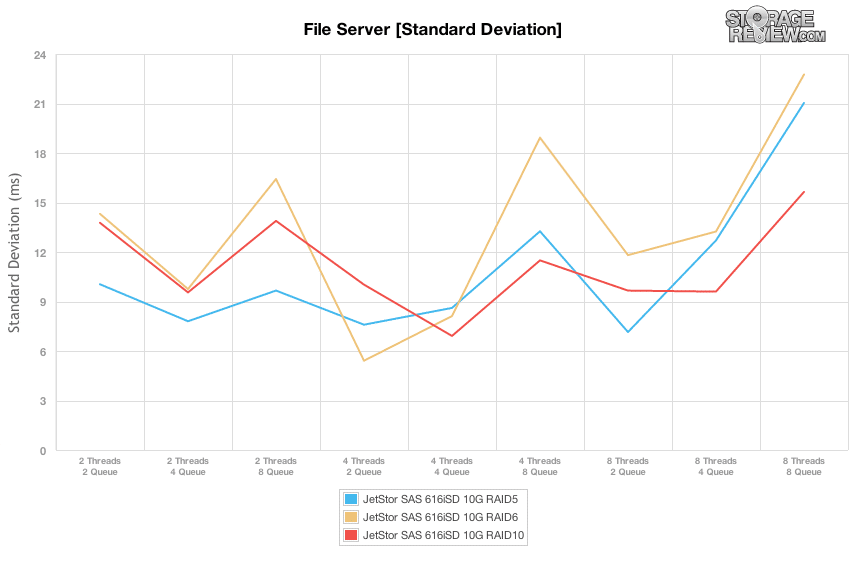

O desvio padrão de todos os tipos de RAID permaneceu consistentemente inconsistente durante o teste de carga variável. Em cargas mais altas, onde as configurações atingiram uma profundidade de fila de 8, a variação aumentou em toda a linha.

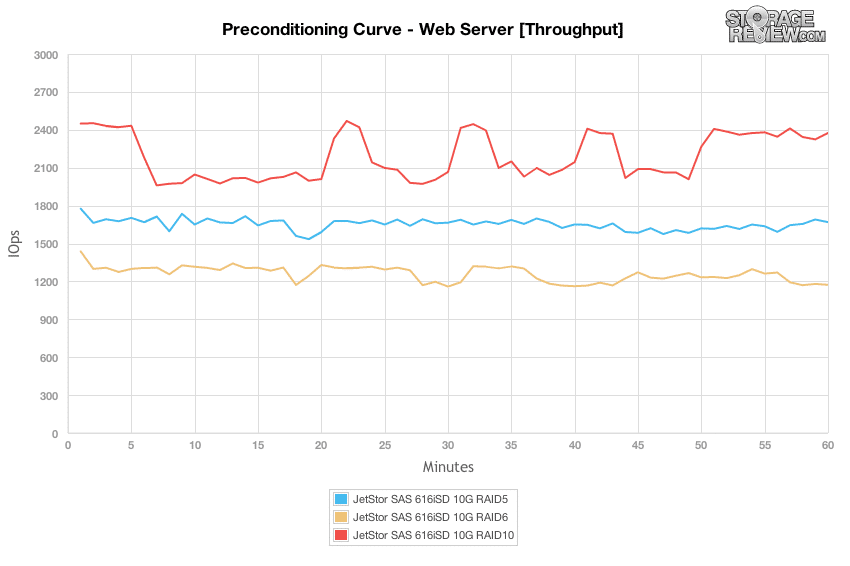

Nossa última carga de trabalho é única na forma como analisamos a fase de pré-condicionamento do teste em comparação com a saída principal. Como uma carga de trabalho projetada com 100% de atividade de leitura, é difícil mostrar o verdadeiro desempenho de leitura de cada dispositivo sem uma etapa de pré-condicionamento adequada. Para manter a carga de trabalho de condicionamento igual à carga de trabalho de teste, invertemos o padrão para 100% de gravação. Por esse motivo, os gráficos de pré-condicionamento são mais lentos que os números finais da carga de trabalho.

Em um cenário de servidor Web com uma condição de gravação de 100%, a configuração RAID10 ofereceu o desempenho mais alto, embora semelhante ao comportamento que observamos no teste aleatório de 4K, caiu ao longo das seções do teste enquanto realizava atividade em segundo plano. Os outros perfis RAID não tiveram o mesmo resultado, embora também tenham sido mais lentos no geral.

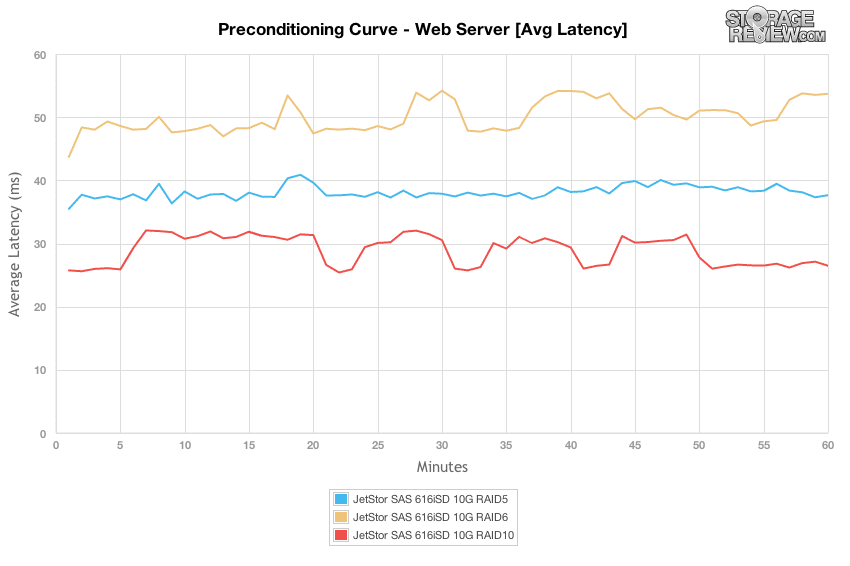

No processo de pré-condicionamento do servidor Web com uma carga de 8T/8Q, houve uma grande variedade de diferenças de desempenho, com o RAID10 oferecendo os tempos de resposta mais rápidos, medindo 26-32ms, o RAID5 medindo cerca de 38-41ms e o RAID6 com 48-54ms.

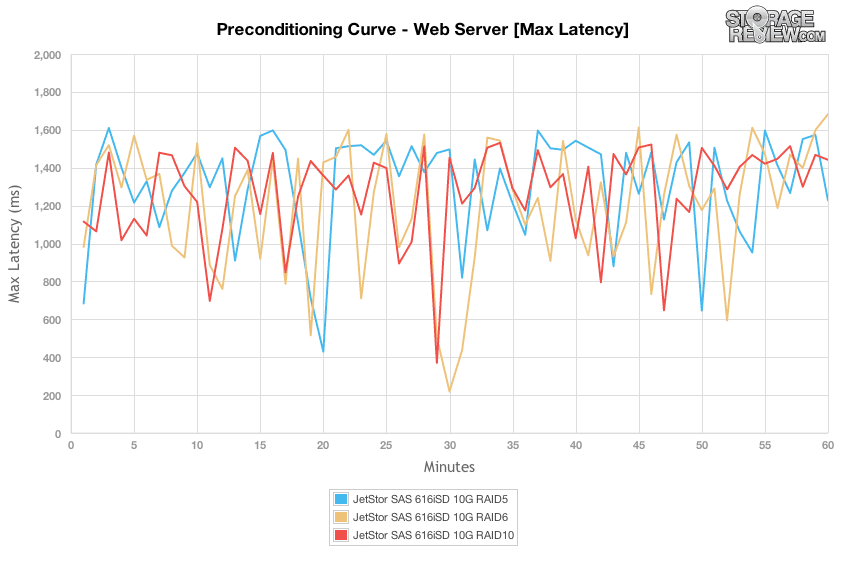

Comparando as diferenças na latência máxima em nossa carga de trabalho de pré-condicionamento do servidor Web, todos os tipos de RAID ofereceram uma faixa semelhante de tempos de resposta de pico medindo 200-1,600 ms no total.

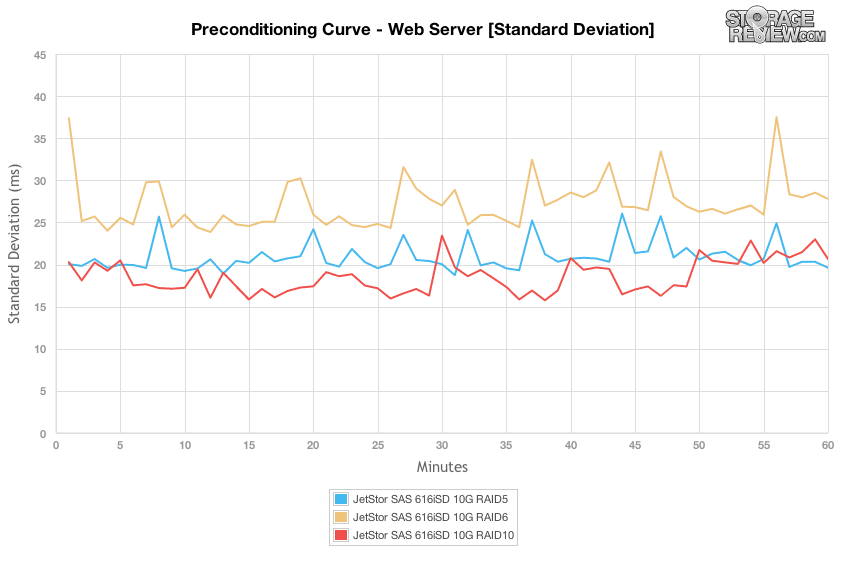

Ao comparar a latência máxima, pode não ter havido muitas diferenças, mas conforme mudamos o foco para o desvio padrão da latência, vemos que o RAID10 ofereceu a distribuição mais estreita na latência, seguido pelo RAID5 e depois pelo RAID6.

Mudando de 100% de atividade de gravação em nossa fase de pré-condicionamento para 100% de atividade de leitura, a diferença entre cada tipo de RAID não é tão perceptível até as profundidades de fila efetivas mais altas. Em seus picos, o modo RAID10 foi capaz de suportar 5,100 IOPS, RAID5 com 4,800 e RAID6 com 4,500.

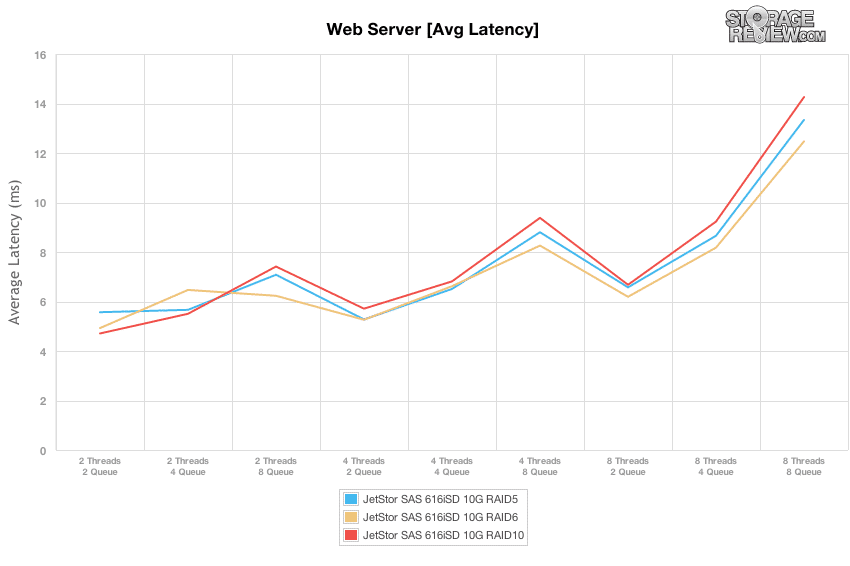

O ponto ideal com 100% de atividade de leitura em nosso perfil de servidor Web ainda era a carga 8T/2T, que oferecia um tempo de resposta de 6.2-6.6ms com uma taxa de transferência de 2,400-2,600 IOPS antes que a latência aumentasse para 13-15ms.

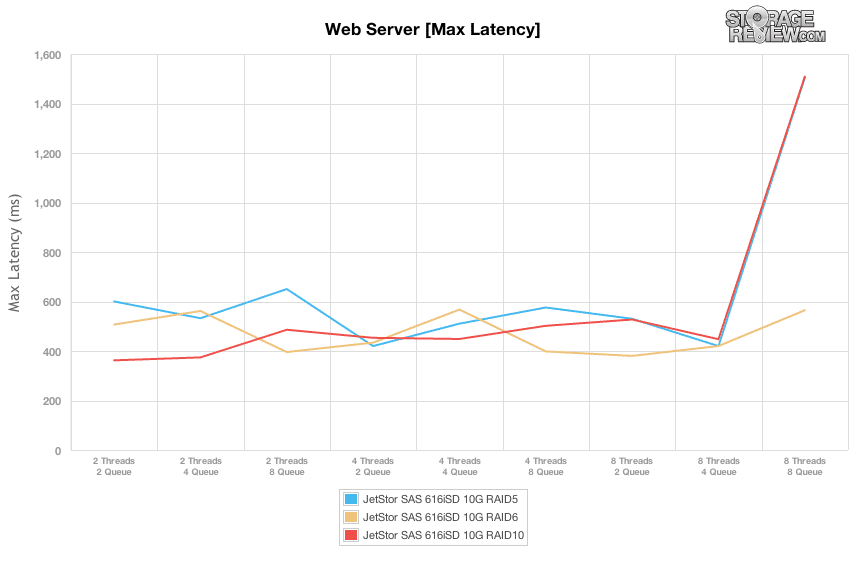

Comparando a latência máxima em nossos testes de carga variados, o JetStor SAS 616iSD manteve uma faixa de 400-600ms até a carga de trabalho 8T/8Q, onde as configurações RAID5 e RAID10 dispararam para 1,500ms.

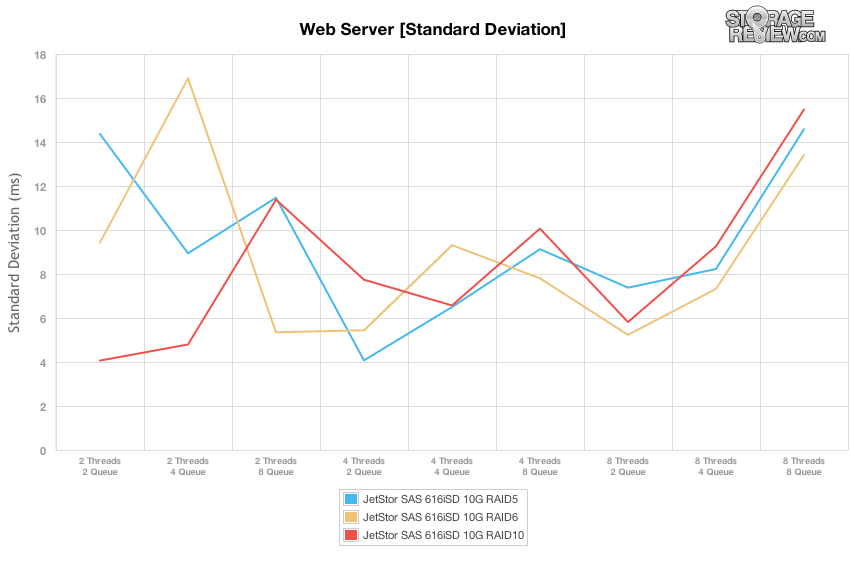

Comparando as diferenças no desvio padrão de latência, cada tipo de RAID no JetStor SAN ofereceu tempos de resposta mais consistentes quando estava sob uma carga moderada, até ser colocado sob nossa carga de pico de 8T/8Q. Na faixa ideal de 8T/2Q, o RAID6 ofereceu a latência mais consistente, seguido pelo RAID10 e RAID5.

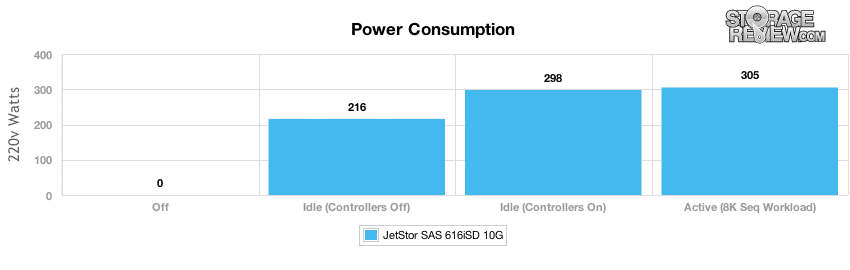

Consumo de energia

Como acontece com qualquer dispositivo localizado em um data center moderno, o consumo de energia e a saída térmica estão sempre em primeiro plano, pois afetam o resultado duas vezes, tanto no uso de energia do próprio dispositivo quanto no resfriamento necessário para compensar o calor que ele cria durante a operação. Com a maioria dos arrays SAN e NAS, o maior componente para o uso geral de energia são as próprias unidades, que se você tiver acesso razoavelmente constante, significa pouco tempo para ficar ocioso e desacelerar. Em nossos testes, medimos a energia em um estado desligado, o sistema ligado, mas os controladores desligados, o sistema ligado e ocioso, bem como o sistema ligado e com uma carga de E/S alta e constante.

Com doze discos rígidos SAS de 600 GB e 15 instalados, a maior parte do uso de energia vem de manter essas unidades ativas. Com os controladores desligados, o array precisava de 216 watts em modo inativo, que aumentou para 298 watts com os controladores ligados. Mesmo com uma carga ativa, o consumo de energia aumentou apenas mais 7 watts para 305 W com uma carga de trabalho sequencial de 8K. Com fontes de alimentação duplas de 460 W, descobrimos que o JetStor SAN estava modestamente superprovisionado em termos de suas necessidades de energia, já que permaneceu em 66% de utilização com discos rígidos de 15,000 RPM instalados. Mesmo com quatro baias não utilizadas, ele ainda tinha muito espaço sobrando, mesmo que uma fonte de alimentação falhasse e fosse removida da equação.

Conclusão

O Jetstor SAS 616iSD 10G se encaixa em uma categoria de array de armazenamento um tanto amorfa, pois pode ser usado sozinho com unidades de desempenho ou de grande capacidade para atender às necessidades de virtualização ou armazenamento geral de uma SMB, ou emparelhado com prateleiras adicionais para solucionar problemas de armazenamento de grandes empresas. A JetStor projetou bem o 616iSD, tudo por dentro e por fora foi bem pensado e a unidade se presta bem para facilitar o serviço de campo. Itens como um design interno sem cabos ou trocas de componentes sem ferramentas significam que os técnicos precisam fazer muito pouco trabalho para manter o SAS 616-SD funcionando em um ambiente de produção. A configuração também é fácil, é praticamente plug and play, pelo menos dentro do significado corporativo de tais coisas.

Em termos de desempenho, testamos o array em configurações comuns de RAID5, RAID6 e RAID10. Observar todos os três é certamente relevante, pois nossos testes observaram uma variabilidade significativa em cada modo. O RAID10 mostrou consistentemente o maior desempenho, seguido pelo RAID5 e depois pelo RAID6 em termos de desempenho bruto e menor latência. Como uma empresa está pensando em implantar este ou qualquer outro array, entender o ponto ideal para o desempenho é especialmente crucial para o sucesso da implantação de armazenamento. Nesse caso, vimos a melhor meta de desempenho em 8 threads, 2 filas onde o JetStor SAS 606iSD foi capaz de oferecer alto rendimento, bem como baixa latência na maioria das cargas de trabalho e em todos os tipos de RAID. O desempenho poderia continuar a escalar além desse ponto, embora a latência aumentasse substancialmente. No lado da energia, descobrimos que nossa configuração 12k SAS de 15 unidades consome 305 watts sob carga, o que é bem menos de 460 watts que cada fonte de alimentação foi projetada para suportar. Isso dá ao sistema bastante espaço aéreo, mesmo que seja necessário usar uma única fonte de alimentação no caso de falha de um componente.

Onde o JetStor enfrenta alguns problemas é quando eles tentam se mover mais para clientes maiores. Nesses casos, a camada de gerenciamento se torna muito importante e isso é algo que o JetStor simplesmente não possui com muita profundidade. Ao comparar com EMC ou NetApp, onde você pode gerenciar plataformas de computação e armazenamento em larga escala por meio de uma única janela de gerenciamento, o JetStor SAN precisa ser configurado por conta própria. Não é exatamente um problema quando se trabalha com poucos sistemas, é mais uma questão de entender qual segmento de mercado essa caixa atende. Para crédito da JetStor, eles não estão tentando substituir grandes matrizes de armazenamento corporativo com o SAS 616iSD; eles são apontados solidamente para o mercado intermediário, onde esse design faz muito sentido.

Vantagens

- Belo design de gabinete/componente

- Design muito robusto de fácil manutenção

- Oferece desempenho forte e consistente em uma ampla gama de cargas de trabalho

Desvantagens

- Falta software de gerenciamento de dados corporativos em larga escala

ponto de partida

JetStor não é exatamente um nome familiar quando se trata de armazenamento, embora talvez devesse ser com quase 20 anos no negócio e um conjunto robusto de ofertas. Especificamente para esta análise, o JetStor SAS 616iSD 10G faz tudo o que é solicitado e tem flexibilidade suficiente para ser configurado com discos rígidos de 10 GbE e 15K para necessidades de desempenho ou discos rígidos de 3.5 ″ de alta capacidade para armazenamento em massa. A matriz é simples de implantar e bem projetada, prestando-se bem ao armazenamento de aplicativos e virtualização para SMBs e uso em filiais/escritórios remotos.

Página do produto JetStor SAS 616iSD 10G