Dell Technologies har introducerat Dell Validated Designs for Analytics – Data Lakehouse som gör det möjligt för företag att kombinera både datasjöar och datalager vilket resulterar i datakvalitet, prestanda, säkerhet och styrning för alla datatyper med självbetjäning på begäran.

Dell Technologies har introducerat Dell Validated Designs for Analytics – Data Lakehouse som gör det möjligt för företag att kombinera både datasjöar och datalager vilket resulterar i datakvalitet, prestanda, säkerhet och styrning för alla datatyper med självbetjäning på begäran.

Data Lakehouse

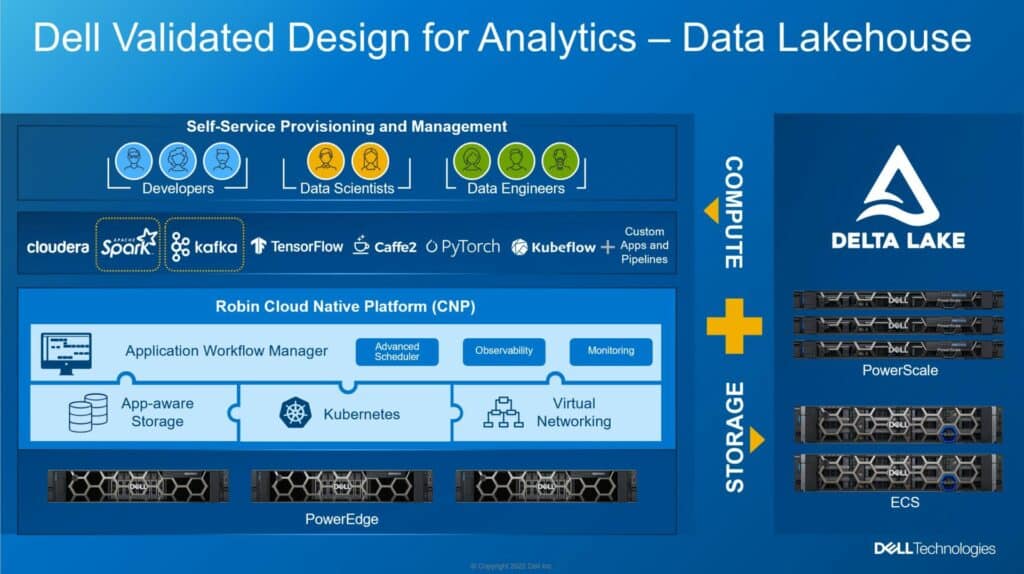

Dell Data Lakehouse möjliggör utvecklande datahantering från siloformade, stela, kostsamma och långsamma till enhetliga system som möjliggör business intelligence (BI), analys, realtidsdataapplikationer, datavetenskap och maskininlärning (ML). Den Data Lakehouse-validerade lösningen omfattar redskap över hela Dell-portföljen inklusive PowerEdge, PowerScale, ECS Object Storage och PowerSwitch.

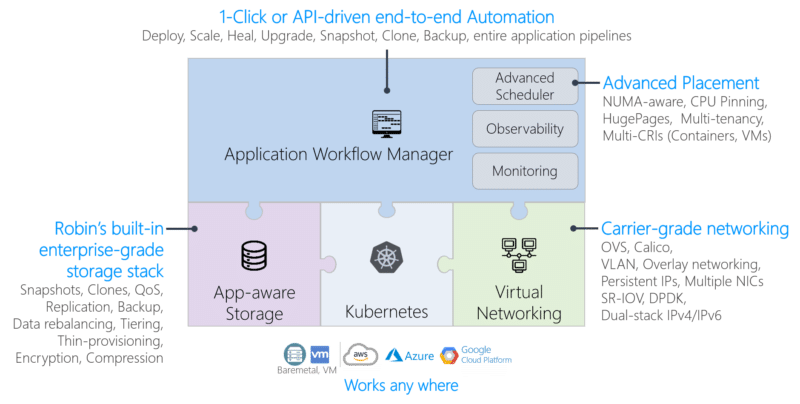

Det är dock inte all hårdvara, infrastrukturen drivs av Apache Spark och Kafka med Delta Lake-teknologier och Robin Cloud-Native Platform (CNP). När allt är samlat är den här lösningen designad för att utnyttja mer data för att omvandla insikter mellan organisationer.

Enligt en blogg av Chhandomay Mandal, Dells direktör, ISG Solution Marketing, "Traditionella datahanteringssystem, som datalager, har använts i årtionden för att lagra strukturerad data och göra den tillgänglig för analys. Datalager är dock inte inrättade för att hantera det ökande utbudet av data Dell har tagit fram en design av referensarkitektur för en kombinerad datasjö/datalager med programvara från tredje part och sin egen server-, lagrings- och nätverkshårdvara och programvara – text, bilder, video, Internet of things (IoT) – och de kan inte heller stödja algoritmer för artificiell intelligens (AI) och maskininlärning (ML) som kräver direkt tillgång till data."

Datasjöar lovade att hjälpa till att lösa dessa problem genom att göra det möjligt för företag att fånga strukturerad, ostrukturerad och semistrukturerad data mer flexibelt och kostnadseffektivt än traditionella datalager. Organisationer använder en datasjö tillsammans med ett datalager genom att lagra data i sjön och sedan kopiera det till lagret, vilket gör det mer tillgängligt och lägger till komplexitet och kostnad för analyslandskapet.

När organisationer har ett bättre grepp om detta enorma dataavtryck, stöder Data Lakehouse alla möjliga användningsfall. Business intelligence (BI), analys, realtidsdataapplikationer, datavetenskap och ML är huvudkandidaterna. Poängen som Dell gör mer eller mindre är att när du väl får grepp om spridda data är det mycket lättare att få affärsfördelar.

Tekniska specifikationer för Dell Data Lakehouse

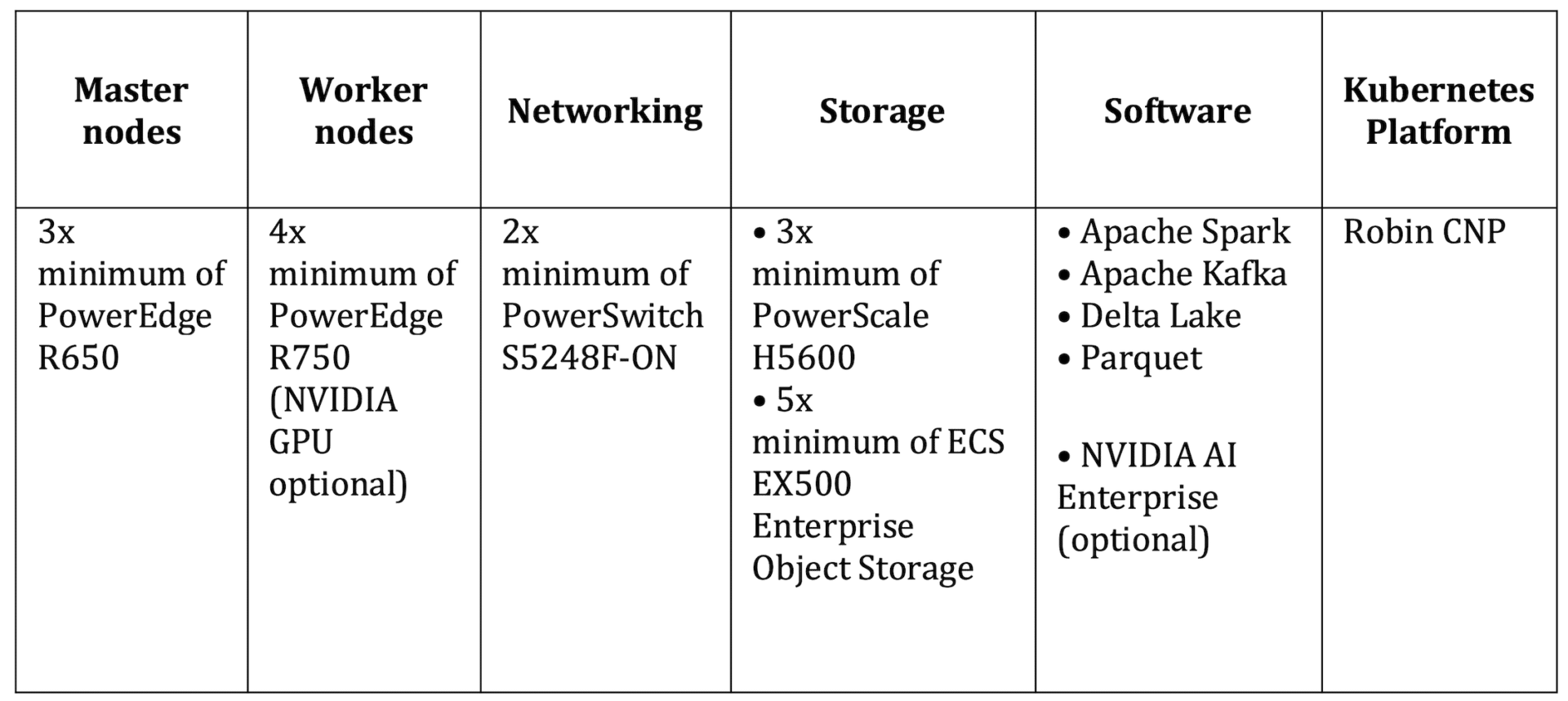

Dell Data Lakehouse drar ihop en hel del mjukvara, men i slutändan är det en hårdvarubaserad konvergerad infrastruktur under. Dell har samlat några av sina bästa hårdvaruerbjudanden i hela portföljen för att sätta ihop denna design.

Tabellen nedan visar viktiga komponenter i systemet, inklusive arbetarnoder som kan stödja GPU:er. Många organisationer kommer att vilja gå den vägen eftersom så mycket av analysen som ska göras på dessa data kan dra nytta av den ökade beräkningskraften som GPU:er kan ge.

Dell Validated Designs for Analytics – Data Lakehouse är tillgänglig nu.

Data Lakehouse-flyer från Dell (PDF)

Engagera dig med StorageReview

Nyhetsbrev | Youtube | Podcast iTunes/Spotify | Instagram | Twitter | Facebook | TikTok | Rssflöde