Intel Habana Gaudi2 djupinlärningsaccelerator och 4:e generationens Intel Xeon Scalable-processorer har visat imponerande resultat i MLPerf Training 3.0 benchmark, enligt ett pressmeddelande från företaget. Riktmärket, publicerat av MLCommons, är en allmänt erkänd industristandard för AI-prestanda.

Intel Habana Gaudi2 djupinlärningsaccelerator och 4:e generationens Intel Xeon Scalable-processorer har visat imponerande resultat i MLPerf Training 3.0 benchmark, enligt ett pressmeddelande från företaget. Riktmärket, publicerat av MLCommons, är en allmänt erkänd industristandard för AI-prestanda.

Resultaten utmanar den rådande branschberättelsen att generativ AI och stora språkmodeller (LLM) bara kan köras på NVIDIA GPU:er. Intels portfölj av AI-lösningar erbjuder konkurrenskraftiga alternativ för kunder som vill gå bort från slutna ekosystem som begränsar effektivitet och skalbarhet.

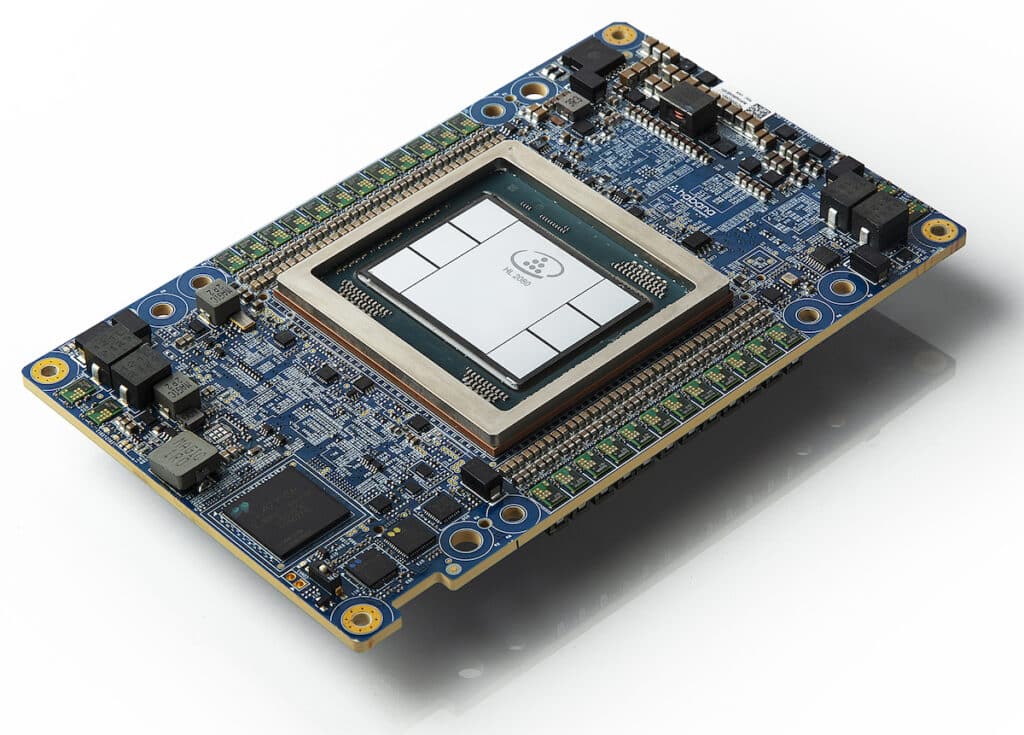

Ett foto visar Habana Gaudi2 Mezzanine Card. Den 10 maj 2022 lanserade Habana Labs, Intels datacenterteam fokuserat på AI djupinlärningsprocessorteknologier, sin andra generationens djupinlärningsprocessorer för träning och slutledning: Habana Gaudi2 och Habana Greco. (Kredit: Intel Corporation)

Vad är MLPerf?

Smakämnen MLPerf Training 3.0 benchmark suite mäter den hastighet med vilken olika system kan träna modeller för att möta ett specificerat kvalitetsmått. Riktmärkena täcker olika områden, inklusive vision, språk och handel, och använder olika datamängder och kvalitetsmål.

Benchmark detaljer

| Area | riktmärke | dataset | Kvalitetsmål | Referens implementeringsmodell |

|---|---|---|---|---|

| Vision | Bildklassificering | IMAGEnet | 75.90 % klassificering | ResNet-50 v1.5 |

| Vision | Bildsegmentering (medicinsk) | KitTS19 | 0.908 medelvärde för DICE | 3D U-Net |

| Vision | Objektdetektering (lätt vikt) | Öppna bilder | 34.0 % mAP | RetinaNet |

| Vision | Objektdetektering (tung vikt) | Kokos | 0.377 Box min AP och 0.339 Mask min AP | Mask R-CNN |

| Språk | Taligenkänning | LibriSpeech | 0.058 Word Error Rate | RNN-T |

| Språk | NLP | Wikipedia 2020/01/01 | 0.72 Mask-LM-noggrannhet | BERT-stor |

| Språk | LLM | C4 | 2.69 log förvirring | GPT3 |

| Commerce | Rekommendation | Criteo 4TB multi-hot | 0.8032 AUC | DLRM-dcnv2 |

Inom synfältet inkluderar riktmärkena bildklassificering med hjälp av ImageNet-datauppsättningen med ett kvalitetsmål på 75.90 % klassificeringsnoggrannhet. Referensmodellen för denna uppgift är ResNet-50 v1.5. Andra synriktmärken inkluderar bildsegmentering med hjälp av den medicinska datasetet KiTS19 och objektdetektering med hjälp av datauppsättningarna Open Images och COCO.

För språkuppgifter inkluderar riktmärkena taligenkänning med hjälp av LibriSpeech-datauppsättningen med ett kvalitetsmål på en 0.058 ordfelfrekvens. Referensmodellen för denna uppgift är RNN-T. Andra språkriktmärken inkluderar naturlig språkbehandling (NLP) med hjälp av Wikipedia 2020/01/01-datauppsättningen och utbildning i stora språkmodeller (LLM) med C4-datauppsättningen.

Inom handelsområdet är riktmärket en rekommendationsuppgift som använder Criteo 4TB multi-hot dataset med ett kvalitetsmål på 0.8032 AUC. Referensmodellen för denna uppgift är DLRM-dcnv2.

Mätmått

Benchmarksviten mäter tiden för att träna en modell på en specifik datauppsättning för att nå ett specificerat kvalitetsmål. På grund av den inneboende variationen i träningstider för maskininlärning erhålls de slutliga resultaten genom att köra benchmarket flera gånger, förkasta de högsta och lägsta resultaten och sedan beräkna ett genomsnitt av de återstående resultaten. Trots detta finns det fortfarande en viss varians i resultaten, med riktmärkesresultat för bildbehandling som har ungefär +/- 2.5 % varians och andra riktmärken har cirka +/- 5 % varians.

Benchmark-divisioner

MLPerf uppmuntrar innovation inom mjukvara och hårdvara genom att tillåta deltagarna att återimplementera referensimplementeringarna. Det finns två divisioner i MLPerf: de stängda och öppna divisionerna. Den stängda divisionen är utformad för att direkt jämföra hårdvaruplattformar eller mjukvaruramverk och kräver att man använder samma modell och optimerare som referensimplementeringen. Å andra sidan uppmuntrar Open-divisionen utvecklingen av snabbare modeller och optimerare och tillåter vilken maskininlärning som helst för att uppnå målkvaliteten.

Systemtillgänglighet

MLPerf kategoriserar benchmarkresultat baserat på systemtillgänglighet. System som kategoriseras som "Tillgängliga" består endast av komponenter som kan köpas eller hyras i molnet. "Preview"-system förväntas vara tillgängliga i nästa inlämningsrunda. Slutligen innehåller system som kategoriseras som "forskning, utveckling eller internt (RDI)" hårdvara eller mjukvara som är experimentell, under utveckling eller för internt bruk.

Intel Habana Guadi2 dyker upp

Speciellt Gaudi2 djupinlärningsacceleratorn visade starkt prestanda på den stora språkmodellen, GPT-3, vilket gör den till en av endast två halvledarlösningar som skickar in prestandaresultat för LLM-träning av GPT-3. Gaudi2 erbjuder också betydande kostnadsfördelar i server- och systemkostnader, vilket gör den till ett övertygande pris/prestandaalternativ till NVIDIAs H100.

Den fjärde generationens Xeon-processorer med Intel AI-motorer visade att kunderna kunde bygga ett universellt AI-system för dataförbearbetning, modellträning och implementering, vilket ger AI-prestanda, effektivitet, noggrannhet och skalbarhet.

Gaudi2 levererade imponerande tid-till-träning på GPT-3, och uppnådde 311 minuter på 384 acceleratorer och nästan linjär 95% skalning från 256 till 384 acceleratorer på GPT-3-modellen. Den visade också utmärkta träningsresultat i datorseende och naturliga språkbehandlingsmodeller. De Gaudi2 resultat skickades "out of the box", vilket innebär att kunder kan förvänta sig jämförbara prestandaresultat när de implementerar Gaudi2 på plats eller i molnet.

4:e generationens Xeon-processorer, som den enda CPU-inlämningen bland många alternativa lösningar, bevisade att Intel Xeon-processorer förser företag med out-of-the-box-kapacitet att distribuera AI på allmänna system, vilket undviker kostnaden och komplexiteten för att introducera dedikerad AI system.

Habana Gaudi2 8-nodskluster

I uppgiften Natural Language Processing (NLP) med hjälp av Wikipedia-datauppsättningen och BERT-stormodellen uppnådde Gaudi2 en träningstid på 2.103 minuter med 64 acceleratorer.

I uppgiften Bildsegmentering (medicinsk) med hjälp av datasetet KiTS19 och 3D U-Net-modellen uppnådde Gaudi2 en träningstid på 16.460 minuter med TensorFlow och 20.516 minuter med PyTorch, båda med åtta acceleratorer.

I rekommendationsuppgiften med Criteo 4TB-datauppsättningen och DLRM-dcnv2-modellen uppnådde Gaudi2 en träningstid på 14.794 minuter med PyTorch och 14.116 minuter med TensorFlow, båda med åtta acceleratorer.

I den slutna divisionen kunde 4:e generationens Xeons träna BERT- och ResNet-50-modeller på mindre än 50 respektive mindre än 90 minuter. Med BERT i den öppna divisionen tränade Xeon modellen på cirka 30 minuter när den skalade ut till 16 noder.

Dessa resultat framhäver den utmärkta skalningseffektiviteten som är möjlig med hjälp av kostnadseffektiva och lättillgängliga nätverkskort i Intel Ethernet 800-serien som använder programvaran Intel Ethernet Fabric Suite med öppen källkod baserad på Intel oneAPI.

Marknadseffekter

Intel Habana Gaudi2-resultaten i MLPerf Training 3.0-riktmärket understryker företagets engagemang för att tillhandahålla konkurrenskraftiga och effektiva AI-lösningar för ett brett utbud av applikationer, från datacentret till den intelligenta kanten. NVIDIA är klart klubbhusledaren i detta avseende, och varje serverleverantör snubblar över sig själv för att visa branschen ett brett utbud av GPU-tunga lådor som är redo för AI-arbetsbelastningar. Men dessa uppgifter bekräftar att AI inte är en kategori som passar alla och Intel gör sitt för att ge branschen valmöjligheter. Nettoresultatet är en vinst för organisationer som använder AI, eftersom mer konkurrens och valmöjligheter vanligtvis är mycket bra.

Engagera dig med StorageReview

Nyhetsbrev | Youtube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | Rssflöde