NVIDIA GTC 2023 startade med att introducera nya produkter, partners, innovationer och mjukvara. För att ge dig en uppfattning om bredden av tillkännagivanden varade keynoten i 78 minuter. Fyra nya plattformar tillkännagavs, var och en optimerad för en specifik generativ AI-inferensarbetsbelastning och specialiserad programvara.

NVIDIA GTC 2023 startade med att introducera nya produkter, partners, innovationer och mjukvara. För att ge dig en uppfattning om bredden av tillkännagivanden varade keynoten i 78 minuter. Fyra nya plattformar tillkännagavs, var och en optimerad för en specifik generativ AI-inferensarbetsbelastning och specialiserad programvara.

Plattformarna kombinerar NVIDIAs fulla stack av inferensmjukvara med de senaste NVIDIA Ada-, Hopper- och Grace Hopper-processorerna. Två nya grafikprocessorer, NVIDIA L4 Tensor Core GPU och H100 NVL GPU, lanserades idag.

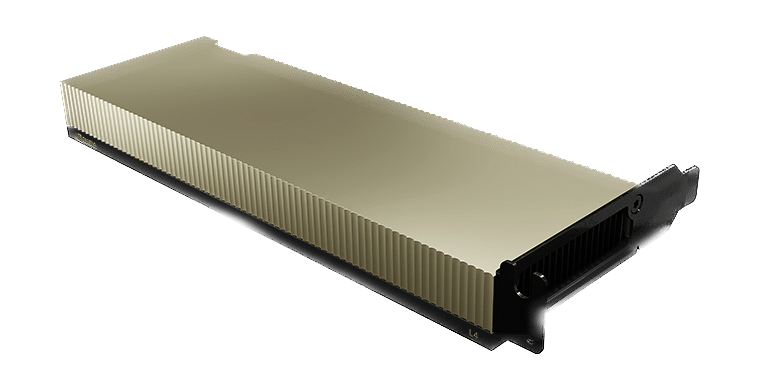

NVIDIA L4 för AI-video levererar 120 gånger mer AI-driven videoprestanda än processorer, kombinerat med 99 procent bättre energieffektivitet. L4 fungerar som en universell GPU för praktiskt taget alla arbetsbelastningar, och erbjuder förbättrade videoavkodnings- och omkodningsmöjligheter, videoströmning, förstärkt verklighet, generativ AI-video och mer.

NVIDIA Ada Lovelace L4 Tensor Core GPU levererar universell acceleration och energieffektivitet för video-, AI-, virtualiserade skrivbords- och grafikapplikationer i företaget, i molnet och vid kanten. Med NVIDIAs AI-plattform och full-stack

L4 är optimerad för slutsatser i stor skala för ett brett utbud av AI-applikationer, inklusive rekommendationer, röstbaserade AI-avatarassistenter, generativ AI, visuell sökning och automatisering av kontaktcenter.

L4 är den mest effektiva NVIDIA-acceleratorn för vanlig användning, och servrar utrustade med L4-kraft upp till 120x högre AI-videoprestanda och 2.7x mer generativ AI-prestanda jämfört med CPU-lösningar, samt över 4x mer grafikprestanda än den tidigare GPU-generationen. NVIDIA L4 är en mångsidig, energieffektiv, enkelslott och låg profilformfaktor som gör den idealisk för stora installationer och kantplaceringar.

NVIDIA L40 för bildgenerering är optimerad för grafik och AI-aktiverad 2D-, video- och 3D-bildgenerering. L40-plattformen fungerar som motorn för NVIDIA Omniverse, en plattform för att bygga och driva metaverse-applikationer i datacentret, och levererar 7x slutledningsprestanda för stabil diffusion och 12x Omniverse-prestanda jämfört med föregående generation.

NVIDIA L40 GPU levererar högpresterande visuell datoranvändning för datacentret, med nästa generations grafik-, dator- och AI-funktioner. Byggd på NVIDIA Ada Lovelace-arkitekturen, utnyttjar L40 kraften i den senaste generationens RT-, Tensor- och CUDA-kärnor för att leverera visualisering och beräkningsprestanda för krävande datacenterarbetsbelastningar.

L40 erbjuder förbättrad genomströmning och funktioner för samtidig strålspårning och skuggning som förbättrar strålspårningsprestanda och accelererar rendering för produktdesign och arkitektur, ingenjörs- och konstruktionsarbetsflöden. L40 GPU levererar hårdvarustöd för strukturell sparsamhet och optimerat TF32-format för direkt prestandavinster för snabbare AI- och datavetenskapsmodellutbildning. De accelererade AI-förbättrade grafikfunktionerna, inklusive DLSS, ger uppskalad upplösning med bättre prestanda i utvalda applikationer.

L40:s stora GPU-minne tacklar minnesintensiva applikationer och arbetsbelastningar som datavetenskap, simulering, 3D-modellering och rendering med 48 GB ultrasnabbt GDDR6-minne. Minne tilldelas flera användare med vGPU-programvara för att fördela stora arbetsbelastningar bland kreativa, datavetenskapliga och designteam.

NVIDIA L24 är designad för 7×40 företagsdatacenterdrift med energieffektiv hårdvara och komponenter, och är optimerad för att distribuera i skala och leverera maximal prestanda för olika datacenterarbetsbelastningar. L40 inkluderar säker start med root of trust-teknik, vilket ger ett extra lager av säkerhet, och är NEBS Level 3-kompatibel för att möta datacenterstandarder.

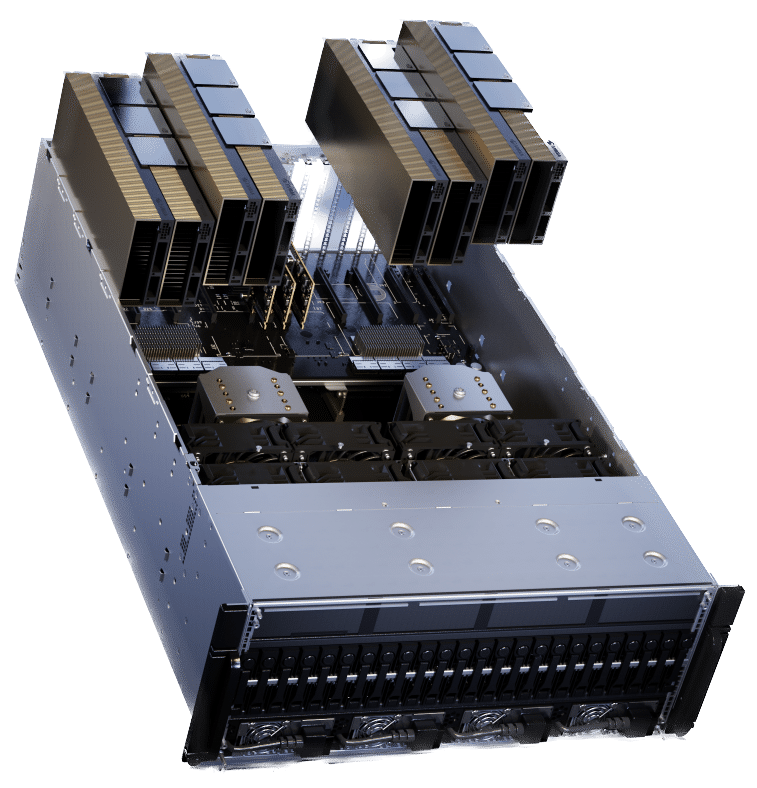

NVIDIA H100 NVL för implementering av stora språkmodeller är idealisk för att distribuera massiva LLMs som ChatGPT i stor skala. Den nya H100 NVL kommer med 94 GB minne med Transformer Engine-acceleration och ger upp till 12 gånger snabbare slutledningsprestanda vid GPT-3 jämfört med föregående generation A100 i datacenterskala.

Den PCIe-baserade H100 NVL med NVLink-brygga använder Transformer Engine, NVLink och 188 GB HBM3-minne för att leverera optimal prestanda och skalning över datacenter. H100 NVL stöder stora språkmodeller upp till 175 miljarder parametrar. Servrar utrustade med H100 NVL GPU:er ökar GPT-175B-modellens prestanda upp till 12x jämfört med NVIDIA DGX A100-system samtidigt som låg latens bibehålls i datacentermiljöer med begränsad energi.

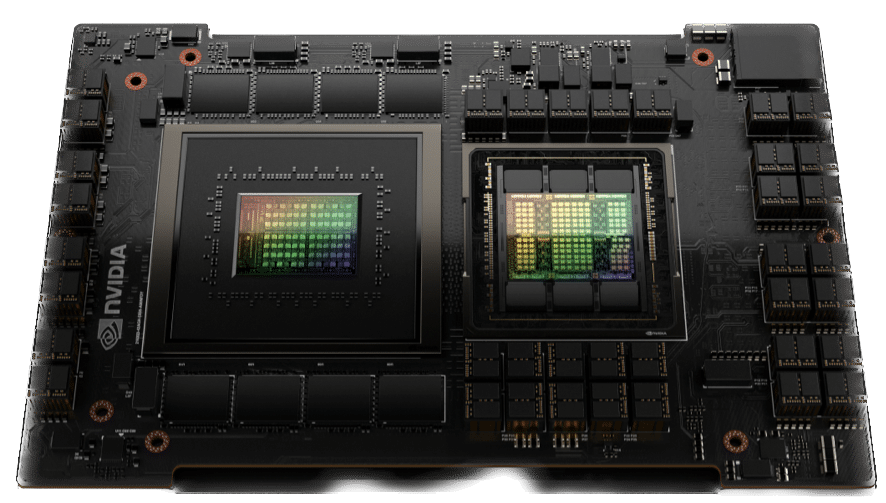

NVIDIA Grace Hopper för rekommendationsmodeller är idealisk för grafrekommendationsmodeller, vektordatabaser och grafiska neurala nätverk. Med 900 GB/s NVLink-C2C-anslutningen mellan CPU och GPU kan Grace Hopper leverera 7 gånger snabbare dataöverföringar och frågor än PCIe Gen 5.

NVIDIA Grace Hopper Superchip är en banbrytande accelererad CPU designad från grunden för AI- och högpresterande datorapplikationer (HPC). Superchippet kommer att leverera upp till 10 gånger högre prestanda för applikationer som kör terabyte data, vilket gör det möjligt för forskare och forskare att nå oöverträffade lösningar för världens mest komplexa problem.

NVIDIA Grace Hopper Superchip kombinerar Grace- och Hopper-arkitekturen med NVIDIA NVLink-C2C för att leverera en CPU+GPU-koherent minnesmodell för accelererade AI- och HPC-applikationer. Grace Hopper inkluderar 900 gigabyte per sekund (GB/s) koherent gränssnitt, är 7 gånger snabbare än PCIe Gen5 och levererar 30 gånger högre sammanlagd systemminnesbandbredd till GPU jämfört med NVIDIA DGX A100. Utöver allt detta kör den alla NVIDIA-programvarustackar och plattformar, inklusive NVIDIA HPC SDK, NVIDIA AI och NVIDIA Omniverse.

Moderna rekommendatorsystemmodeller kräver avsevärda mängder minne för att lagra inbäddningstabeller. Inbäddningstabeller innehåller semantiska representationer för artiklar och användares funktioner, vilket hjälper till att ge bättre rekommendationer till konsumenter.

I allmänhet följer dessa inbäddningar en kraftlagsfördelning för användningsfrekvens eftersom vissa inbäddningsvektorer nås oftare än andra. NVIDIA Grace Hopper möjliggör pipelines för rekommendationssystem med hög genomströmning som

lagra de mest använda inbäddningsvektorerna i HBM3-minnet och de återstående inbäddningsvektorerna i LPDDR5X-minnet med högre kapacitet. NVLink C2C-interconnect ger Hopper GPU:er med hög bandbredd åtkomst till deras lokala LPDDR5X-minne. Samtidigt utökar NVLink Switch System detta för att ge Hopper GPU:er med högbandbredd åtkomst till allt LPDDR5X-minne för alla Grace Hopper Superchips i NVLink-nätverket.

Engagera dig med StorageReview

Nyhetsbrev | Youtube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | Rssflöde