EchoStreams OSS1A är ett 1U-racksystem konstruerat för att användas som en flexibel serverplattform för apparater, mest anmärkningsvärt för sitt djup på endast 21 tum. OSS1A har en Intel C602A-chipset med dubbla processorer och stöder Intel Xeon E5-2600 V2-processorer med upp till 384 GB RAM för att ge den hästkraft som krävs för att hantera en mängd olika uppgifter i utrymmesbegränsade och fältinstallationer.

Vår granskning av OSS1A baseras inte bara på dess prestanda i vår serie av företagsprestandabenchmarks, utan också på vår erfarenhet av att använda OSS1A själva som en del av StorageReview Test Toolkit på plats. Vi valde OSS1A för användning i benchmarks på plats på grund av serverns lilla fotavtryck och för att den har kraften att utföra många av funktionerna i vårt laboratoriums benchmarkingmiljö utan att bli en flaskhals.

EchoStreams OSS1A erbjuds i tre konfigurationer med olika alternativ för intern lagring som kan användas utöver en valfri intern SSD-fack: två främre åtkomliga 15 mm 2.5-tumsfack; två interna 15 mm 2.5-tums enhetsfack; fyra främre åtkomliga 7 mm 2.5-tumsfack; eller två interna 2.5-tumsfack med en LCD-displaypanel. En kommande Haswell-version är också på gång, som kommer att erbjuda en 500W strömförsörjning för att hantera de högsta 160W TDP-processorerna. Haswell-versionen kommer också att stödja två FHHL Gen3 X16-kort, eller One FHHL plus en I/O-modul, som stöder dubbla 10Gb, 40Gb eller IB, plus ett par SFF8644-portar för SAS-expansion från SAS3008 ombord. Denna funktion skulle göra den här plattformen idealisk som lagringshuvudnoder (2x för HA) anslutna till EchoStreams eDrawer4060J (4U60bay dual 12G expander JBOD), som kör NexantaStor eller annan mjukvarudefinierad lagringsstack. I den konfigurationen kan de fyra SSD:erna i fronten användas som cache.

Vår recensionsenhet har formfaktorn med två framtill tillgängliga 2.5-tumsfack och två Intel Xeon E5-2697 v2-processorer med 2.7 GHz, 30 MB cache och 12 kärnor. Vi har också konfigurerat servern med 16GB (2x 8GB) 1333MHz DDR3 med registrerade RDIMM och en 100GB Micron RealSSD P400e som startenhet. Generellt är vår EchoStreams OSS1A konfigurerad med två Emulex LightPulse LPe16202 Gen 5 Fiber Channel HBA (8GFC, 16GFC eller 10GbE FCoE) PCIe 3.0 Dual-Port CFA eller två Mellanox ConnectX-3 Dual-port 10GbE Ethernet PCIe3.0. Dessa komponenter byts ut när servern används för att driva benchmarks beroende på utrustningen som testas och arbetsbelastningen som krävs.

Echostreams OSS1A-specifikationer

- CPU som stöds: Dual socket 2011 Intel Xeon E5 2600 V2 (Ivy Bridge)-processorer

- Chipset: Intel C602A

- RAM som stöds: Upp till 384 GB DDR3 800/1066/1333/1600 RDIMM/ECC UDIMM/Icke-ECC UDIMM/LR-DIMM

- I / O-gränssnitt:

- 2 x bakre USB

- 1 x främre USB

- 1 x VGA-port

- 4 x GbE Ethernet

- 1 x MGMT LAN

- Expansionsplatser: 1x PCIe Gen3 X16 FHHL & 1x PCIe Gen3 X8 LP-platser

- Förvaring:

- 2 x 2.5" hot-swap-fack eller

- 4 x 2.5 tum 7 mm hot-swap-fack eller

- 2 x interna 2.5-tumsfack.

- Serverhantering: IPMI med iKVM

- Kylning: 3x 97mm fläktar

- Frontpanelskärm:

- 1 x Strömbrytare & LED

- 1 x Lokalisera strömbrytare & LED

- 1 x Återställningsbrytare

- 1 x Systemvarningslysdiod

- 4 x LAN LED

- Effekt: 400W högeffektiv 1+1 redundanta nätaggregat

- Bruttovikt: 35lbs

- Mått:

- System: 21 tum x 17 tum x 1.74 tum

- Förpackning: 36" x 24.5" x 10.5" (LxBxH)

- Miljö:

- Arbetstemperatur: 0 ° C till 35 ° C

- Icke-driftstemperatur: -20°C till 70°C

- Luftfuktighet: 5% till 95% icke-kondenserande

- Överensstämmelse: CE, FCC klass A, RoHS 6/6-kompatibel

- Kompatibelt operativsystem: Linux RedHat Enterprise 6 64bit, Suse Linux Enterprise Server 11.2 64bit, VMWare ESX 4.1/ESXi4.1, Windows 2008 R2, Windows Server 2012, CentOS 5.6, Ubuntu 11.10

Bygg och design

Vår OSS1A granskningsenhet har två framtill åtkomliga 2.5-tums enhetsfack infällda i en avtagbar aluminiumram. Framsidan ger också tillgång till en USB-port tillsammans med en lokaliseringsomkopplare och lysdiod, strömbrytare och lysdiod, en återställningsomkopplare, en systemstatuslysdiod och fyra lysdioder som motsvarar de integrerade Ethernet-portarna på baksidan av systemet.

Förhöjda fläktavgaser ligger bakom frontramen, omedelbart framför de dubbla processorerna och DDR3 RAM. EchoStreams OSS1A har dubbla 400W strömförsörjningar i ett 1+1 hot swap-arrangemang till höger om systemet. Vi har konfigurerat den här servern med en 100GB Micron RealSSD P400e-startenhet.

Den bakre panelen har 4 GbE-portar (inklusive en för hantering), 2 USB-portar, en VGA-port och tillgång till expansionskort.

Testa bakgrund och lagringsmedia

Vi publicerar en inventering av vår labbmiljö, En översikt över labbets nätverksmöjligheter, och andra detaljer om våra testprotokoll så att administratörer och de som är ansvariga för utrustningsanskaffning rättvist kan bedöma de förhållanden under vilka vi har uppnått de publicerade resultaten. För att upprätthålla vårt oberoende betalas eller hanteras ingen av våra recensioner av tillverkaren av utrustning vi testar.

I vår standardgranskningsprocess skickar leverantören oss plattformen som granskas, som vi installerar i StorageReview Enterprise Test Lab för att utföra prestandabenchmarks. Men med vissa plattformar finns det storlek, komplexitet och andra logistiska hinder för detta tillvägagångssätt, och det är då EchoStreams OSS1A kommer in i bilden.

Vår senaste recension av EMC VNX5200-plattformen är ett exempel på en situation som krävde att vi åkte till EMC:s labb med OSS1A för att genomföra iSCSI- och FC-prestandatester. EMC levererade en 8Gb FC-switch, medan vi tog med en av våra Mellanox 10/40Gb SX1024-switchar för Ethernet-anslutning. Prestandaavsnittet nedan är baserat på de riktmärken som utförs med OSS1A som driver arbetsbelastningen och VNX5200 som lagringsarray.

EchoStreams OSS1A-1U konfiguration:

- 2x Intel Xeon E5-2697 v2 (2.7 GHz, 30 MB cache, 12-kärnor)

- Intel C602A Chipset

- Minne – 16GB (2x 8GB) 1333MHz DDR3-registrerade RDIMM

- Windows Server Standard 2012 R2

- Boot SSD: 100GB Micron RealSSD P400e

- 2x Mellanox ConnectX-3 dual-port 10GbE NIC

- 2x Emulex LightPulse LPe16002 Gen 5 Fiber Channel (8GFC, 16GFC) PCIe 3.0 Dual-Port HBA

Syntetisk arbetsbelastningsanalys för företag

Innan du påbörjar var och en av fio syntetiska riktmärken, vårt labb förbereder enheten till ett stabilt tillstånd under en tung belastning på 16 trådar med en enastående kö på 16 per tråd. Därefter testas lagringen i fastställda intervall med flera gäng-/ködjupsprofiler för att visa prestanda under lätt och tung användning.

Förkonditionering och primära stationära tester:

- Genomströmning (läs+skriv IOPS aggregerad)

- Genomsnittlig fördröjning (läs+skrivfördröjning i medeltal)

- Max fördröjning (maximal läs- eller skrivfördröjning)

- Latens standardavvikelse (läs+skriv standardavvikelse i genomsnitt)

Denna syntetiska analys innehåller fyra profiler som används i stor utsträckning i tillverkarens specifikationer och riktmärken:

- 4k slumpmässigt – 100% Läs och 100% Skriv

- 8k sekventiell – 100% Läs och 100% Skriv

- 8k slumpmässigt – 70% Läs/30% Skriv

- 128k sekventiell – 100% Läs och 100% Skriv

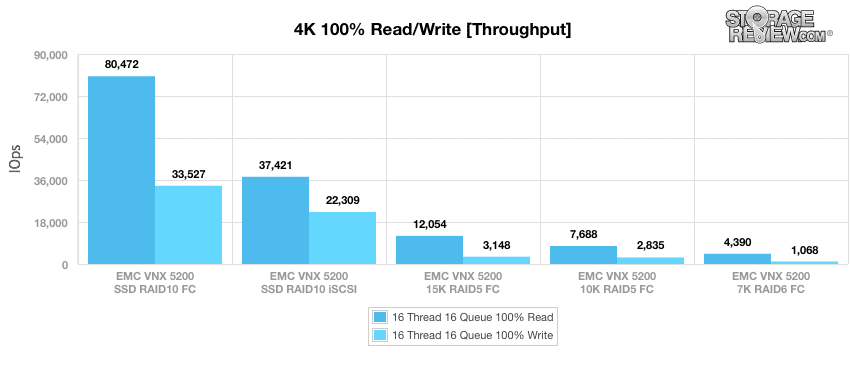

När VNX1 konfigurerats med SSD och nås av EchoStreams OSS5200A via Fibre Channel, publicerade VNX80,472 33,527 10 IOPS läsning och 5200 37,421 IOPS skrivning. Genom att använda samma SSD:er i RAID22,309 med vårt iSCSI-blocknivåtest, uppnådde VNX15 5 12,054 IOPS läsning och 3,148 10 IOPS skrivning. Byte till 7,688K hårddiskar i RAID2,835 med Fibre Channel-anslutning visade 7 6 IOPS läsning och 1 5200 IOPS skrivning, medan 4,390K HDD-konfigurationen träffade 1,068 XNUMX IOPS läsning och XNUMX XNUMX IOPS skrivning. När du använder XNUMXK hårddiskar i en RAIDXNUMX-konfiguration av samma anslutningstyp, publicerade EchoStreams OSSXNUMXA och VNXXNUMX XNUMX XNUMX IOPS läsning och XNUMX XNUMX IOPS skrivning.

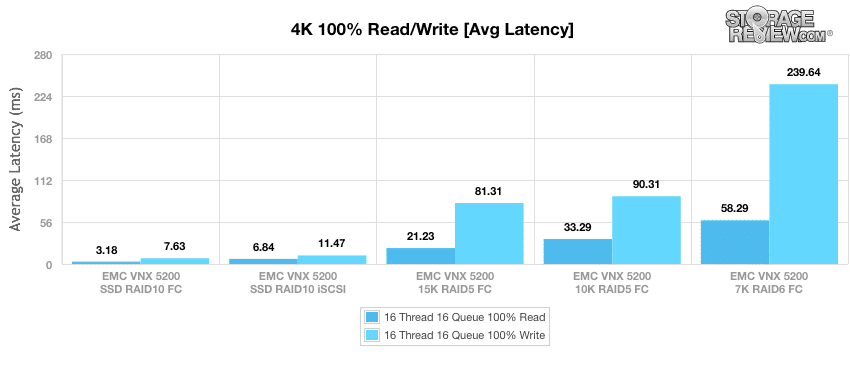

När den konfigurerades med SSD:er i RAID10 och använde en Fibre Channel-anslutning visade den här konfigurationen 3.18 ms läsning och 7.63 ms skrivning. Genom att använda samma SSD-enheter med vårt iSCSI-test på blocknivå, kunde systemet ståta med 6.84 ms läsning och 11.47 me skriv. Att byta till 15K hårddiskar i RAID5 med Fibre Channel-anslutning visade 21.23 ms läsning och 81.31 ms skriv i genomsnittlig latens, medan 10K hårddiskkonfigurationen gav 33.29 ms läsning och 90.31 ms skrivning. När VNX7 bytte till 6K hårddiskar i en RAID5200-konfiguration publicerade VNX58.29 239.64 ms läsning och XNUMX ms skrivning.

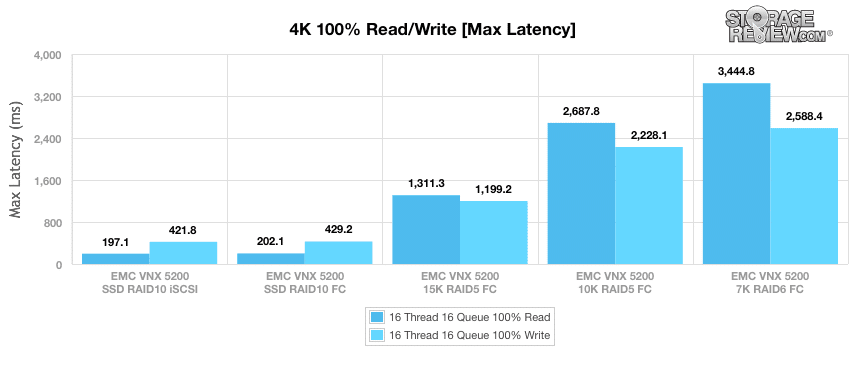

När de är konfigurerade med SSD-enheter i RAID10 och med vårt iSCSI-test på blocknivå, klockade våra maximala latensresultat 197 ms för läsoperationer och 421.8 ms för skrivoperationer. Genom att använda samma SSD-enheter med Fibre Channel-anslutning, mätte systemet 202.1 ms läsning och 429.2 ms skrivning. Byte till 15K hårddiskar i RAID5 med Fibre Channel-anslutning registrerade 1,311.3 1,199.2 ms läsning och 10 2,687.8 ms skrivning för maximal latens, medan 2,228.1K HDD-konfigurationen publicerade 7 6 ms läsning och 1 5200 ms skrivning. Vid byte till 3,444.8K-hårddiskar i en RAID2,588.4-konfiguration av samma anslutningstyp publicerade OSSXNUMXA och VNXXNUMX XNUMX XNUMX ms läsning och XNUMX XNUMX ms skrivning.

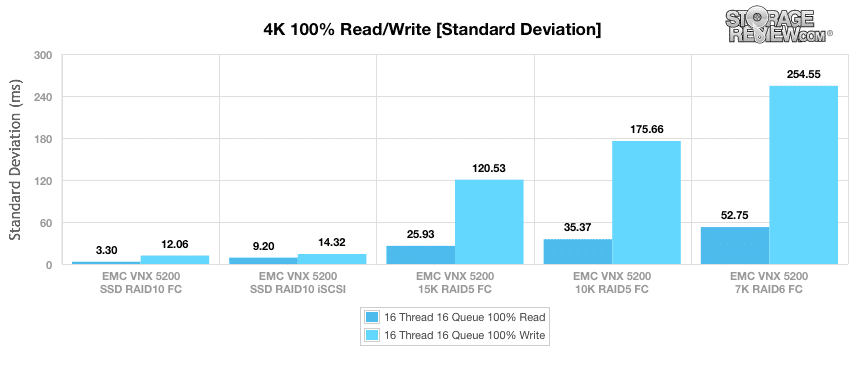

Vårt senaste 4K-riktmärke är standardavvikelse, som mäter systemets konsistenss latensprestanda. När den är konfigurerad med SSD-enheter i RAID10 med vårt iSCSI-test på blocknivå, OSS1A och VNX5200 postade 3.30 ms läs och 12.06 ms skriv. Att använda samma SSD-enheter med Fibre Channel-anslutning visar 9.20 ms läsning och 14.32 ms skriv. Byte till 15K hårddiskar i RAID5 med Fibre Channel-anslutning registrerade 25.93 ms läsning och 120.53 ms skrivning, medan 10K HDD-konfigurationen visade 35.37 ms läsning och 175.66 ms skrivning. När du använder 7K-hårddiskar RAID6-konfiguration av samma anslutningstyp, publicerade VNX5200 52.75 ms läsning och 254.55 ms skrivning.

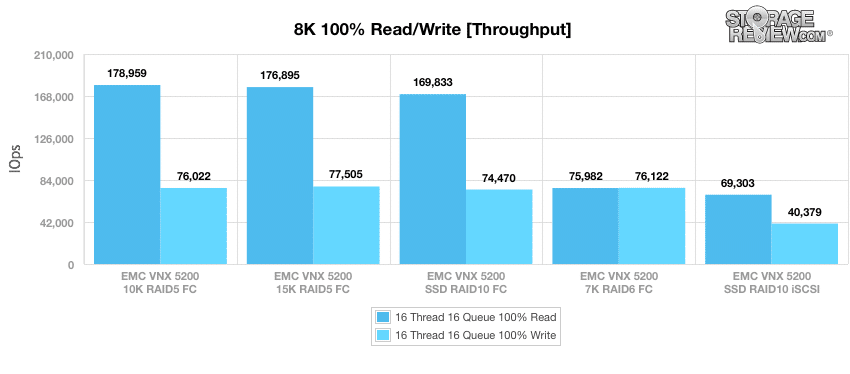

Vårt nästa riktmärke använder en sekventiell arbetsbelastning som består av 100 % läsoperationer och sedan 100 % skrivoperationer med en överföringsstorlek på 8k. Här mätte OSS1A 178,959 76,022 IOPS läsning och 5200 10 IOPS skriv när VNX5 var utrustad med 15K hårddiskar i RAID5 Fibre Channel-anslutning. Att använda 176,895K hårddiskar i RAID77,505 med Fibre Channel-anslutning visar 10 169,833 IOPS läsning och 74,470 69,303 IOPS skrivning. Att byta till SSD:er i RAID40,379 med en Fibre Channel-anslutning registrerade 7 6 IOPS läsning och 5200 75,982 IOPS skrivning, medan SSD iSCSI-blocknivåtestet visade 76,122 XNUMX IOPS läsning och XNUMX XNUMX IOPS skrivning. När du använder XNUMXK hårddiskar i en RAIDXNUMX-konfiguration med Fibre Channel-anslutning, publicerade VNXXNUMX XNUMX XNUMX IOPS läsning och XNUMX XNUMX IOPS skrivning.

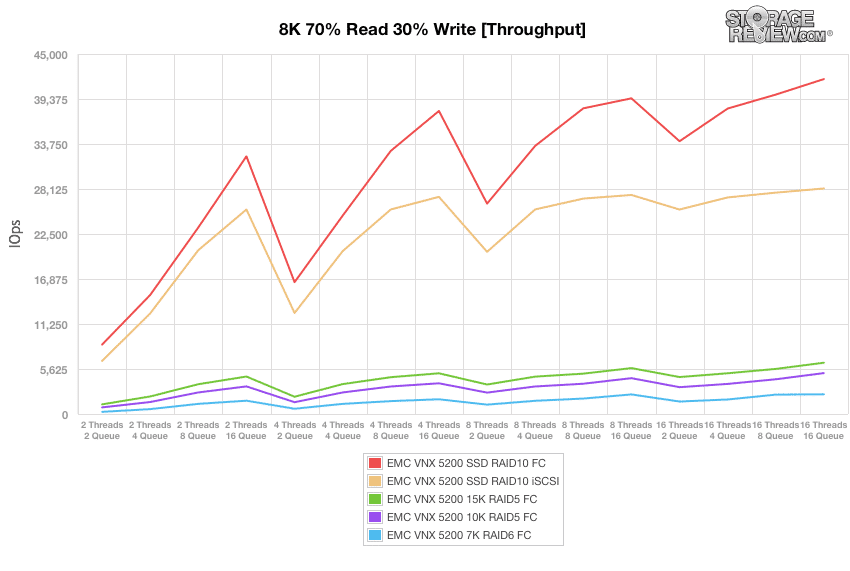

Vår nästa serie arbetsbelastningar består av en blandning av 8k läs- (70%) och skrivoperationer (30%) upp till en 16 trådar 16-kö, vår första är genomströmning. När OSS10A och VNX1 har konfigurerats med SSD:er i RAID5200 med Fibre Channel-anslutning, publicerade en rad 8,673 XNUMX IOPS till 41,866 16 IOPS med 16T/XNUMXQ. Att använda samma SSD-enheter under vårt iSCSI-test på blocknivå visar ett antal 6,631 28,193 IOPS till XNUMX XNUMX IOPS. Att byta till 15K hårddiskar i RAID5 med Fibre Channel-anslutning spelade in ett intervall på 1,204 XNUMX IOPS och 6,411 XNUMX IOPS, medan 10K HDD-konfigurationen publicerade 826 IOPS och 5,113 16 IOPS med 16T/7Q. När du använder 6K-hårddiskar RAID267-konfiguration av samma anslutningstyp, postade systemet ett intervall på 2,467IOPS till XNUMX XNUMXIOPS.

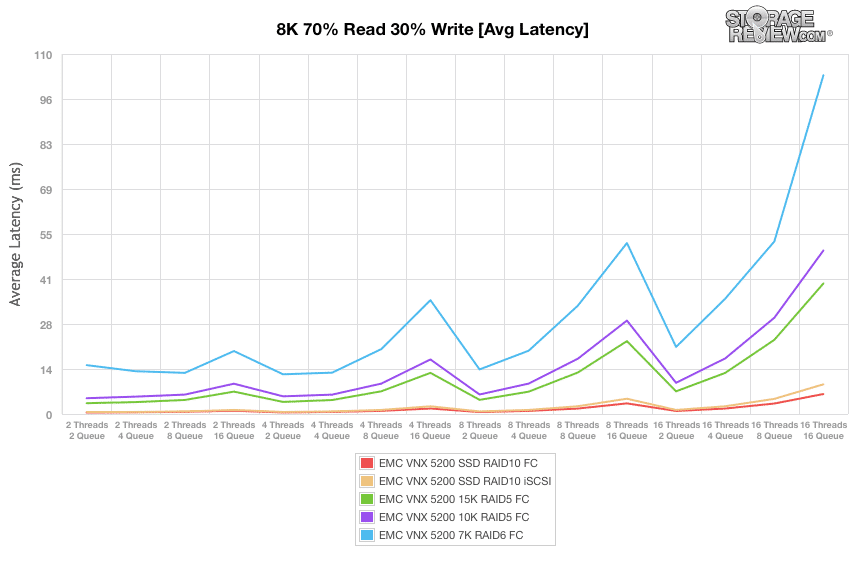

Därefter tittade vi på genomsnittlig latens. När VNX5200 konfigurerades med SSD:er i RAID10 med Fibre Channel-anslutning, mätte OSS1A ett intervall på 0.45ms till 6.11ms med 16T/16Q. Att använda samma SSD-enheter under vårt iSCSI-blocknivåtest visar ett intervall på 0.59 ms till 9.07 ms. Att byta till 15K HDDs i RAID5 med Fibre Channel-anslutning spelade in ett intervall på 3.31ms och 39.89ms, medan 10K HDD-konfigurationen publicerade 4.83ms initialt och 49.97ms av 16T/16Q. När du använder 7K-hårddiskar RAID6-konfiguration av samma anslutningstyp, postade VNX5200 ett intervall på 14.93 ms till 103.52 ms.

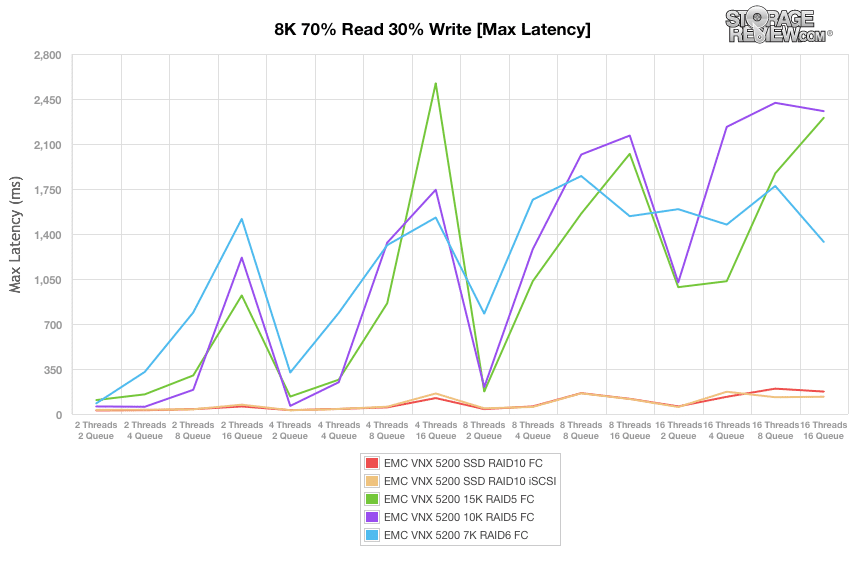

Maximala latensresultat med SSD-enheter i RAID10 som använder Fibre Channel-anslutning varierade från 27.85 ms upp till 174.43 ms med 16T/16Q. Att använda samma SSD-enheter under vårt iSCSI-blocknivåtest visar ett intervall på 31.78 ms till 134.48 ms i maximal latens. Att byta till 15K hårddiskar i RAID5 med Fibre Channel-anslutning spelade in ett intervall på 108.48ms och 2,303.72ms, medan 10K HDD-konfigurationen visade 58.83ms och 2,355.53ms med 16T/16Q. När du använder 7K-hårddiskar RAID6-konfiguration av samma anslutningstyp, publicerade VNX5200 ett maximalt latensintervall på 82.74 ms till 1,338.61 XNUMX ms.

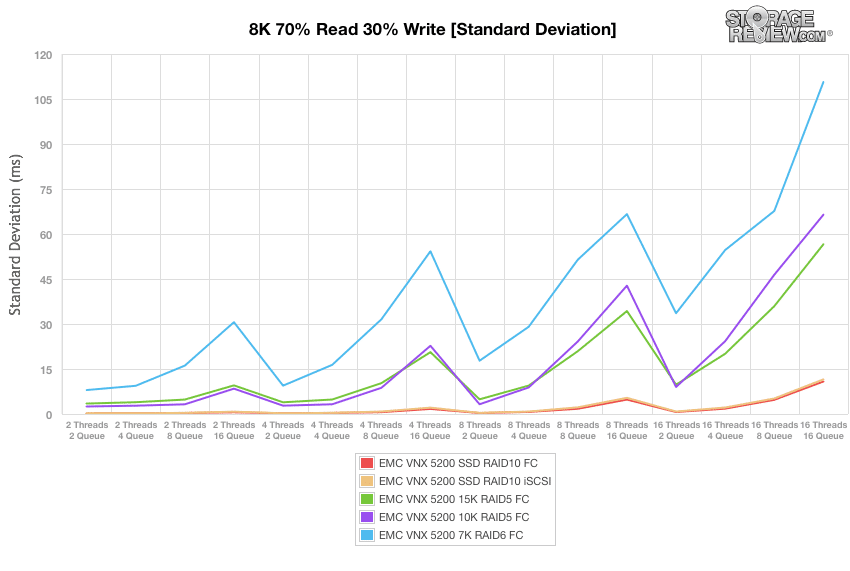

Vårt nästa diagram plottar standardavvikelseberäkningen för latenser under 8k 70% läs- och 30% skrivoperationer. Genom att använda SSD:er i RAID10 med Fibre Channel-anslutning, postade VNX5200 ett intervall på bara 0.18ms till 10.83ms av 16T/16Q. Att använda samma SSD-enheter under iSCSI-blocknivåtestet visar ett liknande intervall på 0.21ms till 11.54ms i latenskonsistens. Att byta till 15K HDDs i RAID5 med Fibre Channel-anslutning spelade in ett intervall på 3.48ms till 56.58ms, medan 10K HDD-konfigurationen visade 2.5ms initialt och 66.44ms av 16T/16Q. När du använder 7K-hårddiskar RAID6-konfiguration av samma anslutningstyp, publicerade VNX5200 ett standardavvikelseintervall på 7.98 ms till 110.68 ms.

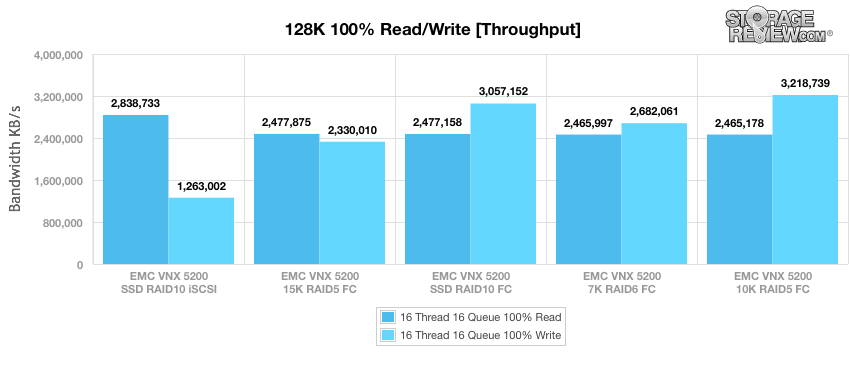

Vårt sista syntetiska riktmärke använde sekventiella 128k överföringar och en arbetsbelastning på 100 % läs- och 100 % skrivoperationer. I det här scenariot mätte OSS1A 2.84 GB/s läsning och 1.26 GB/s skriv när VNX5200 konfigurerades med SSD:er med vårt iSCSI-test på blocknivå. Att använda 15K hårddiskar i RAID5 med Fibre Channel-anslutning visar 2.48 GB/s läsning och 2.33 GB/s skriv. Genom att byta tillbaka till SSD-enheter i RAID10 med Fibre Channel-anslutning spelade OSS1A in 2.48 GB/s läsning och 3.06 GB/s skrivning. När du använder 7K hårddiskar i en RAID6-konfiguration med Fibre Channel-anslutning nådde VNX5200 2.47 GB/s läsning och 2.68 GB/s skrivning medan 10K HDD-konfigurationen gav 2.47 GB/s läsning och 3.22 GB/s skrivning.

Slutsats

Sedan EchoStreams OSS1A först kom till StorageReview har den blivit en viktig del av vårt laboratorium genom att tillåta oss att skapa en mobil version av vår benchmarkmiljö för företagslagring. Vi har funnit att chassidesignen är en genomtänkt kompromiss mellan flexibilitet och storlek. Den inre layouten möjliggör också relativt smärtfri omkonfigurering, till exempel när man byter ut PCIe-expansionskort för att gränssnittet mot en mängd olika nätverksprotokoll och miljöer. Allt detta kommer utan att kompromissa med prestanda, medan plattformen stöder dubbla Intel Xeon E52600 v2-processorer och upp till 384 GB DDR3-minne.

Denna kombination av prestanda och liten formfaktor gör EchoStreams OSS1A till en mångsidig plattform att distribuera för en applikationsserver som är beroende av extern delad lagring. Att vara så kompakt innebär mindre utrymme som används i ditt datacenter, samt att det är ganska portabelt att distribuera som en fältenhet på ett fjärrkontor eller liknande. Chassit kan också skräddarsys för användningsfallet med olika frontlagringsalternativ, och erbjuder upp till 4 7 mm kortplatser som kan användas av SSD:er där snabbare inbyggd lagring krävs. Sammantaget erbjuder EchoStreams OSS1A en enorm mängd prestanda i ett otroligt kort 21″ djupt paket.

Fördelar

- Kort djup 1U formfaktor gör systemet mer portabelt och kan installeras i situationer där utrymmet är litet

- Tillräckligt med processorkraft och RAM-kapacitet för att klara en mängd olika arbetsbelastningar

Nackdelar

- Begränsad intern lagringskapacitet på grund av chassistorlek

The Bottom Line

EchoStreams OSS1A erbjuder prestanda och flexibilitet för att ta sig an en mängd olika uppgifter, förpackad i ett imponerande 1U-chassi med kort djup som förenklar transport och installation på platser med begränsat utrymme. Denna kombination har gjort OSS1A till en oumbärlig komponent i StorageReviews testverktyg på plats.