今天在 SC20 上,NVIDIA 宣布,隨著 NVIDIA A100 100GB GPU 的亮相,其廣受歡迎的 A80 GPU 的高帶寬內存將翻倍。 這個新的 GPU 將是為新的 NVIDIA HGX AI 超級計算平台提供動力的創新。 憑藉兩倍的內存,新 GPU 希望幫助研究人員和工程師達到前所未有的速度和性能,以開啟下一波 AI 和科學突破。

今天在 SC20 上,NVIDIA 宣布,隨著 NVIDIA A100 100GB GPU 的亮相,其廣受歡迎的 A80 GPU 的高帶寬內存將翻倍。 這個新的 GPU 將是為新的 NVIDIA HGX AI 超級計算平台提供動力的創新。 憑藉兩倍的內存,新 GPU 希望幫助研究人員和工程師達到前所未有的速度和性能,以開啟下一波 AI 和科學突破。

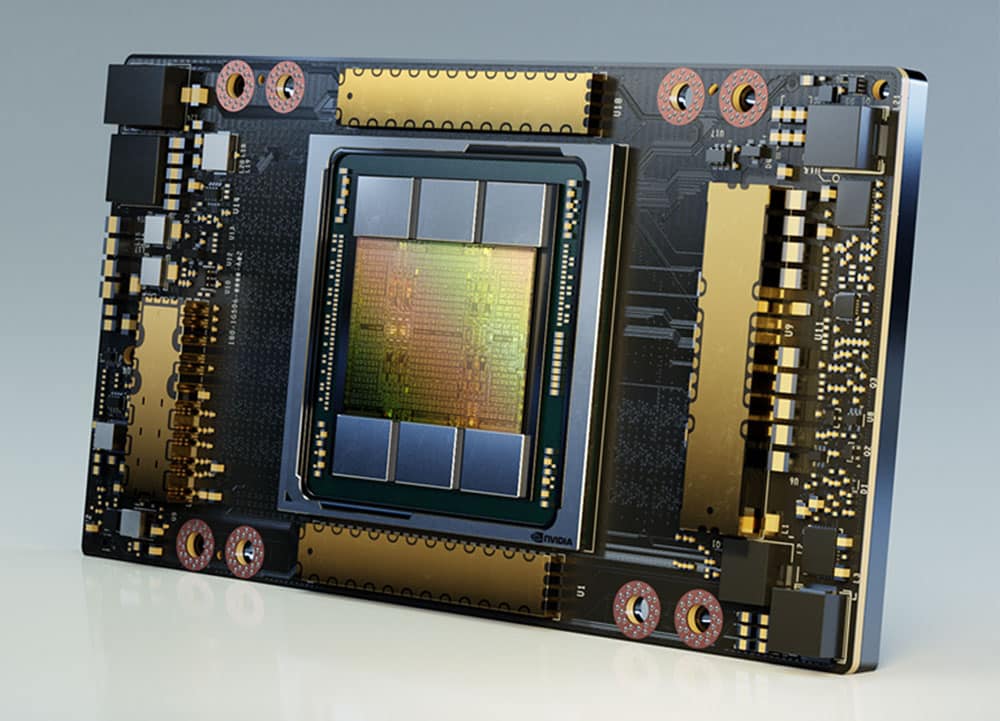

今年早些時候在 GTC 上,NVICIA 宣布發布其 7nm GPU,NVIDIA A100. 正如我們當時所寫,A100 基於 NVIDIA 的安培架構,包含 54 億個晶體管。 與之前的 NVIDIA 數據中心 GPU 一樣,A100 包含 Tensor Core。 Tensor 核心是 GPU 的專用部分,專門設計用於快速執行推理中常用的一種矩陣乘法和加法計算。新的更強大的 GPU 帶來了新的、更強大的 Tensor 核心。 以前,NVIDIA 的 Tensor Cores 最多只能支持 100 位浮點數。 AXNUMX 支持 XNUMX 位浮點運算,精度更高。

據說將高帶寬內存 (HBM2e) 提高到 80GB 可以提供每秒 2 TB 的內存帶寬。 這種新的提升有助於 HPC 中具有巨大數據內存需求的新興應用程序,例如 AI 培訓、自然語言處理和大數據分析等。

A100 80GB 的主要特點

A100 80GB 包括 NVIDIA Ampere 架構的許多突破性功能:

- 第三代張量核心:提供高達上一代 Volta 20 倍的 AI 吞吐量,採用新格式 TF32,以及用於 HPC 的 2.5 倍 FP64、用於 AI 推理的 20 倍 INT8,並支持 BF16 數據格式。

- 更大、更快的 HBM2e GPU 顯存:顯存容量加倍,是業內首款提供每秒超過 2TB 顯存帶寬的產品。

- MIG 技術:將每個獨立實例的內存加倍,最多提供七個 MIG,每個 10GB。

- 結構稀疏性:提供高達 2 倍的加速推理稀疏模型。

- 第三代 NVLink 和 NVSwitch:提供兩倍於上一代互連技術的 GPU 到 GPU 帶寬,將數據傳輸到 GPU 的數據密集型工作負載加速到每秒 600 GB。

庫存情況

源訊、戴爾科技、富士通、技嘉、惠普、浪潮、聯想、廣達和超微預計將在明年上半年開始提供使用 HGX A100 集成基板構建的系統,這些基板配備 A100 80GB GPU。

參與 StorageReview

電子報 | YouTube | 播客 iTunes/Spotify | Instagram | Twitter | Facebook | RSS訂閱