Open Compute Project (OCP) 已宣佈在其平台中添加 Wiwynn ES200 邊緣服務器和 NVIDIA HGX-H100 GPU 基板。

Open Compute Project (OCP) 已宣佈在其平台中添加 Wiwynn ES200 邊緣服務器和 NVIDIA HGX-H100 GPU 基板。

Wiwynn 的短深度邊緣服務器旨在滿足邊緣站點對計算能力不斷增長的需求,特別適用於即時 AI 推理、現場數據分析和多通道視頻處理等應用。

NVIDIA 的 HGX-H100 GPU 基板物理規範有望幫助提高 OCP 的 OAI 子項目利用 HGX 的能力,並為 AI 和 HPC 應用中的高性能計算開發具有成本效益、高效、可擴展的平台和系統規範。

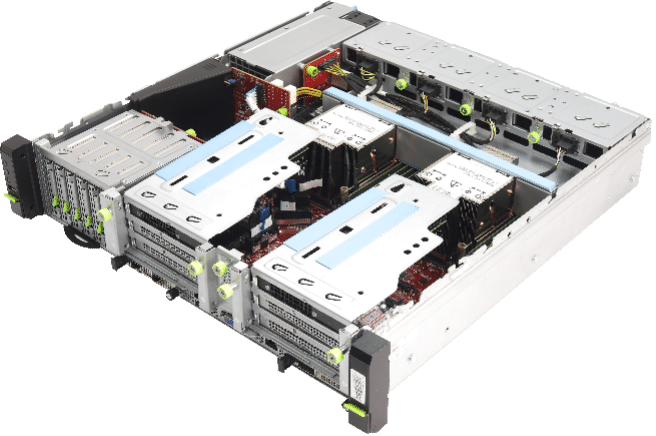

Wiwynn ES200 邊緣服務器

Wiwynn ES200 是一款 2U 雙路邊緣服務器,搭載第三代英特爾至強可擴展處理器。 借助 NUMA 平衡,它可以提供每個安裝的處理器的計算能力來分別完成不同的工作負載,而不會在 CPU 之間造成通信瓶頸。

它還具有額外的 PCIe Gen4 x16 插槽,可以配備兩個雙寬附加卡。 這為系統增加了很大的靈活性,使其成為 AI 推理加速、視頻轉碼和數據分析等用例以及需要額外網絡連接的用例的理想選擇。 它具有靈活的存儲模塊,包括 EDSFF (E1.S) 或 U.2 SSD 和兩個 OCP NIC 3.0 卡,使 ES200 能夠產生令人印象深刻的本地數據處理和高帶寬網絡連接。

ES200 還符合 NEBS-3 標準並具有短深度緊湊型外形。 此外,Wiwynn表示在困難的操作條件下也能流暢運行,並能適應各種邊緣站點。

Wiwynn ES200 邊緣服務器節點規格

| 節點規格 | |

| 處理器 | 第三代英特爾至強可擴展處理器,TDP 3W/250W |

| 處理器插槽 | 2 |

| 芯片組 | 英特爾C621A系列 |

| 安全性 | TPM v2.0(選項) |

| 系統總線 | 英特爾 UltraPath 互連; 11.2GT/秒 |

| 記憶體應用 | 16 個 DIMM 插槽; DDR4 高達 3200 MT/s,每個 DIMM 高達 64GB; 12 個 DIMM 插槽,最多 2 個 DCPMM (Intel Barlow Pass) |

| 儲存應用 | ‧ 2280個板載22110/2 M.XNUMX SSD Module插槽 ‧ 六個U.2 (15/7mm), 或八個EDSFF E1.S (5.9/9.5mm) |

| 擴展插槽 | 多達六個 PCIe Gen4 插槽: ‧ 16個PCIe x8 FHFL Dual-width + XNUMX個PCIe xXNUMX FHHL ‧ 16個PCIe x8 FHHL插槽 + XNUMX個PCIe xXNUMX FHHL ‧ 8個PCIe xXNUMX FHHL插槽可按需選購 兩個板載 OCP 3.0 NIC x16 |

| 管理局域網 | ‧ XNUMX個GbE專用BMC接口 |

| I / O端口 | ‧ 帶 LED 的電源按鈕 ‧ 帶 LED 的 UID 按鈕 ‧ RST按鈕 ‧ 三個USB接口 ‧ BMC管理接口(前側) ‧ VGA接口(D-sub) |

| 底盤規格 | |

| 尺寸 | 2U機架; 86(高)× 440(寬)× 450(深)(毫米) |

| 電源供應器 | 熱插拔、冗餘 (1+1) 1600W CRPS |

| Fan | 四個8038雙轉子,冗餘(7+1) |

| 重量 | 14.47kg |

| 環境 | ‧ 使用環境溫度範圍:-5 至 +55 攝氏度

‧ 操作及儲存相對濕度:10% 至 90% (非冷凝) ‧ 儲存溫度範圍:-40至+70攝氏度 |

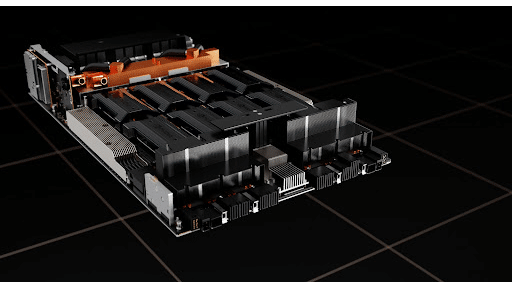

NVIDIA HGX-H100底板

NVIDIA HGX-H100 是一款基板,承載了八個最新的 料斗GPU模塊. HGX 底板物理規範定義了物理尺寸主機接口、管理和調試接口等內容。 NVIDIA 的貢獻包還包含底板物理規格、底板輸入/輸出引腳列表和引腳圖、2D/3D 繪圖。

以下來自 OCP 的列表表明了 NVIDIA HGX 的貢獻是如何建立在他們的“四大原則”之上的:效率、可擴展性、開放性和影響:

- 效率——這是第 3 代 HGX 底板外形尺寸,每一代都提供了大約 3-5 倍高的 AI 訓練吞吐量,同時消耗相似的有功功率。 因此,HGX 底板現在已成為事實上的標準,全球大多數超大規模開發者都圍繞這種外形尺寸設計 AI 訓練和推理。

- 可擴展性——在全球範圍內,有數十萬個 HGX 系統正在生產中。 這種外形尺寸的系統和外殼將是穩定的,並且是大規模建造的。 HGX 規範將包括物理尺寸、用於監控/調試的管理接口等,用於大規模服務。

- 開放性——基於 HGX 的系統是全球最常見的人工智能訓練平台。 許多 OEM/ODM 已經構建了基於 HGX 的人工智能係統。 有了這個 HGX 物理規範的貢獻,OAI 小組將盡可能地將 UBB2.0 與 HGX 規範融合。 OEM/ODM 可以在類似 UBB/HGX 的底板上利用不同加速器的相同系統設計,例如相同的底板尺寸、主機接口、管理接口、電源傳輸等。

- 影響——NVIDIA HGX 平台已成為 AI 訓練平台事實上的全球標準。 開放此 HGX 底板外形允許其他 AI 加速器供應商利用系統和外殼的 HGX 生態系統。 這應該會加速其他 AI 供應商利用現有基礎設施並更快地採用他們的解決方案。 這進一步加速了 AI/HPC 領域的創新。

參與 StorageReview

電子報 | YouTube | 播客 iTunes/Spotify | Instagram | Twitter | Facebook | 的TikTok | RSS訂閱