今天,NVIDIA 宣佈在其部分全球合作夥伴的幫助下,將推出全新的 NVIDIA HGX A100 系統。 新系統希望通過添加 NVIDIA 元素(例如 NVIDIA A100 80GB PCIe GPU、NVIDIA NDR 400G InfiniBand 網絡和 NVIDIA Magnum IO GPUDirect 存儲軟件)來加速 AI 和 HPC。 這些新的 HGX 系統將由包括 Atos、Dell Technologies、Hewlett Packard Enterprise (HPE)、聯想、Microsoft Azure 和 NetApp 在內的合作夥伴推向市場。

今天,NVIDIA 宣佈在其部分全球合作夥伴的幫助下,將推出全新的 NVIDIA HGX A100 系統。 新系統希望通過添加 NVIDIA 元素(例如 NVIDIA A100 80GB PCIe GPU、NVIDIA NDR 400G InfiniBand 網絡和 NVIDIA Magnum IO GPUDirect 存儲軟件)來加速 AI 和 HPC。 這些新的 HGX 系統將由包括 Atos、Dell Technologies、Hewlett Packard Enterprise (HPE)、聯想、Microsoft Azure 和 NetApp 在內的合作夥伴推向市場。

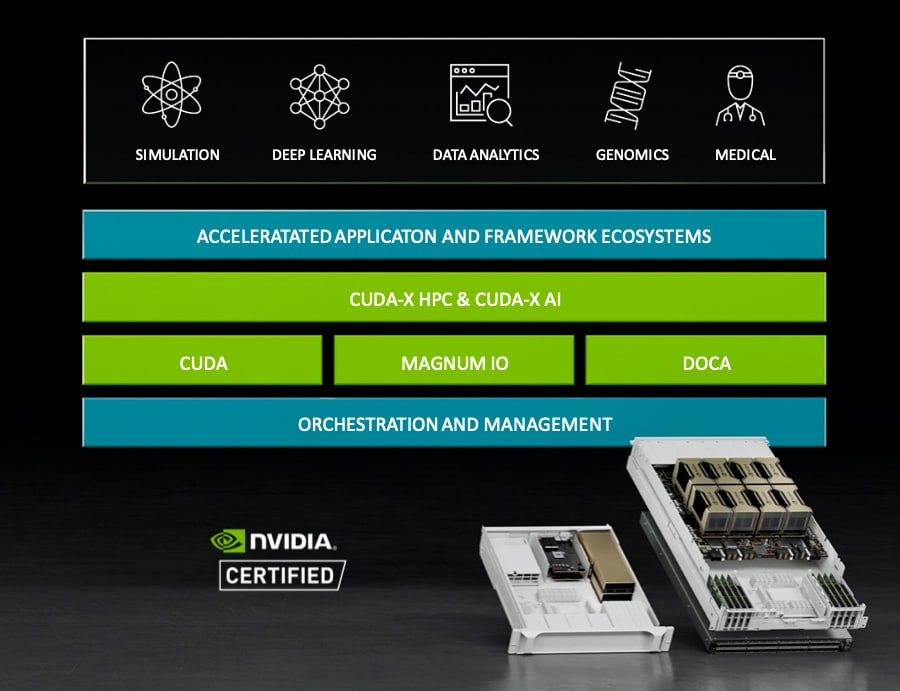

NVIDIA 多年來一直在製造高性能 GPU。 新興的 AI 市場,尤其是 HPC,已經推動越來越多的超級計算機利用該公司的技術。 NVIDIA 自己在過去幾年中一直在使用 DGX 和 HGX 模型製造 HPC 服務器和工作站。 後者將幾個 NVIDIA IP 集中在一個屋簷下以獲得更好的性能。新系統再次使用 NVIDIA 必須提供的最新和最強大的功能來做到這一點。

NVIDIA A100 80GB PCIe GPU

NVIDIA A100 於去年在 GTC 上發布。 這款全新的 7nm GPU 採用了該公司的 Ampere 架構,包含 54 萬個晶體管。 NVIDIA 通過推出 NVIDIA A100 80GB PCIe GPU 迅速改進了產品,將內存增加了一倍。 A100 80GB PCIe GPU 是新 HGX A100 系統的第一部分。 它的大內存容量和高帶寬允許在內存中保存更多數據和更大的神經網絡。 這意味著更少的節點間通信以及更少的能源消耗。 高內存還允許更高的吞吐量,從而可以更快地獲得結果。

如前所述,NVIDIA A100 80GB PCIe GPU 由該公司的 Ampere 架構提供支持。 此架構具有多實例 GPU,也稱為 MIG。 MIG 可以為較小的工作負載(即 AI 推理)提供加速。 此功能允許用戶在保證 QoS 的情況下縮減計算和內存。

圍繞 NVIDIA A100 80GB PCIe GPU 的合作夥伴包括源訊、思科、戴爾科技、富士通、新華三、HPE、浪潮、聯想、企鵝計算、QCT 和超微。 有一些雲服務也提供該技術,包括 AWS、Azure 和 Oracle。

NVIDIA NDR 400G InfiniBand 網絡

NVIDIA HGX A100 系統拼圖的第二塊是新的 NVIDIA NDR 400G InfiniBand 交換機系統。 這聽起來有點明顯,但 HPC 系統需要非常高的數據吞吐量。 NVIDIA 幾年前以近 7 億美元的價格收購了 Mellanox. 從那時起,它一直在穩步發布新產品,同時慢慢淘汰 NVIDIA 的 Mellanox 名稱。 去年發布的 NVIDIA NDR 400G InfiniBand 具有 3 倍的端口密度和 32 倍的 AI 加速。 這通過 NVIDIA Quantum-2 固定配置交換機系統集成到新的 HGX 系統中。 據說該系統每端口提供 64 個 NDR 400Gb/s InfiniBand 端口或 128 個 NDR200 端口。

據該公司稱,新的 NVIDIA Quantum-2 模塊化交換機可提供多達 2,048 個 NDR 400Gb/s InfiniBand 端口(或 4,096 個 NDR200 端口)的可擴展端口配置,總雙向吞吐量為每秒 1.64 PB。 與上一代產品相比,性能提高了 5 倍以上,可擴展性提高了 6.5 倍。 使用 DragonFly+ 網絡拓撲,用戶可以連接到超過一百萬個節點。 最後,該公司在其第三代 NVIDIA SHARP 網絡計算數據縮減技術中加入了這一技術,據稱與前幾代產品相比,該技術可以實現 3 倍的 AI 加速。

NVIDIA Quantum-2 開關向後和向前兼容。 製造合作夥伴包括 Atos、DDN、Dell Technologies、Excelero、GIGABYTE、HPE、Lenovo、Penguin、QCT、Supermicro、VAST 和 WekaIO。

Magnum IO GPU直接存儲

新的 NVIDIA HDX A100 拼圖的最後一塊是新的 Magnum IO GPUDirect Storage。 這允許 GPU 內存和存儲之間的直接內存訪問。 這有幾個好處,包括較低的 I/O 延遲、大量使用網絡適配器的帶寬以及對 CPU 的影響較小。 多個合作夥伴現已推出 Magnum IO GPUDirect Storage,包括 DDN、Dell Technologies、Excelero、HPE、IBM Storage、Micron、NetApp、Pavilion、ScaleFlux、VAST 和 WekaIO。

參與 StorageReview

電子報 | YouTube | LinkedIn | Instagram | Twitter | Facebook | 的TikTok | RSS訂閱