Während der VMware Explore-Veranstaltung 2023 kündigte VMware in Zusammenarbeit mit NVIDIA VMware Private AI und VMware Private AI Foundation an. Auf der NVIDIA GTC diese Woche kam VMware diesem Ziel einen Schritt näher und kündigte die erste Verfügbarkeit der VMware Private AI Foundation mit NVIDIA an.

Während der VMware Explore-Veranstaltung 2023 kündigte VMware in Zusammenarbeit mit NVIDIA VMware Private AI und VMware Private AI Foundation an. Auf der NVIDIA GTC diese Woche kam VMware diesem Ziel einen Schritt näher und kündigte die erste Verfügbarkeit der VMware Private AI Foundation mit NVIDIA an. Diese Zusammenarbeit führte zur Entwicklung einer Plattform auf Basis der VMware Cloud Foundation, die die KI-Inferenz-Microservices von NVIDIA integriert. Die Plattform umfasst auch Beiträge von Unternehmen wie Hugging Face.

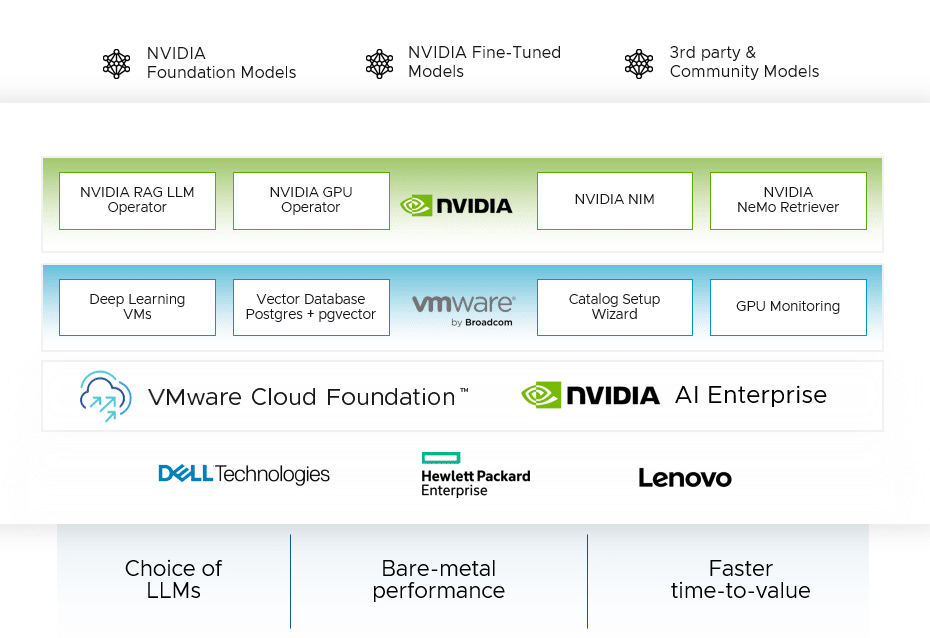

Die VMware Private AI Foundation mit NVIDIA soll die Implementierung von Retrieval Augmented Generation (RAG)-Workflows, die Anpassung von LLM-Modellen und Inferenz-Workloads in Rechenzentren vorantreiben. Es bietet Lösungen für Datenschutz-, Kosten- und Compliance-Probleme durch Automatisierungstools, Deep-Learning-VM-Bilder, eine Vektordatenbank und GPU-Überwachungsfunktionen. Insbesondere ist der Erwerb separater NVIDIA AI Enterprise-Lizenzen für den vollen Funktionsumfang unerlässlich.

VMware Private AI Foundation mit NVIDIA-Vorteilen

Datenschutz, Sicherheit und Compliance: Die Plattform bietet eine ausgefeilte Architektur, die Datenschutz, strenge Sicherheit und strenge Compliance gewährleistet. Es basiert auf der Cloud-Infrastruktur von VMware, die Funktionen wie Secure Boot und VM-Verschlüsselung umfasst.

Verbesserte Leistung: Durch die Nutzung der Innovationen von Broadcom und NVIDIA ist die Plattform darauf ausgelegt, die Leistung für generative KI-Modelle zu maximieren und verfügt über Tools für eine effiziente GPU-Nutzung und eine hochentwickelte Netzwerkstruktur wie NVIDIA NVLink und NVSwitch.

Vereinfachung der Bereitstellung und Kostenoptimierung: Die VMware Private AI Foundation mit NVIDIA zielt darauf ab, die Bereitstellung zu rationalisieren und die mit generativen KI-Modellen verbundenen Kosten zu senken, was durch eine umfassende Management-Suite und Mechanismen zur Ressourcenfreigabe erleichtert wird.

Architektur

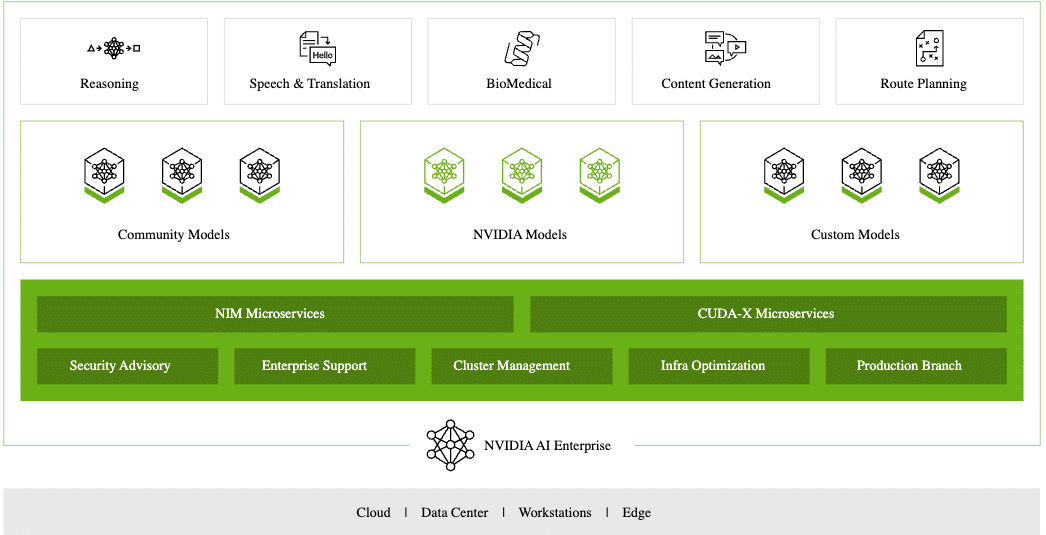

Im Kern bietet die VMware Cloud Foundation eine umfassende Cloud-Infrastrukturlösung, während NVIDIA AI Enterprise eine umfangreiche, cloudnative KI-Softwareplattform bereitstellt. Gemeinsam ermöglichen sie Unternehmen, sichere und private KI-Modelle effektiv einzusetzen.

VMware Private AI Foundation mit NVIDIA ermöglicht On-Premise-Bereitstellungen, die Unternehmen die Kontrolle bieten, mit der sie viele Herausforderungen bei der Einhaltung gesetzlicher Vorschriften schnell bewältigen können, ohne eine wesentliche Neuarchitektur ihrer bestehenden Umgebung durchführen zu müssen.

Das manuelle Einrichten einer Deep-Learning-VM kann ein zeitaufwändiger und komplexer Prozess sein. Dieser manuelle Ansatz kann zu Inkonsistenzen zwischen verschiedenen Entwicklungsumgebungen führen und die Optimierung beeinträchtigen. Um Kunden zu helfen, bietet VMware Private AI Foundation mit NVIDIA vorkonfigurierte Deep-Learning-VMs mit notwendigen Software-Frameworks wie NVIDIA NGC, Bibliotheken und Treibern. Dies erspart Benutzern die mühsame Einrichtung jeder Komponente einzeln.

VMware hat Vektordatenbanken durch die Nutzung von pgvector auf PostgreSQL ermöglicht. Diese Funktion wird durch native Infrastrukturautomatisierung und Datendienstverwaltung in VMware Cloud Foundation verwaltet. Data Services Manager vereinfacht die Bereitstellung und Verwaltung von Open-Source- und kommerziellen Datenbanken über eine zentrale Oberfläche. Vektordatenbanken sind für RAG-Workflows unerlässlich, um eine schnelle Datenabfrage und Echtzeit-LLM-Ausgabeverbesserungen ohne Umschulung zu ermöglichen.

VMware Cloud Foundation hat im Self-Service-Portal einen Katalog-Setup-Assistenten eingeführt, um die Infrastrukturbereitstellung für KI-Projekte zu optimieren. Dies reduziert den manuellen Arbeitsaufwand und beschleunigt den Zugriff auf die KI/ML-Infrastruktur.

VMware Private Foundation und NVIDIA führen GPU-Überwachungsfunktionen in VMware Cloud Foundation ein. Diese Funktionen bieten Ansichten der GPU-Ressourcennutzung über Cluster und Hosts hinweg neben den vorhandenen Hostspeicher- und Kapazitätskonsolen, Einblicke in GPU-Leistungsmetriken und helfen bei der Optimierung und dem Kostenmanagement.

NVIDIA AI Enterprise-Funktionen

Zu den NVIDIA AI Enterprise-Funktionen gehören:

- NVIDIA NIM: Eine Suite von Mikrodiensten, die die Bereitstellung von KI der Generation über eine breite Palette von KI-Modellen hinweg beschleunigt und dabei grundlegende NVIDIA-Software für effiziente Inferenzen nutzt.

- NVIDIA NeMo Retriever: Diese Komponente der NVIDIA NeMo-Plattform bietet Microservices für die Verbindung benutzerdefinierter Modelle mit Geschäftsdaten und gewährleistet so hochpräzise Antworten bei optimalem Datenschutz.

- NVIDIA RAG LLM Operator: Optimieren Sie die Bereitstellung von RAG-Anwendungen in Produktionsumgebungen durch Nutzung der KI-Workflow-Beispiele von NVIDIA.

- NVIDIA GPU Operator: Automatisiert die Verwaltung der Software, die für die Nutzung von GPUs in Kubernetes erforderlich ist, und steigert so die Leistung und Verwaltungseffizienz.

- Server-OEM-Unterstützung: Die Plattform wird von bedeutenden Server-OEMs wie Dell, HPE und Lenovo unterstützt, was eine umfassende Kompatibilität und Unterstützung gewährleistet.

Die VMware Private AI Foundation mit NVIDIA ist eine leistungsstarke Lösung, die darauf zugeschnitten ist, Unternehmen die Bereitstellung und Verwaltung von KI-Modellen zu ermöglichen. Es umfasst ein Ökosystem, das sich mit der Sicherheit, Leistung und Nachhaltigkeit von KI-Projekten befasst. Durch den Einsatz von Deep-Learning-VMs, Vektordatenbanken und einer Reihe von NVIDIA-Tools optimiert die Plattform die Bereitstellung und Verwaltung von KI-Modellen und erfüllt gleichzeitig die Unternehmensanforderungen an Compliance und Leistung. Führende Server-OEMs unterstützen die Plattform und gewährleisten so einen ganzheitlichen und kooperativen Ansatz für KI.

Beteiligen Sie sich an StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed