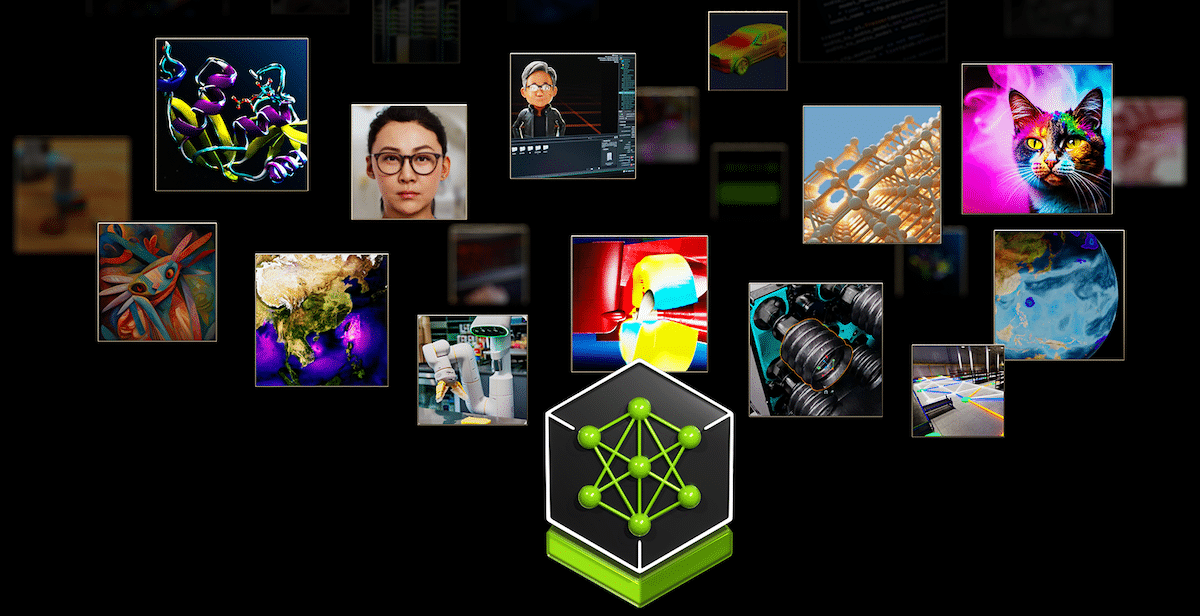

NVIDIA ha anunciado la disponibilidad de NVIDIA NIM, microservicios de inferencia que proporcionan modelos como contenedores optimizados. Estos microservicios permiten a los 28 millones de desarrolladores del mundo crear fácilmente aplicaciones de IA generativa. Estas aplicaciones se pueden implementar en nubes, centros de datos o estaciones de trabajo, lo que reduce significativamente el tiempo de desarrollo de semanas a minutos.

NVIDIA ha anunciado la disponibilidad de NIM de NVIDIA, Microservicios de inferencia que proporcionan modelos como contenedores optimizados. Estos microservicios permiten a los 28 millones de desarrolladores del mundo crear fácilmente aplicaciones de IA generativa. Estas aplicaciones se pueden implementar en nubes, centros de datos o estaciones de trabajo, lo que reduce significativamente el tiempo de desarrollo de semanas a minutos.

A medida que las aplicaciones de IA generativa se vuelven cada vez más complejas y a menudo utilizan múltiples modelos para generar texto, imágenes, video y voz, NVIDIA NIM mejora la productividad de los desarrolladores al ofrecer un método estandarizado para integrar la IA generativa en las aplicaciones. NIM permite a las empresas maximizar sus inversiones en infraestructura, como lo ejemplifica su capacidad para ejecutar Meta Llama 3-8B con hasta tres veces más tokens de IA generativos en infraestructura acelerada que los métodos tradicionales. Este aumento de la eficiencia permite a las empresas generar más respuestas con los mismos recursos informáticos.

Adopción amplia de la industria

Casi 200 socios tecnológicos, incluidos Cadence, Cloudera, Cohesity, DataStax, NetApp, Scale AI y Synopsys, están integrando NVIDIA NIM para acelerar las implementaciones de IA generativa para aplicaciones de dominios específicos, como copilotos, asistentes de código y avatares humanos digitales. Hugging Face también ofrece NIM, comenzando con Meta Llama 3.

Jensen Huang, fundador y director ejecutivo de NVIDIA, enfatizó la accesibilidad y el impacto de NIM y afirmó: "Todas las empresas buscan agregar IA generativa a sus operaciones, pero no todas las empresas tienen un equipo dedicado de investigadores de IA". NVIDIA NIM hace que la IA generativa esté disponible para casi todas las organizaciones.

Las empresas pueden implementar aplicaciones de IA utilizando NIM a través de la plataforma de software NVIDIA AI Enterprise. A partir del próximo mes, los miembros del Programa de Desarrolladores de NVIDIA podrán acceder a NIM de forma gratuita para realizar investigaciones, desarrollo y pruebas en su infraestructura preferida.

Impulsando la IA generativa en todas las modalidades

Los contenedores NIM están prediseñados para acelerar la implementación de modelos para la inferencia acelerada por GPU e incluyen el software NVIDIA CUDA, el servidor de inferencia NVIDIA Triton y el software NVIDIA TensorRT-LLM. Más de 40 modelos, incluidos Databricks DBRX, Gemma de Google, Meta Llama 3, Microsoft Phi-3 y Mistral Large, están disponibles como puntos finales NIM en ai.nvidia.com.

Los desarrolladores pueden acceder a los microservicios NIM de NVIDIA para los modelos Meta Llama 3 a través de la plataforma Hugging Face AI, lo que les permite ejecutar Llama 3 NIM con facilidad utilizando los puntos finales de inferencia Hugging Face con tecnología de GPU NVIDIA.

Amplio apoyo al ecosistema

Los proveedores de plataformas como Canonical, Red Hat, Nutanix y VMware admiten NIM en KServe de código abierto o soluciones empresariales. Las empresas de aplicaciones de IA, incluidas Hippocratic AI, Glean, Kinetica y Redis, están implementando NIM para impulsar la inferencia generativa de IA. Las principales herramientas de inteligencia artificial y socios de MLOps como Amazon SageMaker, Microsoft Azure AI, Dataiku, DataRobot y otros han integrado NIM en sus plataformas, lo que permite a los desarrolladores crear e implementar aplicaciones de inteligencia artificial generativas de dominios específicos con inferencia optimizada.

Integradores de sistemas globales y socios de prestación de servicios como Accenture, Deloitte, Infosys, Latentview, Quantiphi, SoftServe, TCS y Wipro han desarrollado competencias NIM para ayudar a las empresas a desarrollar e implementar rápidamente estrategias de producción de IA. Las empresas pueden ejecutar aplicaciones habilitadas para NIM en sistemas certificados por NVIDIA de fabricantes como Cisco, Dell Technologies, Hewlett-Packard Enterprise, Lenovo y Supermicro, así como en servidores de ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, Pegatron, QCT, Wistron y Wiwynn. Los microservicios NIM también están integrados en las principales plataformas en la nube, incluidos Amazon Web Services, Google Cloud, Azure y Oracle Cloud Infrastructure.

Casos de uso y adopción de la industria

Las empresas líderes están aprovechando NIM para diversas aplicaciones en todas las industrias. Foxconn utiliza NIM para LLM de dominios específicos en fábricas de inteligencia artificial, ciudades inteligentes y vehículos eléctricos. Pegatron emplea NIM para el Proyecto TaME para avanzar en el desarrollo local de LLM para diversas industrias. Amdocs utiliza NIM para un LLM de facturación de clientes, lo que reduce significativamente los costos y la latencia y, al mismo tiempo, mejora la precisión. ServiceNow integra microservicios NIM dentro de su modelo multimodal Now AI, brindando a los clientes un desarrollo e implementación de LLM rápido y escalable.

Disponibilidad

Los desarrolladores pueden experimentar con los microservicios de NVIDIA en ai.nvidia.com sin costo. Las empresas pueden implementar microservicios NIM de nivel de producción con NVIDIA AI Enterprise en sistemas certificados por NVIDIA y plataformas en la nube líderes. Los desarrolladores interesados en acceso gratuito a NIM para investigación y pruebas pueden registrarse para obtener acceso, que se espera que esté disponible el próximo mes.

Interactuar con StorageReview

Boletín | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS Feed