La gamme de cartes RAID MegaRAID de LSI a une énorme part de marché pour une bonne raison, elles sont considérées par beaucoup comme la norme de facto grâce à un matériel solide et une pile logicielle fantastique. Bien sûr, les cartes MegaRAID de LSI sont capables de plus que de simplement lier des disques, leur module complémentaire CacheCade Pro 2.0 tire parti de l'avantage de la vitesse des SSD en tant que pools de cache pour une matrice de disques durs de plus grande capacité.

Le concept de mise en cache est simple - dans ce cas, LSI utilise CacheCade pour stocker les données fréquemment demandées sur le SSD (ou les SSD, jusqu'à 32 sont pris en charge). Lorsque des données chaudes sont demandées, le SSD répond, offrant des améliorations massives de la latence dans les applications intensives en lecture et en écriture. Les serveurs Web, de fichiers et de données bénéficieront tous grandement des vitesses de lecture et d'écriture accrues de la mise en cache. CacheCade continue de fonctionner en arrière-plan, utilisant ses algorithmes pour ajouter ou supprimer des fichiers du cache SSD.

La meilleure partie de CacheCade est peut-être sa simplicité et son faible coût total de possession. Le pack logiciel fonctionne avec les familles de cartes RAID 9260 et 9280 de LSI et peut être acheté sur le site Web de LSI pour 270 $. La valeur TCO est énorme puisqu'une gamme complète de SSD rapides n'est plus nécessaire pour obtenir un accès aux données à faible latence. La mise en cache réduit les coûts en permettant aux utilisateurs de dimensionner un magasin de données avec des disques moins chers et d'ajouter uniquement le nombre de SSD nécessaire pour gérer les données chaudes. Il permet également à la baie de mise en cache de se développer selon les besoins, prenant en charge l'ajout de SSD à mesure que les données chaudes se développent sans affecter le reste de votre baie.

Spécifications LSI MegaRAID CacheCade Pro 2.0

- Compatible avec les contrôleurs de la série MegaRAID SAS 9260/9261/9280

- Systèmes d'exploitation pris en charge - Tous les systèmes d'exploitation pris en charge par la carte contrôleur MegaRAID

- Max. Nombre de SSD dans un pool de SSD CacheCade – 32

- Max. Nombre de SSC VD pris en charge par contrôleur - jusqu'à 64

- Max. Capacité de CacheCade par contrôleur – 512 Go

- Protection du cache en écriture RAID 1, 10 SSD

Configuration et configuration

Pour montrer les améliorations dans plusieurs scénarios, nous avons créé trois plates-formes de mise en cache uniques pour imiter un environnement de disque de passionné, de poste de travail et d'entreprise. Les trois plates-formes ont été testées via notre plate-forme de test Lenovo RD240 ThinkServer avec un SAS/SATA 6.0Gb/s LSI MegaRAID 9260-8i comme interface RAID et de mise en cache. Les configurations suivantes ont été utilisées pour chaque scénario :

Passionné:

- Quatre Disques durs Samsung F5,400EG SATA 2 To à 4 XNUMX tr/min en RAID6

- UN 240 Go OCZ Vertex 3 MAX IOPS MLC-SSD pour la mise en cache

- Capacité utile de 3.6 To

- Coût de 3.6 To de SSD : 7,200 XNUMX $

- Coût avec mise en cache SSD/HDD : $1,120

Poste de travail:

- UN Disque dur Seagate Constellation ES.7,200 SAS 3 2 tr/min XNUMX To

- UN 240 Go OCZ Vertex 3 MAX IOPS MLC-SSD pour la mise en cache

- Capacité utile de 2.8 To

- Coût de 2.8 To de SSD : 5,850 XNUMX $

- Coût avec mise en cache SSD/HDD : $1,120

Entreprise:

- Trois objectifs Disques durs Seagate Savvio 10,000K.600 SAS 10 4 tr/min XNUMX Go en RAID5

- UN 100 Go Micron P300 SLC-SSD pour la mise en cache

- Capacité utile de 1.12 To

- Coût de 1.12 To de SSD : 12,000 XNUMX $

- Coût avec mise en cache SSD/HDD : $2,170

Dans chaque scénario, nous tirons parti de la capacité de la matrice de disques durs avec un SSD de 100 à 240 Go pour la mise en cache. Dans le cas de la configuration Enthusiast, il faudrait plus de 16 SSD de 240 Go pour correspondre à la capacité de stockage totale offerte par les disques durs basse consommation de 5,400 450 tr/min. Avec un prix public d'environ 7,000 $, ce tableau coûterait plus de 2.0 400 $. En utilisant le logiciel CacheCade Pro 270 de LSI (en supposant que vous possédez déjà la carte RAID), cela ne coûte que 2.0 $ pour les disques durs, plus 450 $ pour CacheCade Pro 7,200 et 1,120 $ pour un seul SSD. Environ XNUMX XNUMX $ contre XNUMX XNUMX $ pour des performances très similaires sur t

L'un des principaux points à comprendre avec chaque configuration est que nous comprenons que différents utilisateurs auront des besoins différents en ce qui concerne les exigences d'espace de stockage et la taille des données chaudes pour la mise en cache. Dans chaque situation cependant, les économies de coûts sont tout simplement incroyables.

Benchmarks synthétiques

Notre méthode de test du logiciel CacheCade Pro 2.0 de LSI consistait à évaluer chaque groupe de disques sans mise en cache activée, puis à réévaluer chaque ensemble avec une zone de données chaudes de 25 Go et une mise en cache SSD à pleine vitesse. Ce que ces chiffres montrent, ce sont les performances des vitesses de données « froides » par rapport aux vitesses de données « chaudes ». Une autre façon de voir les choses est de voir à quel point la mise en cache est rapide ou à quel point les vitesses de mise en cache ne sont limitées que par la rapidité de votre baie de mise en cache SSD.

Nous avons estimé que la meilleure façon de montrer CacheCade en action était de s'éloigner de nos benchmarks synthétiques directs (2 Mo séquentiels/aléatoires, 4K aléatoires) et d'utiliser uniquement des charges de travail mixtes pour montrer à quel point la mise en cache peut aider dans un scénario donné.

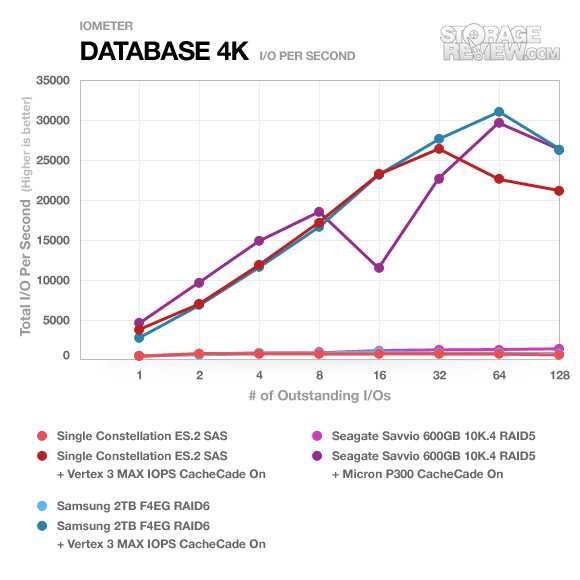

Le premier est notre profil de base de données, avec une combinaison de charge de travail de 67 % en lecture et 33 % en écriture, principalement centrée sur des tailles de transfert de 8K.

En regardant les performances de chacune des trois baies, il est difficile de ne pas voir la reprise drastique de la vitesse. Les performances mises en cache ne sont pas freinées par la plate-forme de mise en cache, mais plutôt par la vitesse réelle du SSD que vous utilisez. La différence est tout simplement incroyable.

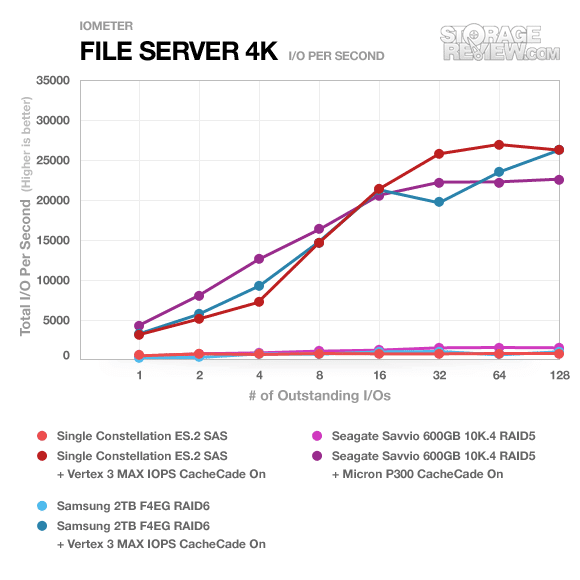

Le profil suivant examine un serveur de fichiers, avec une charge de travail de 80 % en lecture et 20 % en écriture répartie sur plusieurs tailles de transfert allant de 512 octets à 64 Ko.

La même tendance est suivie pour le profil de serveur de fichiers, les vitesses SSD/HDD en cache n'étant freinées que par leurs propres vitesses individuelles. En regardant de plus près le Seagate Savvio associé au SSD Micron P300 à la profondeur de file d'attente la plus élevée, la comparaison est de 1,157 22,902 IOPS à XNUMX XNUMX IOPS entre les vitesses de données froides et chaudes

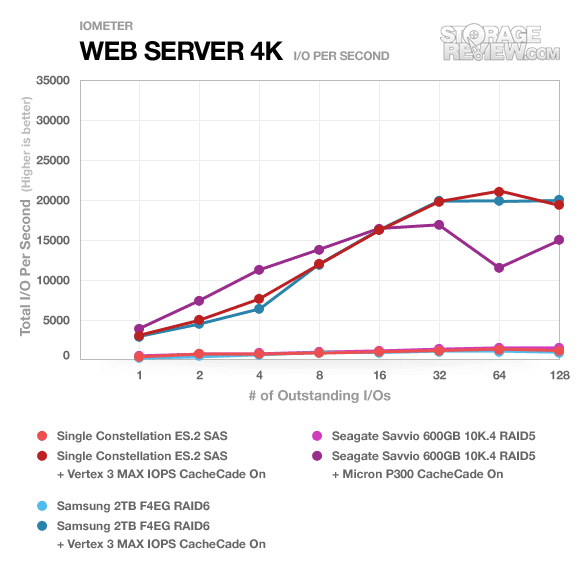

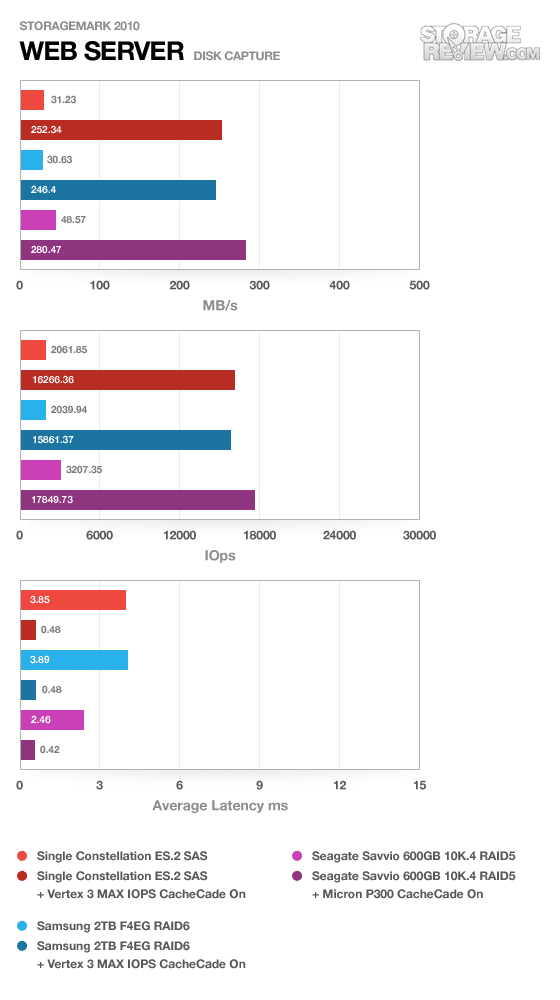

Notre profil de serveur Web est en lecture seule avec une répartition des tailles de transfert de 512 octets à 512 Ko.

Dans cette configuration, les configurations utilisant le processeur SandForce SF-2200 l'ont emporté dans le jeu de vitesse du Micron P300 grâce à ses vitesses de lecture plus rapides et ont offert d'énormes gains de performances. En regardant les vitesses de la matrice Samsung RAID6, elles sont passées de 478 IOPS ou 7.54 Mo/s à 20,079 308 IOPS et XNUMX Mo/s.

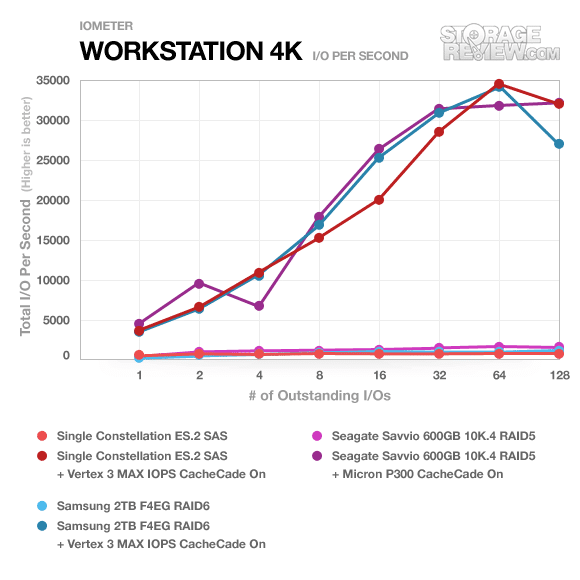

Le dernier profil concerne un poste de travail, avec un mélange de 20 % d'écriture et de 80 % de lecture autour de transferts 8K.

Avec un mélange élevé de transferts de lecture, toutes les baies fonctionnent remarquablement bien avec des gains spectaculaires à tous les niveaux. Dans le cas du Seagate Constellation ES.2, les performances sont passées de 267 IOPS à 32,422 128 IOPS au niveau de profondeur de file d'attente XNUMX.

Benchmarks du monde réel

Pour vraiment voir comment les disques fonctionnent sous des charges de travail normales, vous devez enregistrer le trafic exact transmis vers et depuis l'appareil, puis l'utiliser pour comparer les disques les uns par rapport aux autres. Pour cette raison, nous nous sommes tournés vers nos traces StorageMark 2010, qui incluent des traces grand public couvrant les scénarios HTPC, de productivité et de jeu et des traces d'entreprise comprenant un scénario de serveur de messagerie et de serveur Web.

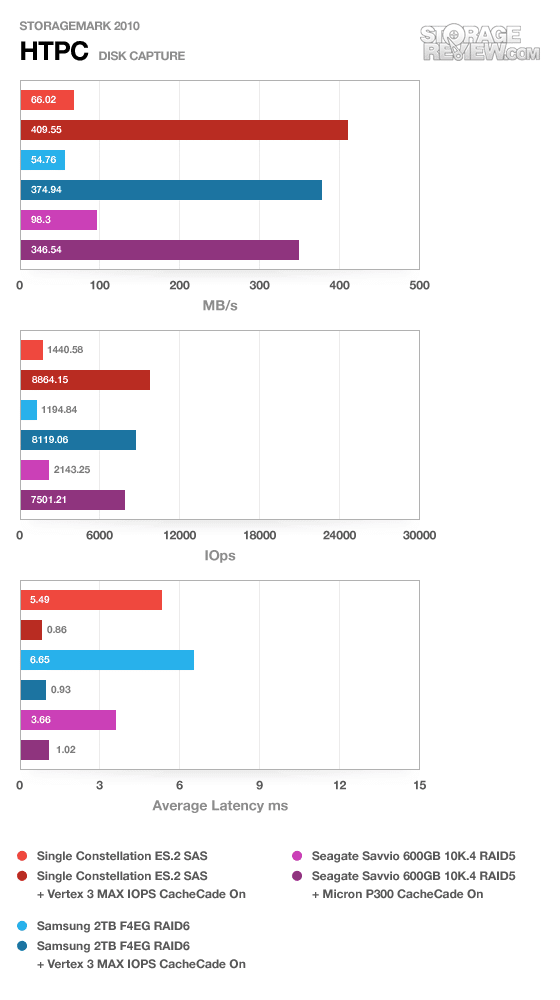

Le premier test réel est notre scénario HTPC. Dans ce test, nous incluons : la lecture d'un film HD 720P dans Media Player Classic, un film SD 480P dans VLC, trois films téléchargés simultanément via iTunes et un flux HDTV 1080i enregistré via Windows Media Center sur une période de 15 minutes. Des débits IOps et Mo/s plus élevés avec des temps de latence plus faibles sont préférables. Dans cette trace, nous avons enregistré 2,986 1,924 Mo en cours d'écriture sur le lecteur et XNUMX XNUMX Mo en cours de lecture.

Nous avons constaté que CacheCade Pro 2.0 s'en sortait très bien, affichant un gain moyen de 512 % dans la trace HTPC sur nos baies de test.

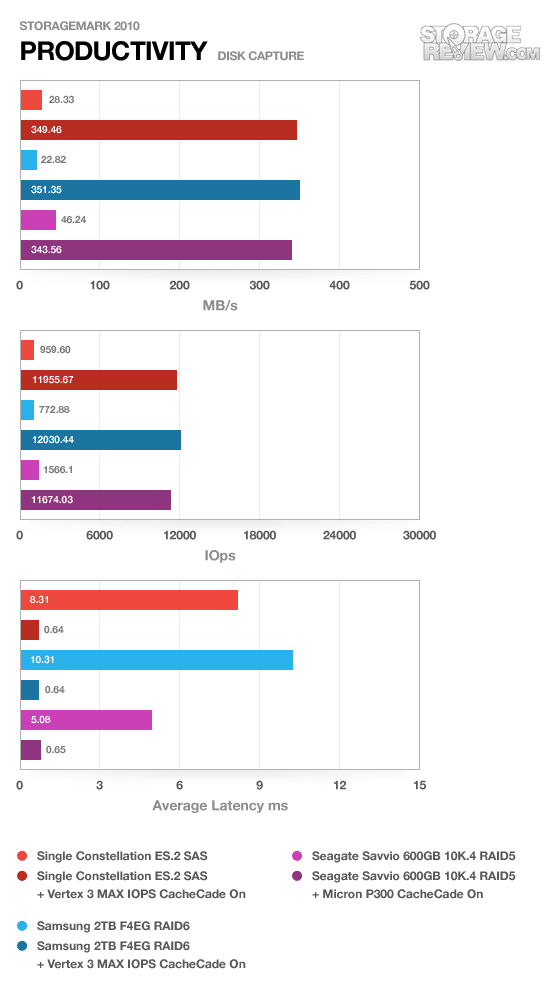

Notre deuxième test en situation réelle couvre l'activité du disque dans un scénario de productivité. À toutes fins utiles, ce test montre les performances du lecteur dans le cadre d'une activité quotidienne normale pour la plupart des utilisateurs. Ce test comprend : une période de trois heures dans un environnement de productivité bureautique avec Vista 32 bits exécutant Outlook 2007 connecté à un serveur Exchange, la navigation sur le Web avec Chrome et IE8, la modification de fichiers dans Office 2007, la visualisation de fichiers PDF dans Adobe Reader, et une heure de lecture de musique locale avec deux heures supplémentaires de musique en ligne via Pandora. Dans cette trace, nous avons enregistré 4,830 2,758 Mo en cours d'écriture sur le lecteur et XNUMX XNUMX Mo en cours de lecture.

Dans la trace de productivité, le gain moyen était de 1,080 4 %, le plus grand saut observé avec la baie Samsung FXNUMXEG avec mise en cache activée.

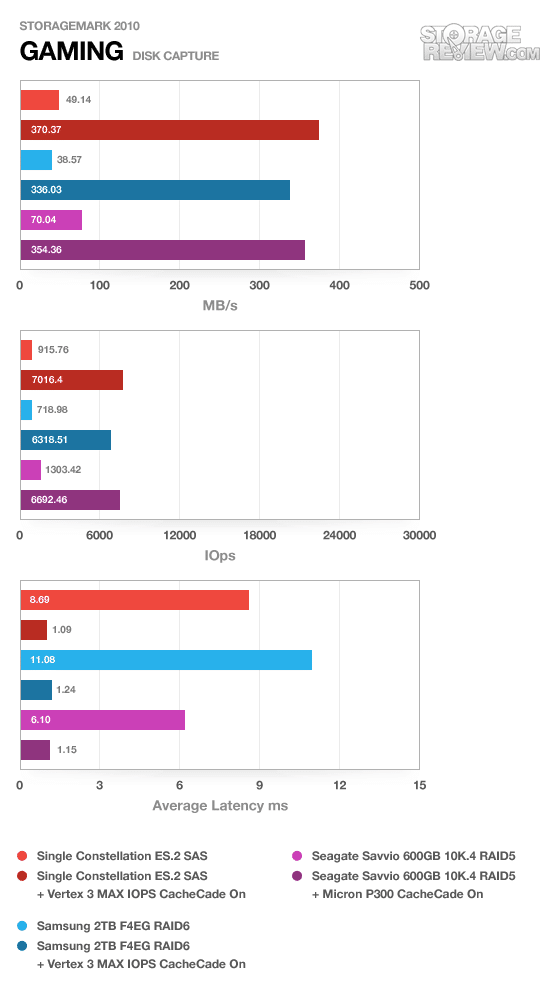

Notre troisième test réel basé sur le client couvre l'activité du disque dans un environnement de jeu. Contrairement à la trace HTPC ou Productivity, celle-ci repose fortement sur les performances de lecture d'un lecteur. Pour donner une ventilation simple des pourcentages de lecture/écriture, le test HTPC est de 64 % en écriture, 36 % en lecture, le test de productivité est de 59 % en écriture et 41 % en lecture, tandis que la trace de jeu est de 6 % en écriture et 94 % en lecture. Le test consiste en un système Windows 7 Ultimate 64 bits préconfiguré avec Steam, avec Grand Theft Auto 4, Left 4 Dead 2 et Mass Effect 2 déjà téléchargés et installés. La trace capture l'activité de lecture intensive de chaque chargement de jeu depuis le début, ainsi que les textures au fur et à mesure que le jeu progresse. Dans cette trace, nous avons enregistré 426 Mo en cours d'écriture sur le lecteur et 7,235 XNUMX Mo en cours de lecture.

L'amélioration moyenne de notre trace de jeu à lecture intensive était de 682%, avec le plus grand bond observé par le seul Seagate Constellation ES.2.

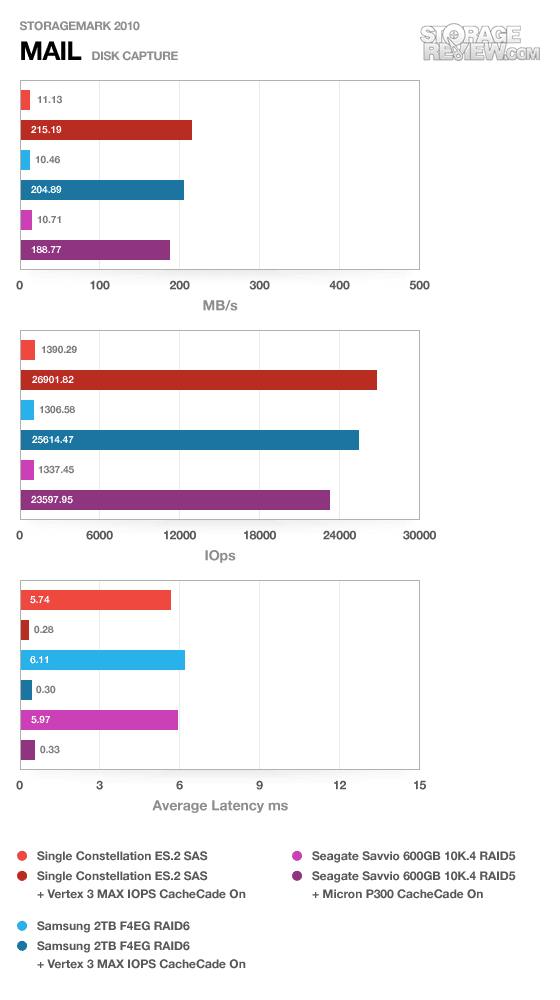

Notre première trace d'entreprise couvre un environnement de serveur de messagerie Microsoft Exchange. Nous avons capturé l'activité de notre serveur de messagerie StorageReview sur une période de quelques jours. Ce matériel de serveur se compose d'un Dell PowerEdge 2970 exécutant un environnement Windows Server 2003 R2 fonctionnant sur trois disques durs SAS de 73 Go 10k en RAID5 sur le contrôleur intégré Dell Perc 5/I. La trace se compose de nombreuses petites demandes de transfert, avec une forte charge de lecture de 95 % avec un trafic d'écriture de 5 %.

La trace du serveur de messagerie a enregistré certains des gains les plus importants dans tous les domaines, la moyenne pour chaque configuration étant de 1,868 XNUMX % entre mise en cache et non mise en cache.

La trace de notre serveur Web a été capturée sur un serveur Web en direct gérant des milliers de visiteurs par jour. Avec une journalisation active des visiteurs, une taille de transfert moyenne de 16 Ko avec un pic de 1024 33 Ko, cette trace était lourde en écriture avec un mélange de 67 % de lecture et XNUMX % d'écriture.

Dans notre trace de serveur Web, le gain moyen constaté était de 684 % entre les baies de stockage non mises en cache et entièrement mises en cache.

Conclusion

La configuration matérielle/logicielle CacheCade Pro 2.0 de LSI est vraiment difficile à battre dans le domaine de la mise en cache, surtout compte tenu du faible coût du logiciel. Nous avons constaté des gains significatifs dans tous les domaines en comparant les résultats de référence froids à chauds (mise en cache complète), l'augmentation la plus élevée dans le monde réel étant celle de la trace de notre serveur de messagerie qui a enregistré une amélioration de plus de 1,800 XNUMX %. La seule chose qui freinait ces améliorations était la vitesse de la matrice de mise en cache SSD qui peut être personnalisée pour répondre aux besoins exacts de l'environnement dans lequel elle est utilisée.

En fin de compte, tout l'intérêt de la mise en cache est d'obtenir des vitesses SSD pour les données fréquemment consultées. À l'aide de CacheCade Pro 2.0, vous pouvez créer une matrice de disques durs de la taille dont vous avez besoin et n'ajouter que le nombre de SSD dont vous avez besoin pour répondre aux exigences de taille ou de vitesse des données à chaud. L'alternative coûteuse serait de créer une baie entièrement à partir de SSD pour correspondre à la capacité requise aux vitesses nécessaires ou de dimensionner une baie de milliers de disques durs à course courte pour répondre à l'exigence IOPS sur la capacité nécessaire. Ces deux alternatives sont très coûteuses, la méthode du disque dur à course courte nécessitant de grandes quantités d'espace physique et de puissance pour même la mettre en œuvre, ce qui la rend même impossible dans la plupart des cas.

Le coût de mise en œuvre d'un tableau CacheCade est minime à seulement 270 $ pour le progiciel. Pour le prosommateur ou le passionné qui a besoin de plus de vitesse sur une gamme de disques, il est probable que vous disposiez déjà d'une carte LSI MegaRAID compatible, donc l'ajout du coût du logiciel n'est pas prohibitif. Du côté de l'entreprise, vous utilisez presque certainement une carte RAID LSI compatible et 270 $, c'est des cacahuètes par rapport au coût total du serveur ou de la matrice de stockage utilisé. Dans tous les cas, pour une mise de fonds minimale, les utilisateurs obtiennent des vitesses SSD associées à un stockage sur disque dur bon marché pour l'essentiel de la charge - l'un des rares scénarios gagnant-gagnant en matière de technologie.

Avantages

- Très rentable

- Des gains de performances incroyables

- Compatible avec plusieurs systèmes d'exploitation grâce à la pile de pilotes étendue de LSI

Inconvénients

- Peut être d'un coût prohibitif à plus petite échelle (niveau enthousiaste)

Conclusion

Le logiciel MegaRAID CacheCade Pro 2.0 de LSI offre aux entreprises et aux passionnés un moyen d'augmenter les vitesses des SSD sur une grande baie de disques durs, avec un coût supplémentaire minimal. Du poste de travail au centre de données, CacheCade offre une valeur fantastique et est absolument une amélioration incontournable pour ceux qui cherchent à tirer les meilleures performances par dollar de leur stockage.