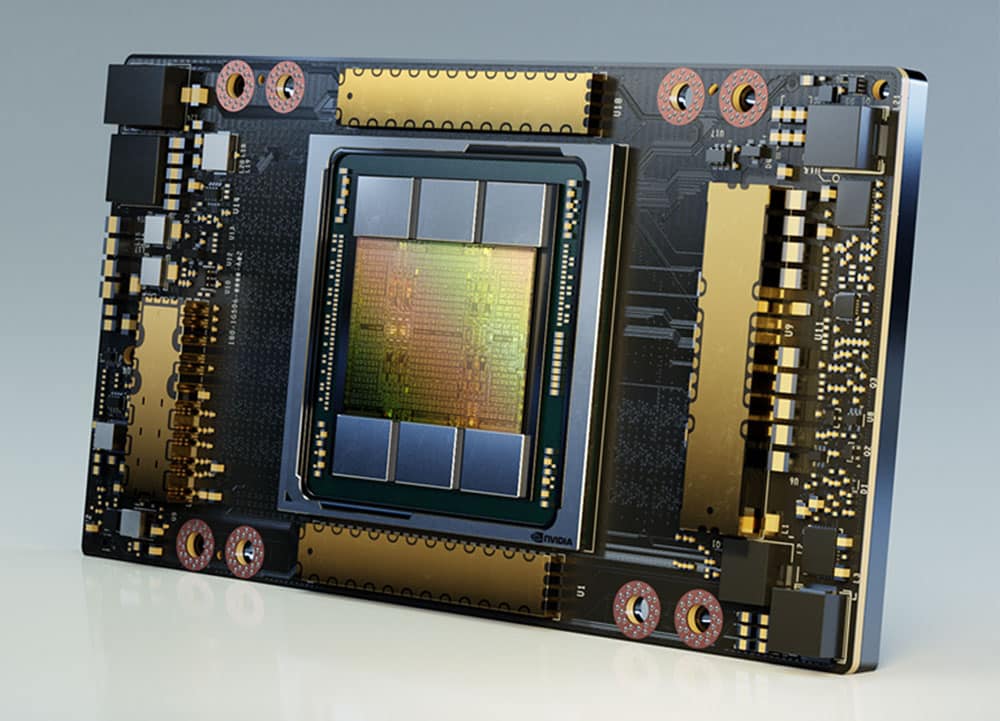

Oggi all'SC20 NVIDIA ha annunciato che la sua popolare GPU A100 vedrà un raddoppio della memoria a larghezza di banda elevata con la presentazione della GPU NVIDIA A100 da 80 GB. Questa nuova GPU rappresenterà l'innovazione alla base della nuova piattaforma di supercalcolo NVIDIA HGX AI. Con il doppio della memoria, la nuova GPU spera di aiutare ricercatori e ingegneri a raggiungere velocità e prestazioni senza precedenti per sbloccare la prossima ondata di scoperte scientifiche e di intelligenza artificiale.

Oggi all'SC20 NVIDIA ha annunciato che la sua popolare GPU A100 vedrà un raddoppio della memoria a larghezza di banda elevata con la presentazione della GPU NVIDIA A100 da 80 GB. Questa nuova GPU rappresenterà l'innovazione alla base della nuova piattaforma di supercalcolo NVIDIA HGX AI. Con il doppio della memoria, la nuova GPU spera di aiutare ricercatori e ingegneri a raggiungere velocità e prestazioni senza precedenti per sbloccare la prossima ondata di scoperte scientifiche e di intelligenza artificiale.

All'inizio di quest'anno al GTC, NVICIA ha annunciato il rilascio del suo GPU da 7 nm, la NVIDIA A100. Come scrivemmo all'epoca, l'A100 si basa sull'architettura Ampere di NVIDIA e contiene 54 miliardi di transistor. Come le precedenti GPU per data center NVIDIA, l'A100 include Tensor Core. I tensor core sono parti specializzate della GPU progettate specificamente per eseguire rapidamente un tipo di moltiplicazione di matrici e calcoli di addizione comunemente utilizzati nell'inferenza. Con le nuove GPU più robuste, arrivano nuovi tensor core più robusti. In precedenza, i Tensor Core di NVIDIA potevano supportare solo numeri in virgola mobile fino a trentadue bit. L'A100 supporta operazioni a virgola mobile a sessantaquattro bit, consentendo una precisione molto maggiore.

Si dice che aumentando la memoria a larghezza di banda elevata (HBM2e) a 80 GB sia possibile fornire 2 terabyte al secondo di larghezza di banda della memoria. Questa nuova spinta aiuta con le applicazioni emergenti nell’HPC che hanno enormi requisiti di memoria dati, come la formazione sull’intelligenza artificiale, l’elaborazione del linguaggio naturale e l’analisi dei big data, per citarne alcuni.

Caratteristiche principali dell'A100 da 80 GB

L'A100 da 80 GB include le numerose funzionalità rivoluzionarie dell'architettura NVIDIA Ampere:

- Tensor Core di terza generazione: forniscono fino a 20 volte il throughput AI della precedente generazione Volta con un nuovo formato TF32, nonché 2.5 volte FP64 per HPC, 20 volte INT8 per l'inferenza AI e supporto per il formato dati BF16.

- Memoria GPU HBM2e più grande e più veloce: raddoppia la capacità di memoria ed è la prima nel settore a offrire più di 2 TB al secondo di larghezza di banda della memoria.

- Tecnologia MIG: raddoppia la memoria per istanza isolata, fornendo fino a sette MIG da 10 GB ciascuno.

- Sparsità strutturale: offre una velocità fino a 2 volte superiore per l'inferenza di modelli sparsi.

- NVLink e NVSwitch di terza generazione: fornisce il doppio della larghezza di banda da GPU a GPU rispetto alla tecnologia di interconnessione della generazione precedente, accelerando i trasferimenti di dati alla GPU per carichi di lavoro ad alta intensità di dati fino a 600 gigabyte al secondo.

Disponibilità

Si prevede che i fornitori di sistemi Atos, Dell Technologies, Fujitsu, GIGABYTE, Hewlett Packard Enterprise, Inspur, Lenovo, Quanta e Supermicro inizieranno a offrire sistemi realizzati utilizzando schede base integrate HGX A100 con GPU A100 da 80 GB nella prima metà del prossimo anno.

Interagisci con StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | Facebook | RSS feed