NVIDIA GTC 2024 está aqui; de volta pessoalmente pela primeira vez em muitos anos. Jordan está no evento ao vivo trazendo todas as últimas notícias e análises sobre o principal evento de IA.

A GPU Technology Conference (GTC) da NVIDIA está de volta presencialmente após vários anos como um evento apenas virtual. Este é um evento fantástico para inovadores, pesquisadores, cientistas e entusiastas da tecnologia verem as tecnologias mais recentes do gigante da tecnologia. O NVIDIA GTC 2024 deste ano, muito aguardado pela comunidade tecnológica, apresenta os mais recentes avanços em IA, aprendizagem profunda, veículos autônomos e a nova arquitetura Blackwell.

Aqui estão os destaques da palestra de segunda-feira do CEO da NVIDIA, Jensen Huang. Ele cercou a nova arquitetura Blackwell da NVIDIA, redes, avanços na computação quântica e atualizações de pilha de software.

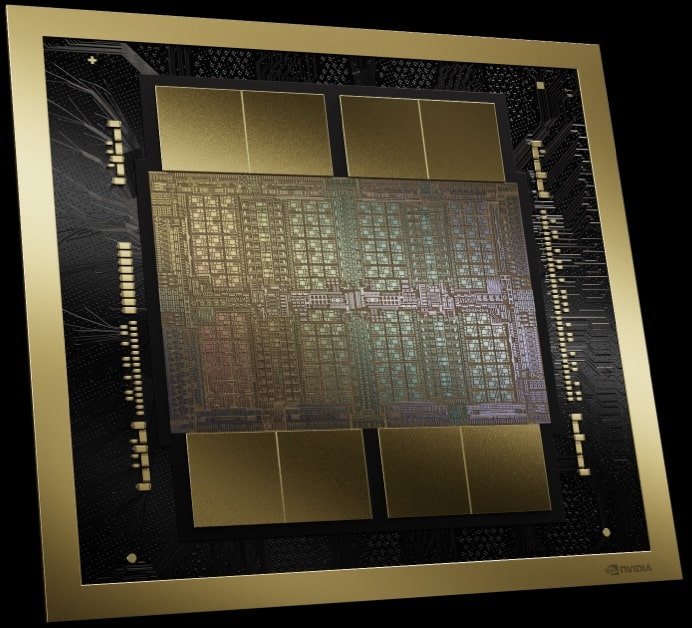

NVIDIA Blackwell

Seis tecnologias inovadoras preparadas para redefinir a computação acelerada estão no centro da inovação da Blackwell. Desde a melhoria do processamento de dados até a revolução no design de medicamentos e muito mais, a NVIDIA está estabelecendo um novo padrão. Aderentes de alto nível como Amazon e Microsoft já estão fazendo fila em antecipação ao potencial transformador da Blackwell.

Vamos dar uma olhada na maravilha da engenharia que a NVIDIA realizou. As GPUs Blackwell contêm impressionantes 208 bilhões de transistores em dois chips, o que é possível graças ao aproveitamento de um processo TSMC 4NP com limite de dois retículos. Essa abordagem desafia os limites da fabricação de semicondutores e introduz uma nova maneira de conectar chips com uma interface incrível de 10 TB/s. Esta mudança em direção a designs de chips reflete a ambição da NVIDIA de ir além dos limites tradicionais.

| Especificação | H100 | B100 | B200 |

| Memória máxima | 80GB HBM3 | 192GB HBM3e | 192GB HBM3e |

| Largura de banda de memória | 3.35 TB / s | 8 TB / s | 8 TB / s |

| FP4 | - | 14 PFLOPS | 18 PF-flops |

| FP6 | - | 7 PFLOPS | 9 PFLOPS |

| FP8/INT8 | 3.958 PFLOPS/POPS | 7 PFLOPS/POPS | 9 PFLOPS/POPS |

| FP16/BF16 | 1979 TFLOPS | 3.5 PFLOPS | 4.5 PFLOPS |

| TF32 | 989 TFLOPS | 1.8 PFLOPS | 2.2 PFLOPS |

| FP64 | 67 TFLOPS | 30 TFLOPS | 40 TFLOPS |

| Consumo Máximo de Energia | 700W | 700W | 1000W |

Nota: Todos os números aqui representam desempenho para cálculos de matrizes esparsas.

Não se trata apenas de embalar mais transistores. A introdução da capacidade computacional do FP4 e FP6 traz um novo nível de treinamento eficiente de modelos, embora com uma ligeira compensação no desempenho do modelo. Esta compensação é um aspecto matizado da plataforma, refletindo um complexo ato de equilíbrio entre eficiência e precisão.

O mecanismo transformador de segunda geração da Blackwell permite um salto nos recursos de computação, largura de banda e tamanho do modelo ao usar o FP4, trazendo melhorias que são vitais para o futuro do desenvolvimento de IA. Além disso, a integração do PCIe Gen6 e da nova tecnologia de memória HBM3e proporciona um aumento substancial na largura de banda, que, quando combinada com o NVLink de quinta geração, duplica a largura de banda da geração anterior para impressionantes 1.8 TB/s.

Uma das introduções mais intrigantes é o RAS Engine, que aumenta a confiabilidade, a disponibilidade e a capacidade de manutenção em implantações massivas de IA. Esta inovação poderia melhorar significativamente a utilização do modelo flop, abordando um dos desafios críticos no dimensionamento de aplicações de IA.

Com a Blackwell, a NVIDIA traz novos recursos de computação confidencial, incluindo a primeira GPU compatível com Trusted Execution Environment (TEE) -I/O do setor, estendendo o TEE além das CPUs para as GPUs. Isto garante o processamento seguro e rápido de dados privados, crucial para o treinamento de IA generativa. Esta inovação é particularmente significativa para indústrias que lidam com regulamentações de privacidade ou informações proprietárias. A Computação Confidencial da NVIDIA Blackwell oferece segurança incomparável sem comprometer o desempenho, oferecendo taxa de transferência quase idêntica aos modos não criptografados. Este avanço não só protege grandes modelos de IA, mas também permite formação confidencial em IA e aprendizagem federada, salvaguardando a propriedade intelectual em IA.

O mecanismo de descompressão da NVIDIA Blackwell marca um salto significativo na análise de dados e fluxos de trabalho de banco de dados. Esse mecanismo pode descompactar dados a uma taxa surpreendente de até 800 GB/s, melhorando significativamente o desempenho da análise de dados e reduzindo o tempo para obtenção de insights. Em colaboração com a memória HBM8e de 3 TB/s e a interconexão NVLink-C2C de alta velocidade, ele acelera as consultas de banco de dados, tornando a Blackwell 18 vezes mais rápida que as CPUs e 6 vezes mais rápida que as GPUs NVIDIA anteriores em benchmarks de consulta. Essa tecnologia suporta os formatos de compactação mais recentes e posiciona a NVIDIA Blackwell como uma potência para análise de dados e ciência, acelerando drasticamente o pipeline de análise de ponta a ponta.

Apesar das maravilhas técnicas, a afirmação da NVIDIA de reduzir os custos operacionais e de energia da inferência do LLM em até 25x causa espanto, principalmente devido à falta de dados detalhados de consumo de energia. Esta afirmação, embora digna de nota, pode beneficiar de esclarecimentos adicionais para avaliar plenamente o seu impacto.

Em resumo, a plataforma Blackwell da NVIDIA é uma prova da busca incansável da empresa em ultrapassar os limites do que é possível em IA e computação. Com as suas tecnologias revolucionárias e objetivos ambiciosos, a Blackwell não é apenas um passo, mas um salto gigante em frente, prometendo alimentar vários avanços em vários setores. À medida que nos aprofundamos nesta era de computação acelerada e IA generativa, as inovações da NVIDIA podem ser os catalisadores para a próxima revolução industrial.

NVIDIA Blackwell HGX

Adotando a arquitetura Blackwell, a NVIDIA atualizou sua série de servidores e placas de base HGX. Esta evolução significativa em relação aos modelos anteriores traz uma mudança convincente, reduzindo nomeadamente o custo total de propriedade e aumentando ao mesmo tempo o desempenho de forma impressionante. A comparação é impressionante: ao comparar o TL8 com o FP4, há uma notável melhoria de desempenho de 4.5x. Mesmo ao combinar o FP8 com o seu antecessor, o desempenho quase duplica. Não se trata apenas de velocidade bruta; é um avanço na eficiência da memória, apresentando um aumento de 8x na largura de banda da memória agregada.

| Especificação | HGX H100 | HGX H200 | HGX B100 | HGX B200 |

| Memória máxima | 640GB HBM3 | 1.1 TB HBM3e | 1.5 TB HBM3e | 1.5 TB HBM3e |

| Largura de banda de memória | 7.2 TB / s | 7.2 TB / s | 8 TB / s | 8 TB / s |

| FP4 | - | - | 112 PFLOPS | 144 PFLOPS |

| FP6 | - | - | 56 PFLOPS | 72 PFLOPS |

| FP8/INT8 | 32 PFLOPS/POPS | 32 PFLOPS/POPS | 56 PFLOPS/POPS | 72 PFLOPS/POPS |

| FP16/BF16 | 16 PFLOPS | 16 PFLOPS | 28 PFLOPS | 36 PFLOPS |

SuperChip NVIDIA Grace-Blackwell

Aprofundando-se nas complexidades do último anúncio da NVIDIA, com foco no GB200, a pedra angular do arsenal da plataforma Blackwell. Com a NVIDIA continuamente inovando na computação de alto desempenho, o GB200 representa uma evolução significativa em suas ofertas de GPU, combinando tecnologia de ponta com avanços estratégicos em conectividade e escalabilidade. O GB200 abriga duas GPUs B200; esta configuração difere do GH200 da geração anterior, que apresentava uma conexão um-para-um entre uma GPU e uma CPU Grace. Desta vez, ambas as GPUs B200 estão conectadas à mesma CPU Grace por meio de um link chip a chip (C900C) de 2 GB/s.

| Especificação | GH200 | GB200 |

| Memória máxima | 144GB HBM3e | 384GB HBM3e |

| Largura de banda de memória | 8 TB / s | 16 TB/s (agregado) |

| FP4 | - | 40 PFLOPS |

| FP6 | - | 20 PFLOPS |

| FP8/INT8 | 3.958 PFLOPS/POPS | 20 PFLOPS |

| FP16/BF16 | 1979 TFLOPS | 10 PFLOPS |

| TF32 | 989 TFLOPS | 5 PFLOPS |

| FP64 | 67 TFLOPS | 90 TFLOPS |

| Pistas PCIe | 4x PCIe Geração 5 x16 | 2x PCIe Geração 6 x16 |

| Consumo Máximo de Energia | 1000W | 2700W |

# Nota: Todos os números aqui representam desempenho para cálculos de matrizes esparsas.

À primeira vista, a decisão de manter o link C900C de 2GB/s da geração anterior pode parecer uma limitação. No entanto, esta escolha de design sublinha uma estratégia calculada para aproveitar as tecnologias existentes e, ao mesmo tempo, abrir caminho para novos níveis de escalabilidade. A arquitetura do GB200 permite a comunicação com até 576 GPUs a uma velocidade de 1.8 TB/s, cortesia do NVLink de quinta geração. Este nível de interconectividade é crucial para a construção de ambientes de computação massivamente paralelos, necessários para treinar e implementar os maiores e mais complexos modelos de IA.

Atualização da pilha de rede NVIDIA

Integrando o GB200 com as mais recentes tecnologias de rede da NVIDIA, as plataformas Ethernet Quantum-X800 InfiniBand e Spectrum-X800 levanta questões interessantes sobre conectividade e largura de banda. A menção aos recursos de 800 Gb/s sugere que a NVIDIA está explorando os benefícios que o PCIe Gen6 pode trazer para a mesa.

A configuração GB200, com configuração de GPU dupla e opções avançadas de rede, representa a visão da NVIDIA para o futuro da HPC. Essa visão não se trata apenas da potência bruta dos componentes individuais, mas de como esses componentes podem ser orquestrados em um sistema coerente e escalável. Ao permitir um maior grau de interconectividade e manter um equilíbrio entre o poder computacional e as taxas de transferência de dados, a NVIDIA aborda alguns dos desafios mais críticos em pesquisa e desenvolvimento de IA, especialmente no tratamento de tamanhos de modelos e demandas computacionais em crescimento exponencial.

Switches NVIDIA NVLink e NVLink de quinta geração

O NVLink de quinta geração marca um marco significativo em computação de alto desempenho e IA. Esta tecnologia aumenta a capacidade de conexão e comunicação entre GPUs, um aspecto crucial para as demandas em rápida evolução dos modelos fundamentais de IA.

O NVLink de quinta geração aumenta sua capacidade de conectividade de GPU para 576 GPUs, um aumento substancial em relação ao limite anterior de 256 GPUs. Essa expansão é acompanhada de uma duplicação da largura de banda em comparação com seu antecessor, um aprimoramento crítico para o desempenho de modelos de IA fundamentais cada vez mais complexos.

Cada link da GPU Blackwell possui dois pares diferenciais de alta velocidade, semelhantes à GPU Hopper, mas atinge uma largura de banda efetiva por link de 50 GB/s em cada direção. Essas GPUs vêm equipadas com 18 links NVLink de quinta geração, fornecendo uma largura de banda total impressionante de 1.8 TB/s. Essa taxa de transferência é mais de 14 vezes maior que a do atual PCIe Gen 5.

Outro recurso notável é o switch NVIDIA NVLink, que suporta largura de banda de GPU de 130 TB/s em um único domínio NVLink de 72 GPU (NVL72), crucial para o paralelismo do modelo. Este switch também oferece um aumento de quatro vezes na eficiência da largura de banda com o novo suporte NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP) FP8.

Além disso, o NVIDIA Unified Fabric Manager (UFM) complementa o switch NVLink, fornecendo gerenciamento robusto e comprovado para a malha computacional NVLink.

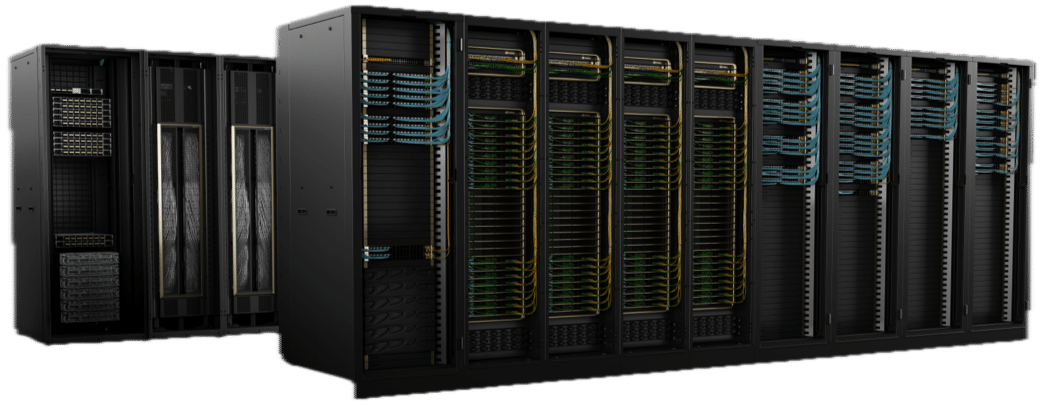

Computação Exascale em um rack

Baseando-se na formidável base estabelecida pelo seu antecessor, o GraceHopper GH200 NVL32, o DGX GB200 NVL72 não é apenas uma atualização; é um avanço fundamental para expandir o que é possível em poder e eficiência computacional. A plataforma DGX GB200 NVL72 apresenta avanços surpreendentes em todos os aspectos. Cada sistema DGX GB200 NVL72 compreende 18 nós GB200 SuperChip, compreendendo 2x GB200 cada.

Esta plataforma mais que duplica o número de GPUs de 32 para 72 e aumenta modestamente as CPUs de 32 para 36. No entanto, o salto na memória é notável, saltando de 19.5 TB para impressionantes 30 TB. Esta expansão não se trata apenas de números mais significativos; trata-se de habilitar um novo escalão de capacidades computacionais, especialmente no tratamento dos modelos e simulações de IA mais complexos.

Uma das atualizações mais impressionantes é o salto no desempenho computacional. A plataforma salta de 127 PetaFLOPS para 1.4 ExaFLOPS ao comparar o desempenho do FP4, marcando um aumento aproximado de 11x. Esta comparação ilumina a dedicação da NVIDIA em ultrapassar os limites da precisão e da velocidade, especialmente em IA e aprendizado de máquina. No entanto, mesmo ao comparar o FP8 com o FP8, a plataforma alcança um aumento de 5.6x, de 127PFs para 720PFs, ressaltando avanços significativos em eficiência e poder computacional.

O compromisso de manter um sistema totalmente refrigerado a água reflete o foco da NVIDIA na sustentabilidade e na otimização do desempenho. Esta abordagem melhora a eficiência operacional do sistema e se alinha às tendências mais amplas do setor em direção a tecnologias de data center mais ecológicas.

NVIDIA DGX SuperPOD com superchips NVIDIA GB200 Grace Blackwell

A NVIDIA também anunciou seu supercomputador de IA de próxima geração, o DGX SuperPOD, equipado com 8 sistemas NVIDIA GB200 NVL72 Grace Blackwell. Esta configuração formidável foi projetada para lidar com modelos de trilhões de parâmetros, ostentando 11.5 exaflops de poder de supercomputação de IA com precisão FP4 em sua arquitetura em escala de rack com refrigeração líquida. Cada sistema GB200 NVL72 inclui 36 Superchips NVIDIA GB200, prometendo um aumento de desempenho de 30x em relação aos seus antecessores H100 para grandes cargas de trabalho de inferência de modelos de linguagem.

De acordo com Jensen Huang, CEO da NVIDIA, o DGX SuperPOD pretende ser a “fábrica da revolução industrial de IA”.

Nuvem de simulação quântica

A NVIDIA também revelou o serviço Quantum Simulation Cloud, permitindo aos pesquisadores explorar a computação quântica em vários domínios científicos. Baseado na plataforma de código aberto CUDA-Q, este serviço oferece ferramentas e integrações poderosas para construir e testar algoritmos e aplicações quânticas. Colaborações com a Universidade de Toronto e empresas como Classiq e QC Ware destacam o esforço da NVIDIA para acelerar a inovação da computação quântica.

Pilha de software NVIDIA NIM

Outro anúncio significativo foi o lançamento da pilha de software NVIDIA NIM, que oferece dezenas de microsserviços de IA generativos de nível empresarial. Esses serviços permitem que as empresas criem e implantem aplicativos personalizados em suas plataformas, otimizando a inferência em modelos populares de IA e aprimorando o desenvolvimento com microsserviços NVIDIA CUDA-X para uma ampla variedade de aplicativos. Jensen Huang enfatizou o potencial desses microsserviços para transformar empresas de todos os setores em entidades movidas por IA.

Sistemas de Computação OVX

Em resposta ao rápido crescimento da IA generativa em vários setores, a NVIDIA lançou os sistemas de computação OVX, uma solução projetada para agilizar IA complexa e cargas de trabalho com uso intensivo de gráficos. Reconhecendo o papel crucial do armazenamento de alto desempenho nas implantações de IA a NVIDIA iniciou um programa de validação de parceiros de armazenamento com colaboradores líderes como DDN Dell PowerScale, NetApp, Pure Storage e WEKA.

O novo programa padroniza o processo para os parceiros validarem seus dispositivos de armazenamento, garantindo desempenho e escalabilidade ideais para cargas de trabalho empresariais de IA. Por meio de testes rigorosos da NVIDIA, esses sistemas de armazenamento são validados em relação a diversos parâmetros, refletindo os requisitos desafiadores dos aplicativos de IA.

Além disso, os servidores OVX certificados pela NVIDIA, equipados com GPUs NVIDIA L40S e integrados a soluções abrangentes de software e rede, oferecem uma arquitetura flexível para se adequar a diversos ambientes de data center. Esta abordagem não apenas acelera a computação onde os dados residem, mas também atende às necessidades exclusivas da IA generativa, garantindo eficiência e economia. Os servidores NVIDIA OVX são equipados com GPUs robustas, oferecendo recursos computacionais aprimorados, acesso de armazenamento de alta velocidade e rede de baixa latência. Isto é particularmente vital para aplicações exigentes como chatbots e ferramentas de pesquisa que requerem processamento extensivo de dados.

Atualmente disponíveis e enviados por fornecedores globais como GIGABYTE, Hewlett Packard Enterprise, Lenovo e Supermicro, os servidores OVX certificados pela NVIDIA representam um salto significativo no tratamento de cargas de trabalho complexas de IA, prometendo desempenho, segurança e escalabilidade de nível empresarial.

Pensamentos de Encerramento

Além disso, houve anúncios nas áreas automotiva, robótica, saúde e IA generativa. Todos esses anúncios mostram a busca incansável da NVIDIA por inovação, oferecendo ferramentas e plataformas avançadas para impulsionar o futuro da IA e da computação em vários domínios. Todos eles são altamente técnicos e possuem muitas complexidades, principalmente no caso de computação quântica e lançamentos de software. Fique ligado nas análises dos anúncios à medida que tivermos mais informações sobre cada um desses novos lançamentos.

Envolva-se com a StorageReview

Newsletter | YouTube | Podcast iTunes/Spotify | Instagram | Twitter | TikTok | RSS feed